介紹八種免費開源的大模型解決方案,因為ChatGPT和Bard價格太高。

1.LLaMA

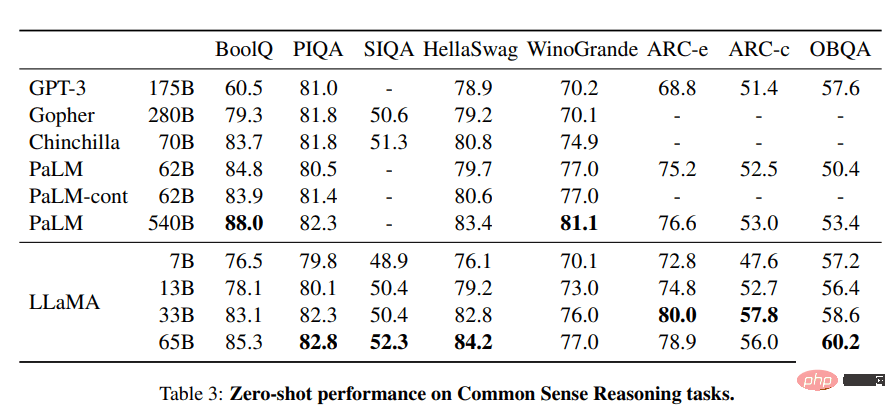

LLaMA專案包含了一組基礎語言模型,其規模從70億到650億個參數不等。這些模型在數以百萬計的token上進行訓練,而且它完全在公開的資料集上進行訓練。結果,LLaMA-13B超過了GPT-3(175B),而LLaMA-65B的表現與Chinchilla-70B和PaLM-540B等最佳模型相似。

圖片來自LLaMA

資源:

- 研究論文:「LLaMA: Open and Efficient Foundation Language Models (arxiv. org)」 [https://arxiv.org/abs/2302.13971]

- GitHub:facebookresearch/llama [https://github.com/facebookresearch/llama]

- 示範:Baize Lora 7B [https://huggingface.co/spaces/project-baize/Baize-7B]

2.Alpaca

史丹佛大學的Alpaca聲稱它可以與ChatGPT競爭,任何人都可以在不到600美元的情況下複製它。 Alpaca 7B是在52K指令遵循的示範上從LLaMA 7B模型中進行微調。

訓練內容|圖片來自史丹佛大學CRFM

資源:

- 部落格:史丹佛大學CRFM。 [https://crfm.stanford.edu/2023/03/13/alpaca.html]

- GitHub:tatsu-lab/stanford_alpaca [https://github.com/tatsu-lab/stanford_alpaca]

- 示範:Alpaca-LoRA (官方示範已經遺失,這是Alpaca模型的再現) [https://huggingface.co/spaces/tloen/alpaca-lora]

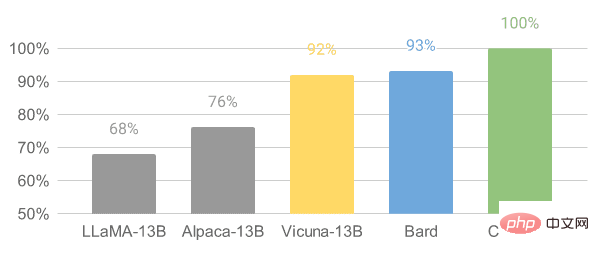

#3.Vicuna

Vicuna是在從ShareGPT收集到的使用者共享對話上的LLaMA模型基礎上進行微調。 Vicuna-13B模型已經達到了OpenAI ChatGPT和Google Bard的90%以上的品質。它還在90%的情況下超過了LLaMA和史丹佛大學Alpaca模型。訓練Vicuna的成本約為300美元。

圖片來自Vicuna

資源:

- 部落格文章:「Vicuna: An Open-Source Chatbot Impressing GPT-4 with 90%* ChatGPT Quality」 [https://vicuna.lmsys.org/]

- #GitHub:lm-sys/FastChat [https://github.com/lm-sys/FastChat#fine-tuning ]

- 示範:FastChat (lmsys.org) [https://chat.lmsys.org/]

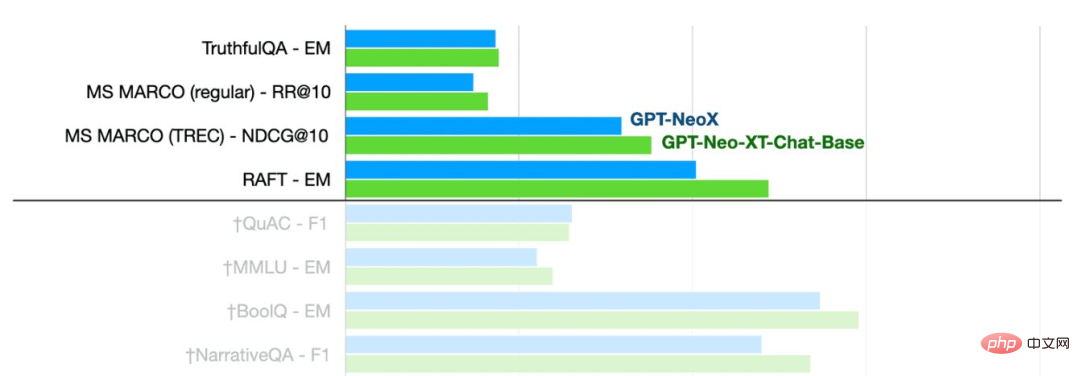

##4.OpenChatKit

#OpenChatKit:開源的ChatGPT替代方案,是一個用於建立聊天機器人的完整工具包。它提供了用於訓練使用者自己的指令調整的大型語言模型、微調模型、用於更新機器人回應的可擴展檢索系統以及用於過濾問題的機器人審核的指令。

- 部落格文章:「Announcing OpenChatKit」—TOGETHER [https://www.together.xyz/blog/openchatkit]

- GitHub: togethercomputer /OpenChatKit [https://github.com/togethercomputer/OpenChatKit]

- 示範:OpenChatKit [https://huggingface.co/spaces/togethercomputer/OpenChatKit]

- 模型卡:togethercomputer/ GPT-NeoXT-Chat-Base-20B [https://huggingface.co/togethercomputer/GPT-NeoXT-Chat-Base-20B]

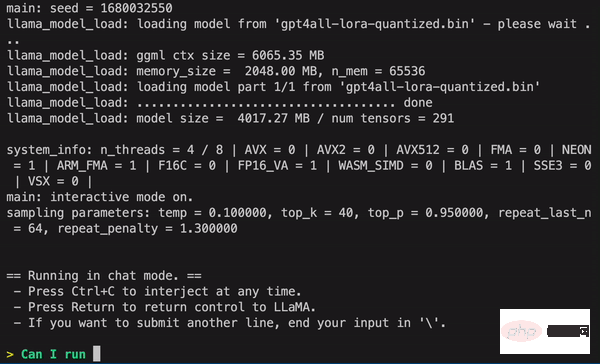

5.GPT4ALL

GPT4ALL是一個社群驅動的項目,並在一個大規模的輔助互動語料庫上進行訓練,包括程式碼、故事、描述和多輪對話。該團隊提供了資料集、模型權重、資料管理流程和訓練程式碼以促進開源。此外,他們還發布了模型的量化4位元版本,可以在筆記型電腦上運行。甚至可以使用Python客戶端來運行模型推理。

- 技術報告:GPT4All [https://s3.amazonaws.com/static.nomic.ai/gpt4all/2023_GPT4All_Technical_Report.pdf]

- GitHub: nomic-ai/gpt4al [https:/ /github.com/nomic-ai/gpt4all]

- #示範:GPT4All(非官方)。 [https://huggingface.co/spaces/rishiraj/GPT4All]

- 模型卡:nomic-ai/gpt4all-lora · Hugging Face [https://huggingface.co/nomic-ai/gpt4all-lora ]

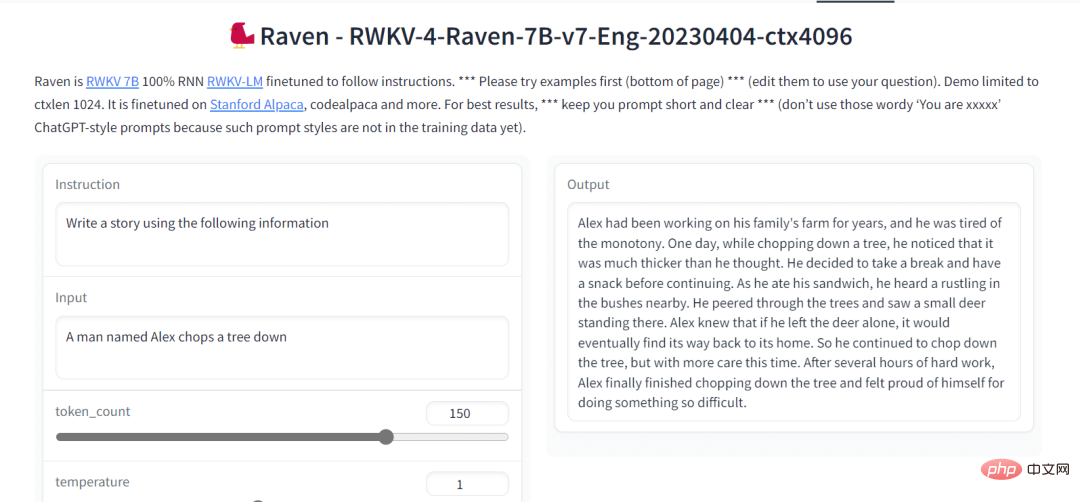

6.Raven RWKV

#Raven RWKV 7B是一個開源的聊天機器人,它由RWKV語言模型驅動,生成的結果與ChatGPT相似。該模型使用RNN,可以在品質和伸縮性方面與transformer相匹配,同時速度更快,節省VRAM。 Raven在史丹佛大學Alpaca、code-alpaca和更多的資料集上進行了微調。

圖片來自Raven RWKV 7B

#資源:

- GitHub:BlinkDL/ChatRWKV [https://github.com /BlinkDL/ChatRWKV]

- 示範:Raven RWKV 7B [https://huggingface.co/spaces/BlinkDL/Raven-RWKV-7B]

- 模型卡:BlinkDL/rwkv-4- raven [https://huggingface.co/BlinkDL/rwkv-4-raven]

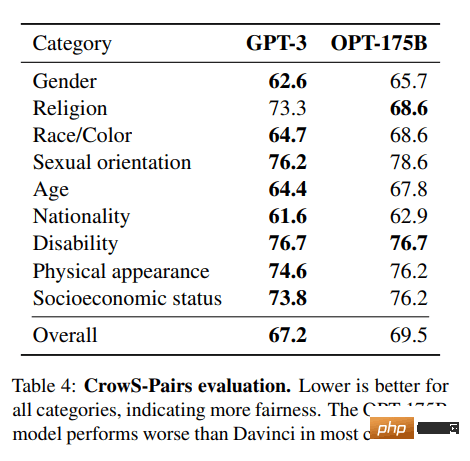

#7.OPT

OPT: Open Pre-trained Transformer語言模型並不像ChatGPT那樣強大,但它在零樣本和少樣本學習以及刻板偏見分析方面表現出卓越的能力。還可以將它與Alpa、Colossal-AI、CTranslate2和FasterTransformer整合以獲得更好的結果。 注意:它上榜的原因是它的受歡迎程度,因為它在文字生成類別中每月有624,710次下載。

圖片來自(arxiv.org)

資源:

- 研究論文:"OPT: Open Pre-trained Transformer Language Models (arxiv.org)」 [https://arxiv.org/abs/2205.01068]

- GitHub: facebookresearch/metaseq [https://github.com/facebookresearch/metaseq]

- # #示範:A Watermark for LLMs [https://huggingface.co/spaces/tomg-group-umd/lm-watermarking]

- 模型卡:facebook/opt-1.3b [https://huggingface. co/facebook/opt-1.3b]

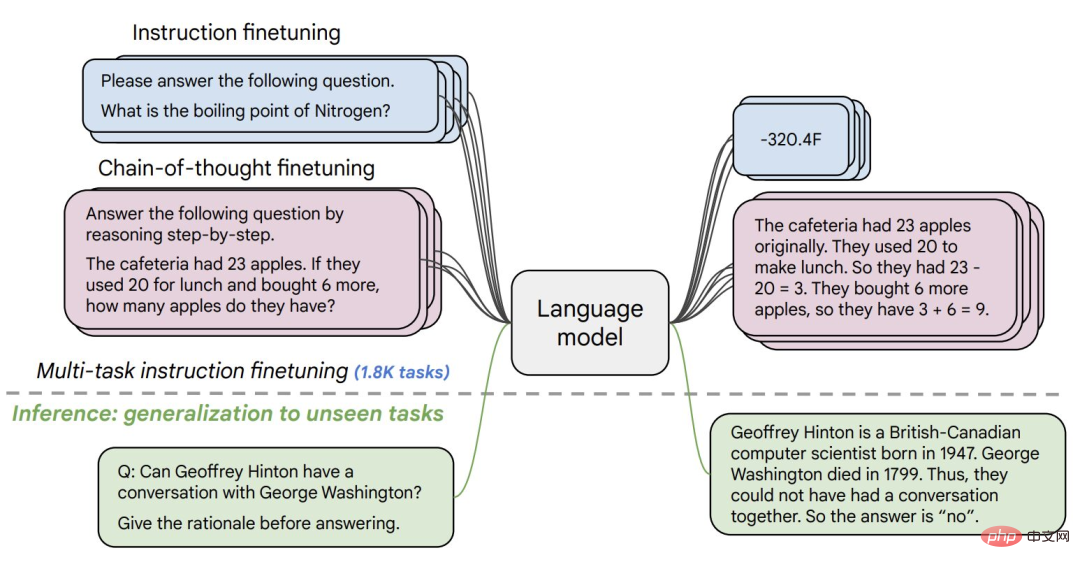

8.Flan-T5-XXL

Flan-T5-XXL在以指令形式表述的資料集上微調了T5模型。指令的微調大大提高了各種模型類別的效能,如PaLM、T5和U-PaLM。 Flan-T5-XXL模型在1000多個額外的任務上進行了微調,涵蓋了更多語言。

圖片來自Flan-T5-XXL

資源:

- 研究論文:「Scaling Instruction-Fine Tuned Language Models 」 [https://arxiv.org/pdf/2210.11416.pdf]

- #GitHub: google-research/t5x [https://github.com/google-research/t5x]

- #示範:Chat Llm Streaming [https://huggingface.co/spaces/olivierdehaene/chat-llm-streaming]

- 模型卡:google/flan-t5-xxl [https://huggingface.co/google /flan-t5-xxl?text=Q: ( False or not False or False ) is? A: Let's think step by step]

#總結

現在有很多開源的可供選擇的大模型,本文涉及到其中比較流行的8個大模型。

以上是介紹八種免費開源的大模型解決方案,因為ChatGPT和Bard價格太高。的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

十個推薦開源免費文字標註工具

Mar 26, 2024 pm 08:20 PM

十個推薦開源免費文字標註工具

Mar 26, 2024 pm 08:20 PM

文字標註工作是將標籤或標記與文字中特定內容相對應的工作。其主要目的是為文本提供額外的信息,以便進行更深入的分析和處理,尤其是在人工智慧領域。文字標註對於人工智慧應用中的監督機器學習任務至關重要。用於訓練AI模型,有助於更準確地理解自然語言文本訊息,並提高文本分類、情緒分析和語言翻譯等任務的表現。透過文本標註,我們可以教導AI模型識別文本中的實體、理解上下文,並在出現新的類似數據時做出準確的預測。本文主要推薦一些較好的開源文字標註工具。 1.LabelStudiohttps://github.com/Hu

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

DALL-E 3 於 2023 年 9 月正式推出,是比其前身大幅改進的車型。它被認為是迄今為止最好的人工智慧圖像生成器之一,能夠創建具有複雜細節的圖像。然而,在推出時,它不包括

15個值得推薦的開源免費圖片標註工具

Mar 28, 2024 pm 01:21 PM

15個值得推薦的開源免費圖片標註工具

Mar 28, 2024 pm 01:21 PM

圖像標註是將標籤或描述性資訊與圖像相關聯的過程,以賦予圖像內容更深層的含義和解釋。這個過程對於機器學習至關重要,它有助於訓練視覺模型以更準確地識別圖像中的各個元素。透過為圖像添加標註,使得電腦能夠理解圖像背後的語義和上下文,從而提高對圖像內容的理解和分析能力。影像標註的應用範圍廣泛,涵蓋了許多領域,如電腦視覺、自然語言處理和圖視覺模型具有廣泛的應用領域,例如,輔助車輛識別道路上的障礙物,幫助疾病的檢測和診斷透過醫學影像識別。本文主要推薦一些較好的開源免費的圖片標註工具。 1.Makesens

建議:優秀JS開源人臉偵測辨識項目

Apr 03, 2024 am 11:55 AM

建議:優秀JS開源人臉偵測辨識項目

Apr 03, 2024 am 11:55 AM

人臉偵測辨識技術已經是一個比較成熟且應用廣泛的技術。而目前最廣泛的網路應用語言非JS莫屬,在Web前端實現人臉偵測辨識相比後端的人臉辨識有優勢也有弱勢。優點包括減少網路互動、即時識別,大大縮短了使用者等待時間,提高了使用者體驗;弱勢是:受到模型大小限制,其中準確率也有限。如何在web端使用js實現人臉偵測呢?為了實現Web端人臉識別,需要熟悉相關的程式語言和技術,如JavaScript、HTML、CSS、WebRTC等。同時也需要掌握相關的電腦視覺和人工智慧技術。值得注意的是,由於Web端的計

阿里7B多模態文件理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

阿里7B多模態文件理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

多模態文件理解能力新SOTA!阿里mPLUG團隊發布最新開源工作mPLUG-DocOwl1.5,針對高解析度圖片文字辨識、通用文件結構理解、指令遵循、外部知識引入四大挑戰,提出了一系列解決方案。話不多說,先來看效果。複雜結構的圖表一鍵識別轉換為Markdown格式:不同樣式的圖表都可以:更細節的文字識別和定位也能輕鬆搞定:還能對文檔理解給出詳細解釋:要知道,“文檔理解”目前是大語言模型實現落地的一個重要場景,市面上有許多輔助文檔閱讀的產品,有的主要透過OCR系統進行文字識別,配合LLM進行文字理

手機怎麼安裝chatgpt

Mar 05, 2024 pm 02:31 PM

手機怎麼安裝chatgpt

Mar 05, 2024 pm 02:31 PM

安裝步驟:1、在ChatGTP官網或手機商店下載ChatGTP軟體;2、開啟後在設定介面中,選擇語言為中文;3、在對局介面中,選擇人機對局並設定中文相譜;4 、開始後在聊天視窗中輸入指令,即可與軟體互動。

剛剛發布!一鍵產生動漫風格圖片的開源模型

Apr 08, 2024 pm 06:01 PM

剛剛發布!一鍵產生動漫風格圖片的開源模型

Apr 08, 2024 pm 06:01 PM

向大家介紹一個最新的AIGC開源專案-AnimagineXL3.1。這個專案是動漫主題文字到圖像模型的最新迭代,旨在為用戶提供更優化和強大的動漫圖像生成體驗。在AnimagineXL3.1中,開發團隊專注於優化了幾個關鍵方面,以確保模型在效能和功能上達到新的高度。首先,他們擴展了訓練數據,不僅包括了先前版本中的遊戲角色數據,還加入許多其他知名動漫系列的數據納入訓練集中。這項舉措豐富了模型的知識庫,使其能夠更全面地理解各種動漫風格和角色。 AnimagineXL3.1引入了一組新的特殊標籤和美學標

單卡跑Llama 70B快過雙卡,微軟硬生把FP6搞到A100哩 | 開源

Apr 29, 2024 pm 04:55 PM

單卡跑Llama 70B快過雙卡,微軟硬生把FP6搞到A100哩 | 開源

Apr 29, 2024 pm 04:55 PM

FP8和更低的浮點數量化精度,不再是H100的「專利」了!老黃想讓大家用INT8/INT4,微軟DeepSpeed團隊在沒有英偉達官方支援的條件下,硬生在A100上跑起FP6。測試結果表明,新方法TC-FPx在A100上的FP6量化,速度接近甚至偶爾超過INT4,而且比後者擁有更高的精度。在此基礎之上,還有端到端的大模型支持,目前已經開源並整合到了DeepSpeed等深度學習推理框架中。這項成果對大模型的加速效果也是立竿見影──在這種框架下用單卡跑Llama,吞吐量比雙卡還要高2.65倍。一名