SpringBoot怎麼整合dataworks

注意事項

這裡測試主要是呼叫拉取dataworks上拉取的腳本,並儲存到本機。

腳本包含兩部分

1、開發的odps腳本(透過OpenApi取得)2、建表語句腳本(透過dataworks資訊去連接maxCompute取得建立語句)

阿里雲Dataworks的openApi分頁查詢限制,一次最多查詢100條。我們拉取腳本需要分多頁查詢

該專案使用到了MaxCompute的SDK/JDBC方式連接,SpringBoot操作MaxCompute SDK/JDBC連接

整合實作

實作主要是編寫工具類,如果需要則可以配置成SpringBean,注入容器即可使用

依賴引入

<properties>

<java.version>1.8</java.version>

<!--maxCompute-sdk-版本号-->

<max-compute-sdk.version>0.40.8-public</max-compute-sdk.version>

<!--maxCompute-jdbc-版本号-->

<max-compute-jdbc.version>3.0.1</max-compute-jdbc.version>

<!--dataworks版本号-->

<dataworks-sdk.version>3.4.2</dataworks-sdk.version>

<aliyun-java-sdk.version>4.5.20</aliyun-java-sdk.version>

</properties>

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-configuration-processor</artifactId>

<optional>true</optional>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

<optional>true</optional>

</dependency>

<!--max compute sdk-->

<dependency>

<groupId>com.aliyun.odps</groupId>

<artifactId>odps-sdk-core</artifactId>

<version>${max-compute-sdk.version}</version>

</dependency>

<!--max compute jdbc-->

<dependency>

<groupId>com.aliyun.odps</groupId>

<artifactId>odps-jdbc</artifactId>

<version>${max-compute-jdbc.version}</version>

<classifier>jar-with-dependencies</classifier>

</dependency>

<!--dataworks需要引入aliyun-sdk和dataworks本身-->

<dependency>

<groupId>com.aliyun</groupId>

<artifactId>aliyun-java-sdk-core</artifactId>

<version>${aliyun-java-sdk.version}</version>

</dependency>

<dependency>

<groupId>com.aliyun</groupId>

<artifactId>aliyun-java-sdk-dataworks-public</artifactId>

<version>${dataworks-sdk.version}</version>

</dependency>

</dependencies>請求參數類編寫

/**

* @Description

* @Author itdl

* @Date 2022/08/09 15:12

*/

@Data

public class DataWorksOpenApiConnParam {

/**

* 区域 eg. cn-shanghai

*/

private String region;

/**

* 访问keyId

*/

private String aliyunAccessId;

/**

* 密钥

*/

private String aliyunAccessKey;

/**

* 访问端点 就是API的URL前缀

*/

private String endPoint;

/**

* 数据库类型 如odps

*/

private String datasourceType;

/**

* 所属项目

*/

private String project;

/**

* 项目环境 dev prod

*/

private String projectEnv;

}工具類編寫

基礎類別準備,拉取腳本之後的回調函數

為什麼需要回調函數,因為拉取的是所有腳本,如果合併每次分頁結果的話,會導致記憶體溢出,而使用回調函數只是每次循環增加處理函數

/**

* @Description

* @Author itdl

* @Date 2022/08/09 15:12

*/

@Data

public class DataWorksOpenApiConnParam {

/**

* 区域 eg. cn-shanghai

*/

private String region;

/**

* 访问keyId

*/

private String aliyunAccessId;

/**

* 密钥

*/

private String aliyunAccessKey;

/**

* 访问端点 就是API的URL前缀

*/

private String endPoint;

/**

* 数据库类型 如odps

*/

private String datasourceType;

/**

* 所属项目

*/

private String project;

/**

* 项目环境 dev prod

*/

private String projectEnv;

}初始化操作

主要是實例化dataworks openApi介面的客戶端信息,maxCompute連接的工具類初始化(包括JDBC,SDK方式)

private static final String MAX_COMPUTE_JDBC_URL_FORMAT = "http://service.%s.maxcompute.aliyun.com/api";

/**默认的odps接口地址 在Odps中也可以看到该变量*/

private static final String defaultEndpoint = "http://service.odps.aliyun.com/api";

/**

* dataworks连接参数

*

*/

private final DataWorksOpenApiConnParam connParam;

/**

* 可以使用dataworks去连接maxCompute 如果连接的引擎是maxCompute的话

*/

private final MaxComputeJdbcUtil maxComputeJdbcUtil;

private final MaxComputeSdkUtil maxComputeSdkUtil;

private final boolean odpsSdk;

/**

* 客户端

*/

private final IAcsClient client;

public DataWorksOpenApiUtil(DataWorksOpenApiConnParam connParam, boolean odpsSdk) {

this.connParam = connParam;

this.client = buildClient();

this.odpsSdk = odpsSdk;

if (odpsSdk){

this.maxComputeJdbcUtil = null;

this.maxComputeSdkUtil = buildMaxComputeSdkUtil();

}else {

this.maxComputeJdbcUtil = buildMaxComputeJdbcUtil();

this.maxComputeSdkUtil = null;

}

}

private MaxComputeSdkUtil buildMaxComputeSdkUtil() {

final MaxComputeSdkConnParam param = new MaxComputeSdkConnParam();

// 设置账号密码

param.setAliyunAccessId(connParam.getAliyunAccessId());

param.setAliyunAccessKey(connParam.getAliyunAccessKey());

// 设置endpoint

param.setMaxComputeEndpoint(defaultEndpoint);

// 目前只处理odps的引擎

final String datasourceType = connParam.getDatasourceType();

if (!"odps".equals(datasourceType)){

throw new BizException(ResultCode.DATA_WORKS_ENGINE_SUPPORT_ERR);

}

// 获取项目环境,根据项目环境连接不同的maxCompute

final String projectEnv = connParam.getProjectEnv();

if ("dev".equals(projectEnv)){

// 开发环境dataworks + _dev就是maxCompute的项目名

param.setProjectName(String.join("_", connParam.getProject(), projectEnv));

}else {

// 生产环境dataworks的项目名和maxCompute一致

param.setProjectName(connParam.getProject());

}

return new MaxComputeSdkUtil(param);

}

private MaxComputeJdbcUtil buildMaxComputeJdbcUtil() {

final MaxComputeJdbcConnParam param = new MaxComputeJdbcConnParam();

// 设置账号密码

param.setAliyunAccessId(connParam.getAliyunAccessId());

param.setAliyunAccessKey(connParam.getAliyunAccessKey());

// 设置endpoint

param.setEndpoint(String.format(MAX_COMPUTE_JDBC_URL_FORMAT, connParam.getRegion()));

// 目前只处理odps的引擎

final String datasourceType = connParam.getDatasourceType();

if (!"odps".equals(datasourceType)){

throw new BizException(ResultCode.DATA_WORKS_ENGINE_SUPPORT_ERR);

}

// 获取项目环境,根据项目环境连接不同的maxCompute

final String projectEnv = connParam.getProjectEnv();

if ("dev".equals(projectEnv)){

// 开发环境dataworks + _dev就是maxCompute的项目名

param.setProjectName(String.join("_", connParam.getProject(), projectEnv));

}else {

// 生产环境dataworks的项目名和maxCompute一致

param.setProjectName(connParam.getProject());

}

return new MaxComputeJdbcUtil(param);

}呼叫OpenApi拉取所有腳本

/**

* 根据文件夹路径分页查询该路径下的文件(脚本)

* @param pageSize 每页查询多少数据

* @param folderPath 文件所在目录

* @param userType 文件所属功能模块 可不传

* @param fileTypes 设置文件代码类型 逗号分割 可不传

*/

public void listAllFiles(Integer pageSize, String folderPath, String userType, String fileTypes, CallBack.FileCallBack callBack) throws ClientException {

pageSize = setPageSize(pageSize);

// 创建请求

final ListFilesRequest request = new ListFilesRequest();

// 设置分页参数

request.setPageNumber(1);

request.setPageSize(pageSize);

// 设置上级文件夹

request.setFileFolderPath(folderPath);

// 设置区域和项目名称

request.setSysRegionId(connParam.getRegion());

request.setProjectIdentifier(connParam.getProject());

// 设置文件所属功能模块

if (!ObjectUtils.isEmpty(userType)){

request.setUseType(userType);

}

// 设置文件代码类型

if (!ObjectUtils.isEmpty(fileTypes)){

request.setFileTypes(fileTypes);

}

// 发起请求

ListFilesResponse res = client.getAcsResponse(request);

// 获取分页总数

final Integer totalCount = res.getData().getTotalCount();

// 返回结果

final List<ListFilesResponse.Data.File> resultList = res.getData().getFiles();

// 计算能分几页

long pages = totalCount % pageSize == 0 ? (totalCount / pageSize) : (totalCount / pageSize) + 1;

// 只有1页 直接返回

if (pages <= 1){

callBack.handle(resultList);

return;

}

// 第一页执行回调

callBack.handle(resultList);

// 分页数据 从第二页开始查询 同步拉取,可以优化为多线程拉取

for (int i = 2; i <= pages; i++) {

//第1页

request.setPageNumber(i);

//每页大小

request.setPageSize(pageSize);

// 发起请求

res = client.getAcsResponse(request);

final List<ListFilesResponse.Data.File> tableEntityList = res.getData().getFiles();

if (!ObjectUtils.isEmpty(tableEntityList)){

// 执行回调函数

callBack.handle(tableEntityList);

}

}

}內部連線MaxCompute拉取所有DDL腳本內容

DataWorks工具類別程式碼,透過回呼函數處理

/**

* 获取所有的DDL脚本

* @param callBack 回调处理函数

*/

public void listAllDdl(CallBack.DdlCallBack callBack){

if (odpsSdk){

final List<TableMetaInfo> tableInfos = maxComputeSdkUtil.getTableInfos();

for (TableMetaInfo tableInfo : tableInfos) {

final String tableName = tableInfo.getTableName();

final String sqlCreateDesc = maxComputeSdkUtil.getSqlCreateDesc(tableName);

callBack.handle(tableName, sqlCreateDesc);

}

}

}MaxCompute工具類別程式碼,依表名取得建表語句, 以SDK為例, JDBC直接執行show create table即可拿到建表語句

/**

* 根据表名获取建表语句

* @param tableName 表名

* @return

*/

public String getSqlCreateDesc(String tableName) {

final Table table = odps.tables().get(tableName);

// 建表语句

StringBuilder mssqlDDL = new StringBuilder();

// 获取表结构

TableSchema tableSchema = table.getSchema();

// 获取表名表注释

String tableComment = table.getComment();

//获取列名列注释

List<Column> columns = tableSchema.getColumns();

/*组装成mssql的DDL*/

// 表名

mssqlDDL.append("CREATE TABLE IF NOT EXISTS ");

mssqlDDL.append(tableName).append("\n");

mssqlDDL.append(" (\n");

//列字段

int index = 1;

for (Column column : columns) {

mssqlDDL.append(" ").append(column.getName()).append("\t\t").append(column.getTypeInfo().getTypeName());

if (!ObjectUtils.isEmpty(column.getComment())) {

mssqlDDL.append(" COMMENT '").append(column.getComment()).append("'");

}

if (index == columns.size()) {

mssqlDDL.append("\n");

} else {

mssqlDDL.append(",\n");

}

index++;

}

mssqlDDL.append(" )\n");

//获取分区

List<Column> partitionColumns = tableSchema.getPartitionColumns();

int partitionIndex = 1;

if (!ObjectUtils.isEmpty(partitionColumns)) {

mssqlDDL.append("PARTITIONED BY (");

}

for (Column partitionColumn : partitionColumns) {

final String format = String.format("%s %s COMMENT '%s'", partitionColumn.getName(), partitionColumn.getTypeInfo().getTypeName(), partitionColumn.getComment());

mssqlDDL.append(format);

if (partitionIndex == partitionColumns.size()) {

mssqlDDL.append("\n");

} else {

mssqlDDL.append(",\n");

}

partitionIndex++;

}

if (!ObjectUtils.isEmpty(partitionColumns)) {

mssqlDDL.append(")\n");

}

// mssqlDDL.append("STORED AS ALIORC \n");

// mssqlDDL.append("TBLPROPERTIES ('comment'='").append(tableComment).append("');");

mssqlDDL.append(";");

return mssqlDDL.toString();

}測試程式碼

public static void main(String[] args) throws ClientException {

final DataWorksOpenApiConnParam connParam = new DataWorksOpenApiConnParam();

connParam.setAliyunAccessId("您的阿里云账号accessId");

connParam.setAliyunAccessKey("您的阿里云账号accessKey");

// dataworks所在区域

connParam.setRegion("cn-chengdu");

// dataworks所属项目

connParam.setProject("dataworks所属项目");

// dataworks所属项目环境 如果不分环境的话设置为生产即可

connParam.setProjectEnv("dev");

// 数据引擎类型 odps

connParam.setDatasourceType("odps");

// ddataworks接口地址

connParam.setEndPoint("dataworks.cn-chengdu.aliyuncs.com");

final DataWorksOpenApiUtil dataWorksOpenApiUtil = new DataWorksOpenApiUtil(connParam, true);

// 拉取所有ODPS脚本

dataWorksOpenApiUtil.listAllFiles(100, "", "", "10", files -> {

// 处理文件

for (ListFilesResponse.Data.File file : files) {

final String fileName = file.getFileName();

System.out.println(fileName);

}

});

// 拉取所有表的建表语句

dataWorksOpenApiUtil.listAllDdl((tableName, tableDdlContent) -> {

System.out.println("=======================================");

System.out.println("表名:" + tableName + "内容如下:\n");

System.out.println(tableDdlContent);

System.out.println("=======================================");

});

}測試結果

test_001腳本

test_002腳本

test_003腳本

test_004腳本

test_005腳本

=================== ====================

表名:test_abc_info內容如下:CREATE TABLE IF NOT EXISTS test_abc_info

(

test_abc1 STRING COMMENT '字段1',

test_abc2 STRING COMMENT '字段2',

test_abc3 ,

test_abc5 STRING COMMENT '字段5' ,

test_abc6 STRING COMMENT '欄位6',

test_abc7 STRING COMMENT '7',##1 PARTITIONED BY (p_date STRING COMMENT '資料日期'

)

;

=========================================

Disconnected from the target VM, address: '127.0.0.1:59509', transport: 'socket'

以上是SpringBoot怎麼整合dataworks的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

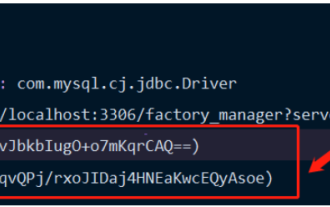

Springboot怎麼整合Jasypt實現設定檔加密

Jun 01, 2023 am 08:55 AM

Springboot怎麼整合Jasypt實現設定檔加密

Jun 01, 2023 am 08:55 AM

Jasypt介紹Jasypt是一個java庫,它允許開發員以最少的努力為他/她的專案添加基本的加密功能,並且不需要對加密工作原理有深入的了解用於單向和雙向加密的高安全性、基於標準的加密技術。加密密碼,文本,數字,二進位檔案...適合整合到基於Spring的應用程式中,開放API,用於任何JCE提供者...添加如下依賴:com.github.ulisesbocchiojasypt-spring-boot-starter2. 1.1Jasypt好處保護我們的系統安全,即使程式碼洩露,也可以保證資料來源的

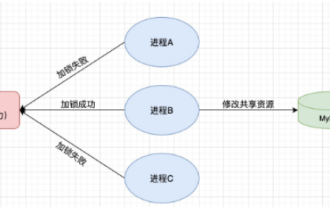

怎麼在SpringBoot中使用Redis實現分散式鎖

Jun 03, 2023 am 08:16 AM

怎麼在SpringBoot中使用Redis實現分散式鎖

Jun 03, 2023 am 08:16 AM

一、Redis實現分散式鎖原理為什麼需要分散式鎖在聊分散式鎖之前,有必要先解釋一下,為什麼需要分散式鎖。與分散式鎖相對就的是單機鎖,我們在寫多執行緒程式時,避免同時操作一個共享變數產生資料問題,通常會使用一把鎖來互斥以保證共享變數的正確性,其使用範圍是在同一個進程中。如果換做是多個進程,需要同時操作一個共享資源,如何互斥?現在的業務應用通常是微服務架構,這也意味著一個應用會部署多個進程,多個進程如果需要修改MySQL中的同一行記錄,為了避免操作亂序導致髒數據,此時就需要引入分佈式鎖了。想要實現分

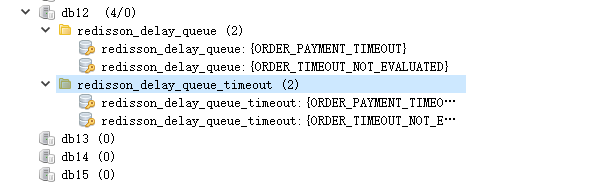

SpringBoot怎麼整合Redisson實現延遲隊列

May 30, 2023 pm 02:40 PM

SpringBoot怎麼整合Redisson實現延遲隊列

May 30, 2023 pm 02:40 PM

使用場景1、下單成功,30分鐘未支付。支付超時,自動取消訂單2、訂單簽收,簽收後7天未進行評估。訂單超時未評價,系統預設好評3、下單成功,商家5分鐘未接單,訂單取消4、配送超時,推播簡訊提醒…對於延時比較長的場景、即時性不高的場景,我們可以採用任務調度的方式定時輪詢處理。如:xxl-job今天我們採

springboot讀取檔案打成jar包後存取不到怎麼解決

Jun 03, 2023 pm 04:38 PM

springboot讀取檔案打成jar包後存取不到怎麼解決

Jun 03, 2023 pm 04:38 PM

springboot讀取文件,打成jar包後訪問不到最新開發出現一種情況,springboot打成jar包後讀取不到文件,原因是打包之後,文件的虛擬路徑是無效的,只能通過流去讀取。文件在resources下publicvoidtest(){Listnames=newArrayList();InputStreamReaderread=null;try{ClassPathResourceresource=newClassPathResource("name.txt");Input

Springboot+Mybatis-plus不使用SQL語句進行多表新增怎麼實現

Jun 02, 2023 am 11:07 AM

Springboot+Mybatis-plus不使用SQL語句進行多表新增怎麼實現

Jun 02, 2023 am 11:07 AM

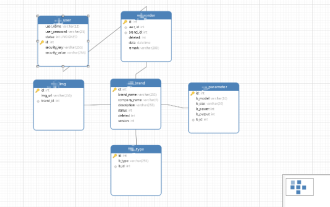

在Springboot+Mybatis-plus不使用SQL語句進行多表添加操作我所遇到的問題準備工作在測試環境下模擬思維分解一下:創建出一個帶有參數的BrandDTO對像模擬對後台傳遞參數我所遇到的問題我們都知道,在我們使用Mybatis-plus中進行多表操作是極其困難的,如果你不使用Mybatis-plus-join這一類的工具,你只能去配置對應的Mapper.xml文件,配置又臭又長的ResultMap,然後再寫對應的sql語句,這種方法雖然看上去很麻煩,但具有很高的靈活性,可以讓我們

SpringBoot怎麼自訂Redis實作快取序列化

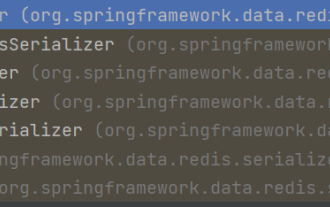

Jun 03, 2023 am 11:32 AM

SpringBoot怎麼自訂Redis實作快取序列化

Jun 03, 2023 am 11:32 AM

1.自訂RedisTemplate1.1、RedisAPI預設序列化機制基於API的Redis快取實作是使用RedisTemplate範本進行資料快取操作的,這裡開啟RedisTemplate類,查看該類別的源碼資訊publicclassRedisTemplateextendsRedisAccessorimplementsRedisOperations,BeanClassLoaderAware{//聲明了value的各種序列化方式,初始值為空@NullableprivateRedisSe

SpringBoot與SpringMVC的比較及差別分析

Dec 29, 2023 am 11:02 AM

SpringBoot與SpringMVC的比較及差別分析

Dec 29, 2023 am 11:02 AM

SpringBoot和SpringMVC都是Java開發中常用的框架,但它們之間有一些明顯的差異。本文將探究這兩個框架的特點和用途,並對它們的差異進行比較。首先,我們來了解一下SpringBoot。 SpringBoot是由Pivotal團隊開發的,它旨在簡化基於Spring框架的應用程式的建立和部署。它提供了一種快速、輕量級的方式來建立獨立的、可執行

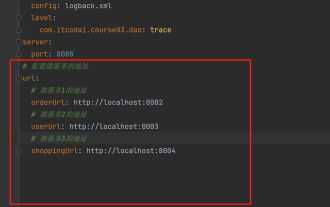

springboot怎麼取得application.yml裡值

Jun 03, 2023 pm 06:43 PM

springboot怎麼取得application.yml裡值

Jun 03, 2023 pm 06:43 PM

在專案中,很多時候需要用到一些配置信息,這些信息在測試環境和生產環境下可能會有不同的配置,後面根據實際業務情況有可能還需要再做修改。我們不能將這些設定在程式碼中寫死,最好是寫到設定檔中,例如可以把這些資訊寫到application.yml檔案中。那麼,怎麼在程式碼裡取得或使用這個位址呢?有2個方法。方法一:我們可以透過@Value註解的${key}即可取得設定檔(application.yml)中和key對應的value值,這個方法適用於微服務比較少的情形方法二:在實際專案中,遇到業務繁瑣,邏