研究人員研發出能聽懂英語指令並執行家務的機器人

普林斯頓大學、史丹佛大學和Google的一組研究人員,利用 OpenAI 的 GPT-3 Davinci 模型,研發出了一款能聽懂英語指令並執行家務的機器人,名為 TidyBot。這款機器人可以依照使用者的喜好,自動完成如分類洗衣服、撿起地上的垃圾、收拾玩具等任務。

GPT-3 Davinci 模型是一種深度學習模型,屬於 GPT 模型系列的一部分,可以理解和產生自然語言。該模型具有強大的總結能力,可以從大量的文字資料中學習複雜的物件屬性和關係。研究人員利用這種能力,讓機器人根據用戶提供的幾個示例對象放置位置,如“黃色襯衫放在抽屜裡,深紫色襯衫放在衣櫃裡,白色襪子放在抽屜裡”,然後讓模型總結出使用者的一般偏好規則,並應用到未來的互動中。

研究人員在論文中寫道:「我們的基本見解是,LLM(大型語言模型)的總結能力與個人化機器人的泛化需求非常匹配。LLM 展示了透過總結實現泛化的驚人能力,利用從海量文本資料集中學習到的複雜物件屬性和關係。」

他們還寫道:「與需要昂貴的資料收集和模型訓練的傳統方法不同,我們展示了LLM 可以直接開箱即用地實現機器人領域的泛化,利用它們從海量文本數據中學習到的強大的總結能力。」

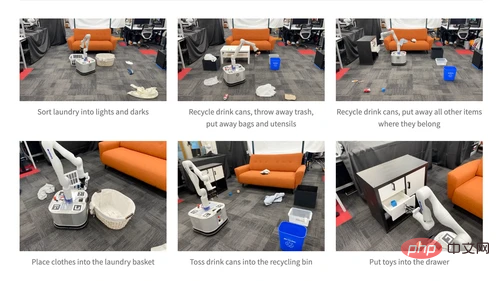

研究人員在論文網站上展示了一個機器人,它能夠將洗衣服分為淺色和深色,回收飲料罐,丟掉垃圾,收拾包包和餐具,將散落的物品放回原處,並將玩具放入抽屜。

研究人員首先測試了一個基於文字的基準資料集,其中輸入了使用者偏好,並要求模型建立個人化規則來確定物品歸屬。模型將範例總結為一般規則,並使用總結來確定新物品的放置位置。基準場景定義在四個房間中,每個房間有 24 個場景。每個場景包含兩到五個放置物品的地方,並且有相同數量的已見和未見物品供模型分類。他們寫道,這個測試在未見物品上達到了 91.2% 的準確率。

當他們將這種方法應用到真實世界的機器人 TidyBot 時,他們發現它能夠成功地收拾 85% 的物體。 TidyBot 在八個真實場景中進行了測試,每個場景有一組十個物品,並在每個場景中運行機器人 3 次。根據IT之家了解,除了 LLM,TidyBot 還使用了一個稱為 CLIP 的影像分類器和一個稱為 OWL-ViT 的物體偵測器。

佐治亞理工學院互動計算學院的助理教授徐丹飛(Danfei Xu)在談到Google的 PaLM-E 模型時表示,LLM 使機器人具有更多的問題解決能力。 「以前的任務規劃系統大多依賴一些形式的搜尋或最佳化演算法,這些演算法不太靈活,也很難建構。LLM 和多模態LLM 使這些系統能夠從互聯網規模的數據中受益,並輕鬆地用於解決新問題。」他說。

以上是研究人員研發出能聽懂英語指令並執行家務的機器人的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

寫在前面今天我們探討下深度學習技術如何改善在複雜環境中基於視覺的SLAM(同時定位與地圖建構)表現。透過將深度特徵提取和深度匹配方法相結合,這裡介紹了一種多功能的混合視覺SLAM系統,旨在提高在諸如低光條件、動態光照、弱紋理區域和嚴重抖動等挑戰性場景中的適應性。我們的系統支援多種模式,包括拓展單目、立體、單目-慣性以及立體-慣性配置。除此之外,也分析如何將視覺SLAM與深度學習方法結合,以啟發其他研究。透過在公共資料集和自採樣資料上的廣泛實驗,展示了SL-SLAM在定位精度和追蹤魯棒性方面優

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

人形機器人Ameca升級第二代了!最近,在世界行動通訊大會MWC2024上,世界上最先進機器人Ameca又現身了。會場周圍,Ameca引來一大波觀眾。得到GPT-4加持後,Ameca能夠對各種問題做出即時反應。 「來一段舞蹈」。當被問及是否有情感時,Ameca用一系列的面部表情做出回應,看起來非常逼真。就在前幾天,Ameca背後的英國機器人公司EngineeredArts剛剛示範了團隊最新的開發成果。影片中,機器人Ameca具備了視覺能力,能看見並描述房間整個狀況、描述具體物體。最厲害的是,她還能

AI如何使機器人更具自主性和適應性?

Jun 03, 2024 pm 07:18 PM

AI如何使機器人更具自主性和適應性?

Jun 03, 2024 pm 07:18 PM

在工業自動化技術領域,最近有兩個熱點很難被忽視:人工智慧(AI)和英偉達(Nvidia)。不要改變原內容的意思,微調內容,重寫內容,不要續寫:「不僅如此,這兩者密切相關,因為英偉達在不僅僅局限於其最開始的圖形處理單元(GPU),正在將其GPU科技擴展到數位孿生領域,同時緊密連接著新興的AI技術。泰瑞達機器人及其MiR和優傲機器人公司。 Recently,Nvidiahascoll

2 個月不見,人形機器人 Walker S 會摺衣服了

Apr 03, 2024 am 08:01 AM

2 個月不見,人形機器人 Walker S 會摺衣服了

Apr 03, 2024 am 08:01 AM

機器之能報道編輯:吳昕國內版的人形機器人+大模型組隊,首次完成疊衣服這類複雜柔性材料的操作任務。隨著融合了OpenAI多模態大模型的Figure01揭開神秘面紗,國內同行的相關進展一直備受關注。就在昨天,國內"人形機器人第一股"優必選發布了人形機器人WalkerS深入融合百度文心大模型後的首個Demo,展示了一些有趣的新功能。現在,得到百度文心大模型能力加持的WalkerS是這個樣子的。和Figure01一樣,WalkerS沒有走動,而是站在桌子後面完成一系列任務。它可以聽從人類的命令,折疊衣物

首個自主完成人類任務機器人出現,五指靈活速度超人,大模型加持虛擬空間訓練

Mar 11, 2024 pm 12:10 PM

首個自主完成人類任務機器人出現,五指靈活速度超人,大模型加持虛擬空間訓練

Mar 11, 2024 pm 12:10 PM

這週,由OpenAI、微軟、貝佐斯和英偉達投資的機器人公司FigureAI宣布獲得接近7億美元的融資,計劃在未來一年內研發出可獨立行走的人形機器人。而特斯拉的擎天柱也屢屢傳出好消息。沒人懷疑,今年會是人形機器人爆發的一年。一家位於加拿大的機器人公司SanctuaryAI最近發布了一款全新的人形機器人Phoenix。官方號稱它能以和人類一樣的速率自主完成許多工作。世界上第一台能以人類速度自主完成任務的機器人Pheonix可以輕輕地抓取、移動並優雅地將每個物件放置在它的左右兩側。它能夠自主辨識物體的

一文搞懂:AI、機器學習與深度學習的連結與區別

Mar 02, 2024 am 11:19 AM

一文搞懂:AI、機器學習與深度學習的連結與區別

Mar 02, 2024 am 11:19 AM

在當今科技日新月異的浪潮中,人工智慧(ArtificialIntelligence,AI)、機器學習(MachineLearning,ML)與深度學習(DeepLearning,DL)如同璀璨星辰,引領著資訊科技的新浪潮。這三個詞彙經常出現在各種前沿討論和實際應用中,但對於許多初涉此領域的探索者來說,它們的具體含義及相互之間的內在聯繫可能仍籠罩著一層神秘面紗。那讓我們先來看看這張圖。可以看出,深度學習、機器學習和人工智慧之間存在著緊密的關聯和遞進關係。深度學習是機器學習的一個特定領域,而機器學習

超強!深度學習Top10演算法!

Mar 15, 2024 pm 03:46 PM

超強!深度學習Top10演算法!

Mar 15, 2024 pm 03:46 PM

自2006年深度學習概念被提出以來,20年快過去了,深度學習作為人工智慧領域的一場革命,已經催生了許多具有影響力的演算法。那麼,你所認為深度學習的top10演算法有哪些呢?以下是我心目中深度學習的頂尖演算法,它們在創新、應用價值和影響力方面都佔有重要地位。 1.深度神經網路(DNN)背景:深度神經網路(DNN)也叫多層感知機,是最普遍的深度學習演算法,發明之初由於算力瓶頸而飽受質疑,直到近些年算力、數據的爆發才迎來突破。 DNN是一種神經網路模型,它包含多個隱藏層。在該模型中,每一層將輸入傳遞給下一層,並

塑造未來的十款類人機器人

Mar 22, 2024 pm 08:51 PM

塑造未來的十款類人機器人

Mar 22, 2024 pm 08:51 PM

以下10款類人機器人正在塑造我們的未來:1、ASIMO:ASIMO由Honda開發,是最知名的人形機器人之一。 ASIMO高4英尺,重119磅,配備先進的感測器和人工智慧功能,使其能夠在複雜的環境中導航並與人類互動。 ASIMO的多功能性使其適用於各種任務,從幫助殘疾人到在活動中進行演示。 2、Pepper:由SoftbankRobotics創建,Pepper旨在成為人類的社交伴侶。憑藉其富有表現力的面孔和識別情緒的能力,Pepper可以參與對話、在零售環境中提供幫助,甚至提供教育支持。 Pepper的