超高解析度作為記錄和顯示高品質影像、影片的一種標準受到眾多研究者的歡迎,與較低解析度(1K 高清格式)相比,高解析度捕捉的場景通常細節十分清晰,像素的訊息被一個小patch 放大。但是,想要將這種技術應用於影像處理和電腦視覺還面臨許多挑戰。

本文中,來自阿里巴巴的研究者專注於新的視圖合成任務,提出了一個名為4K-NeRF 的框架,其基於NeRF 的體積渲染方法可以實現在4K 超高解析度下高保真視圖合成。

#論文網址:https://arxiv.org/abs/2212.04701

專案首頁:https://github.com/frozoul/4K-NeRF

#話不多說,我們先來看看效果(以下影片均進行了降採樣處理,原版4K 影片請參考原項目)。

接下來我們來看看研究是如何實現的。

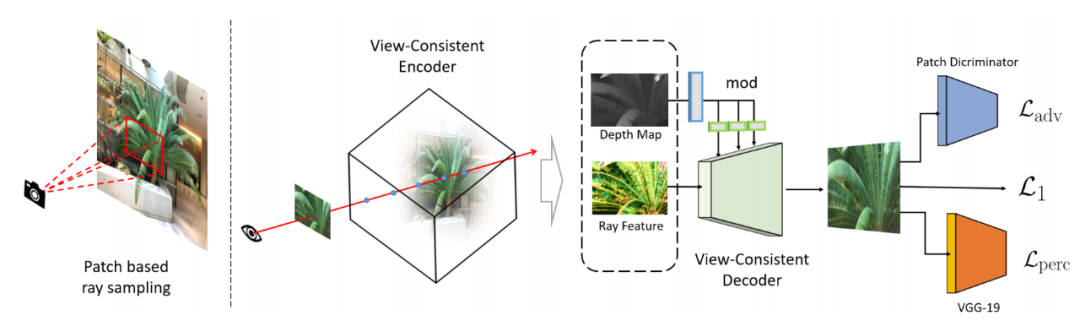

4K-NeRF pipeline(如下圖):使用基於patch 的射線採樣技術,聯合訓練VC-Encoder(View-Consistent)(基於DEVO)在一個較低解析度的空間中編碼三維幾何訊息,之後經過一個VC-Decoder 實現針對高頻細高品質的渲染與視圖一致性的增強。

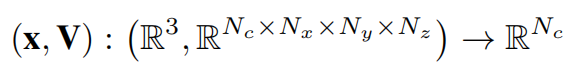

該研究基於DVGO [32] 中定義的公式實例化編碼器,學習到的基於體素網格的表示來明確地編碼幾何結構:

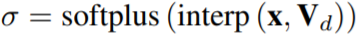

對於每個取樣點,密度估計的三線性插值配備了一個softplus 激活函數用於產生該點的體密度值:

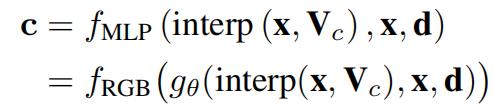

#顏色則是用一個小型的MLP 估計算:

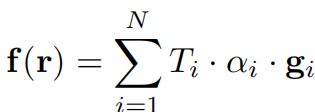

這樣可以透過累積沿著設線r 的取樣點的特徵來得到每個射線(或像素)的特徵值:

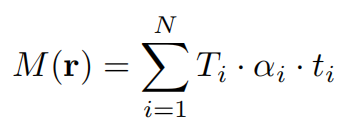

#為了更好地利用嵌入在VC-Encoder 中的幾何屬性,該研究還透過估計每條射線r 沿採樣射線軸的深度產生了一個深度圖。估計的深度圖為上面Encoder 產生的場景三維結構提供了強有力的指導:

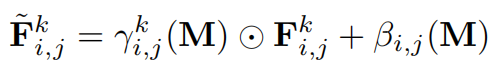

之後經過的網路是透過疊加幾個卷積塊(既不使用非參數歸一化,也不使用降採樣操作)和交錯的升採樣操作來建立的。特別是,該研究不是簡單地將特徵 F 和深度圖 M 連接起來,而是加入了深度圖中的深度訊號,並透過學習變換將其註入每個區塊來調製區塊來啟動。

不同於傳統的 NeRF 方法中的像素級機制,該研究的方法旨在捕捉射線(像素)之間的空間資訊。因此,這裡不適合採用 NeRF 中隨機射線採樣的策略。因此該研究提出了一種基於 patch 的射線採樣訓練策略,以方便捕捉射線特徵之間的空間依賴性。訓練中,首先將訓練視圖的影像分割成大小為 N_p×N_p 的 patch p,以確保像素上的取樣機率是均勻的。當影像空間維數無法被 patch 大小精確分割時,需要截斷 patch 直到邊緣,得到一組訓練 patch。然後從集合中隨機抽取一個 (或多個) patch,透過 patch 中像素的射線形成每次迭代的 mini-batch。

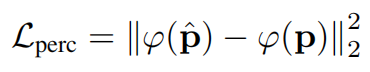

為了解決對精細細節產生模糊或過度平滑視覺效果的問題,該研究添加了對抗性損失和感知損失來規範精細細節合成。感知損失 透過預先訓練的19 層VGG 網路來估計特徵空間中預測的patch

透過預先訓練的19 層VGG 網路來估計特徵空間中預測的patch 和真值p 之間的相似性:

和真值p 之間的相似性:

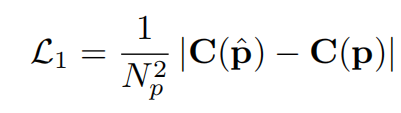

該研究使用 損失而不是MSE 來監督高頻細節的重建

損失而不是MSE 來監督高頻細節的重建

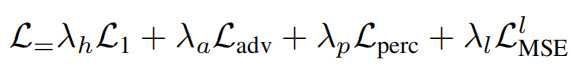

此外,研究也加入了一個輔助MSE 損失,最後總的loss 函數形式如下:

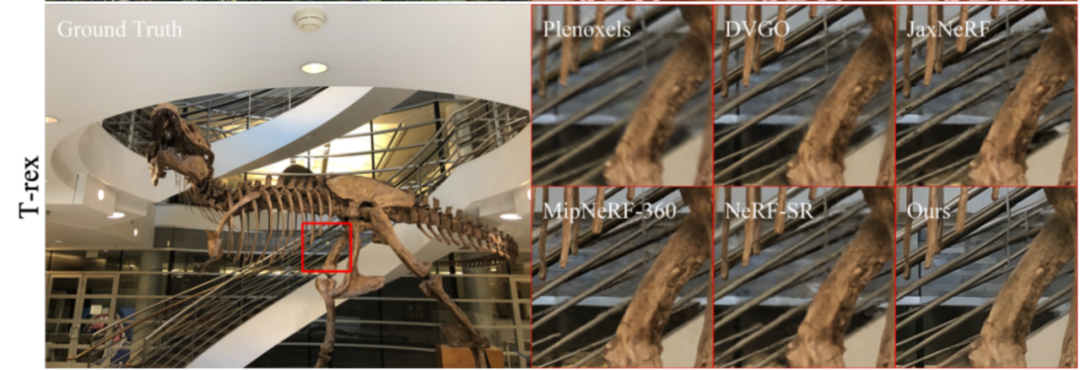

定性分析

#實驗對4K-NeRF 與其他模型進行了比較,可以看到基於普通NeRF 的方法有著不同程度的細節失落、模糊現象。相比之下,4K-NeRF 在這些複雜和高頻細節上呈現了高品質的逼真渲染,即使是在訓練視野有限的場景上。

#量化分析

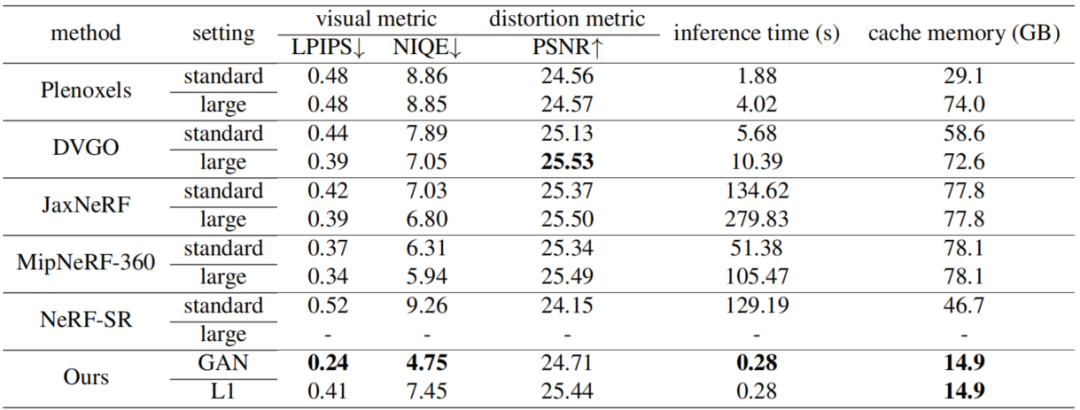

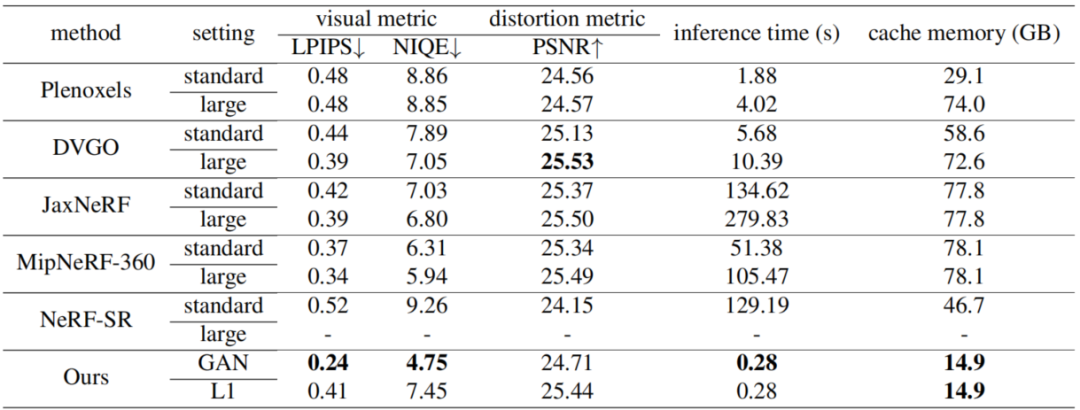

##研究與目前幾個方法在4k 資料的基準下去做對比,包括Plenoxels、DVGO、JaxNeRF、MipNeRF-360 和NeRF-SR。實驗不但以影像恢復的評估指標作為對比,也提供了推理時間和快取內存,以供全面評估參考。結果如下:

該研究探討了NeRF 在精細細節建模方面的能力,提出了一個新穎的框架來增強其在以極高分辨率的場景中恢復視圖一致的細微細節的表現力。此外,該研究還引入了一對保持幾何一致性的編解碼器模組,在較低的空間中有效地建模幾何性質,並利用幾何感知特徵之間的局部相關性實現全尺度空間中的視圖一致性的增強,並且基於patch 的抽樣訓練框架也允許該方法整合來自面向感知的正則化的監督。該研究希望將框架合併到動態場景建模中的效果,以及神經渲染任務作為未來的方向。

以上是神還原物件複雜、高頻細節,4K-NeRF高保真視圖合成來了的詳細內容。更多資訊請關注PHP中文網其他相關文章!