訓練成本不到1000元,直降90%! NUS、清華發表VPGTrans:輕鬆客製化類GPT-4多模態大模型

今年是AI技術爆發發展的一年,以ChatGPT為代表的大語言模型(LLM)大火。

語言模型除了在自然語言領域顯示出巨大的潛力之外,也開始逐漸輻射到其他模態,例如文生圖模型Stable Diffusion的背後也需要語言模型。

從頭開始訓練一個視覺-語言模型(VL-LLM)往往需要消耗大量的資源,所以現有的解決方案都是把語言模型和視覺提示生成模型(Visual Prompt Generator, VPG)連接起來,但即便如此,繼續調整VPG仍需要數千個GPU小時和數百萬的訓練資料。

最近,新加坡國立大學和清華大學的研究人員提出了一個解決方案VPGTrans,將現有的VPG遷移到現有的VL-LLM模型中,就能以低成本的方式獲得目標VL-LLM模型。

論文連結:https://arxiv.org/abs/2305.01278

#程式碼連結:https://github.com/VPGTrans/VPGTrans

多模態對話模型Demo :https://vpgtrans.github.io/

作者:張傲,費豪,姚遠,吉煒,黎力,劉知遠,Chua Tat- Seng

單位:新加坡國立大學,清華大學

##文章的主要創新點包括:

1. 極低訓練成本:

#透過我們提出的VPGTrans方法,可以快速(少於10%訓練時間)將現有的多模態對話模型的視覺模組遷移到新的語言模型,且達到類似或更優效果。

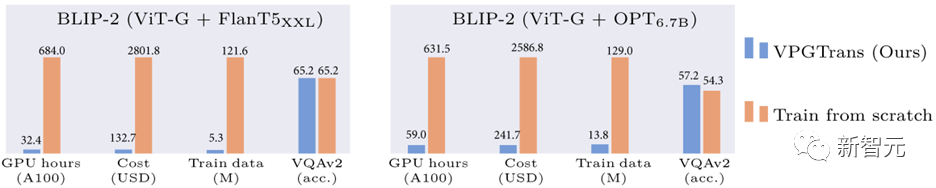

例如,相較於從頭訓練視覺模組,我們可以將BLIP-2 FlanT5-XXL的訓練開銷從19000 人民幣縮減到不到1000元:

#圖1:基於我們的VPGTrans方法的BLIP-2訓練開銷縮減比較

2. 多模態大模型客製化:

#透過我們的VPGTrans框架可以根據需求為各種新的大語言模型靈活添加視覺模組。例如我們在LLaMA-7B和Vicuna-7B基礎上製作了VL-LLaMA和VL-Vicuna。

3. 開源多模態對話模型:

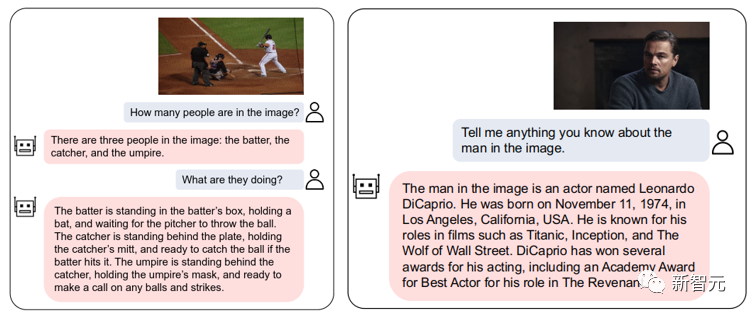

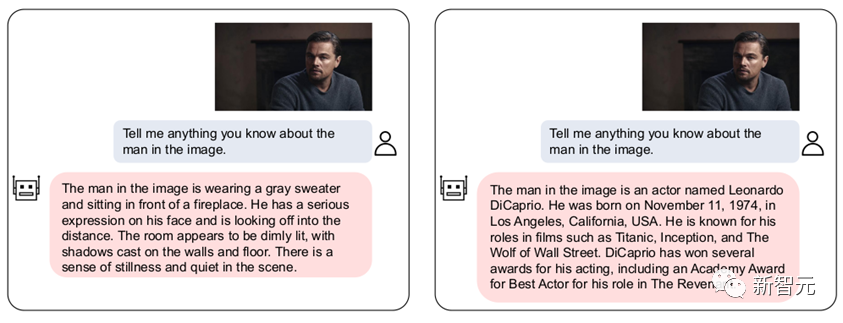

##圖2:VL-Vicuna的互動實例

#一、動機介紹##1.1 背景

#########LLM在多模態理解領域掀起了一股從傳統預訓練視覺語言模型(VLM)到基於大語言模型的視覺語言模型(VL-LLM)的變革。 ######透過為LLM存取視覺模組,VL-LLM可以繼承已有LLM的知識,零樣本泛化能力,推理能力和規劃能力等。相關模型有BLIP-2[1],Flamingo[2],PALM-E等。

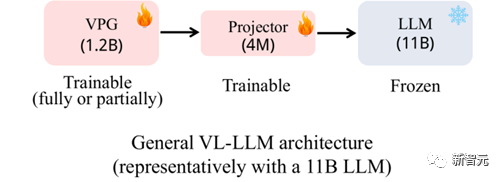

#圖3:常用的VL-LLM架構

現有的常用的VL-LLM基本上採取圖3所示的架構:在一個基座LLM基礎上訓練一個視覺soft prompt生成模組(Visual Prompt Generator, VPG),以及一個進行維度變換的線性層(Projector)。

在參數規模上,LLM一般占主要部分(例如11B),VPG佔次要部分(例如1.2B),Projector最小(4M)。

在訓練過程中,LLM參數一般不會被更新,或是只更新非常少量的參數。可訓練參數主要來自於VPG和projector。

1.2 動機

實際上,即使基座LLM的參數凍結不訓,但由於LLM的大參數量,訓練一個VL -LLM的關鍵開銷依然在於載入基座LLM。

因此訓練一個VL-LLM依然無法避免極大的運算代價。例如,要得到BLIP-2(基座LLM為FlanT5-XXL)需要付出超過600小時的A100訓練時長。如果租用亞馬遜的A100-40G機器,大概需要將近2萬元的費用。

既然從零訓練一個VPG代價如此昂貴,那麼我們開始思考能否把一個已有的VPG遷移到新的LLM上來節省開銷。

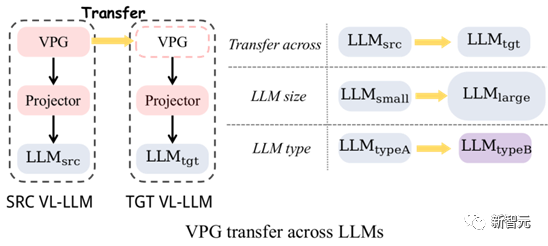

圖4:VPG遷移: 跨LLM大小遷移與跨LLM類型遷移

如圖4所示,我們主要探索了兩種類型的VPG的遷移:

#(1)跨LLM大小遷移(TaS) :例如從OPT-2.7B到OPT-6.7B。

(2)跨LLM類型遷移(TaT):例如從OPT到FlanT5。

其中TaS的意義在於:在LLM相關科研中,我們通常需要在小LLM上調參,再擴展到大LLM。有了TaS,我們可以在調參之後,把小LLM上已經訓練好的VPG直接遷移到大LLM上。

TaT的意義在於:不同功能種類的LLM層出不窮,例如今天有了LLaMA,明天又有了Alpaca和Vicuna。 TaT可以讓我們利用現有的VPG快速為新語言模型添加視覺感知能力。

1.3 貢獻

(1)提出高效率的方法:我們先透過一系列的探究實驗,探討了影響VPG遷移效率的關鍵因素。根據探索實驗發現,我們提出了一個兩階段的高效率遷移框架VPGTrans#。此框架可以大幅縮減訓練VL-LLM所需的計算開銷和所需的訓練資料。

例如,相較於從頭訓練,我們透過BLIP-2 OPT-2.7B到6.7B的VPG遷移,可以只用大約10%的資料和計算時間就達成各個資料集相似或更好的效果(圖1)。

訓練花銷從17901人民幣到1673元。

######(2)得到有趣的發現:###############我們同時提供了TaS和TaT場景下一些有趣的發現,並嘗試給予解釋:######a) TaS場景下,使用VPGTrans從小到大遷移不會影響最終模型效果。

b) TaS場景下,在越小的語言模型上訓練的VPG,遷移到大模型時效率越高,最終效果越好。

c) TaT場景下,越小的模型之間遷移的gap越大。在我們驗證實驗中,OPT350M和FlanT5-base使用VPGTrans互相遷移幾乎和從頭訓練一樣慢。

(3)開源:

#我們使用VPGTrans得到了兩個新的VL-LLMs:VL-LLaMA和VL-Vicuna,並開源在了社群上。其中VL-Vicuna實現了類GPT4的高品質的多模態對話。

二、高效率的VPG遷移方案:VPGTrans

首先我們進行一系列的探索驗證實驗,分析如何最大化VPG的遷移效率。接著我們基於這些重要觀察提出一個解決方案。

2.1 探究實驗

我們選取BLIP-2架構為我們的基礎模型,預訓練語料採用COCO和SBU,總共1.4M圖文對。

下游任務採用COCO Caption, NoCaps, VQAv2, GQA和OK-VQA的zero-shot設定進行評測(對caption任務並非嚴格zero-shot)。以下是我們的關鍵發現:

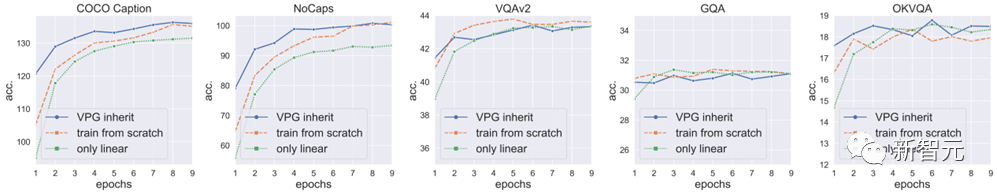

(1)直接繼承一個訓練好的VPG可以加速收斂,但效果有限:

我們發現,直接遷移一個LLM上訓練好的VPG到大LLM可以加速模型收斂,但加速效果有限,且收斂後模型效果相比於從頭訓練VPG會掉點(圖5的VQAv2、GQA藍線最高點都低於橘線)。

我們猜測,這個掉點是由於隨機初始化的projector會在訓練起始階段損傷VPG中已有的視覺感知能力。

下圖顯示直接繼承已實現的VPG所得到的結果 (藍色曲線)。重新訓練VPG (橘線):重新從頭訓練VPG。 The only training conducted is on the linear projector, with no training on VPG.。

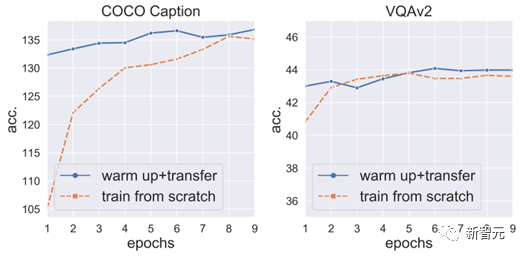

(2)先warm-up訓練projector可以防止掉點,且進一步加速收斂:

於是,我們固定住VPG和LLM,先warm-up訓練projector 3個epoch,再解凍VPG進行下一步訓練。

我們發現,這樣不只可以避免掉點情況,還能夠進一步加速VPG收斂(圖6)。

但值得強調的是,由於訓練的主要開銷在LLM(參數巨多),僅僅訓練projector的開銷不會比同時訓練VPG和projector的開銷小太多。

所以,我們開始探究加速projector warm-up的關鍵技術。

#圖6:先warm-up訓練projector可以防止掉點加速收斂

(3)詞向量轉換器初始化可以加速projector warm-up:

#首先,VPG是透過把映像轉換成LLM可以理解的soft prompt來產生效果的。而soft prompt的使用方式和詞向量其實是非常相似的,都是直接輸入語言模型來提示模型產生對應內容。

所以,我們使用字向量來作為soft prompt的一個代理,訓練了一個

的詞向量轉換器(一個線性層)。

然後,我們將詞向量轉換器和

透過這個初始化,我們可以將projector的warm-up訓練由3個epoch減為2個epoch。

(4)projector可以在超大學習率下快速收斂:

我們進一步實驗發現,projector由於其參數量較少,可以使用5倍的正常學習率進行訓練而不崩潰。

透過5倍學習率的訓練,projector warm-up可以進一步縮短到1個epoch。

(5)一個附加發現:

#雖然projector warm-up很重要,但只訓練projector是不夠的。尤其在caption任務上面,僅訓練projector的效果比同時訓練VPG的效果差一截(圖5綠線在COCO Caption和NoCaps都遠低於藍線)。

這也意味著,僅僅訓練projector會導致欠擬合,也就是無法充分對齊到訓練資料。

2.2 我們所提出的方法

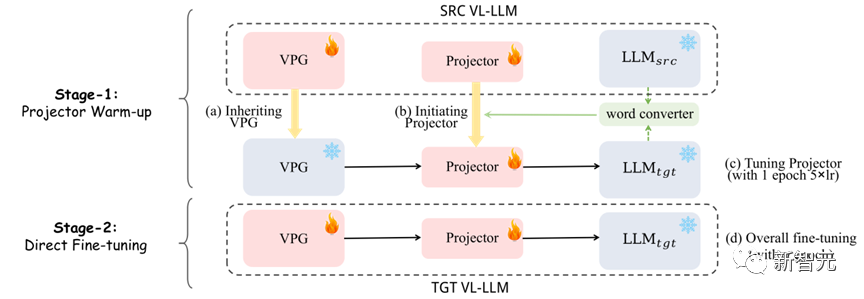

圖7:VPGTrans框架: (1) 一階段:projector的warm-up (2) 二階段: 整體微調

如圖7所示,我們的方法共分為兩個階段:

(1)第一階段:我們先使用詞向量轉換器和原有projector進行融合作為新projector的初始化,然後用5倍學習率訓練新projector一個epoch。

(2)第二階段:直接正常訓練VPG和projector。

三、實驗結果

3.1 加速比

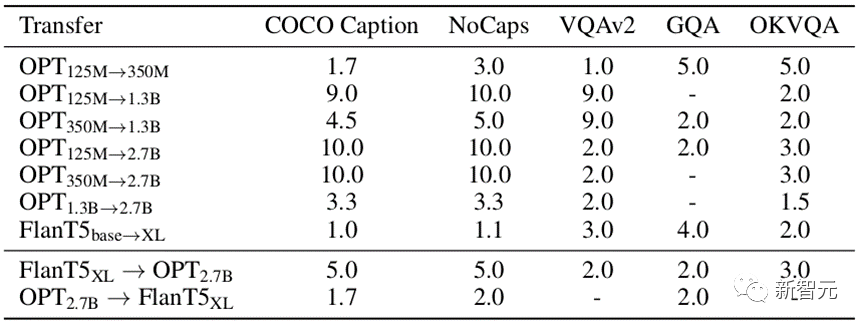

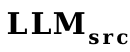

表1:我們的VPGTrans的比較於從頭訓練在各個資料集的加速比

如表1所示,我們測試了不同遷移類型下,VPGTrans在不同資料集上的加速比。

VPGTrans在某指定資料集A上的加速比是從頭訓練達到A上最佳效果a的輪數除以VPGTrans在A上效果超過a的最小訓練輪數得到。

例如,從頭在OPT-2.7B上訓練VPG,在COCO caption達到最佳效果需要10個epoch,但從OPT-125M遷移VPG到OPT-2.7B,僅需1個epoch就能達到該最佳效果。則加速比為10/1=10倍。

我們可以看到,無論是在TaS還是在TaT場景下,我們的VPGTrans都可以實現穩定的加速。

3.2 有趣的發現

我們選取了一個比較有趣的發現進行了說明,其他更多更有意思的發現請參考我們的論文。

TaS場景下,在越小的語言模型上訓練的VPG,遷移起來效率越高,最後模型效果越好。參考表1,我們可以發現OPT-1.3B到OPT-2.7B的加速比要遠小於OPT-125M、OPT-350M到OPT-2.7b的加速比。

我們嘗試提供了一個解釋:一般越大的語言模型,由於其文字空間的維度更高,會更容易損害VPG(VPG一般都是類似CLIP的預訓練模型)本身的視覺感知能力。我們透過類似linear probing的方式進行了驗證:

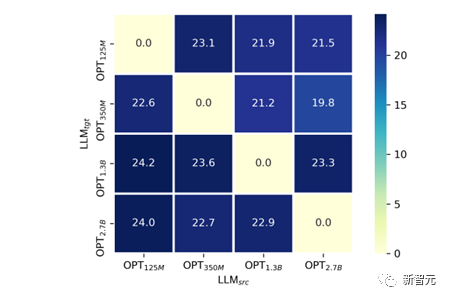

#圖8:僅訓練linear projector層的跨LLM大小遷移(模擬linear probing)

如圖8所示,我們進行了OPT-125M,350M,1.3B,2.7B之間的跨LLM大小的遷移。

在實驗中,為了公平對比不同模型大小下訓練過的VPG的視覺感知能力,我們固定住VPG的參數僅僅訓練linear projector層。我們選取了COCO Caption上的SPICE指標作為視覺感知能力的測量。

不難發現,對於每一個給定的 ,幾乎都符合

,幾乎都符合 越小,最終SPICE越高的一個現象。

越小,最終SPICE越高的一個現象。

3.3 大規模實驗

前文實驗主要是在小規模場景下驗證猜想。為了證明我們的方法的有效性,我們模擬BLIP-2的預訓練過程進行了大規模實驗:

表2:真實場景下的大規模實驗結果

如表2所示,我們的VPGTrans在大規模場景下依然有效。透過OPT-2.7B到OPT-6.7B的遷移,我們只用10.8%的資料和不到10%的訓練時長達到了相似或更優的效果。

尤其是,我們的方法在BLIP-2以FlanT5-XXL為基座的VL-LLM實現了4.7%的訓練成本控制。

四、自訂您的VL-LLMs

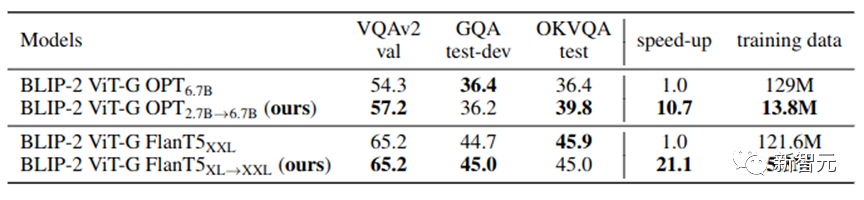

我們的VPGTrans可以快速為任意新的LLMs添加視覺感知模組,從而得到一個全新的高品質VL- LLM。在本工作,我們額外訓練了一個VL-LLaMA和一個VL-Vicuna。其中VL-LLaMA的效果如下:

#

表3:VL-LLaMA的效果展示

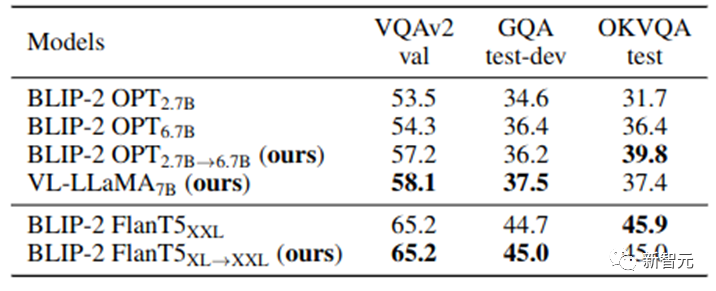

同时,我们的VL-Vicuna可以进行类GPT-4的多模态对话。我们和MiniGPT-4进行了简单的比较:

五、总结

在这项工作中,我们对VPG在LLM之间的可迁移性问题进行了全面调查。我们首先探讨了最大化迁移效率的关键因素。

基于关键观察,我们提出了一种新颖的两阶段迁移框架,即VPGTrans。它可以在显著降低训练成本的同时,实现相当或更好的性能。

通过VPGTrans,我们实现了从BLIP-2 OPT 2.7B到BLIP-2 OPT 6.7B的VPG迁移。相较于从零开始连接VPG到OPT 6.7B,VPGTrans仅需10.7%训练数据和不到10%的训练时长。

此外,我们展示并讨论了一系列有趣发现及其背后的可能原因。最后,我们通过训练VL-LLaMA和LL-Vicuna,展示了我们的VPGTrans在定制新的VL-LLM方面的实际价值。

以上是訓練成本不到1000元,直降90%! NUS、清華發表VPGTrans:輕鬆客製化類GPT-4多模態大模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

ChatGPT 現在允許免費用戶使用 DALL-E 3 產生每日限制的圖像

Aug 09, 2024 pm 09:37 PM

DALL-E 3 於 2023 年 9 月正式推出,是比其前身大幅改進的車型。它被認為是迄今為止最好的人工智慧圖像生成器之一,能夠創建具有複雜細節的圖像。然而,在推出時,它不包括

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想像一下,一個人工智慧模型,不僅擁有超越傳統運算的能力,還能以更低的成本實現更有效率的效能。這不是科幻,DeepSeek-V2[1],全球最強開源MoE模型來了。 DeepSeek-V2是一個強大的專家混合(MoE)語言模型,具有訓練經濟、推理高效的特點。它由236B個參數組成,其中21B個參數用於啟動每個標記。與DeepSeek67B相比,DeepSeek-V2效能更強,同時節省了42.5%的訓練成本,減少了93.3%的KV緩存,最大生成吞吐量提高到5.76倍。 DeepSeek是一家探索通用人工智

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

本月初,來自MIT等機構的研究者提出了一種非常有潛力的MLP替代方法—KAN。 KAN在準確性和可解釋性方面表現優於MLP。而且它能以非常少的參數量勝過以更大參數量運行的MLP。例如,作者表示,他們用KAN以更小的網路和更高的自動化程度重現了DeepMind的結果。具體來說,DeepMind的MLP有大約300,000個參數,而KAN只有約200個參數。 KAN與MLP一樣具有強大的數學基礎,MLP基於通用逼近定理,而KAN基於Kolmogorov-Arnold表示定理。如下圖所示,KAN在邊上具

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人Optimus最新影片出爐,已經可以在工廠裡打工了。正常速度下,它分揀電池(特斯拉的4680電池)是這樣的:官方還放出了20倍速下的樣子——在小小的「工位」上,揀啊揀啊揀:這次放出的影片亮點之一在於Optimus在廠子裡完成這項工作,是完全自主的,全程沒有人為的干預。而且在Optimus的視角之下,它還可以把放歪了的電池重新撿起來放置,主打一個自動糾錯:對於Optimus的手,英偉達科學家JimFan給出了高度的評價:Optimus的手是全球五指機器人裡最靈巧的之一。它的手不僅有觸覺

FisheyeDetNet:首個以魚眼相機為基礎的目標偵測演算法

Apr 26, 2024 am 11:37 AM

FisheyeDetNet:首個以魚眼相機為基礎的目標偵測演算法

Apr 26, 2024 am 11:37 AM

目標偵測在自動駕駛系統當中是一個比較成熟的問題,其中行人偵測是最早得以部署演算法之一。在多數論文當中已經進行了非常全面的研究。然而,利用魚眼相機進行環視的距離感知相對來說研究較少。由於徑向畸變大,標準的邊界框表示在魚眼相機當中很難實施。為了緩解上述描述,我們探索了擴展邊界框、橢圓、通用多邊形設計為極座標/角度表示,並定義一個實例分割mIOU度量來分析這些表示。所提出的具有多邊形形狀的模型fisheyeDetNet優於其他模型,並同時在用於自動駕駛的Valeo魚眼相機資料集上實現了49.5%的mAP

牛津大學最新! Mickey:3D中的2D影像匹配SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

牛津大學最新! Mickey:3D中的2D影像匹配SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

寫在前面項目連結:https://nianticlabs.github.io/mickey/給定兩張圖片,可以透過建立圖片之間的對應關係來估計它們之間的相機姿態。通常,這些對應關係是二維到二維的,而我們估計的姿態在尺度上是不確定的。一些應用,例如隨時隨地實現即時增強現實,需要尺度度量的姿態估計,因此它們依賴外部的深度估計器來恢復尺度。本文提出了MicKey,這是一個關鍵點匹配流程,能夠夠預測三維相機空間中的度量對應關係。透過學習跨影像的三維座標匹配,我們能夠在沒有深度測試的情況下推斷度量相對

單卡跑Llama 70B快過雙卡,微軟硬生把FP6搞到A100哩 | 開源

Apr 29, 2024 pm 04:55 PM

單卡跑Llama 70B快過雙卡,微軟硬生把FP6搞到A100哩 | 開源

Apr 29, 2024 pm 04:55 PM

FP8和更低的浮點數量化精度,不再是H100的「專利」了!老黃想讓大家用INT8/INT4,微軟DeepSpeed團隊在沒有英偉達官方支援的條件下,硬生在A100上跑起FP6。測試結果表明,新方法TC-FPx在A100上的FP6量化,速度接近甚至偶爾超過INT4,而且比後者擁有更高的精度。在此基礎之上,還有端到端的大模型支持,目前已經開源並整合到了DeepSpeed等深度學習推理框架中。這項成果對大模型的加速效果也是立竿見影──在這種框架下用單卡跑Llama,吞吐量比雙卡還要高2.65倍。一名

全面超越DPO:陳丹琦團隊提出簡單偏好優化SimPO,也煉出最強8B開源模型

Jun 01, 2024 pm 04:41 PM

全面超越DPO:陳丹琦團隊提出簡單偏好優化SimPO,也煉出最強8B開源模型

Jun 01, 2024 pm 04:41 PM

為了將大型語言模型(LLM)與人類的價值和意圖對齊,學習人類回饋至關重要,這能確保它們是有用的、誠實的和無害的。在對齊LLM方面,一種有效的方法是根據人類回饋的強化學習(RLHF)。儘管RLHF方法的結果很出色,但其中涉及了一些優化難題。其中涉及訓練一個獎勵模型,然後優化一個策略模型來最大化該獎勵。近段時間已有一些研究者探索了更簡單的離線演算法,其中之一就是直接偏好優化(DPO)。 DPO是透過參數化RLHF中的獎勵函數來直接根據偏好資料學習策略模型,這樣就無需顯示式的獎勵模型了。此方法簡單穩定