UCSD、MIT等華人團隊教機器狗感知3D世界!搭M1晶片,爬樓跨障無所不能

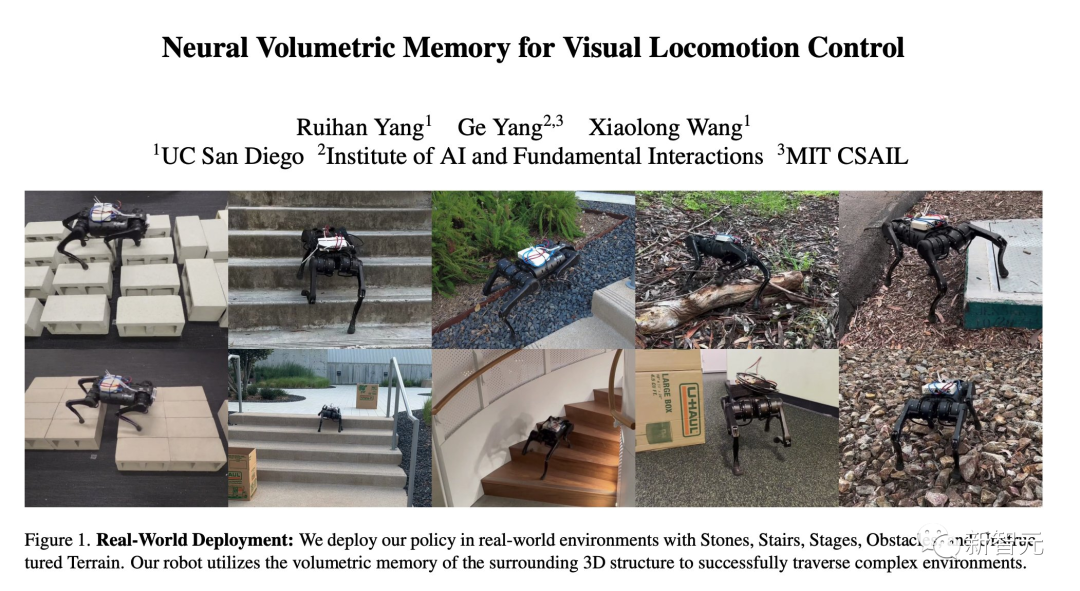

最近,來自UCSD、IAIFI和MIT機構的研究人員,用一種全新的神經體積記憶架構(NVM),教會了一隻機器狗感知三維世界。

利用這項技術,機器狗可以透過單一的神經網路實現爬樓梯、跨縫隙、翻障礙等等——完全自主,無需遙控。

不知道你有沒有註意到狗背上那個的白盒子?

裡面搭載的是蘋果的M1晶片,負責執行機器狗的視覺處理任務。而且,還是團隊從Mac上拆下來的。

不難看出,MIT的這隻機器狗可以輕鬆地爬過了橫在自己面前一段樹枝,毫不費力(基本上)。

長了4隻腳的MacBook?

眾所周知,對於機器狗,以及其他有腿的機器人來說,想要翻越不平整的道路,可謂是困難重重。

路面狀況越是複雜,就有越多的障礙物無法被看見。

為了解決「部分可觀測環境」問題,目前SOTA的視覺-運動技術透過框架堆疊(frame-stacking),將影像通道連接起來。

然而,這種簡單的處理方法遠遠落後於現在的電腦視覺技術——後者可以明確地模擬光流和特定的3D幾何形狀。

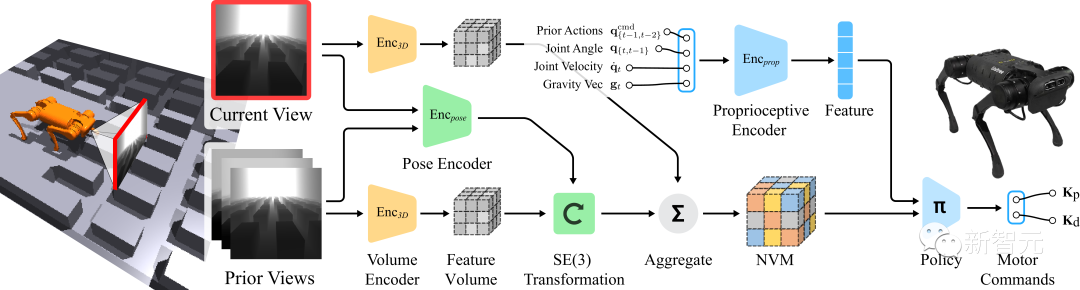

受此啟發,團隊提出了一種神經體積記憶架構(NVM),可以充分考慮到三維世界的SE(3)等變性(Equivalence)。

計畫網址:https://rchalyang.github.io/NVM/

與以往的方法不同,NVM是一種體積格式。它可以將來自多個相機視圖的特徵體積聚合到機器人的自我中心框架中,讓機器人能更好地理解周圍的環境。

測試的結果顯示,使用神經體積記憶(NVM)對腿部運動進行訓練後,機器人在複雜的地形上的表現要明顯優於先前的技術。

此外,消融實驗的結果顯示,神經體積記憶中儲存的內容捕捉了足夠的幾何資訊來重構3D場景。

現實世界中的實驗

為了在模擬之外的不同現實世界場景中進行驗證,團隊在室內和室外場景中都進行了實驗。

當機器狗發現有障礙物突然出現在自己面前時,直接就會選擇繞開。

在滿是石頭的地面上,走起來好像也沒什麼問題,雖然比在平地上還是要費力一些的。

相對於自身來說比較大的障礙,努努力還是可以翻過去的。

採用先前的辨識控制技術,小狗後腿對距離判斷明顯出現了誤差,一腳踩溝裡翻車了,失敗。

採用MIT提出的NVM之後,小狗過溝,穩穩的幸福,成功!

採用先前的辨識控制技術,小狗第一腳就踩空了,狗頭搶地,失敗。

採用MIT提出的NVM之後,小狗四平穩地走過了矩陣。

「腿部運動的體積記憶

# #使用以自我為中心的攝影機視角,本質上是一個處理「部分可觀測環境」的問題(Partially-Observed)。

為了使控制問題具體化,機器人需要從先前的幀中收集信息,並正確推斷被遮擋的地形。

這樣,在表徵一連串的畫面的過程中,某單一影格能夠被放到正確的位置,就變得非常重要了。

為此,團隊提出的神經體積記憶(NVM)的概念,可以將輸入的一連串視覺訊息,轉化為場景特徵進行3D描繪,進而進行輸出。

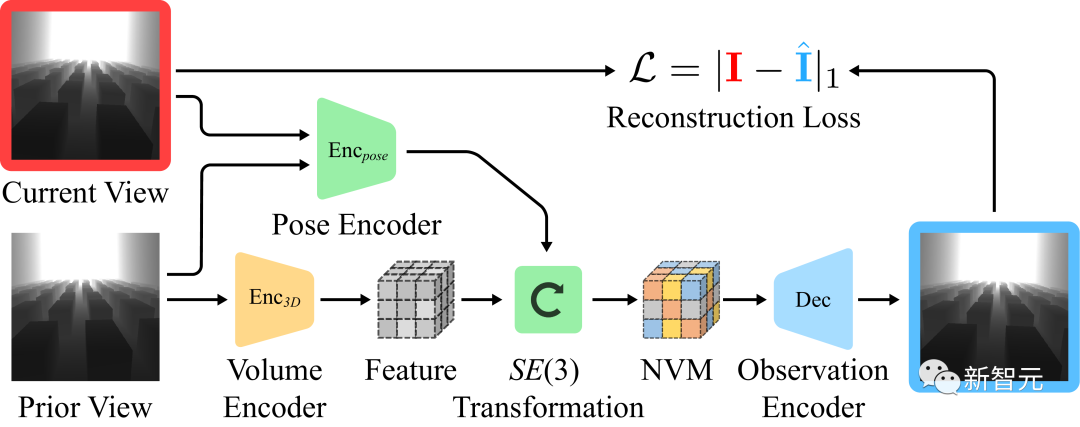

透過自監督學習NVM

雖然「行為複製目標」足以產生一個好的策略,但針對平移和旋轉的等變性,自動為神經體積記憶提供了一個獨立的、自我監督的學習目標。

########################自監督學習:研究團隊訓練了一個獨立的解碼器。讓它透過一段視覺觀察和兩個影格之間的預估轉換,來預測不同影格中的視覺觀察。 ###############如上圖所示,可以假設在影格之間周圍的3D場景保持不變。由於相機是朝前看的,我們可以將先前幀的特徵體積規範化,並用它來預測後續的影像。 ############解碼器的視覺重建############第一幅圖顯示機器人在環境中移動,第二幅圖是輸入的視覺觀察結果,第三幅圖是使用3D特徵體積和預估畫面合成的視覺觀察效果。 ############對於輸入的視覺觀察,研究團隊對影像應用了大量的資料增強來提高模型的穩健性。 ######

#作者介紹

Ruihan Yan

Ruihan Yan是加州大學聖地牙哥分校的二年級博士生。在此之前,他於2019年在南開大學獲得軟體工程學士學位

他的研究興趣是強化學習、機器學習、機器人等。具體來說,他想建立智能體,利用來自不同來源的資訊進行決策。

Ge Yang

#Ge Yang本科畢業於耶魯大學物理和數學專業,並在芝加哥大學獲得物理學博士學位。目前是美國國家科學基金會人工智慧與基礎交互作用研究所(IAIFI)的博士後研究員。

Ge Yang的研究涉及兩組相關問題。第一組是透過重新檢視我們在神經網路中表徵知識的方式,以及知識如何在分佈中轉移,來改善學習。第二組是透過理論工具的觀點來看待強化學習,如神經正切核、非歐幾里德幾何和哈密頓動力學。

Xiaolong Wang

Xiaolong Wang是加州大學聖地牙哥分校ECE系的助理教授。他是TILOS國家科學基金會人工智慧研究所的機器人團隊的成員。

他在卡內基美隆大學獲得了機器人學的博士學位,並曾在加州大學柏克萊分校做博士後研究。

以上是UCSD、MIT等華人團隊教機器狗感知3D世界!搭M1晶片,爬樓跨障無所不能的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

使用C 中的chrono庫可以讓你更加精確地控制時間和時間間隔,讓我們來探討一下這個庫的魅力所在吧。 C 的chrono庫是標準庫的一部分,它提供了一種現代化的方式來處理時間和時間間隔。對於那些曾經飽受time.h和ctime折磨的程序員來說,chrono無疑是一個福音。它不僅提高了代碼的可讀性和可維護性,還提供了更高的精度和靈活性。讓我們從基礎開始,chrono庫主要包括以下幾個關鍵組件:std::chrono::system_clock:表示系統時鐘,用於獲取當前時間。 std::chron

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

DMA在C 中是指DirectMemoryAccess,直接內存訪問技術,允許硬件設備直接與內存進行數據傳輸,不需要CPU干預。 1)DMA操作高度依賴於硬件設備和驅動程序,實現方式因係統而異。 2)直接訪問內存可能帶來安全風險,需確保代碼的正確性和安全性。 3)DMA可提高性能,但使用不當可能導致系統性能下降。通過實踐和學習,可以掌握DMA的使用技巧,在高速數據傳輸和實時信號處理等場景中發揮其最大效能。

怎樣在C 中處理高DPI顯示?

Apr 28, 2025 pm 09:57 PM

怎樣在C 中處理高DPI顯示?

Apr 28, 2025 pm 09:57 PM

在C 中處理高DPI顯示可以通過以下步驟實現:1)理解DPI和縮放,使用操作系統API獲取DPI信息並調整圖形輸出;2)處理跨平台兼容性,使用如SDL或Qt的跨平台圖形庫;3)進行性能優化,通過緩存、硬件加速和動態調整細節級別來提升性能;4)解決常見問題,如模糊文本和界面元素過小,通過正確應用DPI縮放來解決。

C 中的實時操作系統編程是什麼?

Apr 28, 2025 pm 10:15 PM

C 中的實時操作系統編程是什麼?

Apr 28, 2025 pm 10:15 PM

C 在實時操作系統(RTOS)編程中表現出色,提供了高效的執行效率和精確的時間管理。 1)C 通過直接操作硬件資源和高效的內存管理滿足RTOS的需求。 2)利用面向對象特性,C 可以設計靈活的任務調度系統。 3)C 支持高效的中斷處理,但需避免動態內存分配和異常處理以保證實時性。 4)模板編程和內聯函數有助於性能優化。 5)實際應用中,C 可用於實現高效的日誌系統。

怎樣在C 中測量線程性能?

Apr 28, 2025 pm 10:21 PM

怎樣在C 中測量線程性能?

Apr 28, 2025 pm 10:21 PM

在C 中測量線程性能可以使用標準庫中的計時工具、性能分析工具和自定義計時器。 1.使用庫測量執行時間。 2.使用gprof進行性能分析,步驟包括編譯時添加-pg選項、運行程序生成gmon.out文件、生成性能報告。 3.使用Valgrind的Callgrind模塊進行更詳細的分析,步驟包括運行程序生成callgrind.out文件、使用kcachegrind查看結果。 4.自定義計時器可靈活測量特定代碼段的執行時間。這些方法幫助全面了解線程性能,並優化代碼。

量化交易所排行榜2025 數字貨幣量化交易APP前十名推薦

Apr 30, 2025 pm 07:24 PM

量化交易所排行榜2025 數字貨幣量化交易APP前十名推薦

Apr 30, 2025 pm 07:24 PM

交易所內置量化工具包括:1. Binance(幣安):提供Binance Futures量化模塊,低手續費,支持AI輔助交易。 2. OKX(歐易):支持多賬戶管理和智能訂單路由,提供機構級風控。獨立量化策略平台有:3. 3Commas:拖拽式策略生成器,適用於多平台對沖套利。 4. Quadency:專業級算法策略庫,支持自定義風險閾值。 5. Pionex:內置16 預設策略,低交易手續費。垂直領域工具包括:6. Cryptohopper:雲端量化平台,支持150 技術指標。 7. Bitsgap:

給MySQL表添加和刪除字段的操作步驟

Apr 29, 2025 pm 04:15 PM

給MySQL表添加和刪除字段的操作步驟

Apr 29, 2025 pm 04:15 PM

在MySQL中,添加字段使用ALTERTABLEtable_nameADDCOLUMNnew_columnVARCHAR(255)AFTERexisting_column,刪除字段使用ALTERTABLEtable_nameDROPCOLUMNcolumn_to_drop。添加字段時,需指定位置以優化查詢性能和數據結構;刪除字段前需確認操作不可逆;使用在線DDL、備份數據、測試環境和低負載時間段修改表結構是性能優化和最佳實踐。

deepseek官網是如何實現鼠標滾動事件穿透效果的?

Apr 30, 2025 pm 03:21 PM

deepseek官網是如何實現鼠標滾動事件穿透效果的?

Apr 30, 2025 pm 03:21 PM

如何實現鼠標滾動事件穿透效果?在我們瀏覽網頁時,經常會遇到一些特別的交互設計。比如在deepseek官網上,�...