圖與程式碼不一致,Transformer論文被發現錯誤,網友:早該被指出1000次

2017 年,Google大腦團隊在其論文《Attention Is All You Need》中創造性的提出Transformer 這一架構,自此這一研究一路開掛,成為當今NLP 領域最受歡迎的模型之一,被廣泛應用於各種語言任務,並取得了許多SOTA 結果。

不僅如此,在NLP 領域一路領先的Transformer,迅速席捲電腦視覺(CV)、語音辨識等領域,在影像分類、目標偵測、語音辨識等任務上取得良好的效果。

#論文網址:https://arxiv.org/pdf/1706.03762 .pdf

從推出至今,Transformer 已成為眾多模型的核心模組,例如大家熟悉的BERT、T5 等都有Transformer 的身影。就連近段時間爆紅的 ChatGPT 也依賴 Transformer,而後者早已被Google申請了專利。

#圖表來源:https://patentimages.storage.googleapis.com /05/e8/f1/cd8eed389b7687/US10452978.pdf

此外OpenAI 發布的系列模型GPT(Generative Pre-trained Transformer),名字中帶有Transformer,可見Transformer是GPT 系列模型的核心。

與此同時,最近OpenAI 聯合創始人Ilya Stutskever 在談到Transformer 時表示,當Transformer 剛發布之初,實際上是論文放出來的第二天,他們就迫不及待的將先前的研究切換到Transformer ,後續有了GPT。可見 Transformer 的重要性不言而喻。

6 年時間,基於 Transformer 建構的模型不斷發展壯大。然而現在,有人發現了 Transformer 原始論文中的錯誤。

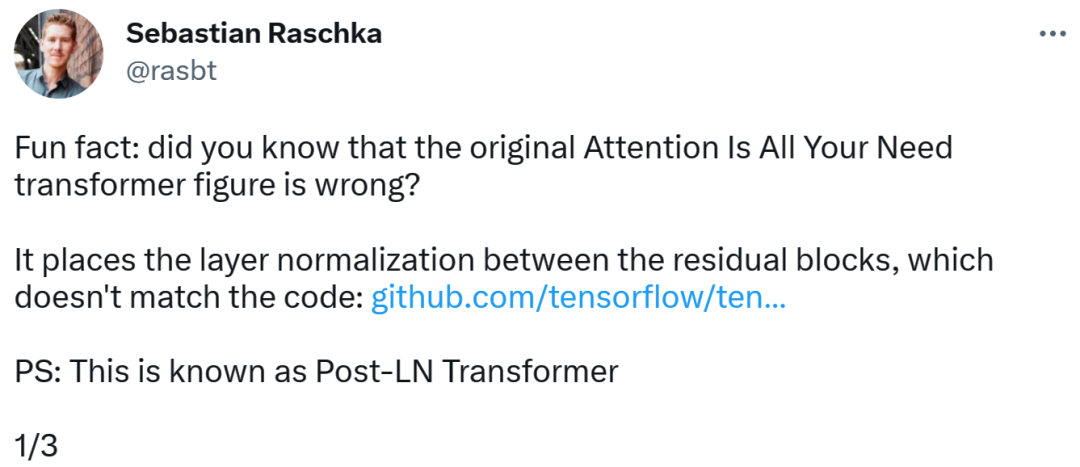

Transformer 架構圖與程式碼「不一致」

發現錯誤的是一位知名機器學習與AI 研究者、新創公司Lightning AI 的首席AI 教育家Sebastian Raschka。他指出,原始 Transformer 論文中的架構圖有誤,將層歸一化(LN)放置在了殘差塊之間,而這與程式碼不一致。

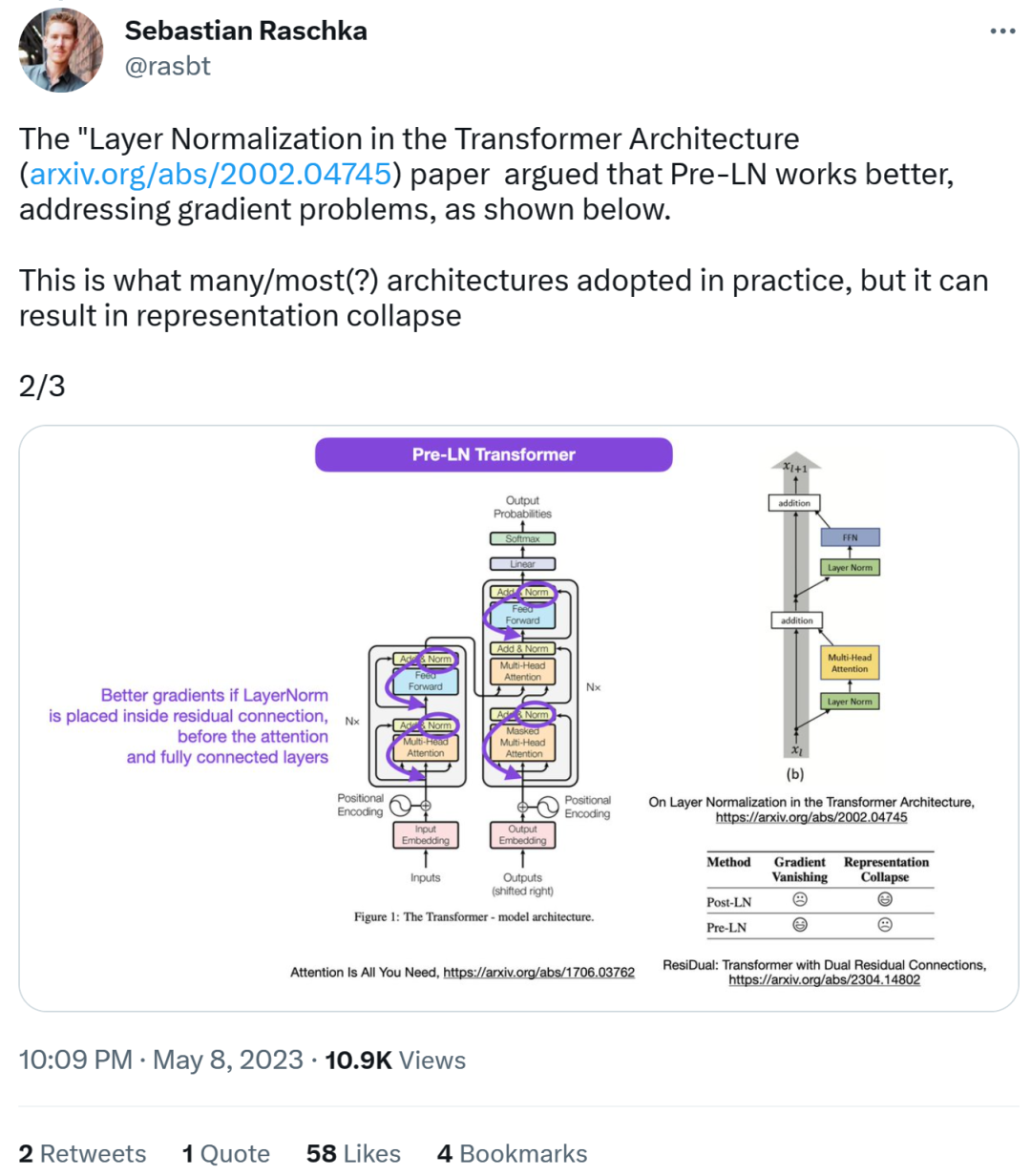

#Transformer 架構圖如下左,圖右為Post-LN Transformer 層(出自論文《On Layer Normalization in the Transformer Architecture》[1])。

不一致的程式碼部分如下,其中 82 行寫了執行順序「layer_postprocess_sequence="dan"」,表示後處理依序執行 dropout、residual_add 和 layer_norm。如果上圖左中的 add&norm 理解為:add 在 norm 上面,即先 norm 再 add,那確實代碼和圖不一致。

程式碼位址:

#https://github.com/tensorflow/tensor2tensor/commit/ f5c9b17e617ea9179b7d84d36b1e8162cb369f25#diff-76e2b94ef16871bdbf46bf04dfe7f1477bafb884748f08197c#8 ,論文《On Layer Normalization in the Transformer Architecture》認為Pre-LN 表現較好,能夠解決梯度問題。這是很多或大多數架構在實踐中所採用的,但它可能導致表示崩潰。

當層歸一化在註意力和全連接層之前被放置在殘差連接之中時,能夠實現更好的梯度。

因此,雖然關於Post-LN 或Pre-LN 的爭論仍在繼續,但另一篇論文結合了這兩點,即《ResiDual: Transformer with Dual Residual Connections》[2]。

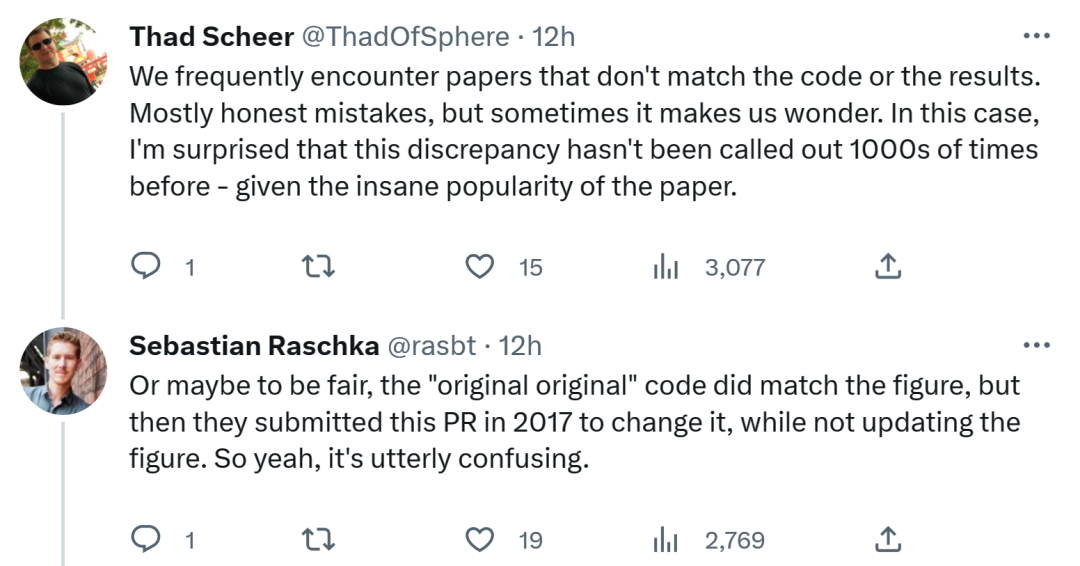

對於 Sebastian 的這項發現,有人認為,我們經常會遇到與程式碼或結果不一致的論文。大多數是無心之過,但有時令人感到奇怪。考慮到 Transformer 論文的流行程度,這個不一致問題早就該被提及 1000 次。

Sebastian 回答稱,公平地講,「最最原始」的程式碼確實與架構圖一致,但 2017 年提交的程式碼版本進行了修改,同時沒有更新架構圖。所以,這實在令人困惑。

#正如一位網友所說,「讀程式碼最糟糕的是,你會經常發現這樣的小變化,而你不知道是有意還是無意。你甚至無法測試它,因為你沒有足夠的算力來訓練模型。」

##不知谷歌之後會更新程式碼還是架構圖,我們拭目以待!

以上是圖與程式碼不一致,Transformer論文被發現錯誤,網友:早該被指出1000次的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

解密Gate.io戰略升級:MeMebox 2.0如何重新定義加密資產管理?

Apr 28, 2025 pm 03:33 PM

解密Gate.io戰略升級:MeMebox 2.0如何重新定義加密資產管理?

Apr 28, 2025 pm 03:33 PM

MeMebox 2.0通過創新架構和性能突破重新定義了加密資產管理。 1) 它解決了資產孤島、收益衰減和安全與便利悖論三大痛點。 2) 通過智能資產樞紐、動態風險管理和收益增強引擎,提升了跨鏈轉賬速度、平均收益率和安全事件響應速度。 3) 為用戶提供資產可視化、策略自動化和治理一體化,實現了用戶價值重構。 4) 通過生態協同和合規化創新,增強了平台的整體效能。 5) 未來將推出智能合約保險池、預測市場集成和AI驅動資產配置,繼續引領行業發展。

排名前十的虛擬幣交易app有哪 最新數字貨幣交易所排行榜

Apr 28, 2025 pm 08:03 PM

排名前十的虛擬幣交易app有哪 最新數字貨幣交易所排行榜

Apr 28, 2025 pm 08:03 PM

Binance、OKX、gate.io等十大數字貨幣交易所完善系統、高效多元化交易和嚴密安全措施嚴重推崇。

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台最新版

Apr 28, 2025 pm 08:09 PM

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台最新版

Apr 28, 2025 pm 08:09 PM

全球十大加密貨幣交易平台包括Binance、OKX、Gate.io、Coinbase、Kraken、Huobi Global、Bitfinex、Bittrex、KuCoin和Poloniex,均提供多種交易方式和強大的安全措施。

比特幣值多少美金

Apr 28, 2025 pm 07:42 PM

比特幣值多少美金

Apr 28, 2025 pm 07:42 PM

比特幣的價格在20,000到30,000美元之間。 1. 比特幣自2009年以來價格波動劇烈,2017年達到近20,000美元,2021年達到近60,000美元。 2. 價格受市場需求、供應量、宏觀經濟環境等因素影響。 3. 通過交易所、移動應用和網站可獲取實時價格。 4. 比特幣價格波動性大,受市場情緒和外部因素驅動。 5. 與傳統金融市場有一定關係,受全球股市、美元強弱等影響。 6. 長期趨勢看漲,但需謹慎評估風險。

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

使用C 中的chrono庫可以讓你更加精確地控制時間和時間間隔,讓我們來探討一下這個庫的魅力所在吧。 C 的chrono庫是標準庫的一部分,它提供了一種現代化的方式來處理時間和時間間隔。對於那些曾經飽受time.h和ctime折磨的程序員來說,chrono無疑是一個福音。它不僅提高了代碼的可讀性和可維護性,還提供了更高的精度和靈活性。讓我們從基礎開始,chrono庫主要包括以下幾個關鍵組件:std::chrono::system_clock:表示系統時鐘,用於獲取當前時間。 std::chron

靠譜的數字貨幣交易平台推薦 全球十大數字貨幣交易所排行榜2025

Apr 28, 2025 pm 04:30 PM

靠譜的數字貨幣交易平台推薦 全球十大數字貨幣交易所排行榜2025

Apr 28, 2025 pm 04:30 PM

靠谱的数字货币交易平台推荐:1. OKX,2. Binance,3. Coinbase,4. Kraken,5. Huobi,6. KuCoin,7. Bitfinex,8. Gemini,9. Bitstamp,10. Poloniex,这些平台均以其安全性、用户体验和多样化的功能著称,适合不同层次的用户进行数字货币交易

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台2025

Apr 28, 2025 pm 08:12 PM

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台2025

Apr 28, 2025 pm 08:12 PM

2025年全球十大加密貨幣交易所包括Binance、OKX、Gate.io、Coinbase、Kraken、Huobi、Bitfinex、KuCoin、Bittrex和Poloniex,均以高交易量和安全性著稱。