Meta自研AI晶片進展:首款AI晶片2025年推出,還有視訊AI晶片

5月19日消息,根據外媒Techcrunch報道,在今天上午的一次線上活動中,Facebook 母公司Meta首次公開了其自研AI 晶片的進展,可以支持其最近推出的廣告設計和創作工具的生成式AI技術。

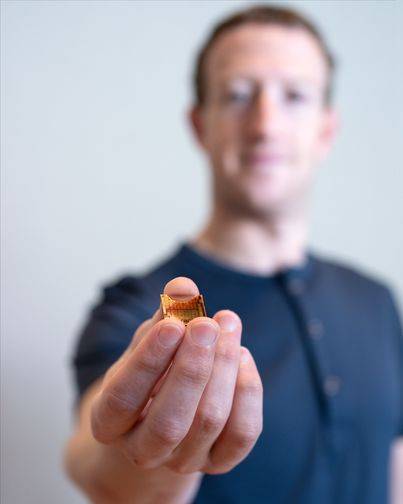

△Meta CEO祖克柏展示首款自研AI晶片MTIA

##Meta基礎設施副總裁Alexis Bjorlin表示:「

建立我們自己的[硬體] 功能使我們能夠控制堆疊的每一層,從資料中心設計到培訓框架。需要這種程度的垂直整合才能大規模突破人工智慧研究的界限。首款自研AI晶片MTIA

在過去十年左右的時間裡,Meta 花費了數十億美元來招募頂級資料科學家並建立新型人工智慧,包括現在為發現引擎、審核過濾器和遍布其應用程式和服務的廣告推薦器提供支援的人工智慧。 This company has been striving to turn its many ambitious AI research innovations into products, especially in the area of generative AI.。

自 2016 年開始,網路頭部企業一直在積極研發雲端AI晶片。 Google 一直在設計和部署稱為Tensor Processing Units(TPU)的自研AI晶片,用於訓練生成式AI 系統如PaLM-2、Imagen 等;亞馬遜則向AWS 客戶提供AWS Trainium、AWS Inferentia 兩款自研晶片進行應用。傳聞微軟也傳出正與 AMD 合作開發一款名為 Athena 的 AI晶片。

先前,Meta 主要使用第三方的 CPU 和專為加速 AI 演算法而設計的客製化晶片的組合來運行其 AI 工作負載——CPU 在處理這類任務時的效率往往低於 GPU。為了扭轉局面,Meta 在2020年開發了其第一代基於7nm製程的自研AI晶片 MTIA(MTIA v1)。

Meta 將該AI晶片稱為 Meta Training and Inference Accelerator,簡稱 MTIA,並將其描述為加速 AI 訓練和推理工作負載的AI晶片「家族」的一部分。 MTIA 是一種 ASIC,一種將不同電路組合在一塊基板上的晶片,允許對其進行編程以並行執行一項或多項任務。

「為了在我們的重要工作負載中獲得更高水準的效率和效能,我們需要一個與模型、軟體堆疊和系統硬體協同設計的客製化解決方案,以使得各種服務為我們的使用者提供更好的體驗。

根據介紹,MTIA v1採用7奈米製程製造,其內部128MB記憶體可擴充至最高128GB。 Meta表示,MTIA可以專門用於處理與 AI 推薦系統相關的工作,幫助用戶找出最佳貼文內容並更快呈現在用戶眼前,其運算效能和處理效率都勝過 CPU。另外,在 Meta 設計的基準測試中,MTIA處理「低複雜度」 」和「中等複雜度」的 AI 模型也比 GPU 更有效率。

Meta 表示,MTIA晶片的記憶體和網路領域仍有一些工作要做,隨著 AI 模型規模的成長,這會出現瓶頸,需要將工作負載分配到多個晶片上。最近,Meta已經收購了位於奧斯陸的英國晶片獨角獸Graphcore的AI網路技術團隊,以此為目的。目前,MTIA更注重Meta應用程式系列"建議工作負載"的推理能力,而非訓練能力。

Meta 強調,它將繼續改進的MTIA ,在運行推薦工作負載時「大大」提高了公司在每瓦性能方面的效率——反過來允許Meta 運行「更加增強」和「尖端」人工智慧工作負載。

根據計劃,Meta 將在 2025 年正式推出自研的MTIA晶片。

Meta的AI超級電腦RSC

報告稱,Meta原本計劃在2022 年大規模推出其自研的定制AI晶片,但最終卻推遲了,轉而為其超級電腦Research SuperCluster (RSC) 訂購了價值數十億美元的Nvidia GPU ,這需要對其多個資料中心進行重大重新設計。

據介紹,RSC 於 2022 年 1 月首次亮相,與 Penguin Computing、Nvidia 和 Pure Storage 合作組裝而成,已經完成了第二階段的擴建。 Meta 表示,它現在包含總共 2,000 個 Nvidia DGX A100 系統,配備 16,000 個 Nvidia A100 GPU。

雖然,目前RSC的算力已經落後於微軟和Google的AI超級電腦。谷歌聲稱其專注於人工智慧的超級電腦搭載了 26,000 個 Nvidia H100 GPU。 Meta指出,RSC的優勢在於其允許研究人員使用Meta生產系統中的實際範例來訓練模型。該公司先前的AI基礎設施利用的是開源和公開可用的資料集,與此不同的是現在的基礎設施。

RSC AI 超級電腦正在推進多個領域的 AI 研究,包括生成式 AI,突破研究邊界。 」Meta 發言人表示:「這真的關係到人工智慧研究的生產力。我們希望為 AI 研究人員提供最先進的基礎設施,使他們能夠開發模型並為他們提供培訓平台以推動 AI 發展。 ”

Meta稱,在其巔峰時期,RSC 可以達到近 5 exaflops 的運算能力,這使其成為世界上最快的運算能力之一。

Meta利用RSC進行LLaMA的訓練,其中RSC是指「大型語言模型Meta人工智慧」的縮寫。 Meta 表示,最大的 LLaMA 模型在 2,048 個 A100 GPU 上進行了訓練,耗時 21 天。

「建立我們自己的超級運算能力使我們能夠控制堆疊的每一層;從資料中心設計到培訓框架,」Meta發言人補充道:「RSC 將幫助Meta 的AI 研究人員建立新的更好的AI 模型,這些模型可以從數萬億個示例中學習;跨數百種不同的語言工作;一起無縫分析文本、圖像和視頻;開發新的增強現實工具;以及更多。

未來,Meta或將自研的AI晶片MTIA導入RSC當中,以進一步提升其AI性能。

面向視訊處理的AI晶片MSVP

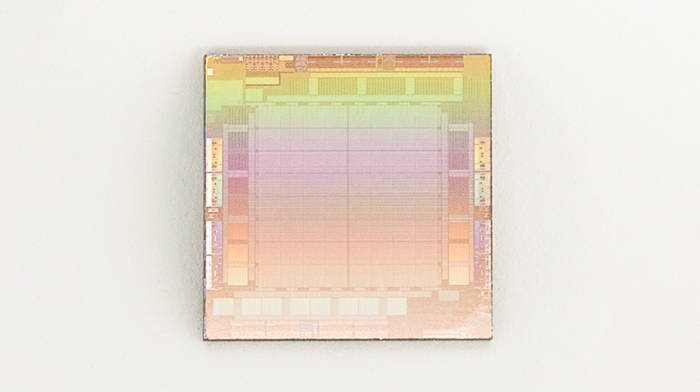

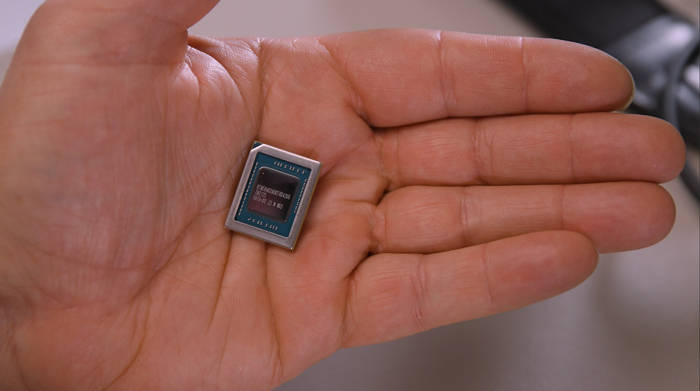

除了MTIA之外,Meta還在自研另一款被稱為Meta Scalable Video Processor(MSVP)的AI晶片,主要面向持續成長的滿足視訊點播和直播串流媒體的數據處理需求,Meta最終希望將大部分成熟且穩定的影音內容處理工作交由MSVP 執行。其實,Meta 多年前就開始構思客製化伺服器端視訊處理晶片,並宣佈在 2019 年推出用於視訊轉碼和推理工作的 ASIC。這是其中一些努力的成果,也是競爭優勢的新推動。特別是視訊直播領域。

「光是在Facebook 上,人們就將50% 的時間花在觀看影片上,」Meta 技術主管Harikrishna Reddy 和Yunqing Chen 在19日上午發表的一篇部落格文章中寫道:「為了服務世界各地的各種設備(行動裝置、筆記型電腦、電視等),上傳到Facebook 或Instagram 的影片被轉碼為多個位元流,具有不同的編碼格式、解析度和品質…MSVP是可編程和可擴展的,並且可以配置為有效地支援VOD 所需的高品質轉碼以及即時串流媒體所需的低延遲和更快的處理時間。

△MSVP

△MSVP

#Meta 表示,它的計劃是最終將大部分「穩定和成熟」的視訊處理工作負載卸載到 MSVP,並僅對需要特定自訂和「顯著」更高品質的工作負載使用軟體視訊編碼。 Meta 說,使用智慧降噪和影像增強等預處理方法以及偽影去除和超解析度等後處理方法,我們將繼續使用 MSVP 來提高視訊品質。

「在未來,MSVP 將使我們能夠支援更多Meta 最重要的用例和需求,包括短視訊——實現生成式AI、AR/VR 和其他元宇宙內容的高效交付,」Reddy 和Chen 說。

編輯:芯智訊-浪客劍

以上是Meta自研AI晶片進展:首款AI晶片2025年推出,還有視訊AI晶片的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

新標題:英偉達H200發表:HBM容量提升76%,大幅提升大模型效能90%的最強AI晶片

Nov 14, 2023 pm 03:21 PM

新標題:英偉達H200發表:HBM容量提升76%,大幅提升大模型效能90%的最強AI晶片

Nov 14, 2023 pm 03:21 PM

11月14日消息,英偉達(Nvidia)在當地時間13日上午的「Supercomputing23」會議上正式發布了全新的H200GPU,並更新了GH200產品線其中,H200依然是建立在現有的HopperH100架構之上,但增加了更多高頻寬記憶體(HBM3e),從而更好地處理開發和實施人工智慧所需的大型資料集,使得運行大模型的綜合性能相比前代H100提升了60%到90%。而更新後的GH200,也將為下一代AI超級電腦提供動力。 2024年將會有超過200exaflops的AI運算能力上線。 H200

傳聯發科拿下Google伺服器AI晶片大單,將供應高速Serdes晶片

Jun 19, 2023 pm 08:23 PM

傳聯發科拿下Google伺服器AI晶片大單,將供應高速Serdes晶片

Jun 19, 2023 pm 08:23 PM

6月19日消息,根據中國台灣媒體報道,Google(Google)為了研發最新的面向伺服器的AI晶片,已經找來聯發科合合作,併計劃交由台積電5nm製程代工,計劃明年初量產。報導稱,消息人士透露,這次谷歌與聯發科的合作,將由聯發科提供串行器及解串器(SerDes)方案,並協助整合谷歌自研的張量處理器(TPU),助力谷歌打造最新的伺服器AI晶片,效能將比CPU或GPU架構更強大。業界指出,Google目前的多項服務都與AI有關,早在多年前就投入到了深度學習技術當中,發現運用GPU來進行AI運算成本十分昂貴,因此谷歌決

AI的下一個熱門:英偉達B100晶片和OpenAI GPT-5模型的巔峰表現

Nov 18, 2023 pm 03:39 PM

AI的下一個熱門:英偉達B100晶片和OpenAI GPT-5模型的巔峰表現

Nov 18, 2023 pm 03:39 PM

在號稱世界最強AI晶片英偉達H200亮相後,業界開始期待英偉達更強大的B100晶片,與此同時,今年以來最紅的新創AI公司OpenAI已經開始研發更強大、更複雜的GPT-5模型。國泰君安在最新的研究中指出,性能無邊的B100與GPT5預計在2024年發布,重磅升級或釋放前所未有的生產力。該機構表示,看好AI進入快速發展的成長期,能見度持續至2024年。相較於前幾代產品,B100和GPT-5究竟有多強大?英偉達和OpenAI已經給出了預告:B100速度可能是H100的4倍以上,而GPT-5可能會實現超

網傳vivo將推出自研AI大模型:類似微軟Copilot

Oct 17, 2023 pm 05:57 PM

網傳vivo將推出自研AI大模型:類似微軟Copilot

Oct 17, 2023 pm 05:57 PM

vivo已官宣,將於2023年11月1日在深圳國際會展中心舉行主題為「同心・同行」2023年開發者大會,屆時將發布自研AI大模型、自研操作系統,還有OriginOS4系統。近日,知名數位部落客「數位閒聊站」爆料稱,vivo自研AI大模型將落地OriginOS4,類似微軟Copilot的形式單獨做了個從側邊欄呼出的浮窗,跟集成在語音助手上的模式不太一樣,AI資料量和系統融合做得不錯,全員智慧化系統。從圖片來看,vivo自研AI大模型將命名為「JoviCopilot」。據悉,JoviCopilot可

深度揭密:蘋果自家研發相機ISP的奧秘!

Nov 11, 2023 pm 02:45 PM

深度揭密:蘋果自家研發相機ISP的奧秘!

Nov 11, 2023 pm 02:45 PM

11月11日消息,近日,手機芯片領域的權威@手機芯片達人在其最新微博中透露,蘋果公司即將推出兩款全新的M3系列晶片,進一步鞏固其在行動裝置晶片領域的技術實力。這兩款晶片將採用先進的3奈米工藝,為用戶帶來更卓越的性能和能源效率。有關這兩款晶片的詳細信息,目前仍處於神秘之中。不過,根據手機晶片達人的爆料,M3系列的第四款晶片被命名為M3Ultra,並將採用先進的「UltraFusion」技術。這項技術的特點是將兩塊M3Max晶片巧妙拼接在一起,為設備提供更強大的運算能力和處理速度。至於第五款M3系列芯

耐能推出最新AI晶片KL730,驅動輕量級GPT解決方案的大規模應用

Aug 17, 2023 pm 01:37 PM

耐能推出最新AI晶片KL730,驅動輕量級GPT解決方案的大規模應用

Aug 17, 2023 pm 01:37 PM

KL730在能源效率方面的進步使得解決了人工智慧模型落地方面最大的瓶頸——能源成本,相較於行業及以往耐能的晶片,提高了3到4倍KL730晶片支援最先進的輕量級GPT大語言模型,如nanoGPT,並提供每秒0.35-4tera的有效運算能力AI公司耐能今日宣布發表KL730晶片,該晶片整合了車規級NPU和影像訊號處理(ISP),將安全且低能耗的AI能力賦能到邊緣伺服器、智慧家庭及汽車輔助駕駛系統等各類應用場景。總部位於聖迭戈的耐能以其開創性的神經處理單元(NPU)而聞名耐能最新晶片KL730旨在實

PHP密碼學的最新進展與應用實踐

Aug 17, 2023 pm 12:16 PM

PHP密碼學的最新進展與應用實踐

Aug 17, 2023 pm 12:16 PM

PHP密碼學的最新進展與應用實踐引言:隨著互聯網的迅速發展和資料安全性的重要性日益凸顯,密碼學作為一門研究保護資訊安全的學科得到了廣泛關注和研究。在這方面,PHP密碼學的最新進展使得開發者們能夠更好地保護使用者的敏感訊息,並提供更安全的應用程式。本文將介紹PHP密碼學的最新進展,以及實際應用場景中的程式碼範例。一、最新進展哈希演算法雜湊演算法是密碼學中常用的技術

AI晶片,全球缺貨!

May 30, 2023 pm 09:53 PM

AI晶片,全球缺貨!

May 30, 2023 pm 09:53 PM

谷歌CEO將AI革命比作人類對火的使用,但現在為該行業提供燃料的數位火種——AI晶片,很難獲得。驅動AI運作的新一代先進晶片幾乎都是由英偉達製造的,隨著ChatGPT爆火出圈,市場對英偉達圖形處理晶片(GPU)的需求遠遠超過了供應。幫助企業建立聊天機器人等AI模型的新創公司Lamini的聯合創始人兼首席執行官SharonZhou表示:「因為存在短缺,所以關鍵在於你的朋友圈。」「就像疫情期間的衛生紙一樣。」這種情況限制了亞馬遜和微軟等雲端服務供應商向ChatGPT的創建者OpenAI等客戶提供的運算能