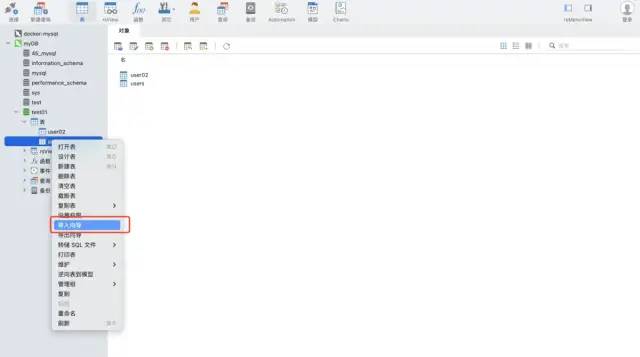

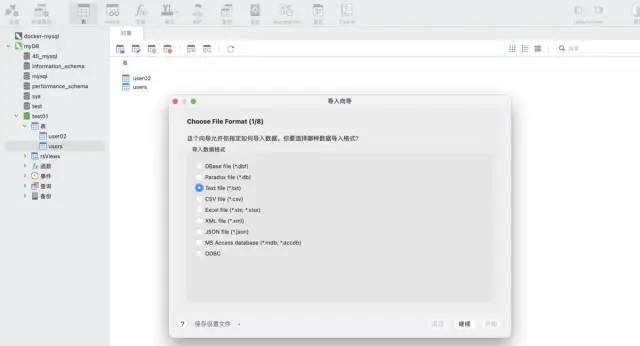

使用 navicat 工具的匯入精靈功能。這個軟體可以支援多種文件格式,並且可以根據文件的欄位自動建立表格或將資料插入到已有的表格中,非常快速且方便。

測試資料:csv 格式,約1200萬行

import pandas as pd data = pd.read_csv('./tianchi_mobile_recommend_train_user.csv') data.shape

列印結果:

##方式一:python ➕ pymysql 函式庫

安裝pymysql 指令:

pip install pymysql

程式碼實作:##import pymysql

# 数据库连接信息

conn = pymysql.connect(

host='127.0.0.1',

user='root',

passwd='wangyuqing',

db='test01',

port = 3306,

charset="utf8")

# 分块处理

big_size = 100000

# 分块遍历写入到 mysql

with pd.read_csv('./tianchi_mobile_recommend_train_user.csv',chunksize=big_size) as reader:

for df in reader:

datas = []

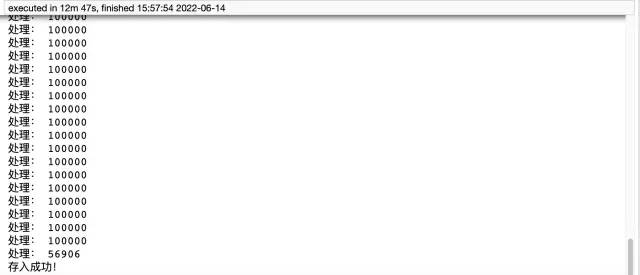

print('处理:',len(df))

# print(df)

for i ,j in df.iterrows():

data = (j['user_id'],j['item_id'],j['behavior_type'],

j['item_category'],j['time'])

datas.append(data)

_values = ",".join(['%s', ] * 5)

sql = """insert into users(user_id,item_id,behavior_type

,item_category,time) values(%s)""" % _values

cursor = conn.cursor()

cursor.executemany(sql,datas)

conn.commit()

# 关闭服务

conn.close()

cursor.close()

print('存入成功!')

pandas ➕ sqlalchemy:pandas需要引入sqlalchemy來支援sql,在sqlalchemy的支援下,它可以實作所有常見資料庫類型的查詢、更新等操作。

#程式碼實作:

以上是怎麼用Python讀取千萬資料自動寫入MySQL資料庫的詳細內容。更多資訊請關注PHP中文網其他相關文章!from sqlalchemy import create_engine

engine = create_engine('mysql+pymysql://root:wangyuqing@localhost:3306/test01')

data = pd.read_csv('./tianchi_mobile_recommend_train_user.csv')

data.to_sql('user02',engine,chunksize=100000,index=None)

print('存入成功!')

pymysql 方法用時12分47秒,耗時還是比較長的,程式碼量大,而pandas只要五行程式碼就實現了這個需求,只花了4分鐘左右。最後補充下,方式一需要提前建表,方式二則不需要。所以推薦大家使用第二種方式,方便又有效率。如果還覺得速度慢的小夥伴,可以考慮加入多進程、多執行緒。

最完整的三種將資料存入MySQL 資料庫方法:直接儲存,利用navicat 的導入精靈功能