國產ChatGPT「套殼」的秘密,現在被找到了

「科大訊飛套殼ChatGPT!」「百度文心一言套皮Stable Diffusion!」「商湯大模型實則抄襲!」…

#外界對國產大模型產生質疑已經不是一次兩次了。

業內人士對這個現象的解釋是,高品質的中文資料集實在緊缺,訓模型時只能讓採買的外文標註資料集「當外援」。訓練所用的資料集撞車,就會產生相似結果,進而引發烏龍事件。

其餘辦法中,用現有大模型輔助生成訓練資料容易資料清洗不到位,重複利用token會導致過擬合,僅訓練稀疏大模型也不是長久之計。

業界漸漸形成共識:

通往AGI的道路,對資料數量和資料品質都將持續提出極高的要求。

時勢所需,近2個月來,國內不少團隊先後開源了中文資料集,除通用資料集外,針對程式設計、醫療等垂域也有專門的開源中文資料集發布。

高品質資料集雖有但少

大模型的新突破十分依賴高品質、豐富的資料集。

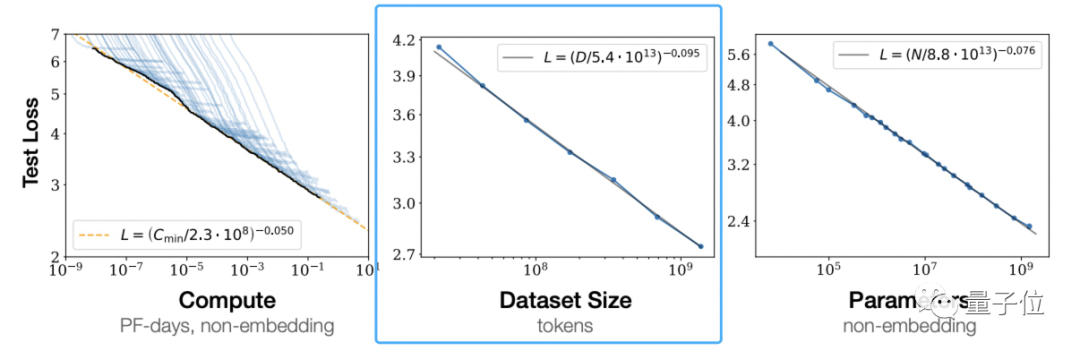

根據OpenAI 《Scaling Laws for Neural Language Models》提出大模型所遵循的伸縮法則(scaling law)可以看到,獨立增加訓練資料量,是可以讓預訓練模型效果變更好的。

這不是OpenAI的一家之言。

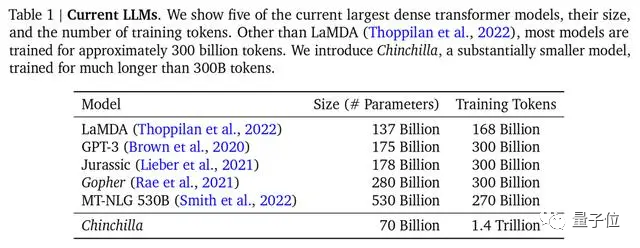

DeepMind也在Chinchilla模型論文中指出,先前的大模型多是訓練不足的,還提出最優訓練公式,已成為業界公認的標準。

#△主流大模型,Chinchilla參數最少,但訓練最充分

不過,用來訓練的主流資料集以英文為主,如Common Crawl、BooksCorpus、WiKipedia、ROOT等,最受歡迎的Common Crawl中文資料只佔4.8%。

中文資料集是什麼情況?

公開資料集不是沒有-這一點量子位元從瀾舟科技創辦人兼CEO、當今NLP領域成就最高華人之一周明口中得到證實-如命名實體資料集MSRA-NER、Weibo -NER等,以及GitHub上可找到的CMRC2018、CMRC2019、ExpMRC2022等存在,但整體數量和英文資料集相比可謂九牛一毛。

並且,其中部分已經老舊,可能都不知道最新的NLP研究概念(新概念相關研究只以英文形式出現在arXiv上)。

雖然中文高品質資料集存在,但數量較少且使用起來較為繁瑣,這是所有開展大型模型研究的團隊不得不面對的嚴峻形勢。先前的清華大學電子系系友論壇上,清華計算機系教授唐傑分享過,千億模型ChatGLM-130B訓練前資料準備時,就曾面臨過清洗中文資料後,可用量不到2TB的情況。

解決中文世界缺乏高品質資料集迫在眉睫。

行之有效的解決方法之一,是直接用英文資料集訓大模型。

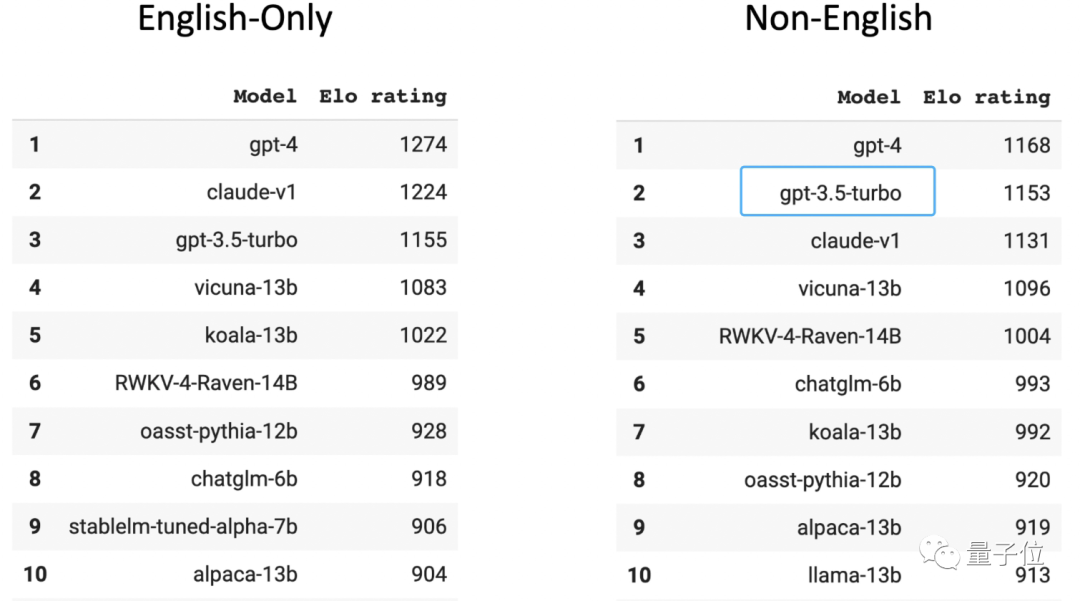

在人類玩家評分的大模型匿名競技場Chatbot Arena榜單中,GPT-3.5在非英文排行榜位居第二(第一名是GPT-4)。要知道,96%的GPT-3.5訓練資料都是英文,再刨去其他語種,用來訓練的中文資料量少到可以用「千分之n」來計算。

國內top3高校某大模型相關團隊在讀博士透露,如果採用這種方法,不嫌麻煩的話,甚至可以給模型接一個翻譯軟體,把所有語言都轉換成英語,然後把模型的輸出轉換為中文,再回傳給使用者。

然而這樣餵養的大模型始終是英文思維,當遇到成語改寫、俗語理解、文章改寫這類含有中文語言特色的內容,往往處理不佳,出現翻譯錯誤或潛在文化的偏差。

還有個解決方法就是採集、清洗和標註中文語料,做新的中文高品質資料集,供給大模型們。

開源資料集眾人拾柴

察覺現況後,國內不少大模型團隊決定走第二條路,著手利用私人資料庫做資料集。

百度有內容生態數據,騰訊有公眾號數據,知乎有問答數據,阿里有電商和物流數據。

累積的私有資料不一,就可能在特定場景和領域建立核心優勢壁壘,將這些資料嚴格蒐集、整理、篩選、清洗和標註,能確保訓出模型的有效性和準確性。

而那些私有資料優勢不那麼明顯大模型團隊,開始全網爬資料(可以預見,爬蟲資料量會非常大)。

華為為了打造盤古大模型,從互聯網爬取了80TB文本,最後清洗為1TB的中文數據集;浪潮源1.0訓練採用的中文數據集達5000GB(相比GPT3模型訓練數據集為570GB);最近發布的天河天元大模型,也是天津超算中心蒐集整理全局網頁數據,同時納入各種開源訓練數據和專業領域數據集等的成果。

同時,近2個月來,中文資料集出現眾人拾柴火焰高的現象-

許多團隊陸續發布開源中文資料集,彌補目前中文開源資料集的不足或失衡。

其中部分整理如下:

- CodeGPT:GPT和GPT產生的與程式碼相關的對話資料集;背後機構為複旦大學。

- CBook-150k:中文語料圖書集合,包含15萬本中文圖書的下載和抽取方法,涵蓋人文、教育、科技、軍事、政治等眾多領域;背後機構為復旦大學。

- RefGPT:為了避免手動標註的昂貴成本,提出一種自動產生事實型對話的方法,並公開我們的部分數據,包含5萬條中文多輪對話;背後是來自上海交大、香港理工大學等機構的NLP從業人員。

- COIG:全名為“中國通用開放指令資料集”,是更大、更多樣化的指令調優語料庫,並由人工驗證確保了它的品質;背後的聯合機構包括北京人工智慧研究院、謝菲爾德大學、密西根大學、達特茅斯學院、浙江大學、北京航空航天大學、卡內基美隆大學。

- Awesome Chinese Legal Resources:中國法律資料資源,由上海交大收集和整理。

- Huatuo:透過醫學知識圖譜和GPT3.5 API建構的中文醫學指令資料集,在此基礎上對LLaMA進行了指令微調,提高了LLaMA在醫療領域的問答效果;專案開源方是哈工大。

- Baize:使用少量“種子問題”,讓ChatGPT 自己跟自己聊天,並自動收集成高品質多輪對話資料集;加州大學聖迭戈分校(UCSD)與中山大學、MSRA合作團隊把使用此法收集的資料集開源。

當更多的中文資料集被開源到聚光燈下,行業的態度是歡迎與欣喜。如智譜AI創始人兼CEO張鵬所表達的態度:

中文高品質數據只是藏在深閨而已,現在大家都意識到這個問題了,自然也會有相應的解決方案,例如資料開源。

總之是朝著好的方向發展,不是嗎?

值得注意的是,除了預訓練數據,目前階段人類回饋數據同樣不可或缺。

現成的例子擺在眼前:

與GPT-3相比,ChatGPT疊加的重要buff就是利用RLHF(人類回饋強化學習),生成用於fine-tuing的高品質標記數據,使得大模型朝向與人類意圖對齊的方向發展。

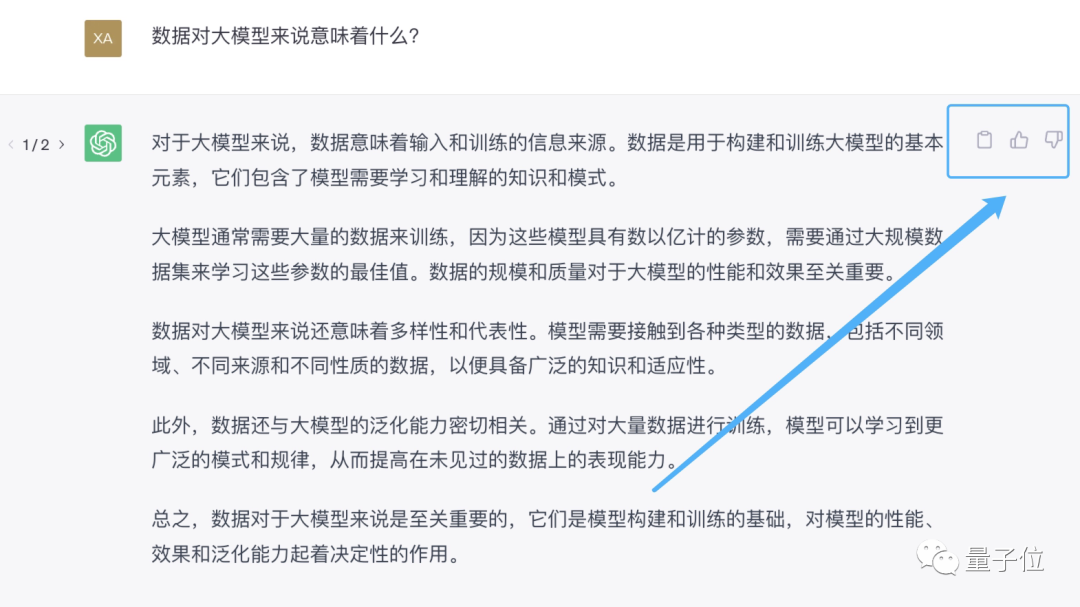

提供人類回饋最直接的辦法,就是告訴AI助理“你的回答不對”,或直接在AI助理產生的回覆旁邊點讚或踩一踩。

先用起來就能先收集一波用戶回饋,讓雪球滾起來,這就是為什麼大家都搶著發布大模型的原因之一。

現在,國內的類ChatGPT產品,從百度文心一言、復旦MOSS到智譜ChatGLM,都提供了回饋的選項。

但由於在大部分體驗使用者眼中,這些大模型產品最主要的還是「玩具」屬性。

當遇到錯誤或不滿意的回答,會選擇直接關掉對話介面,並不利於背後大模型對人類回饋的蒐集。

以上是國產ChatGPT「套殼」的秘密,現在被找到了的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

我嘗試了使用光標AI編碼的Vibe編碼,這太神奇了!

Mar 20, 2025 pm 03:34 PM

我嘗試了使用光標AI編碼的Vibe編碼,這太神奇了!

Mar 20, 2025 pm 03:34 PM

Vibe編碼通過讓我們使用自然語言而不是無盡的代碼行創建應用程序來重塑軟件開發的世界。受Andrej Karpathy等有遠見的人的啟發,這種創新的方法使Dev

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!

Mar 22, 2025 am 10:58 AM

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!

Mar 22, 2025 am 10:58 AM

2025年2月,Generative AI又是一個改變遊戲規則的月份,為我們帶來了一些最令人期待的模型升級和開創性的新功能。從Xai的Grok 3和Anthropic的Claude 3.7十四行詩到Openai的G

如何使用Yolo V12進行對象檢測?

Mar 22, 2025 am 11:07 AM

如何使用Yolo V12進行對象檢測?

Mar 22, 2025 am 11:07 AM

Yolo(您只看一次)一直是領先的實時對象檢測框架,每次迭代都在以前的版本上改善。最新版本Yolo V12引入了進步,可顯著提高準確性

Chatgpt 4 o可用嗎?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o可用嗎?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4當前可用並廣泛使用,與諸如ChatGpt 3.5(例如ChatGpt 3.5)相比,在理解上下文和產生連貫的響應方面取得了重大改進。未來的發展可能包括更多個性化的間

最佳AI藝術生成器(免費付款)創意項目

Apr 02, 2025 pm 06:10 PM

最佳AI藝術生成器(免費付款)創意項目

Apr 02, 2025 pm 06:10 PM

本文回顧了AI最高的藝術生成器,討論了他們的功能,對創意項目的適用性和價值。它重點介紹了Midjourney是專業人士的最佳價值,並建議使用Dall-E 2進行高質量的可定製藝術。

O1 vs GPT-4O:OpenAI的新型號比GPT-4O好嗎?

Mar 16, 2025 am 11:47 AM

O1 vs GPT-4O:OpenAI的新型號比GPT-4O好嗎?

Mar 16, 2025 am 11:47 AM

Openai的O1:為期12天的禮物狂歡始於他們迄今為止最強大的模型 12月的到來帶來了全球放緩,世界某些地區的雪花放緩,但Openai才剛剛開始。 山姆·奧特曼(Sam Altman)和他的團隊正在推出12天的禮物前

Google的Gencast:Gencast Mini Demo的天氣預報

Mar 16, 2025 pm 01:46 PM

Google的Gencast:Gencast Mini Demo的天氣預報

Mar 16, 2025 pm 01:46 PM

Google DeepMind的Gencast:天氣預報的革命性AI 天氣預報經歷了巨大的轉變,從基本觀察到復雜的AI驅動預測。 Google DeepMind的Gencast,開創性

哪個AI比Chatgpt更好?

Mar 18, 2025 pm 06:05 PM

哪個AI比Chatgpt更好?

Mar 18, 2025 pm 06:05 PM

本文討論了AI模型超過Chatgpt,例如Lamda,Llama和Grok,突出了它們在準確性,理解和行業影響方面的優勢。(159個字符)