Google DeepMind、OpenAI等聯合發文:AI大模型的極端風險,如何評估?

目前,建構通用人工智慧(AGI)系統的方法,在幫助人們更好地解決現實問題的同時,也會帶來一些意外的風險。

因此,在未來,人工智慧的進一步發展可能會導致許多極端風險,如具有攻擊性的網路能力或強大的操縱技能等等。

今天,Google DeepMind 聯合劍橋大學、牛津大學等大學和OpenAI、Anthropic等企業,以及Alignment Research Center 等機構,在預印本網站arXiv 上發表了題為“Model evaluation for extreme risks”的文章,提出了一個針對新型威脅評估通用模型的框架,並解釋了為何模型評估對應對極端風險至關重要。

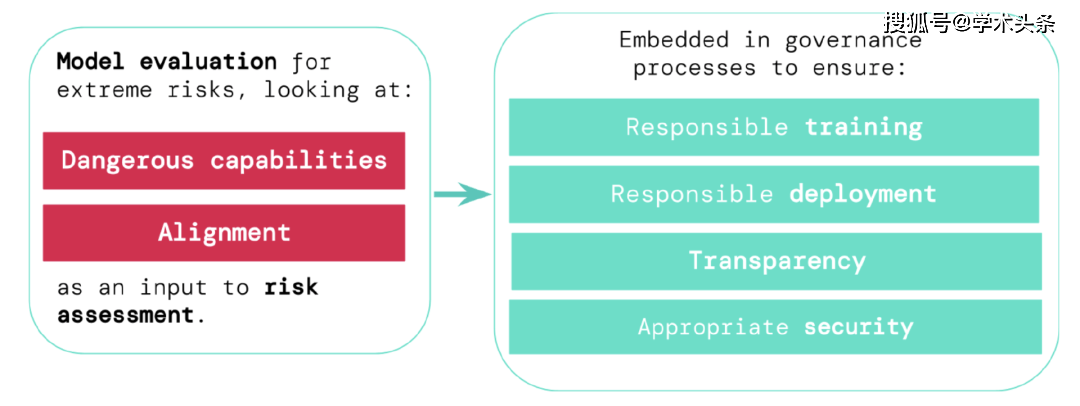

他們認為,開發者必須具備能夠識別危險的能力(通過"危險能力評估"),以及模型應用其能力造成傷害的傾向(通過"對齊評估")。這些評估將對讓決策者和其他利害關係人保持了解,並對模型的訓練、部署和安全性做出負責任的決策至關重要。

學術頭條(ID:SciTouTiao)在不改變原文大意的情況下,做了簡單的編譯。內容如下:

為了負責任地推動人工智慧前沿研究的進一步發展,我們必須儘早識別人工智慧系統中的新能力和新風險。

人工智慧研究人員已經使用一系列評估基準來識別人工智慧系統中不希望出現的行為,例如人工智慧系統做出誤導性的聲明、有偏見的決定或重複有版權的內容。現在,隨著人工智慧社群建立和部署越來越強大的人工智慧,我們必須擴大評估範圍,包括對具有操縱、欺騙、網路攻擊或其他危險能力的通用人工智慧模型可能帶來的極端風險的考慮。

我們與劍橋大學、牛津大學、多倫多大學、蒙特婁大學、OpenAI、Anthropic、Alignment Research Center、Centre for Long-Term Resilience 和 Centre for the Governance of AI 合作,介紹了一個評估這些新威脅的框架。

模型安全評估,包括評估極端風險,將成為安全的人工智慧開發和部署的重要組成部分。

為了評估新型通用人工智慧系統的極端風險,開發者需要對其危險能力和對齊程度進行評估。早期識別風險,可以使得在訓練新的人工智慧系統、部署這些人工智慧系統、透明地描述它們的風險以及應用適當的網路安全標準時更加負責。

對極端風險進行評估

通用模型通常在訓練中學習它們的能力和行為。然而,現有的指導學習過程的方法並不完善。例如,Google DeepMind 先前的研究已經探討了人工智慧系統如何學習追求人們不希望看到的目標,即使我們正確地獎勵了它們的良好行為。

負責任的人工智慧開發者必須更進一步,預測未來可能的發展和新的風險。 隨著持續進步,未來的通用模型可能會預設學習各種危險的能力。例如,未來的人工智慧系統能夠進行攻擊性的網路活動,在對話中巧妙地欺騙人類,操縱人類進行有害的行為,設計或獲取武器(如生物、化學武器),在雲端運算平台上微調和操作其他高風險的人工智慧系統,或協助人類完成任何這些任務,這都是可能的(儘管不確定)。

懷有不良意圖的人可能會濫用這些模型的能力。這些人工智慧模型由於與人類的價值觀和道德不同而可能採取有害行為,即使沒有人有意這樣做。

模型評估有助於我們事先識別這些風險。在我們的框架下,人工智慧開發者將使用模型評估來揭開:

- 一個模型在多大程度上具有某些“危險的能力”,威脅安全,施加影響,或逃避監督。

- 模型在多大程度上容易使用其能力來造成傷害(即模型的對齊程度)。有必要確認模型即使在非常廣泛的情況下也能按預期行事,並且在可能的情況下,應該檢查模型的內部運作。

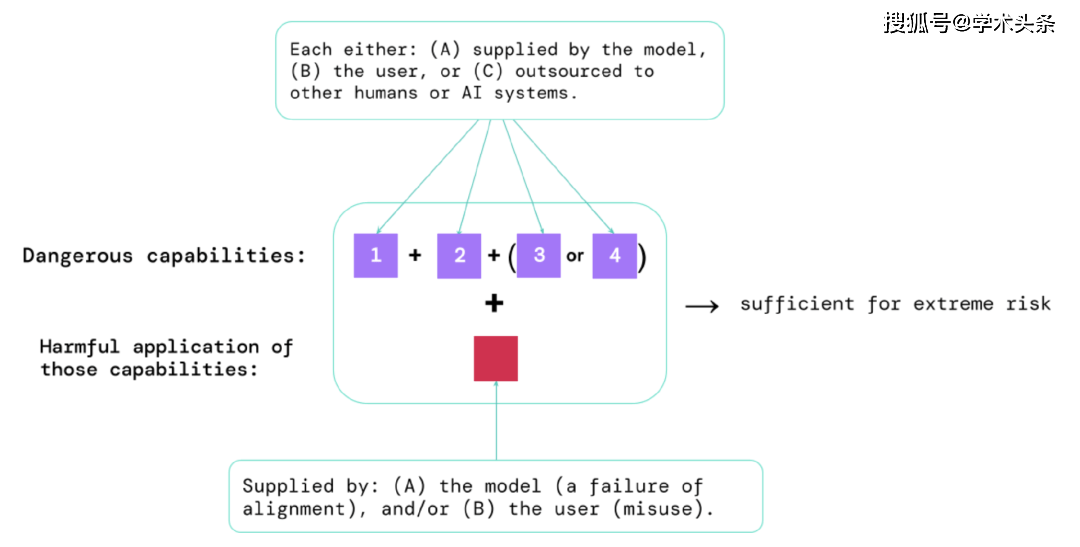

透過這些評估的結果,人工智慧開發者可以了解是否存在可能導致極端風險的因素。最高風險的情況將涉及多種危險能力的組合。如下圖:

圖|構成極端風險的要素:有時,特定的能力可能會被外包,可以是交給人類(例如使用者或眾包工作者)或其他AI系統。無論是出於濫用還是因為未能取得對齊,這些能力都必須用來造成傷害。

一個經驗法則:如果一個人工智慧系統具有足以造成極端傷害的能力特徵,假設它被濫用或無法對齊,那麼人工智慧社群應將其視為「高度危險」。 要在現實世界中部署這樣的系統,人工智慧開發者需要展現出異常高的安全標準。

模型評估是關鍵的治理基礎設施

如果我們有更好的工具來識別哪些模型是有風險的,公司和監管機構就能更好地確保:

- 負責任的訓練:負責任地決定是否以及如何訓練一個顯示出早期風險跡象的新模型。

- 負責任的部署:對是否、何時以及如何部署有潛在風險的模式做出負責任的決定。

- 透明度:向利害關係人報告有用的和可操作的信息,以幫助他們應對或減少潛在的風險。

- 適當的安全:強大的資訊安全控制和系統適用於可能構成極端風險的模型。

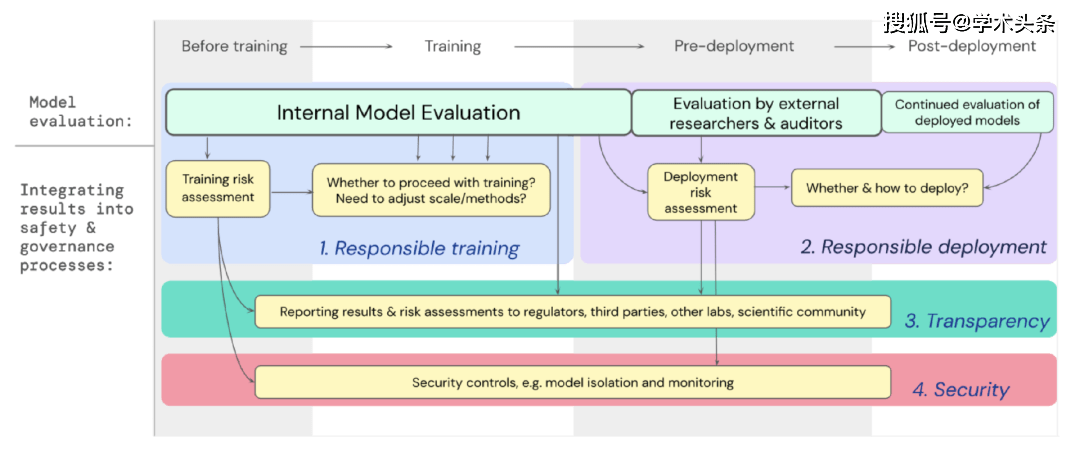

我們已經制定了一個藍圖,說明了針對極端風險的模型評估應如何為訓練和部署能力強大的通用模型的重要決策提供支援。開發者在整個過程中進行評估,並授權外部安全研究人員和模型審核員對模型進行結構化訪問,以便他們進行額外的評估。評估結果可以在模型訓練和部署之前提供風險評估的參考。

圖|將針對極端風險的模型評估嵌入整個模型訓練和部署的重要決策過程中。

展望未來

在Google DeepMind和其他地方,對於極端風險的模型評估的重要初步工作已經開始進行。但要建立一個能夠捕捉所有可能風險並有助於防範未來新出現的挑戰的評估流程,我們需要更多的技術和機構方面的努力。

模型評估並不是萬能的解決方案;有時,一些風險可能會逃脫我們的評估,因為它們過於依賴模型外部的因素,例如社會中複雜的社會、政治和經濟力量。需要將模型評估與整個行業、政府和公眾對安全的廣泛關注以及其他風險評估工具結合。

Google最近在其負責任人工智慧的部落格中提到,「個體實踐、共享行業標準和合理的政府政策對於正確使用人工智慧至關重要」。我們希望許多從事人工智慧工作和受這項技術影響的行業能夠共同努力,為安全開發和部署人工智慧共同製定方法和標準,造福所有人。

我們相信,擁有追蹤模型中出現的風險屬性的程序,以及對相關結果的充分回應,是作為負責任的開發者在人工智慧前沿研究工作中的關鍵部分。

以上是Google DeepMind、OpenAI等聯合發文:AI大模型的極端風險,如何評估?的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

10個生成AI編碼擴展,在VS代碼中,您必須探索

Apr 13, 2025 am 01:14 AM

10個生成AI編碼擴展,在VS代碼中,您必須探索

Apr 13, 2025 am 01:14 AM

嘿,編碼忍者!您當天計劃哪些與編碼有關的任務?在您進一步研究此博客之前,我希望您考慮所有與編碼相關的困境,這是將其列出的。 完畢? - 讓&#8217

GPT-4O vs OpenAI O1:新的Openai模型值得炒作嗎?

Apr 13, 2025 am 10:18 AM

GPT-4O vs OpenAI O1:新的Openai模型值得炒作嗎?

Apr 13, 2025 am 10:18 AM

介紹 Openai已根據備受期待的“草莓”建築發布了其新模型。這種稱為O1的創新模型增強了推理能力,使其可以通過問題進行思考

視覺語言模型(VLMS)的綜合指南

Apr 12, 2025 am 11:58 AM

視覺語言模型(VLMS)的綜合指南

Apr 12, 2025 am 11:58 AM

介紹 想像一下,穿過美術館,周圍是生動的繪畫和雕塑。現在,如果您可以向每一部分提出一個問題並獲得有意義的答案,該怎麼辦?您可能會問:“您在講什麼故事?

pixtral -12b:Mistral AI'第一個多模型模型 - 分析Vidhya

Apr 13, 2025 am 11:20 AM

pixtral -12b:Mistral AI'第一個多模型模型 - 分析Vidhya

Apr 13, 2025 am 11:20 AM

介紹 Mistral發布了其第一個多模式模型,即Pixtral-12b-2409。該模型建立在Mistral的120億參數Nemo 12B之上。是什麼設置了該模型?現在可以拍攝圖像和Tex

如何在SQL中添加列? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

如何在SQL中添加列? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

SQL的Alter表語句:動態地將列添加到數據庫 在數據管理中,SQL的適應性至關重要。 需要即時調整數據庫結構嗎? Alter表語句是您的解決方案。本指南的詳細信息添加了Colu

超越駱駝戲:大型語言模型的4個新基準

Apr 14, 2025 am 11:09 AM

超越駱駝戲:大型語言模型的4個新基準

Apr 14, 2025 am 11:09 AM

陷入困境的基準:駱駝案例研究 2025年4月上旬,梅塔(Meta)揭開了其Llama 4套件的模特,擁有令人印象深刻的性能指標,使他們對GPT-4O和Claude 3.5 Sonnet等競爭對手的良好定位。倫斯的中心

如何使用AGNO框架構建多模式AI代理?

Apr 23, 2025 am 11:30 AM

如何使用AGNO框架構建多模式AI代理?

Apr 23, 2025 am 11:30 AM

在從事代理AI時,開發人員經常發現自己在速度,靈活性和資源效率之間進行權衡。我一直在探索代理AI框架,並遇到了Agno(以前是Phi-

多動症遊戲,健康工具和AI聊天機器人如何改變全球健康

Apr 14, 2025 am 11:27 AM

多動症遊戲,健康工具和AI聊天機器人如何改變全球健康

Apr 14, 2025 am 11:27 AM

視頻遊戲可以緩解焦慮,建立焦點或支持多動症的孩子嗎? 隨著醫療保健在全球範圍內挑戰,尤其是在青年中的挑戰,創新者正在轉向一種不太可能的工具:視頻遊戲。現在是世界上最大的娛樂印度河之一