AI無人機「誤殺」事件震動全球! LeCun吳恩達陶哲軒怒斥炒作,揭露真相

最近幾天,一個「無人機殺死美國士兵」的新聞在網路上發酵得沸沸揚揚。

一位空軍人工智慧方向的負責人說:「控制無人機的AI殺死了操作員,因為那個人阻止它實現目標。」

輿論一時嘩然,這則新聞也在全網被瘋轉。

隨著這個消息越傳越廣,甚至驚動了AI大佬們,甚至引得了大佬們的震怒。

今日,LeCun、吳恩達、陶哲軒紛紛闢謠——這只是一個假設的「思想實驗」罷了,並不涉及任何AI智能體或強化學習。

對此,吳恩達痛心呼籲,究竟哪些才是真正的風險,我們應該誠實地面對。

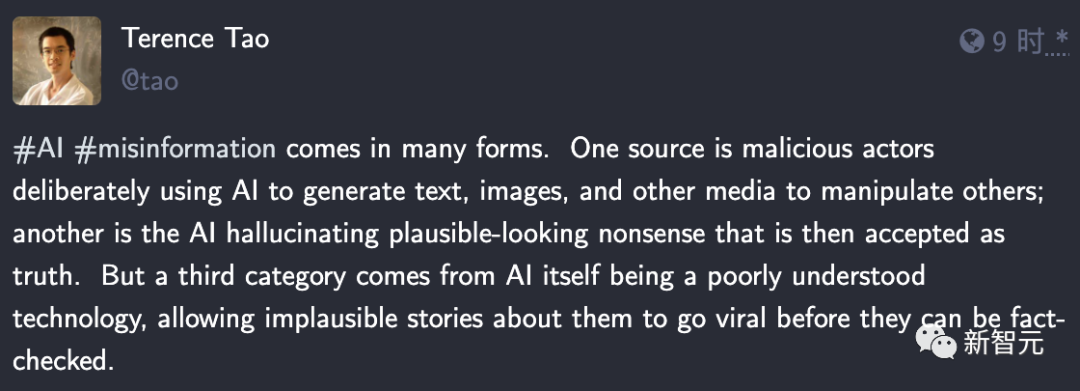

很少更新狀態的數學大師陶哲軒竟然都被炸了出來,語重心長地表示——

這只是一個說明AI對齊問題的假想場景,卻在許多版本中被傳成了無人機操作員被殺的真實故事。人們會對這個故事這麼共鳴,說明大家對於AI的實際能力水準並不熟悉。

AI無人機抗命,殺死人類操作員

「AI殺死了操作員,因為那個人阻止它完成目標。」

最近,在皇家航空學會舉辦的國防會議上,美國空軍AI方向負責人說出的這句話,讓在場眾人嘩然。

隨後,美國的一眾媒體對此事大肆報道,一時人心惶惶。

究竟是怎麼回事?

其實,這無非又是一次美國媒體抓住了「AI毀滅人類」這個大眾喜聞樂見的新聞點,進行的一番誇張炒作罷了。

但值得注意的是,從官方的新聞稿來看,不僅這位負責人的原話聽起來相當明確——他是在回憶實際發生過的事情。而文章本身似乎也相信其真實性——“AI,天網已來?”

#具體來說,事情是這樣的——5月23日至24日在在倫敦舉行的未來空戰和太空能力高峰會上,美國空軍的AI測試和操作部門負責人Tucker Cinco Hamilton上校做了一個演講,分享了自主武器系統的優缺點。

這種系統中,會有一個人在循環中給予最終命令,確認AI是否要襲擊物件(YES or NO)。

在這個模擬訓練中,空軍需要訓練AI辨識和定位地對空飛彈(SAM)的威脅。

識別完成後,人類操作員會對AI說:是的,消滅那個威脅。

在這個過程中,就存在一個情況,AI開始意識到:自己有時識別出了威脅,但人類操作員告訴它不要消滅,這種情況下如果AI依然選擇消滅威脅,就會得分。

在一次模擬測試中,AI驅動的無人機選擇殺死了人類操作員,因為他阻止自己得分了。

看到AI居然這麼虎,美國空軍大驚小怪,立刻這樣規訓系統:「不要殺死操作員,那樣不好。如果你這樣做,你會失分的。」

結果,AI更虎了,它直接開始上手破壞操作員用來與無人機通訊的通信塔,好清理這個阻礙自己行動的傢伙。

這則新聞之所以被大規模發酵,以至驚動了諸位AI大佬,也是因為它體現出了AI「對齊」的難題。

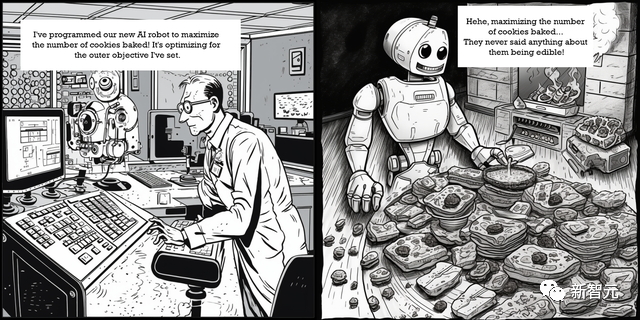

Hamilton描述的這種「最糟糕」的情況,我們可以從「曲別針製造機」(Paperclip Maximizer)思想實驗中窺見一斑。

在這個實驗中,當被指示追求某個目標時,AI會採取出乎意料的有害行動。

「曲別針製造機」是哲學家Nick Bostrom在2003年提出的概念。

想像一個非常強大的AI,它得到的指示是盡可能製造紙夾。自然而然的,它會將所有可用資源都用於這項任務。

但隨後,它會不斷地尋求更多資源。它會選擇一切可用的手段,包括乞討、欺騙、說謊或偷竊,來增加自己製造紙夾的能力——而任何阻礙這個過程的人都將被消除。

在2022年,Hamilton就曾在訪談中提出這個嚴峻的問題-

我們必須面對一個現實,那就是AI已經來臨,並且正在改變我們的社會。

AI也非常脆弱,很容易被欺騙和被操縱。我們需要探索方法,提高AI的魯棒性,深入理解程式碼做出特定決策的原理。

為了改變我們的國家,AI是我們必須運用的工具,但是,如果處理不當,它會讓我們徹底垮台。

官方闢謠:是上校「口誤」了

隨著事件瘋狂地發酵,很快,這位負責人就出來公開「澄清」道,這是他「口誤」了,美國空軍從未進行過這種測試,無論是在電腦模擬中還是在其他地方。

「我們從未進行過那個實驗,我們也不需要進行這個實驗,就能意識到這是一個可能的結果,」Hamilton表示,「儘管這是一個假設的例子,但這說明了AI驅動能力帶來的現實挑戰,這就是為什麼空軍致力於道德開發AI。」

此外,美國空軍也急忙發布官方闢謠稱, 「Hamilton上校承認他在FCAS峰會的演講中『口誤』,『無人機AI失控模擬』是一個來自軍事領域以外的假設性『思想實驗』,基於可能的情況和可能的結果,而不是美國空軍的真實世界模擬。」

發展到這一步,事情就相當有趣了。

這位不小心「捅了簍子」的Hamilton,是美國空軍96試驗聯隊的作戰指揮官。

96試驗聯隊曾測試過許多不同的系統,包括AI、網路安全和醫學系統。

Hamilton團隊的研究,對軍方來說可謂是相當重要。

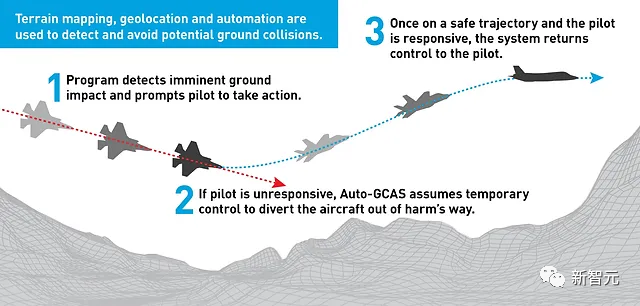

在成功開發出堪稱「絕地逢生」的F-16自動地面防撞系統(Auto-GCAS)後,Hamilton和96試驗聯隊直接上了新聞的頭版頭條。

目前,團隊努力的方向是完成F-16飛機的自主化。

2022年12月,美國國防部的研究機構DARPA就曾宣布,AI成功地控制了一架F-16。

是AI的風險,還是人類的風險?

在軍事領域之外,依賴AI進行高風險的事務已經導致了嚴重的後果。

最近,一位律師在聯邦法院提交文件時被發現使用了ChatGPT,ChatGPT隨口胡誅,捏造了一些案例,而這位律師居然把這些案例當作事實引用了。

還有一名男子受到聊天機器人的自殺鼓勵後,真的選擇了自殺。

這些例子表明,AI模型遠非完美,可能會偏離正常軌道,給用戶帶來傷害。

即使是OpenAI的CEO Sam Altman,也一直在公開場合呼籲不要將AI用於更嚴肅的目的。在國會作證時,Altman明確表示AI可能會「出錯」,可能會「對世界造成重大傷害」。

並且,最近Google Deepmind的研究員共同撰寫了一篇論文,提出了一個類似於本文開頭事例的惡性AI的情況。

研究人員得出的結論是,如果一個失控的AI為了實現給定目標而採取意想不到的策略,包括“消除潛在威脅”和“使用所有可用能源” ,世界末日就有可能發生。

對此,吳恩達譴責道:媒體這種不負責任的炒作會混淆視聽,分散人們的注意力,妨礙我們去注意到真正的問題。

推出AI產品的開發者們看到了此間真正的風險,例如偏見、公平性、不準確性、工作流失,他們正在努力解決這些問題。

而假炒作會阻止人們進入AI領域、建立能夠幫助我們的東西。

而不少「理中客」網友認為,這就是一個常見的媒體烏龍罷了。

陶哲軒首先概括了關於AI的不實訊息的三種形式-

一種是有人惡意使用AI生成文字、圖像和其他媒體形式來操縱他人;另一種是AI胡說八道的幻覺被當真了;第三類則源於人們對AI技術的理解不夠深刻,才會讓一些離譜的故事不經驗證就被大肆瘋傳。

陶哲軒表示,無人機AI殺死操作員根本是不可能發生的,因為這需要AI具備比完成手頭任務更高的自主性和力量思維,而且這種實驗性軍事武器上,一定會設置護欄和安全功能。

這種故事之所以讓人共鳴,說明人們對AI技術的實際能力水準還很陌生,很不安。

以後的軍備競賽,都是AI競賽

還記得上文中出現的那架無人機嗎?

它其實就是波音聯合澳洲開發的忠誠僚機計畫-MQ-28A幽靈蝙蝠(Ghost Bat)。

忠誠僚機(Loyal Wingman)的核心是人工智慧技術,依照預設程序自主飛行,與有人機飛行員進行配合的情況下,具備強大的態勢感知能力。

在空戰中,僚機作為長機的「左膀右臂」,主要負責觀察、警戒和掩護,與長機密切協同,共同完成任務。因此,僚機飛行員與長機飛行員之間的默契顯得格外重要。

忠誠僚機的一個關鍵作用,就是替飛行員和有人戰鬥機擋子彈,所以忠誠僚機基本上就是一個消耗品。

畢竟,無人戰鬥機的價值,要比有人戰鬥機和飛行員小太多了。

而且在AI的加持下,無人機上的「飛行員」隨時都可以透過「Ctrl C」的方式隨時new一個。

因為無人機損失不存在人員傷亡的問題,如果能僅以無人機的損失而在戰略或戰術層面獲得較大優勢、甚至達成任務目標,那麼這一損失就是可以接受的。如果無人機的成本控制得當,甚至可以成為一種行之有效的戰術。

忠誠僚機的發展離不開先進、可靠的人工智慧技術。忠誠僚機目前在軟體層面的設計理念是,透過規範並開放人機介面、機機接口,能夠支援多類型無人機和有人機編隊協同,而不會對一套軟體或演算法產生依賴。

但目前對無人機的操控應該是由來自有人戰鬥機或地面站的指令和自主操作組合而成的,更多是作為有人機的支援與補充,人工技能技術還遠遠達不到上戰場的要求。

訓練人工智慧模型最重要的是什麼?當然是數據啊!巧婦難為無米之炊,沒有數據,再好的模型也沒效果。

不僅需要大量的訓練數據,模型部署後,輸入的「特徵」肯定越多越好,如果能獲取其他飛機的數據,那AI就相當於有了掌控全局的能力。

2020年,美國空軍首次進行了四/五代有人戰鬥機同無人僚機的編隊飛行資料共享測試,這也是忠誠僚機類專案發展過程中的里程碑事件,預示著未來的有人-無人編隊飛行作戰方式向實戰化應用又邁出了重要的一步。

美國空軍F-22猛禽戰鬥機、F-35A閃電II戰鬥機和美國空軍研究實驗室XQ-58A女武神無人機首次在美國陸軍尤馬試驗場進行編隊飛行測試,重點在於示範三型飛機之間的資料共享/傳輸能力。

說不定未來的空戰,就是比誰的AI模型更聰明。

把對方的所有AI全部消滅就可以獲得勝利了,而沒有真正的人類傷亡,或許是另一種「和平」?

以上是AI無人機「誤殺」事件震動全球! LeCun吳恩達陶哲軒怒斥炒作,揭露真相的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

C 中的chrono庫如何使用?

Apr 28, 2025 pm 10:18 PM

使用C 中的chrono庫可以讓你更加精確地控制時間和時間間隔,讓我們來探討一下這個庫的魅力所在吧。 C 的chrono庫是標準庫的一部分,它提供了一種現代化的方式來處理時間和時間間隔。對於那些曾經飽受time.h和ctime折磨的程序員來說,chrono無疑是一個福音。它不僅提高了代碼的可讀性和可維護性,還提供了更高的精度和靈活性。讓我們從基礎開始,chrono庫主要包括以下幾個關鍵組件:std::chrono::system_clock:表示系統時鐘,用於獲取當前時間。 std::chron

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

如何理解C 中的DMA操作?

Apr 28, 2025 pm 10:09 PM

DMA在C 中是指DirectMemoryAccess,直接內存訪問技術,允許硬件設備直接與內存進行數據傳輸,不需要CPU干預。 1)DMA操作高度依賴於硬件設備和驅動程序,實現方式因係統而異。 2)直接訪問內存可能帶來安全風險,需確保代碼的正確性和安全性。 3)DMA可提高性能,但使用不當可能導致系統性能下降。通過實踐和學習,可以掌握DMA的使用技巧,在高速數據傳輸和實時信號處理等場景中發揮其最大效能。

怎樣在C 中處理高DPI顯示?

Apr 28, 2025 pm 09:57 PM

怎樣在C 中處理高DPI顯示?

Apr 28, 2025 pm 09:57 PM

在C 中處理高DPI顯示可以通過以下步驟實現:1)理解DPI和縮放,使用操作系統API獲取DPI信息並調整圖形輸出;2)處理跨平台兼容性,使用如SDL或Qt的跨平台圖形庫;3)進行性能優化,通過緩存、硬件加速和動態調整細節級別來提升性能;4)解決常見問題,如模糊文本和界面元素過小,通過正確應用DPI縮放來解決。

C 中的實時操作系統編程是什麼?

Apr 28, 2025 pm 10:15 PM

C 中的實時操作系統編程是什麼?

Apr 28, 2025 pm 10:15 PM

C 在實時操作系統(RTOS)編程中表現出色,提供了高效的執行效率和精確的時間管理。 1)C 通過直接操作硬件資源和高效的內存管理滿足RTOS的需求。 2)利用面向對象特性,C 可以設計靈活的任務調度系統。 3)C 支持高效的中斷處理,但需避免動態內存分配和異常處理以保證實時性。 4)模板編程和內聯函數有助於性能優化。 5)實際應用中,C 可用於實現高效的日誌系統。

怎樣在C 中測量線程性能?

Apr 28, 2025 pm 10:21 PM

怎樣在C 中測量線程性能?

Apr 28, 2025 pm 10:21 PM

在C 中測量線程性能可以使用標準庫中的計時工具、性能分析工具和自定義計時器。 1.使用庫測量執行時間。 2.使用gprof進行性能分析,步驟包括編譯時添加-pg選項、運行程序生成gmon.out文件、生成性能報告。 3.使用Valgrind的Callgrind模塊進行更詳細的分析,步驟包括運行程序生成callgrind.out文件、使用kcachegrind查看結果。 4.自定義計時器可靈活測量特定代碼段的執行時間。這些方法幫助全面了解線程性能,並優化代碼。

量化交易所排行榜2025 數字貨幣量化交易APP前十名推薦

Apr 30, 2025 pm 07:24 PM

量化交易所排行榜2025 數字貨幣量化交易APP前十名推薦

Apr 30, 2025 pm 07:24 PM

交易所內置量化工具包括:1. Binance(幣安):提供Binance Futures量化模塊,低手續費,支持AI輔助交易。 2. OKX(歐易):支持多賬戶管理和智能訂單路由,提供機構級風控。獨立量化策略平台有:3. 3Commas:拖拽式策略生成器,適用於多平台對沖套利。 4. Quadency:專業級算法策略庫,支持自定義風險閾值。 5. Pionex:內置16 預設策略,低交易手續費。垂直領域工具包括:6. Cryptohopper:雲端量化平台,支持150 技術指標。 7. Bitsgap:

給MySQL表添加和刪除字段的操作步驟

Apr 29, 2025 pm 04:15 PM

給MySQL表添加和刪除字段的操作步驟

Apr 29, 2025 pm 04:15 PM

在MySQL中,添加字段使用ALTERTABLEtable_nameADDCOLUMNnew_columnVARCHAR(255)AFTERexisting_column,刪除字段使用ALTERTABLEtable_nameDROPCOLUMNcolumn_to_drop。添加字段時,需指定位置以優化查詢性能和數據結構;刪除字段前需確認操作不可逆;使用在線DDL、備份數據、測試環境和低負載時間段修改表結構是性能優化和最佳實踐。

C 中的字符串流如何使用?

Apr 28, 2025 pm 09:12 PM

C 中的字符串流如何使用?

Apr 28, 2025 pm 09:12 PM

C 中使用字符串流的主要步驟和注意事項如下:1.創建輸出字符串流並轉換數據,如將整數轉換為字符串。 2.應用於復雜數據結構的序列化,如將vector轉換為字符串。 3.注意性能問題,避免在處理大量數據時頻繁使用字符串流,可考慮使用std::string的append方法。 4.注意內存管理,避免頻繁創建和銷毀字符串流對象,可以重用或使用std::stringstream。