目錄:

###################### ##########論文1:Faster sorting algorithms discovered using deep reinforcement learning#####################作者:Daniel J. Mankowitz 等# #################論文網址:https://www.nature.com/articles/s41586-023-06004-9############ ##########摘要:###「透過交換和複製移動,AlphaDev 跳過了一個步驟,以一種看似錯誤,但實際上是捷徑的方式連接項目。」這種前所未見、違反直覺的思想不禁讓人回想起2016 年那個春天。 ############七年前,AlphaGo 在圍棋上擊敗人類世界冠軍,如今 AI 又在程式設計上給我們上了一課。 Google DeepMind CEO 哈薩比斯的兩句話引爆電腦領域:「AlphaDev 發現了一種全新且更快的排序演算法,我們已將其開源到主要C 庫中供開發人員使用。這只是AI 提升程式碼效率進步的開始。」###############################推薦:###AI 重寫排序演算法,速度快70% :DeepMind AlphaDev 革新計算基礎,每天調用萬億次的庫更新了###############論文2:Video-LLaMA: An Instruction-tuned Audio-Visual Language Model for Video Understanding #####################作者:Hang Zhang 等##################論文地址:https:/ /arxiv.org/abs/2306.02858######################摘要:###近期,大語言模式展現了令人矚目的能力。我們能否給大模型裝上 “眼睛” 和 “耳朵”,讓它能夠理解視頻,陪著用戶互動呢? ############從這個問題出發,達摩院的研究人員提出了 Video-LLaMA,一個具有綜合視聽能力大模型。 Video-LLaMA 能夠感知和理解視訊中的視訊和音訊訊號, 並能理解使用者輸入的指令,完成一系列基於音訊視訊的複雜任務,例如音 / 視訊描述,寫作,問答等。目前論文,代碼,交互 demo 都已開放。另外,在 Video-LLaMA 的專案首頁中,研究團隊也提供了中文版本的模型,讓中文使用者的體驗更絲滑。 ############下面兩個例子展示了 Video-LLaMA 的視聽綜合感知能力,例子中的會話圍繞著有聲視訊。 #########################推薦:###給語言大模型加上綜合視聽能力,達摩院開源 Video-LLaMA。 ###############論文 3:Patch-based 3D Natural Scene Generation from a Single Example#########

摘要:北京大學陳寶權團隊聯合山東大學和騰訊AI Lab 的研究人員,提出了首個基於單一範例場景無需訓練便可產生多樣化高品質三維場景的方法。

#推薦:CVPR 2023 | 三維場景產生:無需任何神經網路訓練,從單一範例產生多元結果。

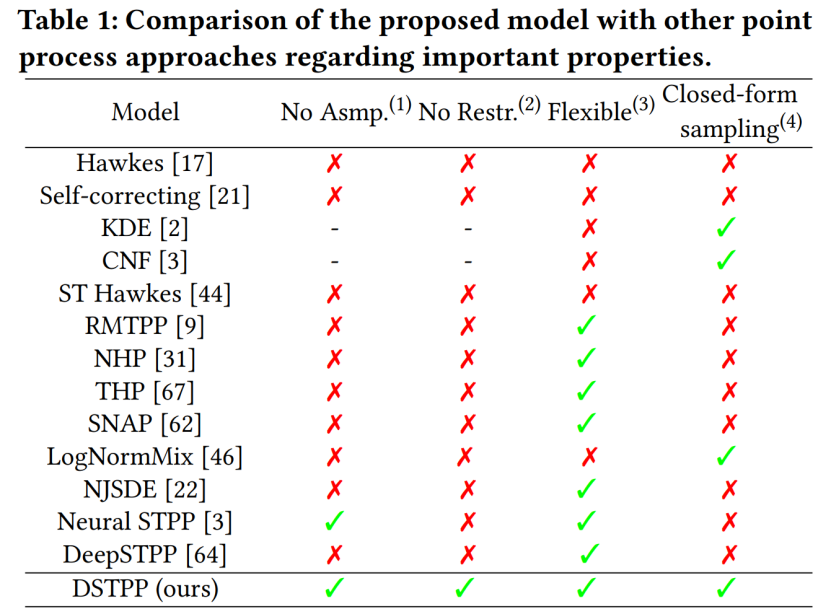

論文4:Spatio-temporal Diffusion Point Processes

摘要:清華電子工程系城市科學與計算研究中心最新提出時空擴散點過程,突破已有方法建模時空點過程的受限機率形式和高採樣成本等缺陷,實現了靈活、高效且易於計算的時空點過程模型,可廣泛用於城市自然災害、突發事故和居民活動等時空事件的建模與預測,促進城市規劃和管理的智慧化發展。下表展示 DSTPP 相比已有點製程解決方案的優勢。

#推薦:擴散模型還能預測地震與犯罪?清華團隊最新研究提出時空擴散點過程。

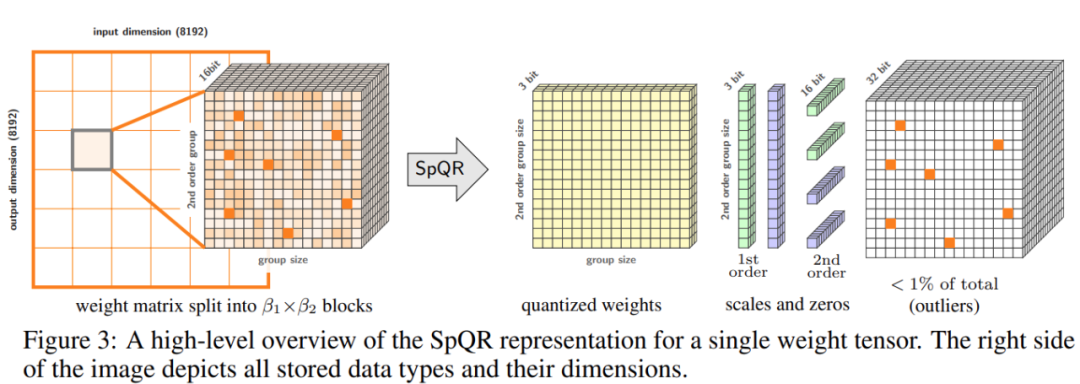

論文5:SpQR: A Sparse-Quantized Representation for Near-Lossless LLM Weight Compression

#摘要:為了解決準確性問題,華盛頓大學、蘇黎世聯邦理工學院等機構的研究者提出了一種新的壓縮格式和量化技術SpQR(稀疏- 量化表徵),首次實現了LLM 跨模型尺度的近無損壓縮,同時達到了與先前方法相似的壓縮水平。

SpQR 透過識別和隔離異常權重來工作,這些異常權重會導致特別大的量化誤差,研究者將它們以更高的精度存儲,同時將所有其他權重壓縮到3-4 位,在LLaMA 和Falcon LLMs 中實現了不到1% 的困惑度相對準確率損失。在單一 24GB 的消費級 GPU 上執行 33B 參數的 LLM,而不會有任何效能下降,同時還能提高 15% 的速度。下圖 3 為 SpQR 的總體架構。

推薦:將330 億參數大模型「塞進」單一消費級GPU,加速15%、性能不減。

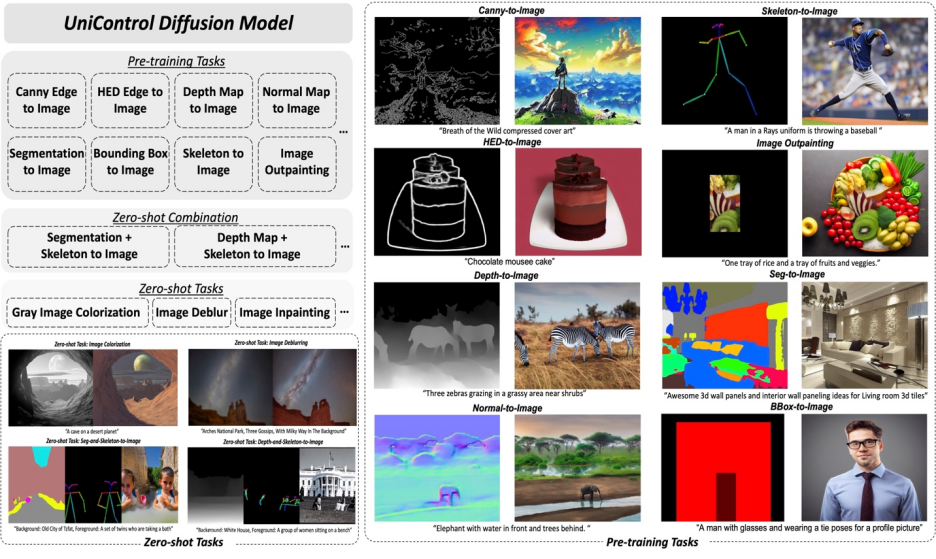

論文 6:UniControl: A Unified Diffusion Model for Controllable Visual Generation In the Wild

摘要:本文中,Salesforce AI、東北大學、史丹佛大學的研究者提出了MOE-style Adapter 和Task-aware HyperNet來實作UniControl 中的多模態條件生成能力。 UniControl 在九個不同的 C2I 任務上進行訓練,展示了強大的視覺生成能力和 zero-shot 泛化能力。 UniControl 模型由多個預訓練任務和 zero-shot 任務組成。

#推薦:多模態可控圖片產生統一模型來了,模型參數、推理程式碼全部開源。

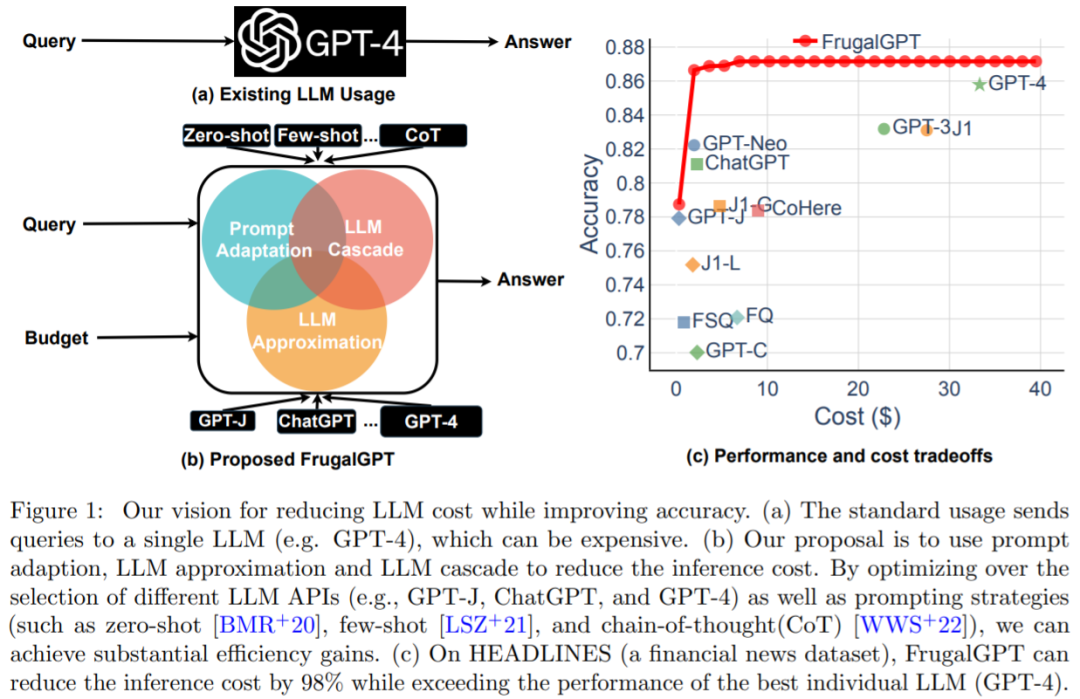

論文7:FrugalGPT: How to Use Large Language Models While Reducing Cost and Improving Performance

#摘要:成本和準確性之間的平衡是決策的關鍵因素,尤其是在採用新技術時。如何有效和有效率地利用LLM 是從業者面臨的關鍵挑戰:如果任務相對簡單,那麼聚合來自GPT-J (其規模比GPT-3 小30 倍)的多個響應可以實現與GPT-3 類似的性能,從而實現成本和環境上的權衡。然而,在較為困難任務上,GPT-J 的表現可能會大幅下降。因此,如何經濟高效地使用 LLM 需要採用新的方法。

最近的一項研究嘗試提出解決這一成本問題的方法,研究者透過實驗表明,FrugalGPT 可以與最佳個體LLM(例如GPT-4) 的表現相媲美,成本降低高達98%,或在相同成本下將最佳個體LLM 的準確性提高4%。該研究討論了三種降低成本的策略,即 prompt 適應、LLM 近似和 LLM 級聯。

推薦:GPT-4 API 平替?性能媲美同時成本降低 98%,史丹佛提出 FrugalGPT,研究卻惹爭議。

以上是DeepMind用AI重寫排序演算法;將33B大模型塞進單一消費級GPU的詳細內容。更多資訊請關注PHP中文網其他相關文章!