最近幾年,「視訊會議」在工作中的佔比逐漸增加,廠商也開發了各種諸如實時字幕等技術以方便會議中不同語言的人之間交流。

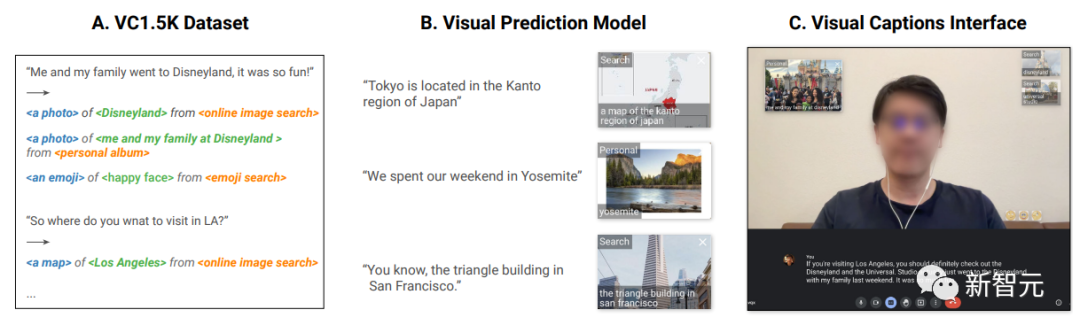

但還有一個痛點,要是對話中提到了一些對方很陌生的名詞,並且很難用語言描述出來,比如食物“壽喜燒”,或者是說“上週去了某個公園度假”,很難用語言給對方描述出的美景;甚至是指出“東京位於日本關東地區”,需要一張地圖來展示等,如果只用語言可能會讓對方越來越迷茫。

最近,Google在人機互動頂級會議ACM CHI(Conference on Human Factors in Computing Systems)上展示了一個系統Visual Captions,介紹了遠距會議中的一個全新視覺解決方案,可以在對話背景中產生或檢索圖片以提高對方對複雜或陌生概念的了解。

論文連結:https://research.google/pubs/pub52074/

程式碼連結:https://github.com/google/archat

#Visual Captions系統基於一個微調後的大型語言模型,可以在開放詞彙的對話中主動推薦相關的視覺元素,並已融入開源專案ARChat。

在使用者研究中,研究人員邀請了實驗室內的26位參與者,與實驗室外的10位參與者對系統進行評估,超過80%的使用者基本上都認同Video Captions可以在各種場景下能提供有用、有意義的視覺推薦,並且可以提升交流體驗。

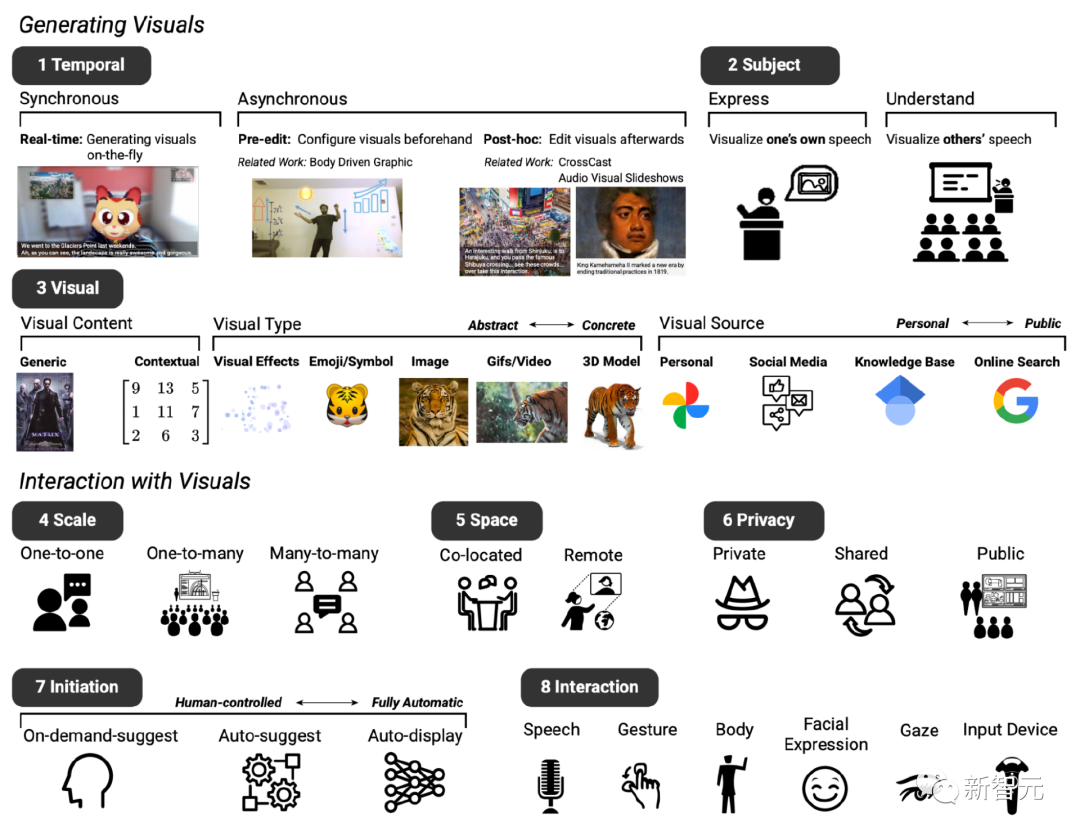

在開發之前,研究人員首先邀請了10位內部參與者,包括軟體工程師、研究人員、UX設計師、視覺藝術家、學生等技術與非技術背景的從業者,討論對即時視覺增強服務的特定需求和期望。

兩次會議後,根據現有的文字轉圖像系統,確立了預期原型系統的基本設計,主要包括八個維度(記為D1至D8)。

D1:時序,視覺增強系統可與對話同步或非同步展現

D2:主題,可用於表達和理解語音內容

D3:視覺,可使用廣泛的視覺內容、視覺類型和視覺來源

D4:規模,根據會議規模的不同,視覺增強效果可能有所不同

D5:空間,視訊會議是在同一地點還是在遠端設定中

D6:隱私,這些因素也影響視覺效果是否應該私下顯示、在參與者之間共享或向所有人公開

D7:初始狀態,參與者還確定了他們希望在進行對話時與系統互動的不同方式,例如,不同層次的「主動性」,即使用者可以自主確定係統何時介入聊天D8:交互,參與者設想了不同的交互方法,例如,使用語音或手勢進行輸入

以動態的視覺效果增強語言溝通的設計空間

根據初步回饋,研究人員設計了Video Caption系統,專注於產生語義相關的視覺內容、類型和來源的同步視覺效果。

雖然在探索性會議中的想法大多關注於一對一遠端對話的形式,Video Caption同樣也可以用於一對多的(例如,向觀眾進行演示)和多對多場景(多人會議討論)的部署。

除此之外,最能補充對話的視覺效果在很大程度上取決於討論的上下文,所以需要一個專門製作的訓練集。

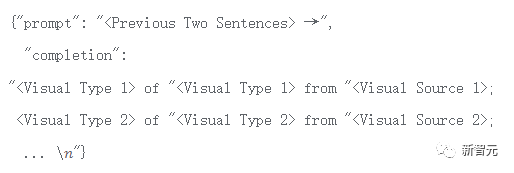

研究人員收集了1595個四元組,包括語言、視覺內容、類型、來源,涵蓋了各種情境場景,包括日常對話、講座、旅遊指南等。

例如使用者說「我很想看看!」(I would love to see it!)對應於「臉微笑」(face smiling)的視覺內容、「表情符號」 (emoji)的視覺類型和「公共搜尋」(public search)的視覺來源。

「她有沒有告訴你我們去墨西哥的事?」對應於「來自墨西哥之旅的照片」的視覺內容、「照片」的視覺類型以及「個人相簿」的視覺源。

該資料集VC 1.5K目前已開源。

資料連結:https://github.com/google/archat/tree/main/dataset

為了預測哪些視覺效果可以補充對話,研究人員使用VC1.5K資料集基於大型語言模型訓練了一個視覺意圖預測模型。

在訓練階段,每個視覺意圖解析為「

基於此格式,系統可以處理開放詞彙會話和上下文預測視覺內容、視覺來源和視覺類型。

這種方法在實務上也優於基於關鍵字的方法,因為後者無法處理開放式詞彙的例子,例如用戶可能會說“你的艾米阿姨將在這個星期六來訪”,沒有匹配到關鍵字,也就無法推薦相關的視覺類型或視覺來源。

研究人員使用VC1.5K資料集中的1276個(80%)樣本來微調大型語言模型,其餘319個(20%)範例作為測試數據,並使用token準確率指標來測量微調模型的效能,即模型正確預測的樣本中token正確的百分比。

最終模型可以達到97%的訓練token準確率和87%的驗證token準確率。

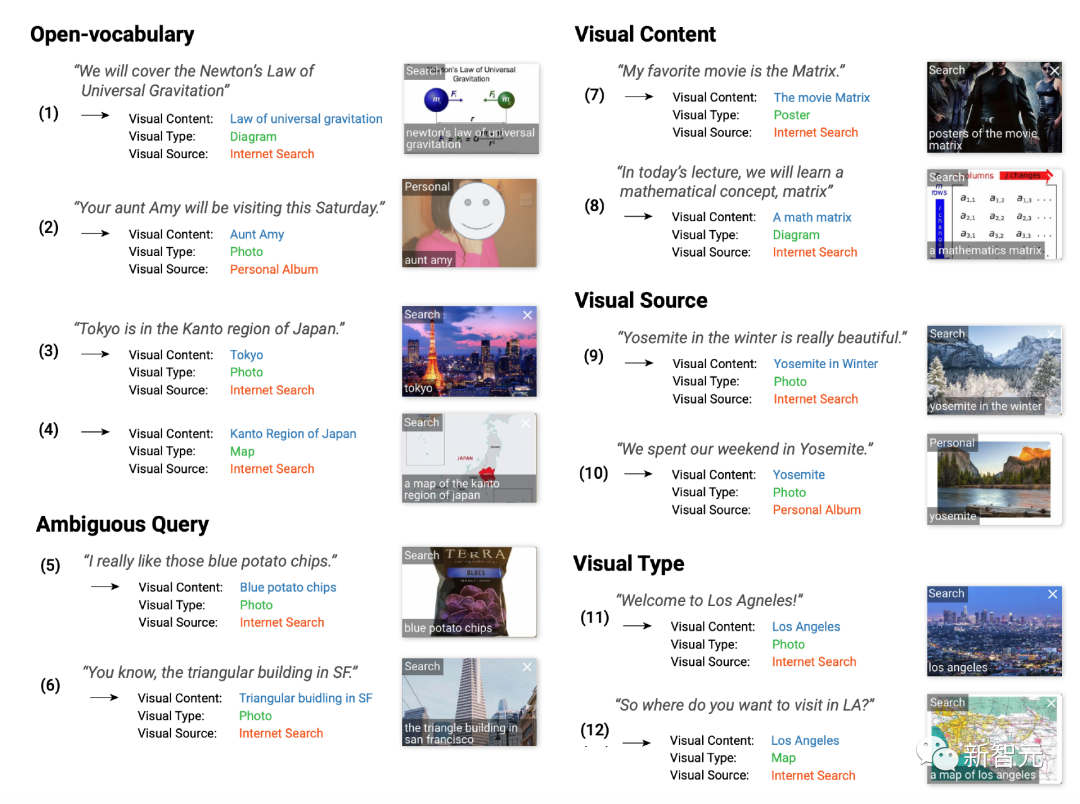

為了評估訓練的視覺字幕模型的實用性,研究團隊邀請了89位參與者執行846項任務,要求對效果進行評分,1為非常不同意(strongly disagree)、7為非常同意(strongly agree)。

實驗結果顯示,大多數參與者喜歡在對話中看到視覺效果(Q1),83% 給了5-有些同意(somewhat agree)以上的評價。

此外,參與者認為顯示的視覺效果是有用的且資訊豐富的(Q2),82%給出了高於5分的評價;高品質的(Q3) ,82%給出了高於5分的評價;並與原始語音相關(Q4,84%)。

參與者也發現預測的視覺類型(Q5,87%)和視覺來源(Q6,86%)在相應對話的背景下是準確的。

研究參與者對視覺化預測模型的技術評估結果進行評分

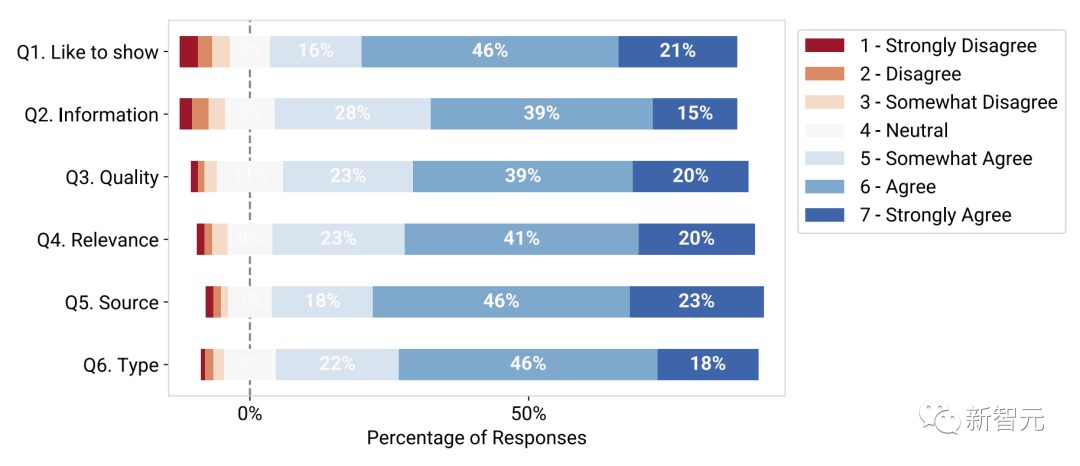

#基於此微調的視覺意圖預測模型,研究人員在ARChat平台上開發了Visual Captions,可以直接在視訊會議平台(如Google Meet)的攝影機串流上新增的互動式小工具。

在系統工作流程中,Video Captions可以自動捕捉使用者的語音、檢索最後的句子、每隔100毫秒將資料輸入到視覺意圖預測模型中、檢索相關視覺效果,然後提供推薦的視覺效果。

#Visual Captions的系統工作流程

# #Visual Captions在推薦視覺效果時提供三個等級的可選主動性:

#自動顯示(高主動性):系統自主搜尋並向所有會議參與者公開顯示視覺效果,無需使用者互動。

按需建議(低主動性):使用者按下空白鍵後,系統才會建議視覺效果。

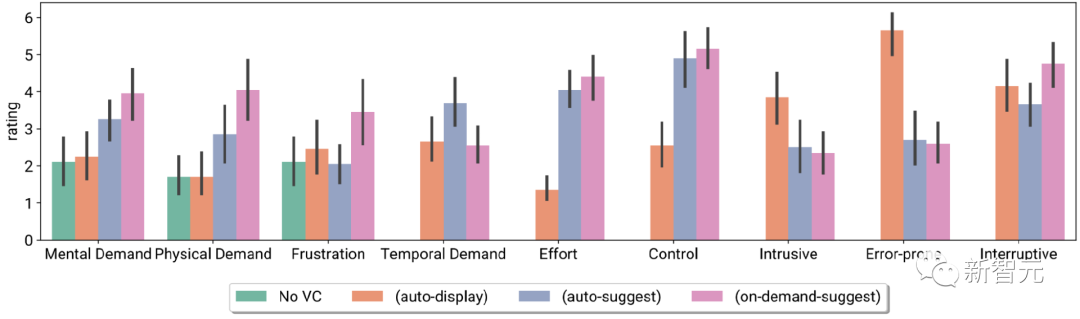

研究人員在對照實驗室研究(n = 26)和測試階段部署研究(n = 10)中評估了Visual Captions系統,參與者發現,即時視覺效果有幫助於解釋不熟悉的概念、解決語言歧義,並使對話更具吸引力,從而促進了現場對話。

#####################參與者的task load指數和Likert scale評級,包括無VC、以及三個不同主動性的VC###############與會者也報告了在現場進行互動中的不同的系統偏好,即在不同的會議場景中使用不同程度的VC主動性## ####以上是再也不怕「視訊會議」蒙塞住了! GoogleCHI頂會發布新神器Visual Captions:讓圖片做你的字幕助手的詳細內容。更多資訊請關注PHP中文網其他相關文章!