280萬條多模態指令-響應對,八種語言通用,首個涵蓋視訊內容的指令資料集MIMIC-IT來了

近段时间来,AI 对话助手在语言任务上取得了不小的进展。这种显著的进步不只是基于 LLM 强大的泛化能力,还应该归功于指令调优。这涉及到在一系列通过多样化和高质量指令的任务上对 LLM 进行微调。

借助指令调优获得零样本性能的一个潜在原因是,它内化了上下文。这很重要,特别是当用户输入跳过常识性的上下文时。通过纳入指令调优,LLM 获得了对用户意图的高度理解,即使在以前未见过的任务中也能表现出更好的零样本能力。

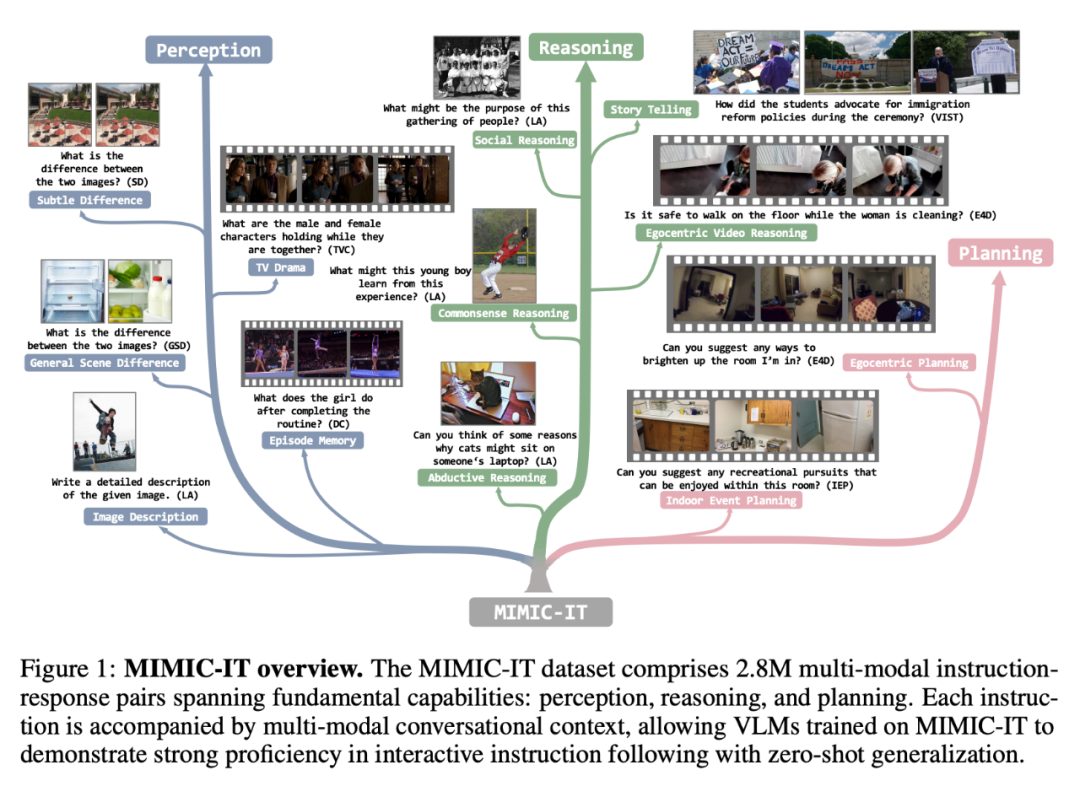

然而,一个理想的 AI 对话助手应该能够解决涉及多种模态的任务。这需要获得一个多样化和高质量的多模式指令跟随数据集。比如,LLaVAInstruct-150K 数据集(也被称为 LLaVA)就是一个常用的视觉 - 语言指令跟随数据集,它是使用 COCO 图像、指令和从 GPT-4 中获得的基于图像说明和目标边界框的响应构建的。但 LLaVA-Instruct-150K 具有三个局限性:有限的视觉多样性;使用图片作为单一视觉数据;上下文信息仅包含语言形态。

为了推动 AI 对话助手突破这些限制,来自新加坡南洋理工大学、微软雷蒙德研究院的学者们提出了多模态上下文指令调优数据集 MIMIC-IT,这是一个包含 280 万条多模态上下文指令 - 相应对的数据集,涵盖各种现实生活场景。

论文地址:https://arxiv.org/pdf/2306.05425.pdf

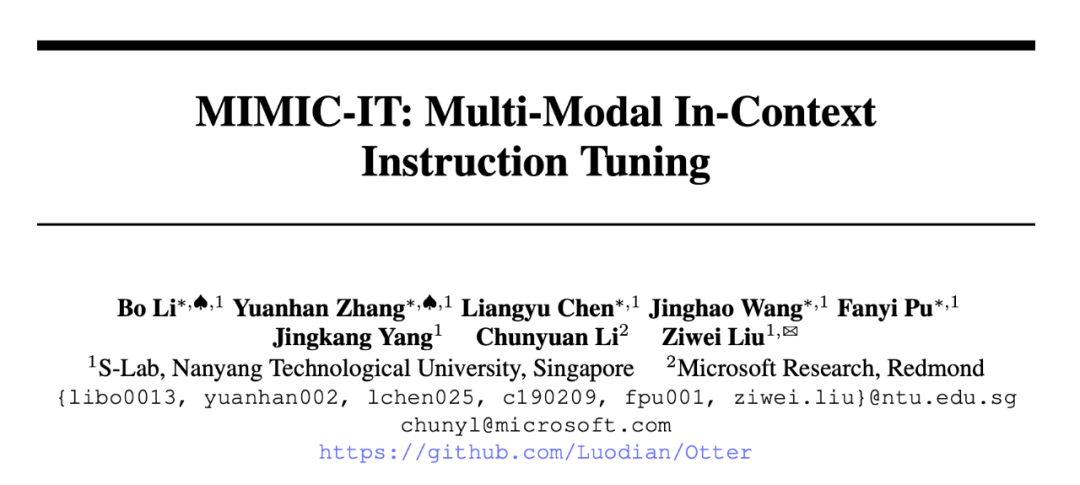

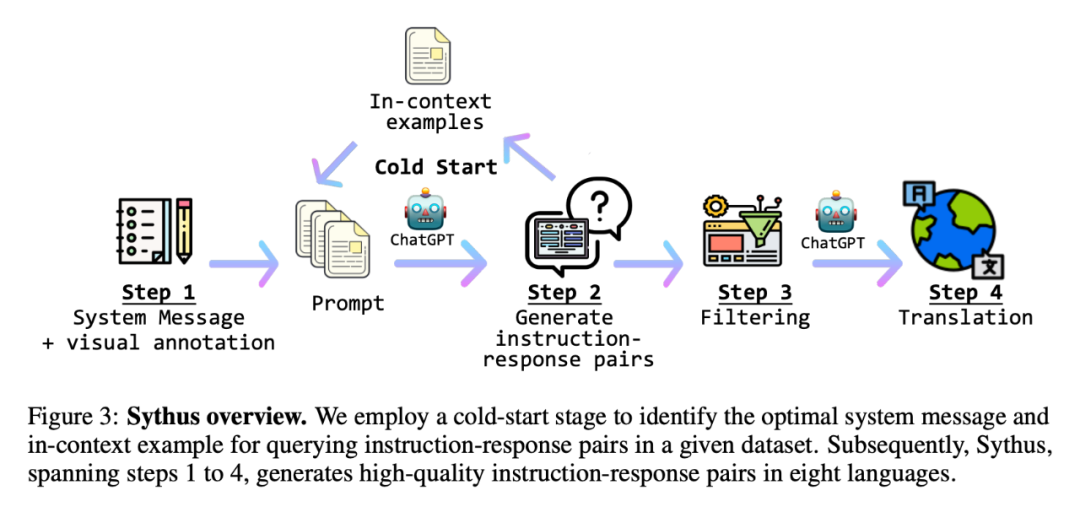

此外,为了高效地生成指令 - 响应对,研究者还介绍了「Sythus」,这是一个受 self-instruct 方法启发的指令 - 响应注释的自动化 pipeline。Sythus 采用系统信息、视觉注释和上下文中的例子来指导语言模型(GPT-4 或 ChatGPT)根据视觉语境生成指令 - 响应对,针对视觉语言模型的三个基本能力:感知、推理和规划。此外,英文的指令和响应被译成七种语言,以支持多种语言的使用。

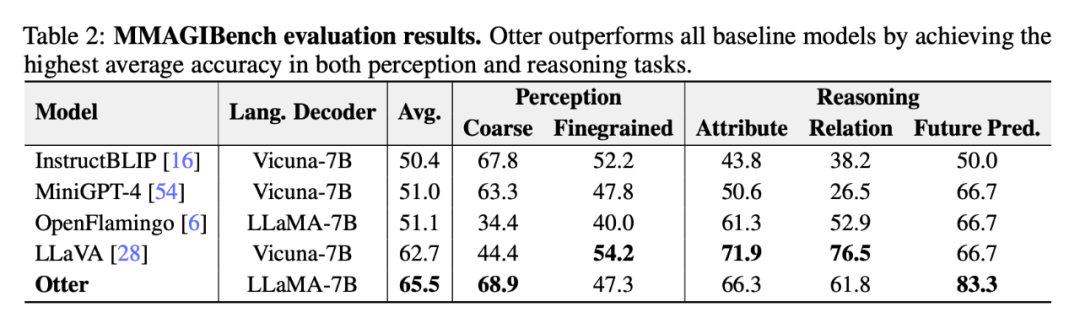

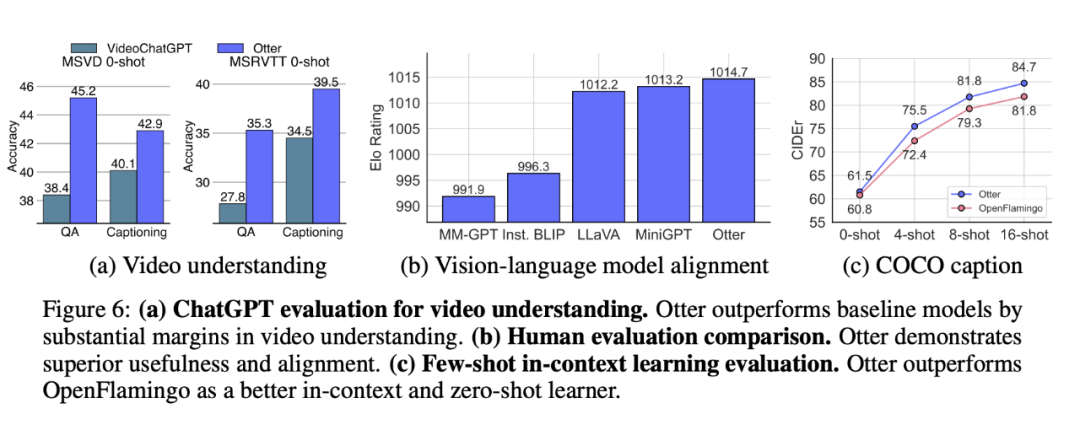

特别值得注意的是,研究者在 MIMIC-IT 上训练了基于 OpenFlamingo 的多模态模型「Otter」。通过 ChatGPT、人类两个方面的评估,Otter 的多模态能力超越了近期的其他视觉 - 语言模型。

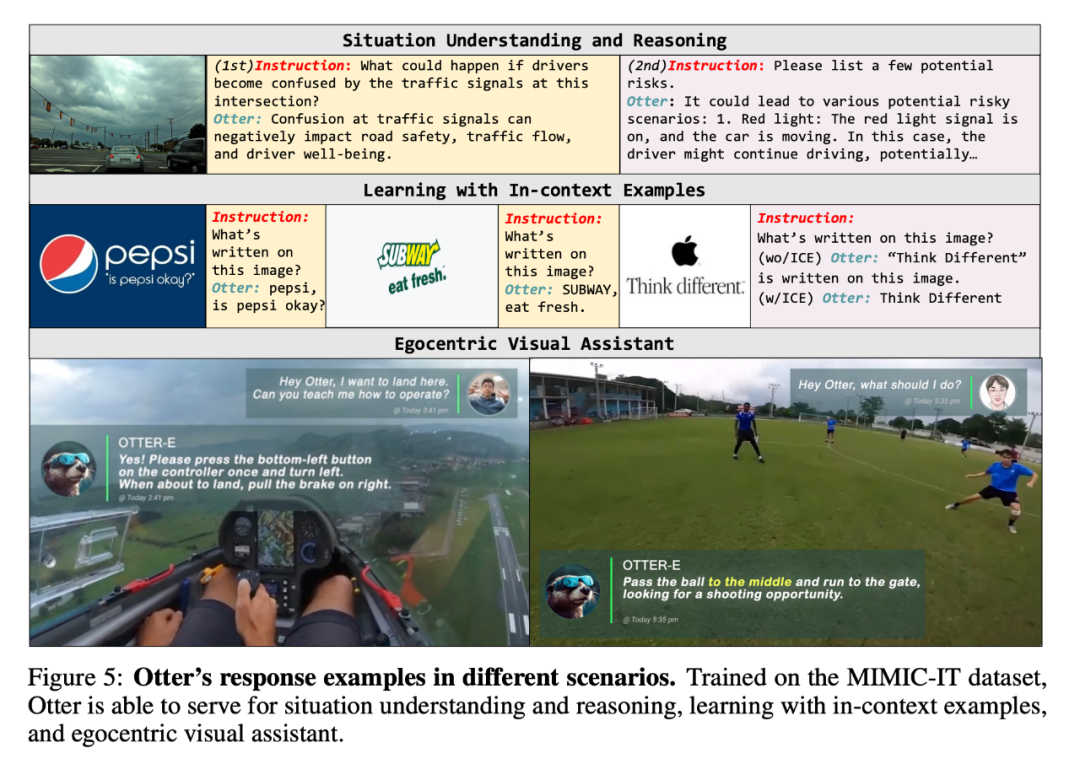

在一系列 Demo 中,研究者展示了 Otter 的多模态问答能力:

Q:接下来出哪张牌?

A:八筒。这样你就能留着四条和五条,等着凑成顺子。

Q:我想着陆了,怎么操作?

A:按一次左下按钮,左转,要着陆时拉右边的手刹。

Q:接下来怎么办?

A:把球传到中路,跑到球门,寻找进球机会。

接下来,让我们看看研究细节。

MIMIC-IT 資料集

MIMIC-IT 資料集包括 280 萬個多模態指令 - 回應對,涵蓋了基本能力:感知、推理和計劃。每個指令都伴隨著多模態的對話背景,使在 MIMIC-IT 上訓練的 VLM 能夠在互動式指令中表現出很好的熟練度,並能進行零樣本的概括。

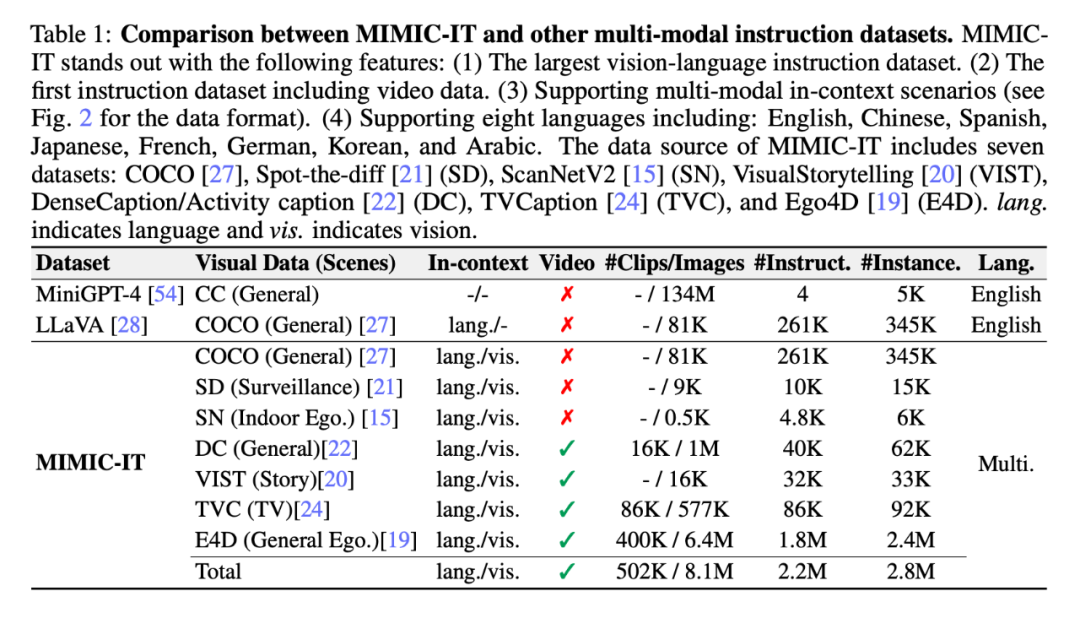

比起LLaVA,MIMIC-IT 的特性包括:

(1) 多樣化的視覺場景,包含了一般場景、自我中心視角場景和室內RGB-D 影像等不同資料集的影像和影片;

(2) 多個圖像(或一個視訊)作為視覺資料;

(3) 多模態的上下文訊息,包括多個指令- 響應對和多個圖像或視訊;

(4) 支援八種語言,包括英文、中文、西班牙文、日文、法文、德文、韓文和阿拉伯文。

下圖進一步展示了二者的指令- 回應對對比(黃色方框為LLaVA):

如表1 所示,MIMIC-IT 的資料來源來自七個資料集:COCO、Spot-the-diff (SD)、ScanNetV2 (SN)、VisualStorytelling (VIST) 、DenseCaption /Activity caption(DC)、TVCaption(TVC)和Ego4D(E4D)。 「上下文」這一列的「lang.」表示語言,「vis.」表示視覺。

同時,研究者提出了Sythus(圖3),這是一個自動化pipeline,用於產生多種語言的高品質指令- 響應對。在 LLaVA 提出的框架基礎上,研究者利用 ChatGPT 來產生基於視覺內容的指令 - 回應對。為了確保產生的指令 - 回應對的質量,該 pipeline 將系統資訊、視覺註釋和上下文中的樣本作為 ChatGPT 的 prompt。系統資訊定義了所產生的指令 - 響應對的預期語氣和風格,而視覺註釋則提供了基本的圖像信息,如邊界框和圖像描述。上下文中的樣本幫助 ChatGPT 在語境中學習。

由於核心集的品質會影響後續的資料收集過程,研究者採用了一個冷啟動策略,在大規模查詢之前加強上下文中的樣本。在冷啟動階段,採用啟發式方法,僅透過系統資訊和視覺註釋來 prompt ChatGPT 收集上下文中的樣本。這個階段只有在確定了令人滿意的上下文中的樣本後才結束。在第四步,一旦獲得指令- 回應對,pipeline 會將它們擴展為中文(zh)、日文(ja)、西班牙文(es)、德文(de)、法文(fr)、韓文(ko)和阿拉伯語(ar)。進一步的細節,可參考附錄 C,具體的任務 prompt 可以在附錄 D 中找到。

經驗性評估

隨後,研究者展示了MIMIC-IT 資料集的各種應用以及在其上訓練的視覺語言模型(VLM) 的潛在能力。首先,研究者介紹了使用 MIMIC-IT 資料集開發的上下文指令調優模型 Otter。而後,研究者探索了在 MIMIC-IT 資料集上訓練 Otter 的各種方法,並討論了可以有效使用 Otter 的眾多場景。

圖 5 是 Otter 在不同場景下的回應實例。由於在 MIMIC-IT 資料集上進行了訓練,Otter 能夠為情境理解和推理、上下文樣本學習、自我中心的視覺助手服務。

最後,研究者在一系列基準測試中對 Otter 與其他 VLM 的表現進行了比較分析。

ChatGPT 評估

#下表2 展示了研究者利用MMAGIBench 架構[43] 對視覺語言模型的感知和推理能力進行廣泛的評估。

人類評估

Multi-Modality Arena [32] 使用Elo 評級系統來評估VLM 回應的有用性和一致性。圖 6 (b) 顯示 Otter 展示了卓越的實用性和一致性,在最近的 VLM 中獲得了最高的 Elo 評級。

少樣本上下文學習基準評估

#Otter 基於OpenFlamingo 進行微調,OpenFlamingo 是一種專為多模態上下文學習而設計的架構。使用 MIMIC-IT 資料集進行微調後,Otter 在 COCO 字幕 (CIDEr) [27] 少樣本評估(見圖 6 (c))上的表現明顯優於 OpenFlamingo。正如預期的那樣,微調也帶來了零樣本評估的邊際性能增益。

#圖 6:ChatGPT 影片理解的評估。

討論

缺陷。雖然研究者已經迭代改進了系統訊息和指令 - 回應範例,但 ChatGPT 容易出現語言幻覺,因此它可能會產生錯誤的回應。通常,更可靠的語言模型需要 self-instruct 資料產生。

未來工作。未來,研究者計劃支援更多具體 AI 資料集,例如 LanguageTable 和 SayCan。研究者也考慮使用更值得信賴的語言模型或生成技術來改進指令集。

以上是280萬條多模態指令-響應對,八種語言通用,首個涵蓋視訊內容的指令資料集MIMIC-IT來了的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

泰拉瑞亞怎麼用指示取得物品? -泰拉瑞亞怎麼收藏物品?

Mar 19, 2024 am 08:13 AM

泰拉瑞亞怎麼用指示取得物品? -泰拉瑞亞怎麼收藏物品?

Mar 19, 2024 am 08:13 AM

泰拉瑞亞怎麼用指示取得物品?一、什麼是泰拉瑞亞給予物品指令在泰拉瑞亞遊戲中,給予物品指令是一項非常實用的功能。透過這個指令,玩家可以直接取得需要的物品,而不必費力地去打怪或傳送到某個地點。這樣可以大大節省時間,提高遊戲的效率,讓玩家更專注於探索和建立世界。總的來說,這個功能讓遊戲體驗變得更加流暢和愉快。二、如何使用泰拉瑞亞給予物品指令1.打開遊戲並進入遊戲介面。 2.按下鍵盤上的「Enter」鍵,開啟聊天視窗。 3.在聊天視窗中輸入指令的格式:「/give[玩家名稱][物品ID][物品數量]」。

使用PyTorch進行小樣本學習的影像分類

Apr 09, 2023 am 10:51 AM

使用PyTorch進行小樣本學習的影像分類

Apr 09, 2023 am 10:51 AM

近年來,基於深度學習的模型在目標偵測和影像辨識等任務中表現出色。像ImageNet這樣具有挑戰性的影像分類資料集,包含1000種不同的物件分類,現在有些模型已經超過了人類層級。但是這些模型依賴監督訓練流程,標記訓練資料的可用性對它們有重大影響,並且模型能夠檢測到的類別也僅限於它們接受訓練的類別。由於在訓練過程中沒有足夠的標記圖像用於所有類別,這些模型在現實環境中可能不太有用。而我們希望的模型能夠識別它在訓練期間沒有見到過的類,因為幾乎不可能在所有潛在物件的圖像上進行訓練。我們將從幾個樣本中學習

VUE3快速入門:使用Vue.js指令實作選項卡切換

Jun 15, 2023 pm 11:45 PM

VUE3快速入門:使用Vue.js指令實作選項卡切換

Jun 15, 2023 pm 11:45 PM

本文旨在協助初學者快速入手Vue.js3,實現簡單的選項卡切換效果。 Vue.js是一個流行的JavaScript框架,可用於建立可重複使用的元件、輕鬆管理應用程式的狀態和處理使用者介面的互動操作。 Vue.js3是該框架的最新版本,相較於先前的版本變動較大,但基本原理並未改變。在本文中,我們將使用Vue.js指令實作選項卡切換效果,目的是讓讀者熟悉Vue.js的

為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

Jul 25, 2024 am 06:42 AM

為大模型提供全新科學複雜問答基準與評估體系,UNSW、阿貢、芝加哥大學等多家機構共同推出SciQAG框架

Jul 25, 2024 am 06:42 AM

編輯|ScienceAI問答(QA)資料集在推動自然語言處理(NLP)研究中發揮著至關重要的作用。高品質QA資料集不僅可以用於微調模型,也可以有效評估大語言模型(LLM)的能力,尤其是針對科學知識的理解和推理能力。儘管目前已有許多科學QA數據集,涵蓋了醫學、化學、生物等領域,但這些數據集仍有一些不足之處。其一,資料形式較為單一,大多數為多項選擇題(multiple-choicequestions),它們易於進行評估,但限制了模型的答案選擇範圍,無法充分測試模型的科學問題解答能力。相比之下,開放式問答

在自訂資料集上實作OpenAI CLIP

Sep 14, 2023 am 11:57 AM

在自訂資料集上實作OpenAI CLIP

Sep 14, 2023 am 11:57 AM

在2021年1月,OpenAI宣布了兩個新模型:DALL-E和CLIP。這兩個模型都是多模態模型,以某種方式連接文字和圖像。 CLIP的全名是對比語言-影像預訓練(ContrastiveLanguage-ImagePre-training),它是一種基於對比文字-影像對的預訓練方法。為什麼要介紹CLIP呢?因為目前火熱的StableDiffusion並不是單一模型,而是由多個模型組成。其中一個關鍵組成部分是文字編碼器,用於對使用者的文字輸入進行編碼,而這個文字編碼器就是CLIP模型中的文字編碼器CL

GoogleAI影片再出王炸!全能通用視覺編碼器VideoPrism,效能刷新30項SOTA

Feb 26, 2024 am 09:58 AM

GoogleAI影片再出王炸!全能通用視覺編碼器VideoPrism,效能刷新30項SOTA

Feb 26, 2024 am 09:58 AM

AI視訊模型Sora爆紅之後,Meta、Google等大廠紛紛下場做研究,追趕OpenAI的步伐。最近,來自Google團隊的研究人員提出了一種通用視訊編碼器——VideoPrism。它能夠透過單一凍結模型,處理各種視訊理解任務。圖片論文地址:https://arxiv.org/pdf/2402.13217.pdf例如,VideoPrism能夠將下面影片中吹蠟燭的人分類、定位出來。圖片影片-文字檢索,根據文字內容,可以檢索出影片中對應的內容。圖片再比如,描述下面影片——一個小女孩在玩積木。還可以進行QA問答。

如何正確拆分資料集?常見的三種方法總結

Apr 08, 2023 pm 06:51 PM

如何正確拆分資料集?常見的三種方法總結

Apr 08, 2023 pm 06:51 PM

將資料集分解為訓練集,可以幫助我們了解模型,這對於模型如何推廣到新的看不見資料非常重要。如果模型過度擬合可能無法很好地概括新的看不見的數據。因此也無法做出良好的預測。擁有適當的驗證策略是成功創造良好預測,使用AI模型的業務價值的第一步,本文就整理出一些常見的資料分割策略。簡單的訓練、測試拆分將資料集分為訓練和驗證2個部分,並以80%的訓練和20%的驗證。可以使用Scikit的隨機取樣來執行此操作。首先需要固定隨機種子,否則無法比較獲得相同的資料拆分,在調試時無法獲得結果的複現。如果資料集

PyTorch 並行訓練 DistributedDataParallel 完整程式碼範例

Apr 10, 2023 pm 08:51 PM

PyTorch 並行訓練 DistributedDataParallel 完整程式碼範例

Apr 10, 2023 pm 08:51 PM

使用大型資料集訓練大型深度神經網路 (DNN) 的問題是深度學習領域的主要挑戰。隨著 DNN 和資料集規模的增加,訓練這些模型的計算和記憶體需求也會增加。這使得在計算資源有限的單一機器上訓練這些模型變得困難甚至不可能。使用大型資料集訓練大型 DNN 的一些主要挑戰包括:訓練時間長:訓練過程可能需要數週甚至數月才能完成,具體取決於模型的複雜性和資料集的大小。記憶體限制:大型 DNN 可能需要大量記憶體來儲存訓練期間的所有模型參數、梯度和中間活化。這可能會導致記憶體不足錯誤並限制可在單一機器上訓練的