網路爬蟲是什麼

當涉及技術 SEO時,可能很難理解它是如何運作的。但重要的是要獲得盡可能多的知識來優化我們的網站並吸引更多的受眾。在搜尋引擎優化中發揮重要作用的一種工具就是網路爬蟲。

網路爬蟲(也稱為網路蜘蛛)是一種在網路上搜尋和索引內容的機器人。從本質上講,網路爬蟲負責理解網頁上的內容,以便在進行查詢時檢索它。

您可能想知道,「誰運行這些網路爬蟲?」

通常,網路爬蟲由具有自己演算法的搜尋引擎操作。演算法將告訴網路爬蟲如何找到相關資訊以回應搜尋查詢。

網路蜘蛛將搜尋(爬行)並分類網路上它可以找到並被告知要索引的所有網頁。因此,如果您不希望在搜尋引擎上找到您的網頁,您可以告訴網路爬蟲不要抓取您的網頁。

為此,您需要上傳 robots.txt 檔案。本質上,robots.txt 檔案將告訴搜尋引擎如何抓取和索引您網站上的頁面。

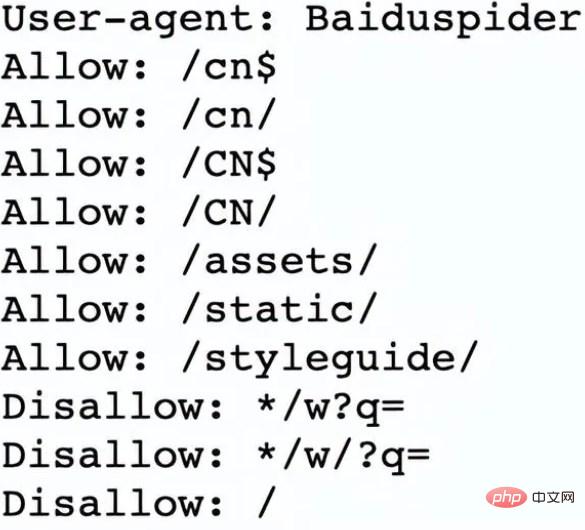

例如,讓我們看一下 Nike.com/robots.txt

Nike使用其 robots.txt 檔案來確定其網站中的哪些連結將被抓取和索引。

在檔案的這一部分中,它確定:

網路爬蟲Baiduspider被允許爬取前7個連結

網路爬蟲Baiduspider被禁止爬取其餘三個連結

這對耐吉來說是有利的,因為該公司的某些頁面不適合被搜索,並且不允許的連結不會影響其優化的頁面,這些頁面有助於他們在搜尋引擎中排名。

那麼現在我們知道什麼是網路爬蟲,它們是如何完成工作的呢?下面,讓我們回顧一下網路爬蟲的工作原理。

網路爬蟲透過發現 URL 以及檢視和分類網頁來運作。在此過程中,他們會找到指向其他網頁的超鏈接,並將它們添加到接下來要抓取的頁面列表中。網路爬蟲很聰明,可以確定每個網頁的重要性。

搜尋引擎的網路爬蟲很可能不會爬取整個網路。相反,它將根據包括多少其他頁面連結到該頁面、頁面瀏覽量甚至品牌權威等因素來決定每個網頁的重要性。因此,網路爬蟲將確定要爬取的頁面、爬取它們的順序以及它們應該多久爬取一次更新。

例如,如果您有一個新網頁,或者對現有網頁進行了更改,那麼網路爬蟲將記錄並更新索引。或者,如果您有一個新網頁,您可以要求搜尋引擎抓取您的網站。

當網路爬蟲在您的頁面上時,它會查看副本和元標記,存儲該信息,並將其編入索引以供搜尋引擎對關鍵字進行排序。

在整個過程開始之前,網路爬蟲將查看您的 robots.txt 檔案以查看要爬取哪些頁面,這就是為什麼它對技術 SEO 如此重要。

最終,當網路爬蟲抓取您的頁面時,它會決定您的頁面是否會顯示在查詢的搜尋結果頁面上。請務必注意,某些網路爬蟲的行為可能與其他爬蟲不同。例如,有些人在決定哪些網頁最需要抓取時可能會使用不同的因素。

既然我們已經了解了網路爬蟲的工作原理,我們將討論為什麼它們應該爬取您的網站。

以上是網路爬蟲是什麼的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

如何利用React和Python建立強大的網路爬蟲應用

Sep 26, 2023 pm 01:04 PM

如何利用React和Python建立強大的網路爬蟲應用

Sep 26, 2023 pm 01:04 PM

如何利用React和Python建立強大的網路爬蟲應用引言:網路爬蟲是一種自動化程序,用於透過網路抓取網頁資料。隨著網路的不斷發展和數據的爆炸性增長,網路爬蟲越來越受歡迎。本文將介紹如何利用React和Python這兩種流行的技術,建構一個強大的網路爬蟲應用。我們將探討React作為前端框架,Python作為爬蟲引擎的優勢,並提供具體的程式碼範例。一、為

如何使用PHP來寫一個簡單的網路爬蟲

Jun 14, 2023 am 08:21 AM

如何使用PHP來寫一個簡單的網路爬蟲

Jun 14, 2023 am 08:21 AM

網路爬蟲是一種自動化程序,能夠自動存取網站並抓取其中的資訊。這種技術在現今的網路世界中越來越常見,被廣泛應用於資料探勘、搜尋引擎、社群媒體分析等領域。如果你想了解如何使用PHP編寫簡單的網路爬蟲,本文將會為你提供基本的指導和建議。首先,需要了解一些基本的概念和技術。爬取目標在編寫爬蟲之前,需要選擇爬取的目標。這可以是一個特定的網站、一個特定的網頁、或整個互

使用Vue.js和Perl語言開發高效的網路爬蟲和資料抓取工具

Jul 31, 2023 pm 06:43 PM

使用Vue.js和Perl語言開發高效的網路爬蟲和資料抓取工具

Jul 31, 2023 pm 06:43 PM

使用Vue.js和Perl語言開發高效的網路爬蟲和資料抓取工具近年來,隨著網路的快速發展和資料的日益重要,網路爬蟲和資料抓取工具的需求也越來越大。在這個背景下,結合Vue.js和Perl語言開發高效率的網路爬蟲和資料抓取工具是個不錯的選擇。本文將介紹如何使用Vue.js和Perl語言開發這樣一個工具,並附上對應的程式碼範例。一、Vue.js和Perl語言的介

PHP 網路爬蟲之 HTTP 請求方法詳解

Jun 17, 2023 am 11:53 AM

PHP 網路爬蟲之 HTTP 請求方法詳解

Jun 17, 2023 am 11:53 AM

隨著網路的發展,各種各樣的數據變得越來越容易取得。而網路爬蟲作為一種獲取數據的工具,越來越受到人們的關注與重視。在網路爬蟲中,HTTP請求是一個重要的環節,本文將詳細介紹PHP網路爬蟲常見的HTTP請求方法。一、HTTP請求方法HTTP請求方法是指客戶端向伺服器傳送請求時,所使用的請求方法。常見的HTTP請求方法有GET、POST、PU

PHP中如何進行網路爬蟲和資料抓取?

May 20, 2023 pm 09:51 PM

PHP中如何進行網路爬蟲和資料抓取?

May 20, 2023 pm 09:51 PM

隨著網路時代的到來,網路資料的爬取與抓取已成為許多人的日常工作。在支援網頁開發的程式語言中,PHP以其可擴展性和易上手的特點,成為了網路爬蟲和資料抓取的熱門選項。本文將從以下幾個面向介紹PHP如何進行網路爬蟲和資料抓取。一、HTTP協定和請求實作在進行網路爬蟲和資料抓取之前,需要對HTTP協定和請求的實作有一定的了解。 HTTP協定是基於請求回應模型的,抓

PHP 簡單網頁爬蟲開發實例

Jun 13, 2023 pm 06:54 PM

PHP 簡單網頁爬蟲開發實例

Jun 13, 2023 pm 06:54 PM

隨著網路的快速發展,數據已成為了當今資訊時代最為重要的資源之一。而網路爬蟲作為一種自動化獲取和處理網路數據的技術,也越來越受到人們的關注和應用。本文將介紹如何使用PHP開發簡單的網路爬蟲,並實現自動化取得網路資料的功能。一、網路爬蟲概述網路爬蟲是一種自動化取得和處理網路資源的技術,其主要工作流程是模擬瀏覽器行為,自動存取指定的URL位址並提取所

如何使用PHP和swoole進行大規模的網路爬蟲開發?

Jul 21, 2023 am 09:09 AM

如何使用PHP和swoole進行大規模的網路爬蟲開發?

Jul 21, 2023 am 09:09 AM

如何使用PHP和swoole進行大規模的網路爬蟲開發?引言:隨著網路的快速發展,大數據已成為當今社會的重要資源之一。為了獲得這些寶貴的數據,網路爬蟲應運而生。網路爬蟲可以自動化地存取網路上的各種網站,並從中提取所需的資訊。在本文中,我們將探討如何使用PHP和swoole擴充來開發高效能的、大規模的網路爬蟲。一、了解網路爬蟲的基本原理網路爬蟲的基本原理很簡