Scrapy優化技巧:如何減少重複URL的爬取,提高效率

Scrapy是一個功能強大的Python爬蟲框架,可用於從網路上取得大量的資料。但是,在進行Scrapy開發時,經常會遇到重複URL的爬取問題,這會浪費大量的時間和資源,影響效率。本文將介紹一些Scrapy優化技巧,減少重複URL的爬取,提升Scrapy爬蟲的效率。

一、使用start_urls和allowed_domains屬性

在Scrapy爬蟲中,可以使用start_urls屬性來指定需要爬取的網址。同時,也可以使用allowed_domains屬性指定該爬蟲可以爬取的網域名稱。這兩個屬性的使用可以幫助Scrapy快速過濾掉不需要爬取的網址,在節省時間和資源的同時,提高效率。

二、使用Scrapy-Redis實現分散式爬取

當需要爬取大量URL時,單機爬取效率低下,因此可以考慮使用分散式爬取技術。 Scrapy-Redis是Scrapy的插件,透過使用Redis資料庫實現分散式爬取,提高Scrapy爬蟲的效率。透過在settings.py檔案中設定REDIS_HOST和REDIS_PORT參數,可以指定Scrapy-Redis連接的Redis資料庫的位址和連接埠號,以實現分散式爬取。

三、使用增量式爬取技術

在Scrapy爬蟲開發中,經常會遇到需要重複爬取相同網址的情況,這會造成大量的時間和資源浪費。因此,可以使用增量式爬取技術來減少重複爬取。增量式爬取技術的基本概念是:記錄爬取過的網址,在下一次爬取時,根據記錄查詢是否已經爬取過相同網址,如果已經爬取過,則跳過。透過這種方式可以減少重複URL的爬取,提高效率。

四、使用中間件過濾重複URL

除了增量式爬取技術外,還可以使用中間件過濾重複URL。 Scrapy中的中間件是一種自訂的處理器,在Scrapy爬蟲運作過程中,可以透過中間件對請求和回應進行處理。我們可以透過編寫自訂中間件來實現URL去重。其中,最常用的去重方法是使用Redis資料庫記錄已經爬取的URL列表,透過查詢該列表來判斷URL是否已經被爬取過。

五、使用DupeFilter過濾重複URL

除了自訂中間件外,Scrapy還提供了內建的去重過濾器DupeFilter,可以有效地減少重複URL的爬取。 DupeFilter會對每個URL進行雜湊處理,並在記憶體中保存不重複的雜湊值。因此,在爬取過程中,只有哈希值不同的URL才會被爬取。使用DupeFilter不需要額外的Redis伺服器支持,是一種輕量級的重複URL過濾方式。

總結:

在Scrapy爬蟲開發中,重複URL的爬取是一個常見的問題,需要透過各種最佳化技巧來減少重複URL的爬取,提高Scrapy爬蟲的效率。本文介紹了一些常見的Scrapy優化技巧,包括使用start_urls和allowed_domains屬性、使用Scrapy-Redis實現分散式爬取、使用增量式爬取技術、使用自訂中間件過濾重複URL以及使用內建的DupeFilter過濾重複URL。讀者可以依照自己的需求選擇適合的最佳化方式,提高Scrapy爬蟲的效率。

以上是Scrapy優化技巧:如何減少重複URL的爬取,提高效率的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

html和url的差別是什麼

Mar 06, 2024 pm 03:06 PM

html和url的差別是什麼

Mar 06, 2024 pm 03:06 PM

區別:1、定義不同,url是是統一資源定位符,而html是超文本標記語言;2、一個html中可以有很多個url,而一個url中只能存在一個html頁面;3、html指的是網頁,而url指的是網站位址。

深度解讀:為何Laravel速度慢如蝸牛?

Mar 07, 2024 am 09:54 AM

深度解讀:為何Laravel速度慢如蝸牛?

Mar 07, 2024 am 09:54 AM

Laravel是一款廣受歡迎的PHP開發框架,但有時候被人詬病的就是其速度慢如蝸牛。究竟是什麼原因導致了Laravel的速度不盡人意呢?本文將從多個面向深入解讀Laravel速度慢如蝸牛的原因,並結合具體的程式碼範例,幫助讀者更深入地了解此問題。 1.ORM查詢效能問題在Laravel中,ORM(物件關係映射)是一個非常強大的功能,可以讓

Golang的gc優化策略探討

Mar 06, 2024 pm 02:39 PM

Golang的gc優化策略探討

Mar 06, 2024 pm 02:39 PM

Golang的垃圾回收(GC)一直是開發者關注的熱門話題。 Golang作為一門快速的程式語言,其自帶的垃圾回收器能夠很好地管理內存,但隨著程式規模的增大,有時會出現一些效能問題。本文將探討Golang的GC最佳化策略,並提供一些具體的程式碼範例。 Golang中的垃圾回收Golang的垃圾回收器採用的是基於並發標記-清除(concurrentmark-s

C++ 程式最佳化:時間複雜度降低技巧

Jun 01, 2024 am 11:19 AM

C++ 程式最佳化:時間複雜度降低技巧

Jun 01, 2024 am 11:19 AM

時間複雜度衡量演算法執行時間與輸入規模的關係。降低C++程式時間複雜度的技巧包括:選擇合適的容器(如vector、list)以最佳化資料儲存和管理。利用高效演算法(如快速排序)以減少計算時間。消除多重運算以減少重複計算。利用條件分支以避免不必要的計算。透過使用更快的演算法(如二分搜尋)來優化線性搜尋。

解碼Laravel效能瓶頸:優化技巧全面揭秘!

Mar 06, 2024 pm 02:33 PM

解碼Laravel效能瓶頸:優化技巧全面揭秘!

Mar 06, 2024 pm 02:33 PM

解碼Laravel效能瓶頸:優化技巧全面揭秘! Laravel作為一個受歡迎的PHP框架,為開發者提供了豐富的功能和便利的開發體驗。然而,隨著專案規模增加和訪問量增加,我們可能會面臨效能瓶頸的挑戰。本文將深入探討Laravel效能最佳化的技巧,幫助開發者發現並解決潛在的效能問題。一、資料庫查詢優化使用Eloquent延遲載入在使用Eloquent查詢資料庫時,避免

Laravel效能瓶頸揭秘:優化方案大揭秘!

Mar 07, 2024 pm 01:30 PM

Laravel效能瓶頸揭秘:優化方案大揭秘!

Mar 07, 2024 pm 01:30 PM

Laravel效能瓶頸揭秘:優化方案大揭秘!隨著網路技術的發展,網站和應用程式的效能優化變得愈發重要。作為一款流行的PHP框架,Laravel在開發過程中可能會面臨效能瓶頸。本文將探討Laravel應用程式可能遇到的效能問題,並提供一些最佳化方案和具體的程式碼範例,讓開發者能夠更好地解決這些問題。一、資料庫查詢最佳化資料庫查詢是Web應用中常見的效能瓶頸之一。在

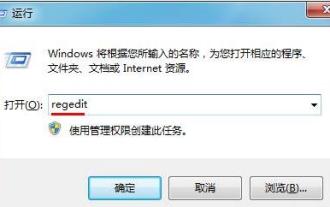

優化WIN7系統開機啟動項目的操作方法

Mar 26, 2024 pm 06:20 PM

優化WIN7系統開機啟動項目的操作方法

Mar 26, 2024 pm 06:20 PM

1.在桌面上按組合鍵(win鍵+R)開啟運行窗口,接著輸入【regedit】,回車確認。 2.開啟登錄編輯程式後,我們依序點選展開【HKEY_CURRENT_USERSoftwareMicrosoftWindowsCurrentVersionExplorer】,然後看目錄裡有沒有Serialize項,如果沒有我們可以點選右鍵Explorer,新建項,並將其命名為Serialize。 3.接著點選Serialize,然後在右邊窗格空白處點選滑鼠右鍵,新建一個DWORD(32)位元值,並將其命名為Star

如何在 Golang 中用正規表示式偵測 URL?

May 31, 2024 am 10:32 AM

如何在 Golang 中用正規表示式偵測 URL?

May 31, 2024 am 10:32 AM

使用正規表示式在Golang中偵測URL的步驟如下:使用regexp.MustCompile(pattern)編譯正規表示式模式。模式需匹配協定、主機名稱、連接埠(可選)、路徑(可選)和查詢參數(可選)。使用regexp.MatchString(pattern,url)偵測URL是否符合模式。