Scrapy的強大功能:如何實現驗證碼的辨識與處理?

Scrapy是一個強大的Python框架,可幫助我們輕鬆爬取網站上的資料。但是,當我們要爬取的網站有驗證碼時,就會遇到問題。驗證碼的目的是防止自動化爬蟲對網站進行攻擊,所以它們往往是高度複雜且難以破解的。在這篇文章中,我們將介紹如何使用Scrapy框架來識別和處理驗證碼,以讓我們的爬蟲繞過這些防禦措施。

什麼是驗證碼?

驗證碼是用來證明使用者是真實人類而不是機器的一種測試。它通常是一個混淆的文字字串或一個難以辨別的圖像,要求使用者手動輸入或選擇所顯示的內容。驗證碼旨在捕獲自動機器人和腳本,以保護網站不受惡意攻擊和濫用。

驗證碼通常有三種類型:

- 文本驗證碼:使用者需要複製和貼上一串文本,以證明他們是人類用戶而不是機器人。

- 數字驗證碼:要求使用者在輸入框中輸入顯示的數字。

- 圖片驗證碼:要求使用者在輸入框中輸入顯示的影像中的字元或數字,這通常是最難破解的類型,因為影像中的字元或數字可以是扭曲的、錯位的或具有其他視覺噪音。

為什麼需要處理驗證碼?

爬蟲通常是大規模自動化執行的,因此它們很容易被識別為機器人並被網站禁止獲取資料。驗證碼是為了防止這種情況發生而被引入的。一旦ep 進入到驗證碼階段,Scrapy爬蟲就會停下來等待使用者輸入,並因此無法繼續爬取數據,導致爬蟲的效率和完整性下降。

因此,我們需要一種方法來處理驗證碼,以便我們的爬蟲可以自動通過並繼續執行其任務。通常我們使用第三方工具或API來完成驗證碼的識別,這些工具和API使用機器學習和圖像處理演算法來識別圖像和字符,並將結果傳回給我們的程式。

如何在Scrapy中處理驗證碼?

開啟Scrapy的settings.py文件,我們需要將DOWNLOADER_MIDDLEWARES的欄位進行修改,加入以下的代理:

DOWNLOADER_MIDDLEWARES = {'scrapy.downloadermiddlewares.downloadtimeout.DownloadTimeoutMiddleware': 350,#350 ##'scrapy.contrib.downloadermiddleware.retry.RetryMiddleware': 350,'scrapy.contrib.downloadermiddleware.redirect.RedirectMiddleware': 400,

'scrapy.contrib.downloadermiddlewarewareware.cookies.C.D.基礎。下載. ownloaderStats ': 850,

'tutorial.middlewares.CaptchaMiddleware': 999}

在這個範例中,我們使用CaptchaMiddleware來處理驗證碼。 CaptchMiddleware是一個自訂的中間件類,它將處理下載請求並在需要時調用API來識別驗證碼,然後將驗證碼填入請求中並返回繼續執行。

程式碼範例:

class CaptchaMiddleware(object):

def __init__(self):

self.client = CaptchaClient()

self.max_attempts = 5

def process_request(self, request, spider):

# 如果没有设置dont_filter则默认开启

if not request.meta.get('dont_filter', False):

request.meta['dont_filter'] = True

if 'captcha' in request.meta:

# 带有验证码信息

captcha = request.meta['captcha']

request.meta.pop('captcha')

else:

# 没有验证码则获取

captcha = self.get_captcha(request.url, logger=spider.logger)

if captcha:

# 如果有验证码则添加到请求头

request = request.replace(

headers={

'Captcha-Code': captcha,

'Captcha-Type': 'math',

}

)

spider.logger.debug(f'has captcha: {captcha}')

return request

def process_response(self, request, response, spider):

# 如果没有验证码或者验证码失败则不重试

need_retry = 'Captcha-Code' in request.headers.keys()

if not need_retry:

return response

# 如果已经尝试过,则不再重试

retry_times = request.meta.get('retry_times', 0)

if retry_times >= self.max_attempts:

return response

# 验证码校验失败则重试

result = self.client.check(request.url, request.headers['Captcha-Code'])

if not result:

spider.logger.warning(f'Captcha check fail: {request.url}')

return request.replace(

meta={

'captcha': self.get_captcha(request.url, logger=spider.logger),

'retry_times': retry_times + 1,

},

dont_filter=True,

)

# 验证码校验成功则继续执行

spider.logger.debug(f'Captcha check success: {request.url}')

return response

def get_captcha(self, url, logger=None):

captcha = self.client.solve(url)

if captcha:

if logger:

logger.debug(f'get captcha [0:4]: {captcha[0:4]}')

return captcha

return None

在此中間件中,我們使用了CaptchaClient物件作為captcha解決方案中間件,我們可以使用多個個captcha解決方案中間件。

注意事項

在實作這個中間件時,請注意以下幾點:

驗證碼的識別和處理需要使用第三方工具或API,我們需要確保我們有合法的許可證並按照廠商的要求使用它們。 新增了這樣的中間件後,請求的流程會變得更加複雜,開發者需要仔細測試和偵錯以確保程式能夠正常運作。- 結論

- 透過使用Scrapy框架和驗證碼識別和處理的中間件,我們可以有效地繞過驗證碼防禦策略,實現對目標網站的有效爬取。這種方式通常比手動輸入驗證碼要省時省力,並且具有更高的效率和準確性。但是,請務必注意在使用之前閱讀並遵守第三方工具和API的許可協議和要求。

以上是Scrapy的強大功能:如何實現驗證碼的辨識與處理?的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

WIN10服務主機太佔cpu的處理操作過程

Mar 27, 2024 pm 02:41 PM

WIN10服務主機太佔cpu的處理操作過程

Mar 27, 2024 pm 02:41 PM

1.首先我們右鍵點選任務列空白處,選擇【任務管理器】選項,或右鍵開始徽標,然後再選擇【任務管理器】選項。 2.在開啟的任務管理器介面,我們點選最右邊的【服務】選項卡。 3.在開啟的【服務】選項卡,點選下方的【開啟服務】選項。 4.在開啟的【服務】窗口,右鍵點選【InternetConnectionSharing(ICS)】服務,然後選擇【屬性】選項。 5.在開啟的屬性窗口,將【開啟方式】修改為【禁用】,點選【應用程式】後點選【確定】。 6.點選開始徽標,然後點選關機按鈕,選擇【重啟】,完成電腦重啟就行了。

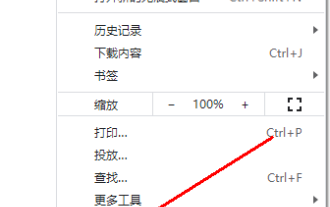

Google瀏覽器不顯示驗證碼圖片怎麼辦?chrome瀏覽器不顯示驗證碼?

Mar 13, 2024 pm 08:55 PM

Google瀏覽器不顯示驗證碼圖片怎麼辦?chrome瀏覽器不顯示驗證碼?

Mar 13, 2024 pm 08:55 PM

谷歌瀏覽器不顯示驗證碼圖片怎麼辦?在使用Google瀏覽器登入網頁有時候需要驗證碼驗證。部分使用者在使用圖片驗證碼的時候發現Google瀏覽器無法正常顯示圖片的內容。這該怎麼辦呢?下面小編帶來Google瀏覽器驗證碼不顯示處理方法介紹,希望對大家有幫助! 方法介紹 1、進入軟體,點選右上角的「更多」按鈕,選擇下方選項清單中的「設定」進入。 2、進入新介面後,點選左側的「隱私設定與安全性」選項。 3、接著點擊右側中的「網站設定&rdquo

CSV檔案操作速成指南

Dec 26, 2023 pm 02:23 PM

CSV檔案操作速成指南

Dec 26, 2023 pm 02:23 PM

快速學會開啟和處理CSV格式檔案的方法指南隨著資料分析和處理的不斷發展,CSV格式成為了廣泛使用的檔案格式之一。 CSV文件是一種簡單且易於閱讀的文字文件,其以逗號分隔不同的資料欄位。無論是在學術研究、商業分析或資料處理方面,都經常會遇到需要開啟和處理CSV檔案的情況。以下的指南將向您介紹如何快速學會開啟和處理CSV格式檔案。步驟一:了解CSV檔案格式首先,

虛擬號碼可以接收驗證碼嗎

Jan 02, 2024 am 10:22 AM

虛擬號碼可以接收驗證碼嗎

Jan 02, 2024 am 10:22 AM

虛擬號碼可以接收驗證碼,只要註冊時填寫的手機號碼符合規定,並且能夠正常接通手機號,就可以收到簡訊驗證碼。不過,使用虛擬手機號碼要注意,部分網站不支援虛擬手機號碼註冊,因此需要選擇正規的虛擬手機號碼服務商。

學習PHP中如何處理特殊字元轉換單引號

Mar 27, 2024 pm 12:39 PM

學習PHP中如何處理特殊字元轉換單引號

Mar 27, 2024 pm 12:39 PM

在PHP開發過程中,處理特殊字元是常見的問題,尤其是在字串處理中經常會遇到特殊字元轉義的情況。其中,將特殊字元轉換單引號是比較常見的需求,因為在PHP中,單引號是一種常用的字串包裹方式。在本文中,我們將介紹如何在PHP中處理特殊字元轉換單引號,並提供具體的程式碼範例。在PHP中,特殊字元包括但不限於單引號(')、雙引號(")、反斜線()等。在字串

C#開發中如何處理XML和JSON資料格式

Oct 09, 2023 pm 06:15 PM

C#開發中如何處理XML和JSON資料格式

Oct 09, 2023 pm 06:15 PM

C#開發中如何處理XML和JSON資料格式,需要具體程式碼範例在現代軟體開發中,XML和JSON是廣泛應用的兩種資料格式。 XML(可擴展標記語言)是一種用於儲存和傳輸資料的標記語言,而JSON(JavaScript物件表示)是一種輕量級的資料交換格式。在C#開發中,我們經常需要處理和操作XML和JSON數據,本文將重點放在如何使用C#處理這兩種數據格式,並附上

win7升級至win10失敗後,如何解決?

Dec 26, 2023 pm 07:49 PM

win7升級至win10失敗後,如何解決?

Dec 26, 2023 pm 07:49 PM

如果我們使用的作業系統是win7的話,對於升級的時候有的小夥伴們可能就會出現win7升win10失敗的情況。小編覺得我們可以嘗試重新升級看下能不能解決。詳細內容就來看下小編是怎麼做的吧~win7升win10失敗怎麼辦方法一:1.建議下載個驅動人生先評估下你電腦是否可以升級到Win10,2.然後升級後用驅動人生檢測下有沒有驅動異常這些,然後一鍵修復。方法二:1.刪除C:\Windows\SoftwareDistribution\Download下的所有檔案。 2.win+R運行“wuauclt.e

PHP7中的生成器:如何有效率地處理大規模資料和節省記憶體?

Oct 20, 2023 pm 04:42 PM

PHP7中的生成器:如何有效率地處理大規模資料和節省記憶體?

Oct 20, 2023 pm 04:42 PM

PHP7中的生成器:如何有效率地處理大規模資料和節省記憶體?概述:在大規模資料處理和節省記憶體方面,PHP7引入了生成器(Generators)作為一種強大的工具。生成器是PHP語言中一類特殊的函數,與普通函數不同的是,生成器可以暫停執行並傳回中間結果,而不是將所有結果一次傳回。這使得生成器非常適合處理大批量數據,降低了記憶體的使用和提高了處理效率。本文將介紹生