羊駝家族大模型集體演化! 32k上下文追平GPT-4,由田徑棟團隊出品

開源羊駝大模型LLaMA上下文追平GPT-4,只需要一個簡單改動!

Meta AI這篇剛提交的論文表示,LLaMA上下文視窗從2k擴展到32k後只需要小於1000步的微調。

與預訓練相比,成本忽略不計。

擴展上下文窗口,就意味著AI的「工作記憶」容量增加,具體來說可以:

- 支援更多輪對話,減少遺忘現象,如更穩定的角色扮演

- 輸入更多資料完成更複雜的任務,如一次處理更長文檔或多篇文檔

更重要的意義在於,所有基於LLaMA的羊駝大模型家族豈不是可以低成本採用此方法,集體進化?

羊駝是目前綜合能力最強的開源基礎模型,已經衍生出不少完全開源可商用大模型和垂直行業模型。

論文通信作者地棟也興奮地在朋友圈分享這項新進展。

基於RoPE的大模型都能用

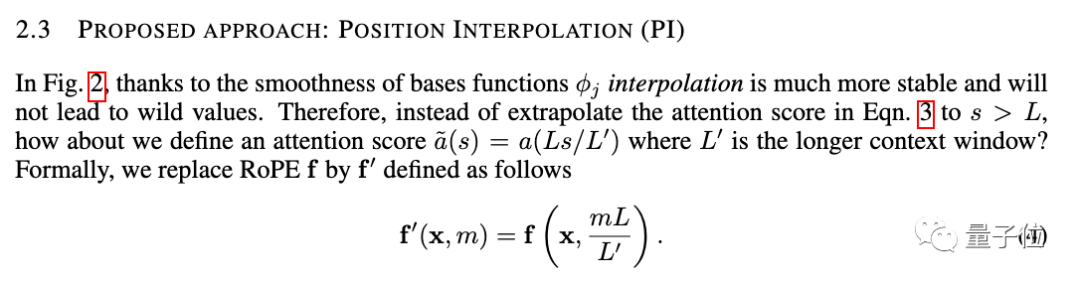

新方法名為位置插值(Position Interpolation),對使用RoPE(旋轉位置編碼)的大模型都適用。

RoPE早在2021年就由追一科技團隊提出,到現在已成為大模型最常見的位置編碼方法之一。

但在此架構下直接使用外推法(Extrapolation)擴展上下文窗口,會完全破壞自註意力機制。

具體來說,超出預訓練上下文長度之外的部分,會使模型困惑度(perplexity)飆升至和未經訓練的模型相當。

新方法改成線性地縮小位置索引,擴展前後位置索引和相對距離的範圍對齊。

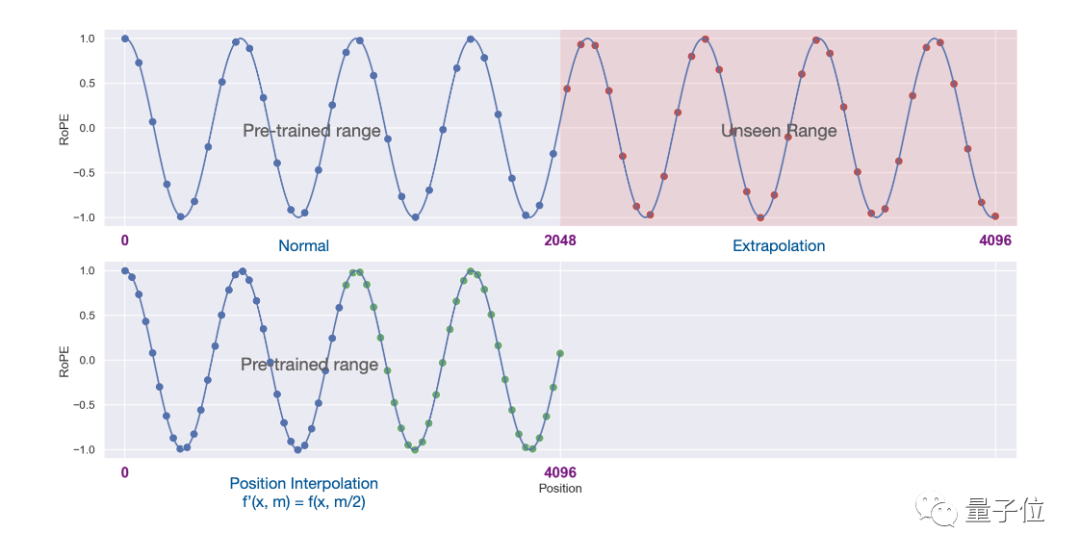

用圖形表現二者的差異更為直覺。

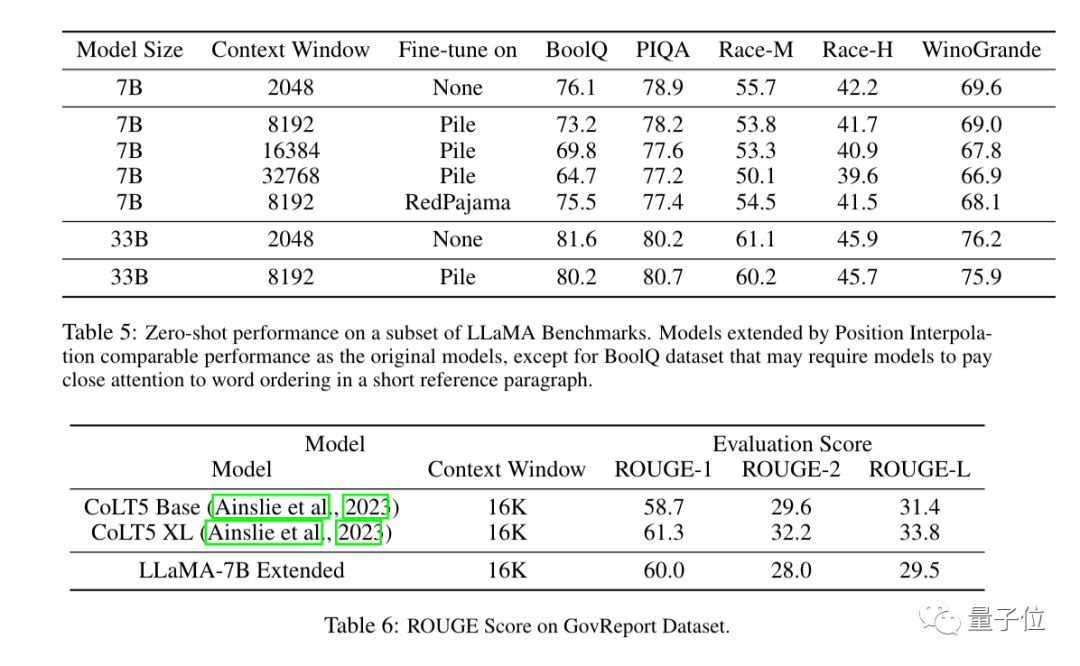

實驗結果顯示,新方法對從7B到65B的LLaMA大模型都有效。

在長序列語言建模(Long Sequence Language Modeling)、金鑰檢索(Passkey Retrieval)、長文件摘要(Long Document Summarization)中效能都沒有明顯下降。

除了實驗之外,論文附錄中也給出了新方法的詳細證明。

Three More Thing

上下文視窗曾經是開源大模型與商業大模型之間一個重要差距。

例如OpenAI的GPT-3.5最高支援16k,GPT-4支援32k,AnthropicAI的Claude更是高達100k。

同時許多開源大模型如LLaMA和Falcon還停留在2k。

現在,Meta AI的新成果直接把這一差距抹平了。

擴展上下文視窗也是近期大模型研究的焦點之一,除了位置插值方法之外,還有很多嘗試引起業界關注。

1、開發者kaiokendev在一篇技術部落格中探索了一種將LLaMa上下文視窗擴展到8k的方法。

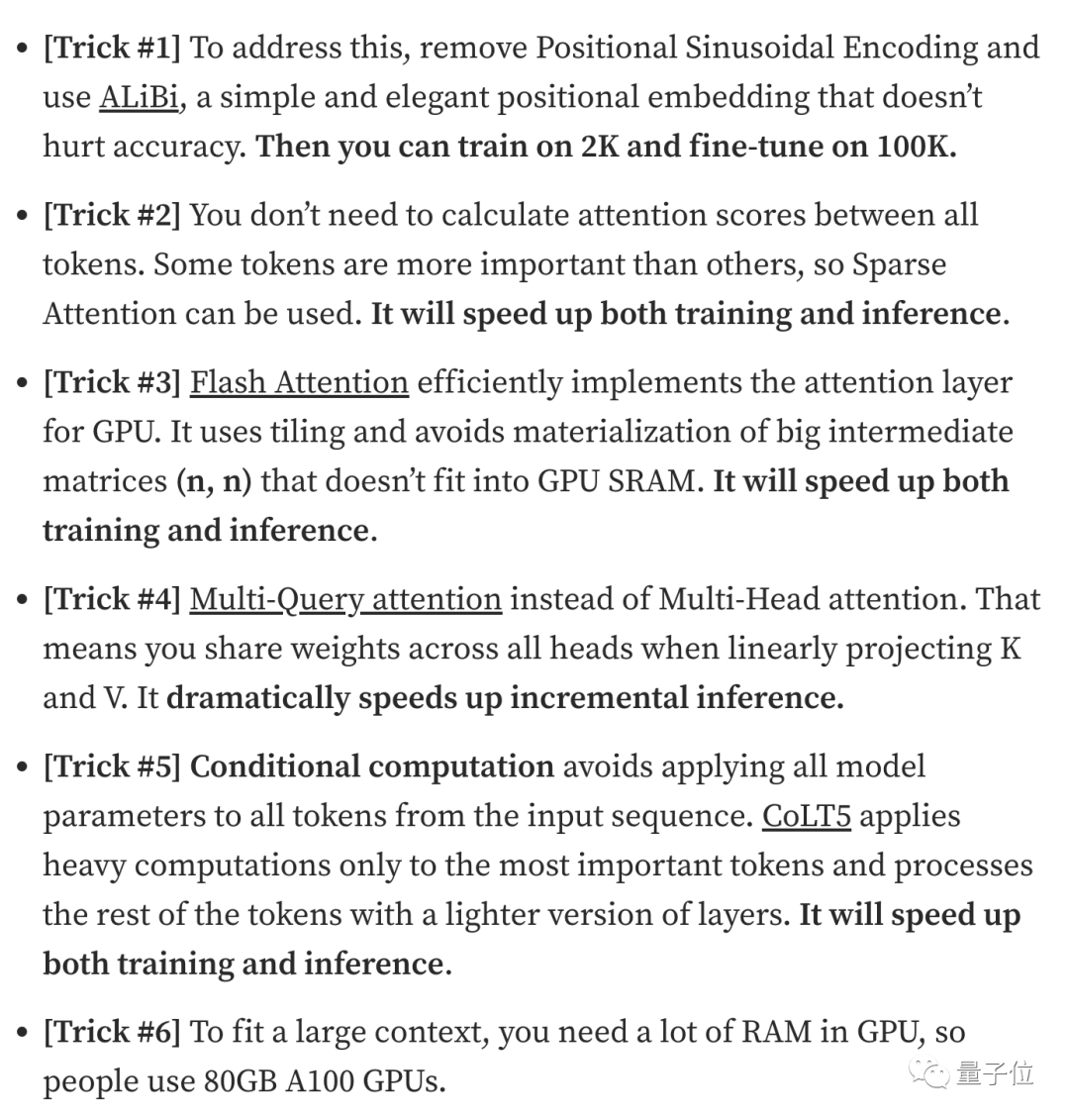

2、資料安全公司Soveren機器學習負責人Galina Alperovich在一篇文章中總結了擴展上下文視窗的6個技巧。

3、來自Mila、IBM等機構的團隊也在一篇論文中嘗試了在Transformer中完全去掉位置編碼的方法。

有需要的小夥伴可以點擊下方連結查看~

Meta論文:https://www.php.cn/link/ 0bdf2c1f053650715e1f0c725d754b96

Extending Context is Hard…but not Impossiblehttps://www.php.cn/link/9659078925b57e621eb3f9ef19773ac3

The Secret Sauce behind 100K context window在 LLMshttps://www.php.cn/link/09a630e07af043e4cae879dd60db1cac

無地點編碼論文https://www.php.cn/link/fb6c84779f12283a81d7399

以上是羊駝家族大模型集體演化! 32k上下文追平GPT-4,由田徑棟團隊出品的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

大模型App騰訊元寶上線!混元再升級,打造可隨身攜帶的全能AI助理

Jun 09, 2024 pm 10:38 PM

大模型App騰訊元寶上線!混元再升級,打造可隨身攜帶的全能AI助理

Jun 09, 2024 pm 10:38 PM

5月30日,騰訊宣布旗下混元大模型全面升級,基於混元大模型的App「騰訊元寶」正式上線,蘋果及安卓應用程式商店皆可下載。相較於先前測試階段的混元小程式版本,面向工作效率場景,騰訊元寶提供了AI搜尋、AI總結、AI寫作等核心能力;面向日常生活場景,元寶的玩法也更加豐富,提供了多個特色AI應用,並新增了創建個人智能體等玩法。 「騰訊做大模型不爭一時之先。」騰訊雲副總裁、騰訊混元大模型負責人劉煜宏表示:「過去的一年,我們持續推進騰訊混元大模型的能力爬坡,在豐富、海量的業務場景中打磨技術,同時洞察用戶的真實需求

位元組跳動豆包大模型發布,火山引擎全端 AI 服務協助企業智慧轉型

Jun 05, 2024 pm 07:59 PM

位元組跳動豆包大模型發布,火山引擎全端 AI 服務協助企業智慧轉型

Jun 05, 2024 pm 07:59 PM

火山引擎總裁譚待企業要做好大模型落地,面臨模型效果、推理成本、落地難度的三大關鍵挑戰:既要有好的基礎大模型做支撐,解決複雜難題,也要有低成本的推理服務讓大模型廣泛應用,還要更多工具、平台和應用程式幫助企業做好場景落地。 ——譚待火山引擎總裁01.豆包大模型首次亮相大使用量打磨好模型模型效果是AI落地最關鍵的挑戰。譚待指出,只有大的使用量,才能打磨出好模型。目前,豆包大模型日均處理1,200億tokens文字、生成3,000萬張圖片。為助力企業做好大模型場景落地,位元組跳動自主研發的豆包大模型將透過火山

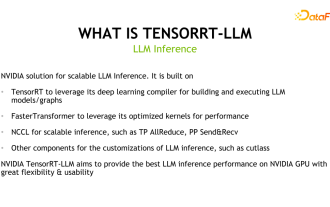

揭露NVIDIA大模型推理架構:TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

揭露NVIDIA大模型推理架構:TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

一、TensorRT-LLM的產品定位TensorRT-LLM是NVIDIA為大型語言模型(LLM)所開發的可擴展推理方案。它基於TensorRT深度學習編譯框架建構、編譯和執行計算圖,並藉鑒了FastTransformer中高效的Kernels實作。此外,它還利用NCCL實現設備間的通訊。開發者可以根據技術發展和需求差異,客製化算子以滿足特定需求,例如基於cutlass開發客製化的GEMM。 TensorRT-LLM是NVIDIA官方推理方案,致力於提供高效能並不斷完善其實用性。 TensorRT-LL

工業知識圖譜進階實戰

Jun 13, 2024 am 11:59 AM

工業知識圖譜進階實戰

Jun 13, 2024 am 11:59 AM

一、背景簡介首先來介紹雲問科技的發展歷程。雲問科技公...2023年,正是大模型盛行的時期,很多企業認為已經大模型之後圖譜的重要性大大降低了,之前研究的預置的資訊化系統也都不重要了。不過隨著RAG的推廣、資料治理的盛行,我們發現更有效率的資料治理和高品質的資料是提升私有化大模型效果的重要前提,因此越來越多的企業開始重視知識建構的相關內容。這也推動了知識的建構和加工開始向更高層次發展,其中有許多技巧和方法可以挖掘。可見一個新技術的出現,並不是將所有的舊技術打敗,也有可能將新技術和舊技術相互融合後

對標GPT-4!中國移動九天大模型通過雙備案

Apr 04, 2024 am 09:31 AM

對標GPT-4!中國移動九天大模型通過雙備案

Apr 04, 2024 am 09:31 AM

4月4日消息,日前,國家網信辦公佈已備案大模型清單,中國移動「九天自然語言交互大模型」名列其中,標誌著中國移動九天AI大模型可正式對外提供生成式人工智慧服務。中國移動表示,這是同時透過國家「生成式人工智慧服務備案」和「境內深度合成服務演算法備案」雙備案的首個央企研發的大模型。據介紹,九天自然語言交互大模型具有產業能力增強、安全可信、支援全端國產化等特點,已形成90億、139億、570億、千億等多種參數量版本,可靈活部署於雲、邊、端不同場

GPT Store都開不下去,這家國產平台怎麼敢走這條路的? ?

Apr 19, 2024 pm 09:30 PM

GPT Store都開不下去,這家國產平台怎麼敢走這條路的? ?

Apr 19, 2024 pm 09:30 PM

注意看,這個男人把超1000種大模型接入,讓你可插拔無縫切換使用。最近也上線了可視化的AI工作流程:給你一個直覺的拖放介面,拖拖、拉拉、拽拽,就能在無限畫布上編排自己個兒的Workflow。正所謂兵貴神速,量子位聽說,這個AIWorkflow上線不到48小時,就已經有用戶配出了100多個節點的個人工作流程。不賣關子,今天要聊的是LLMOps公司Dify,及其CEO張路宇。張路宇也是Dify的創辦人。投入創業前,有11年的網路經驗。搞產品設計,懂專案管理,也對SaaS有點自己的獨到見解。後來他

新測試基準發布,最強開源Llama 3尷尬了

Apr 23, 2024 pm 12:13 PM

新測試基準發布,最強開源Llama 3尷尬了

Apr 23, 2024 pm 12:13 PM

如果試題太簡單,學霸和學渣都能考90分,拉不開差距……隨著Claude3、Llama3甚至之後GPT-5等更強模型發布,業界急需一款更難、更有區分度的基準測試。大模型競技場背後組織LMSYS推出下一代基準測試Arena-Hard,引起廣泛關注。 Llama3的兩個指令微調版本實力到底如何,也有了最新參考。與先前大家分數都相近的MTBench相比,Arena-Hard區分度從22.6%提升到87.4%,孰強孰弱一目了然。 Arena-Hard利用競技場即時人類數據構建,與人類偏好一致率也高達89.1%

利用昇腾AI技术,秦岭·秦川交通大模型助力西安打造智慧交通创新中心

Oct 15, 2023 am 08:17 AM

利用昇腾AI技术,秦岭·秦川交通大模型助力西安打造智慧交通创新中心

Oct 15, 2023 am 08:17 AM

“高度复杂、碎片化程度高、跨领域”一直是交通行业数智化升级路上的首要痛点。近日,由中科视语、西安市雁塔区政府、西安未来人工智能计算中心联合打造的参数规模千亿级的“秦岭·秦川交通大模型”,面向智慧交通领域,为西安及其周边地区打造智慧交通创新支点。“秦岭·秦川交通大模型”结合西安当地海量开放场景下的交通生态数据、中科视语自研的原创先进算法以及西安未来人工智能计算中心昇腾AI的强大算力,为路网监测、应急指挥、养护管理、公众出行等智慧交通全场景带来数智化变革。交通管理在不同城市有不同的特点,不同道路的交