GoogleAudioPaLM實現「文字+音訊」雙模態解決,說聽兩用大模型

大型語言模型以其強大的性能及通用性,帶動了一批多模態的大模型開發,如音訊、視訊等。

語言模型的底層架構大多是基於Transformer,且以解碼器為主,所以無需過度調整模型架構即可適應其他序列模態。

最近,Google發布了一個統一的語音-文字模型AudioPaLM,將文字和音訊的token合併為一個多模態聯合詞彙表,再結合不同任務描述標記,可以實現在任意語音和文字的混合任務上訓練decoder-only模型,包括語音辨識(ASR)、文字轉語音合成、自動語音翻譯(AST)和語音到語音翻譯(S2ST)等,將傳統上由異質模型解決的任務統一到一個架構和訓練流程。

圖片

圖片

論文連結:https://arxiv.org/pdf/2306.12925.pdf

#範例連結:https://google-research.github.io/seanet/audiopalm/examples/

此外,由於AudioPaLM的底層架構是一個大型的Transformer模型,可以用對文本進行預先訓練的大型語言模型的權重來初始化,可以從PaLM等模型的語言學知識中受益。

從實現效果來看,AudioPaLM在AST和S2ST基準上取得了最先進的結果,並且在ASR基準上的性能也和其他模型不相上下。

透過利用AudioLM的音訊提示,AudioPaLM模型能夠對新的說話者語音遷移來執行S2ST,在語音品質和語音保存方面超過了現有的方法。

AudioPaLM模型也具有zero-shot的能力,可以對訓練中未見過的語音輸入/目標語言組合執行AST任務。

AudioPaLM

研究人員使用一個decoder-only Transformer模型對文字和語音的token進行建模,其中文字和音訊在輸入到模型之間已經進行分詞,所以輸入只是一個整數序列,在輸出端再進行反分詞(detokenized)操作回傳給使用者。

圖片

圖片

#音訊embedding及分詞

將音訊的原始波形轉換為token的過程中,包括從現有的語音表徵模型中抽取為嵌入(embedding),並將嵌入離散為一組有限的音訊token

先前的工作中從w2v-BERT模型中提取嵌入,並透過k-means將其量化,而這篇論文中,研究人員試驗了三種方案:

w2v-BERT:使用在多語言資料上訓練的w2v-BERT模型,而非純英語;並且在進行k-means聚類之前沒有進行歸一化處理,否則會導致在多語言環境中性能下降。接著以25Hz的速率產生token,詞表大小為1024

USM-v1:使用表現較強的、20億參數的通用語音模型(USM)編碼器執行類似的操作,並從中間層提取嵌入;

USM-v2:用輔助ASR損失來訓練,並進一步微調以支援多語言。

修改text-only解碼器

#在Transfomrer解碼器結構中,除了輸入和最後的softmax輸出層外,都不涉及到建模token的數量,並且在PaLM架構中,輸入和輸出矩陣的權重變數時共享的,即互為轉置。

所以只需要將嵌入矩陣的大小從(t × m)擴展到(t a)×m即可把一個純文字模型變成一個既能模擬文字又能模擬音訊的模型,其中t是文字詞表的大小,a是音訊詞表的大小,m是嵌入維度。

為了利用預訓練的文字模型,研究人員透過在嵌入矩陣中添加新的行來改變現有模型的checkpoint。

具體的實現為,前t個token對應於SentencePiece文字標記,後面a個token代表音訊標記,雖然文字嵌入式複用的預訓練權重,但音訊嵌入是全新初始化的,必須進行訓練。

實驗結果顯示,與從頭重新訓練相比,基於文字預訓練模型對語音和文字的多模態任務表現提升非常有利。

音訊token解碼為原生音訊

#為了從音訊token中合成音訊波形,研究人員試驗了兩種不同的方法:

1. 類似AudioLM模型的自迴歸解碼

2. 類似SoundStorm模型的非自回歸解碼

這兩種方法都需要先生成SoundStream token,再用卷積解碼器將其轉換為音訊波形。

研究人員在Multilingual LibriSpeech上訓練,語音條件為3秒長的語音樣本,同時表示為音訊token 和SoundStream token

#透過提供部分原始輸入語音作為語音條件,模型能夠在將說話者的語音翻譯成不同語言時保留原始說話人的語音,當原始音頻短於3秒時,透過重複播放來填充空白時間。

訓練任務

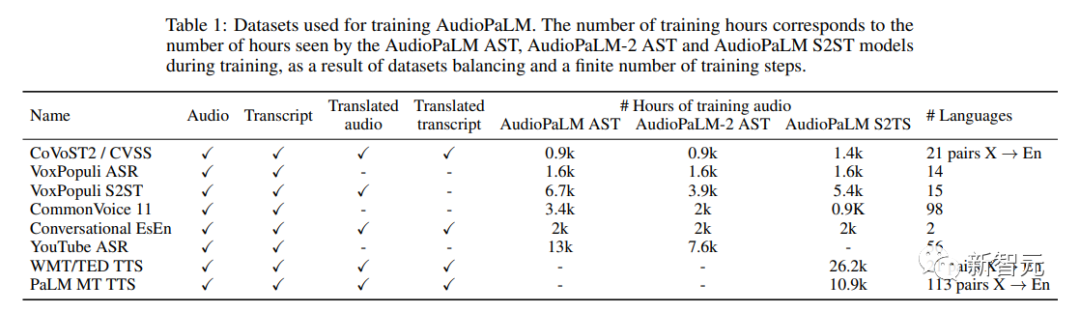

#使用到的訓練資料集皆為speech-text數據:

1. 音訊Audio:原始語言的語音(speech)

2. 轉錄Transcript:音訊資料中語音的轉錄

3. 翻譯音訊Translated Audio:音訊中語音的口語翻譯

#4. 翻譯轉錄Translated Transcript:音訊中語音的書面翻譯

組件任務包括:

1. ASR(自動語音辨識):轉錄音訊以取得轉錄文字

2. AST(自動語音翻譯):翻譯音訊以獲得翻譯後的轉錄文字

#3. S2ST(語音到語音翻譯):翻譯音訊以獲得翻譯後的音訊

4. TTS(文字轉語音):讀出轉錄的內容,以獲得音訊。

5. MT(文字到文字的機器翻譯):翻譯轉錄以獲得翻譯後的轉錄文字

一個資料集可能會用於多個任務,所以研究人員選擇向模型發出訊號,告訴模型應該對給定的輸入執行哪項任務,具體方法為:在輸入前加上一個標籤,指定任務和輸入語言的英文名稱,輸出語言也可以選擇。

例如,想要模型對法語語料進行ASR時,分詞後的音訊輸入前面要加上標籤[ASR French];要在英文中執行TTS任務,文字前面需要加上[TTS English];要執行從英語到法語的S2ST任務,分詞後的英語音頻會在前面加上[S2ST English French]

訓練混合

研究人員使用SeqIO庫對訓練資料進行混合,並對較大的資料集進行權重降低。

圖片

圖片

實驗部分

圖片

圖片

##AudioPaLM在AST和S2ST任務上超越了其他基準模型,在ASR上表現雖然不是最優,但效果也非常好。

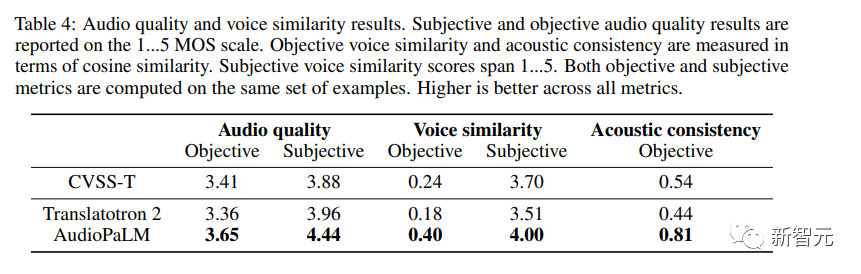

除了評估語音內容的翻譯品質外,研究人員還評估了AudioPaLM產生的語言是否品質足夠高,並且在翻譯成不同語言時能否保留說話人的聲音。

客觀指標

#使用類似無參考MOS估計器,給定一個音訊樣本,在1到5的範圍內提供一個感知音頻品質估計。

#########為了測量跨語言的語音遷移質量,研究人員使用的現成的說話人驗證模型,併計算源(用SoundStream編碼/解碼)和翻譯語音的嵌入之間的餘弦相似度;也衡量了從來源音訊到目標音訊的聲學特性(錄音條件、背景雜訊)。 ######主觀評估

研究人員進行了兩項獨立研究來評估產生的語音品質和語音相似度,兩項研究中都使用相同的樣本集合。

由於語料的品質參差不齊,有些含有響亮的重疊語音(例如,背景中播放的電視節目或歌曲)或極強的噪音(例如,衣服與麥克風摩擦),類似的失真效果使得人類評分員的工作變得複雜,因此研究人員決定透過只選擇MOS估計值至少為3.0的輸入進行預先過濾。

評分以5級量表提供,從1(品質差或完全不同的聲音)到5(品質好,相同的聲音)。

圖片

圖片

從結果可以觀察到AudioPaLM在客觀和主觀測量中,在音訊品質和語音相似度方面都明顯優於基線Translatotron 2系統,AudioPaLM比CVSS-T中的真實合成錄音具有更高的品質和更好的語音相似度,在大多數指標上有比較大提升。

研究人員也比較了高資源組和低資源組(法語、德語、西班牙語和加泰隆尼亞語與其他語言)的系統,發現這些組之間的指標沒有明顯差異。

以上是GoogleAudioPaLM實現「文字+音訊」雙模態解決,說聽兩用大模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

芝麻開門交易所網頁註冊鏈接 gate交易app註冊網址最新

Feb 28, 2025 am 11:06 AM

芝麻開門交易所網頁註冊鏈接 gate交易app註冊網址最新

Feb 28, 2025 am 11:06 AM

本文詳細介紹了芝麻開門交易所(Gate.io)網頁版和Gate交易App的註冊流程。 無論是網頁註冊還是App註冊,都需要訪問官方網站或應用商店下載正版App,然後填寫用戶名、密碼、郵箱和手機號等信息,並完成郵箱或手機驗證。

芝麻開門交易所網頁版登入口 最新版gateio官網入口

Mar 04, 2025 pm 11:48 PM

芝麻開門交易所網頁版登入口 最新版gateio官網入口

Mar 04, 2025 pm 11:48 PM

詳細介紹芝麻開門交易所網頁版登入口操作,含登錄步驟、找回密碼流程,還針對登錄失敗、無法打開頁面、收不到驗證碼等常見問題提供解決方法,助你順利登錄平台。

Bybit交易所鏈接為什麼不能直接下載安裝?

Feb 21, 2025 pm 10:57 PM

Bybit交易所鏈接為什麼不能直接下載安裝?

Feb 21, 2025 pm 10:57 PM

為什麼Bybit交易所鏈接無法直接下載安裝? Bybit是一個加密貨幣交易所,為用戶提供交易服務。該交易所的移動應用程序不能直接通過AppStore或GooglePlay下載,原因如下:1.應用商店政策限制蘋果公司和谷歌公司對應用商店中允許的應用程序類型有嚴格的要求。加密貨幣交易所應用程序通常不符合這些要求,因為它們涉及金融服務,需要遵循特定的法規和安全標準。 2.法律法規合規在許多國家/地區,與加密貨幣交易相關的活動都受到監管或限制。為了遵守這些規定,Bybit應用程序只能通過官方網站或其他授權渠

加密數字資產交易APP推薦top10(2025全球排名)

Mar 18, 2025 pm 12:15 PM

加密數字資產交易APP推薦top10(2025全球排名)

Mar 18, 2025 pm 12:15 PM

本文推荐十大值得关注的加密货币交易平台,涵盖币安(Binance)、OKX、Gate.io、BitFlyer、KuCoin、Bybit、Coinbase Pro、Kraken、BYDFi和XBIT去中心化交易所。这些平台在交易币种数量、交易类型、安全性、合规性、特色功能等方面各有千秋,例如币安以其全球最大的交易量和丰富的功能著称,而BitFlyer则凭借其日本金融厅牌照和高安全性吸引亚洲用户。选择合适的平台需要根据自身交易经验、风险承受能力和投资偏好进行综合考量。 希望本文能帮助您找到最适合自

幣安binance官網最新版登錄入口

Feb 21, 2025 pm 05:42 PM

幣安binance官網最新版登錄入口

Feb 21, 2025 pm 05:42 PM

訪問幣安官方網站最新版登錄入口,只需遵循這些簡單步驟。前往官方網址,點擊右上角的“登錄”按鈕。選擇您現有的登錄方式,如果是新用戶,請“註冊”。輸入您的註冊手機號或郵箱和密碼,並完成身份驗證(例如手機驗證碼或谷歌身份驗證器)。成功驗證後,即可訪問幣安官方網站的最新版登錄入口。

Bitget交易平台官方App下載安裝地址

Feb 25, 2025 pm 02:42 PM

Bitget交易平台官方App下載安裝地址

Feb 25, 2025 pm 02:42 PM

本指南提供了 Bitget 交易所官方 App 的詳細下載和安裝步驟,適用於安卓和 iOS 系統。指南整合了來自多個權威來源的信息,包括官網、App Store 和 Google Play,並強調了下載和賬戶管理過程中的注意事項。用戶可以從官方渠道下載 App,包括應用商店、官網 APK 下載和官網跳轉,並完成註冊、身份驗證和安全設置。此外,指南還涵蓋了常見問題和注意事項,例如

2025年Bitget最新下載地址:獲取官方App的步驟

Feb 25, 2025 pm 02:54 PM

2025年Bitget最新下載地址:獲取官方App的步驟

Feb 25, 2025 pm 02:54 PM

本指南提供了 Bitget 交易所官方 App 的詳細下載和安裝步驟,適用於安卓和 iOS 系統。指南整合了來自多個權威來源的信息,包括官網、App Store 和 Google Play,並強調了下載和賬戶管理過程中的注意事項。用戶可以從官方渠道下載 App,包括應用商店、官網 APK 下載和官網跳轉,並完成註冊、身份驗證和安全設置。此外,指南還涵蓋了常見問題和注意事項,例如