將上下文長度擴展到256k,無限上下文版本的LongLLaMA來了?

今年 2 月,Meta 發布的 LLaMA 大型語言模型系列,成功推動了開源聊天機器人的發展。因為LLaMA 比之前發布的許多大模型參數少(參數量從70 億到650 億不等),但性能更好,例如,最大的650 億參數的LLaMA 模型可以媲美谷歌的Chinchilla-70B 和PaLM-540B ,所以一發表讓很多研究者興奮不已。

然而,LLaMA 僅授權給學術界的研發人員使用,從而限制了該模型的商業應用。

因而,研究者開始尋找那些可用於商業用途的LLaMA,UC 伯克利的博士生Hao Liu 發起的計畫OpenLLaMA,就是其中一個比較熱門的LLaMA 開源複製品,其使用了與原始LLaMA 完全相同的預處理和訓練超參數,可以說OpenLLaMA 完全按照LLaMA 的訓練步驟來的。最重要的一點是,該模型可商用。

OpenLLaMA 在 Together 公司發布的 RedPajama 資料集上訓練完成,有三個模型版本,分別為 3B、7B 和 13B,這些模型都經過了 1T tokens 的訓練。結果顯示,OpenLLaMA 在多項任務中的表現都與原始 LLaMA 相當,甚至有超越的情況。

除了不斷發布新模型,研究者對模型處理 token 的能力探索不斷。

幾天前,田徑棟團隊的最新研究用不到 1000 步微調,將 LLaMA 上下文擴展到 32K。再往前追溯,GPT-4 支援 32k token(這相當於 50 頁的文字) ,Claude 可以處理 100k token (大概相當於一鍵總結《哈利波特》第一部)等等。

現在,一個新的基於 OpenLLaMA 大型語言模型來了,它將上下文的長度擴展到 256k token,甚至更多。該研究由 IDEAS NCBR 、波蘭科學院、華沙大學、 Google DeepMind 共同完成。

圖片

圖片

LongLLaMA 基於 OpenLLaMA 完成,微調方法採用 FOT ( Focused Transformer )。本文表明,FOT 可以用於對已經存在的大型模型進行微調,以擴展其上下文長度。

研究以 OpenLLaMA-3B 和 OpenLLaMA-7B 模型為起點,並使用 FOT 對它們進行微調。由此產生的模型稱之為 LONGLLAMAs,能夠在其訓練上下文長度之外進行外推(甚至可以達到 256K),並且在短上下文任務上還能保持表現。

- 計畫網址:https://github.com/CStanKonrad/long_llama

- 論文網址:https://arxiv. org/pdf/2307.03170.pdf

有人將這項研究形容為OpenLLaMA 的無限上下文版本,借助FOT,模型很容易外推到更長的序列,例如在8K token 上訓練的模型,可以輕易外推到256K 視窗大小。

圖片

圖片

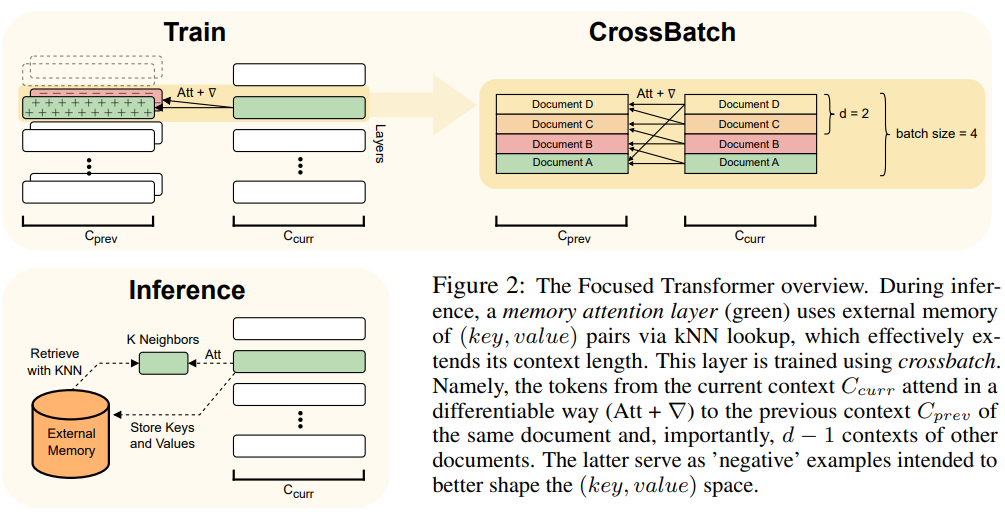

本文用到了FOT 方法,它是Transformer 模型中一種即插即用的擴展,可用來訓練新模型,也可對現有較大的模型進行更長情境微調。

為了達到這個目的,FOT 使用了記憶注意力層和跨批次(crossbatch)訓練過程:

- #記憶注意力層使模型能夠在推理時從外部記憶體中檢索訊息,從而有效地擴展了上下文;

- 跨批次訓練過程使模型傾向於學習(鍵,值)表示,這些表示對於記憶注意力層的使用非常簡單。

有關FOT 架構的概述,請參考圖2:

圖片

圖片

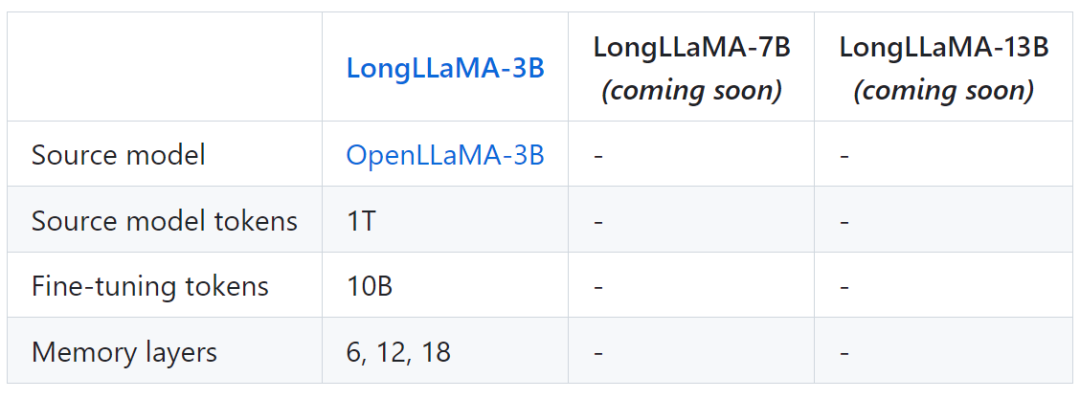

下表為LongLLaMA 的一些模型資訊:

圖片

圖片

最後,該專案也提供了LongLLaMA 與原始OpenLLaMA 模型的比較結果。

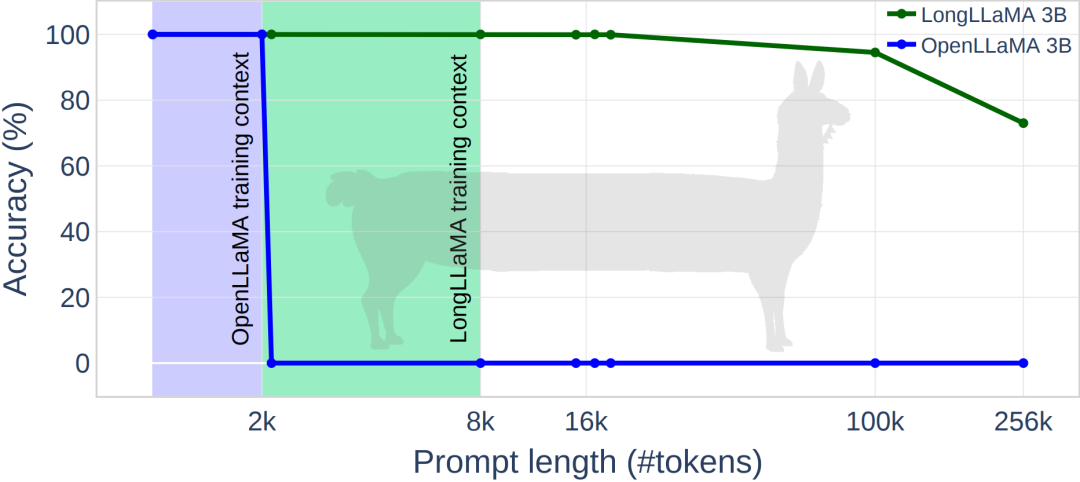

下圖為 LongLLaMA 一些實驗結果,在密碼檢索任務上,LongLLaMA 取得了良好的效能。具體而言,LongLLaMA 3B 模型遠遠超出了它的訓練上下文長度 8K,對於 token 為 100k 時,準確率達到 94.5%,當 token 為 256k 時,準確率為 73%。

圖片

圖片

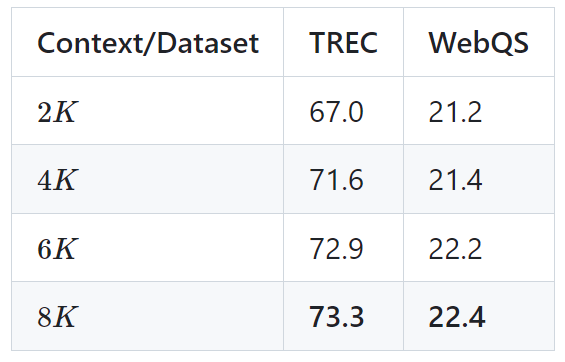

下表為LongLLaMA 3B 模型在兩個下游任務(TREC 問題分類和WebQS 問題回答)上的結果,結果顯示,在使用長上下文時,LongLLaMA 效能改進明顯。

圖片

圖片

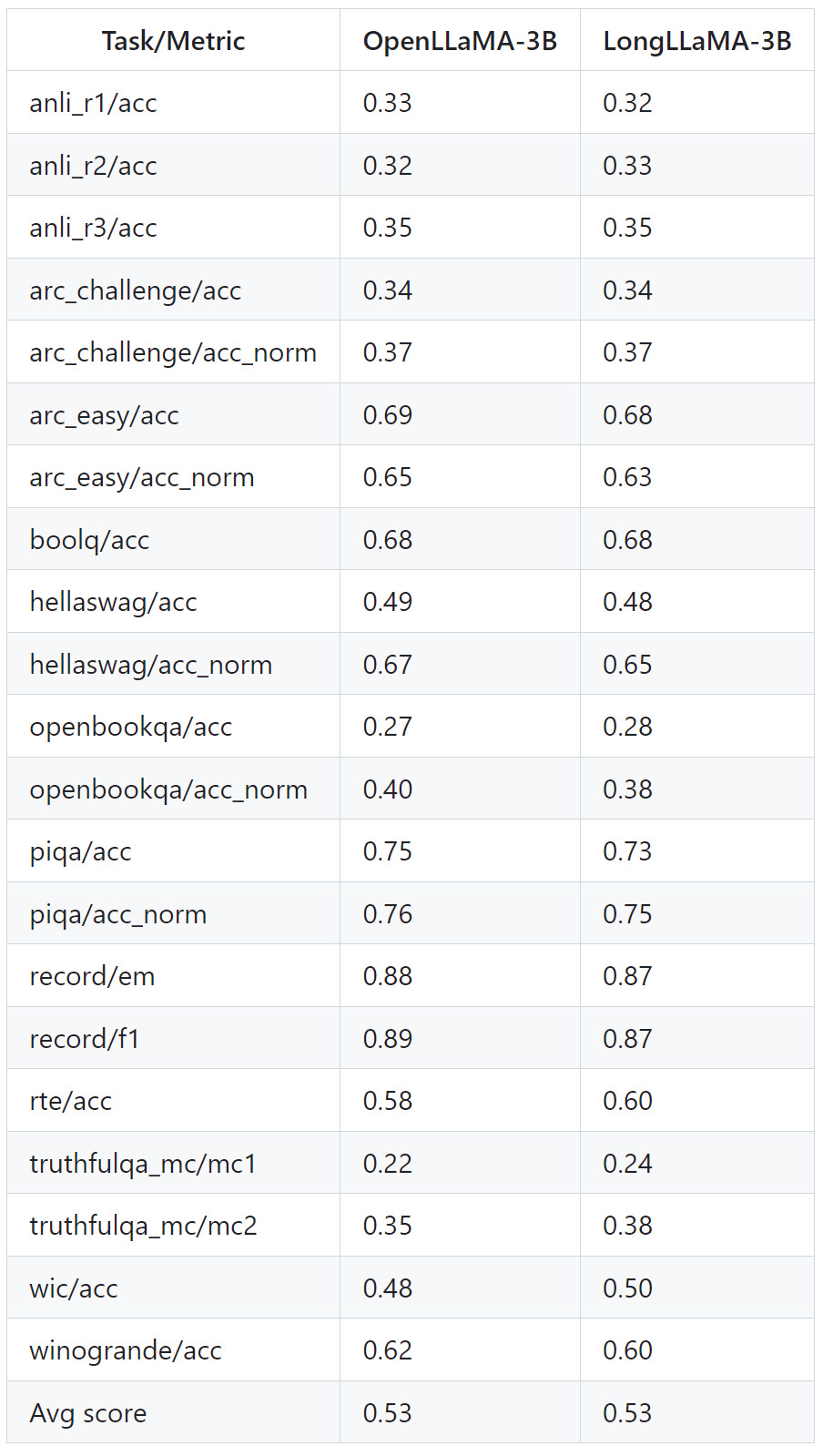

下表顯示了即使在不需要長上下文的任務上,LongLLaMA 也能表現良好。實驗在零樣本設定下,對 LongLLaMA 和 OpenLLaMA 進行了比較。

圖片

圖片

了解更多細節,可參考原文與專題。

以上是將上下文長度擴展到256k,無限上下文版本的LongLLaMA來了?的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

大宗交易的虛擬貨幣交易平台排行榜top10最新發布

Apr 22, 2025 am 08:18 AM

大宗交易的虛擬貨幣交易平台排行榜top10最新發布

Apr 22, 2025 am 08:18 AM

選擇大宗交易平台時應考慮以下因素:1. 流動性:優先選擇日均交易量超50億美元的平台。 2. 合規性:查看平台是否持有美國FinCEN、歐盟MiCA等牌照。 3. 安全性:冷錢包存儲比例和保險機制是關鍵指標。 4. 服務能力:是否提供專屬客戶經理和定制化交易工具。

數字貨幣交易所App前十名蘋果版下載入口匯總

Apr 22, 2025 am 09:27 AM

數字貨幣交易所App前十名蘋果版下載入口匯總

Apr 22, 2025 am 09:27 AM

提供各種複雜的交易工具和市場分析。覆蓋 100 多個國家,日均衍生品交易量超 300 億美元,支持 300 多個交易對與 200 倍槓桿,技術實力強大,擁有龐大的全球用戶基礎,提供專業的交易平台、安全存儲解決方案以及豐富的交易對。

排名前十的虛擬貨幣交易app有哪些 十大數字貨幣交易所平台推薦

Apr 22, 2025 pm 01:12 PM

排名前十的虛擬貨幣交易app有哪些 十大數字貨幣交易所平台推薦

Apr 22, 2025 pm 01:12 PM

2025年安全的數字貨幣交易所排名前十依次為:1. Binance,2. OKX,3. gate.io,4. Coinbase,5. Kraken,6. Huobi,7. Bitfinex,8. KuCoin,9. Bybit,10. Bitstamp,這些平台均採用了多層次的安全措施,包括冷熱錢包分離、多重簽名技術以及24/7的監控系統,確保用戶資金的安全。

穩定幣有哪些?穩定幣如何交易?

Apr 22, 2025 am 10:12 AM

穩定幣有哪些?穩定幣如何交易?

Apr 22, 2025 am 10:12 AM

常見的穩定幣有:1. 泰達幣(USDT),由Tether發行,與美元掛鉤,應用廣泛但透明性曾受質疑;2. 美元幣(USDC),由Circle和Coinbase發行,透明度高,受機構青睞;3. 戴幣(DAI),由MakerDAO發行,去中心化,DeFi領域受歡迎;4. 幣安美元(BUSD),由幣安和Paxos合作,交易和支付表現出色;5. 真實美元(TUSD),由TrustTo

目前有多少穩定幣交易所?穩定幣種類有多少?

Apr 22, 2025 am 10:09 AM

目前有多少穩定幣交易所?穩定幣種類有多少?

Apr 22, 2025 am 10:09 AM

截至2025年,穩定幣交易所數量約為千家。 1. 法定貨幣支持的穩定幣包括USDT、USDC等。 2. 加密貨幣支持的穩定幣如DAI、sUSD。 3. 算法穩定幣如TerraUSD。 4. 還有混合型穩定幣。

幣圈十大交易所有哪些 最新幣圈app推薦

Apr 24, 2025 am 11:57 AM

幣圈十大交易所有哪些 最新幣圈app推薦

Apr 24, 2025 am 11:57 AM

選擇可靠的交易所至關重要,Binance、OKX、Gate.io等十大交易所各具特色,CoinGecko、Crypto.com等新app也值得關注。

2025下一個千倍幣可能有哪些

Apr 24, 2025 pm 01:45 PM

2025下一個千倍幣可能有哪些

Apr 24, 2025 pm 01:45 PM

截至2025年4月,有七个加密货币项目被认为具有显著增长潜力:1. Filecoin(FIL)通过分布式存储网络实现快速发展;2. Aptos(APT)以高性能Layer 1公链吸引DApp开发者;3. Polygon(MATIC)提升以太坊网络性能;4. Chainlink(LINK)作为去中心化预言机网络满足智能合约需求;5. Avalanche(AVAX)以快速交易和