能抓取玻璃碎片、水下透明物,清華提出通用型透明物體抓取框架,成功率極高

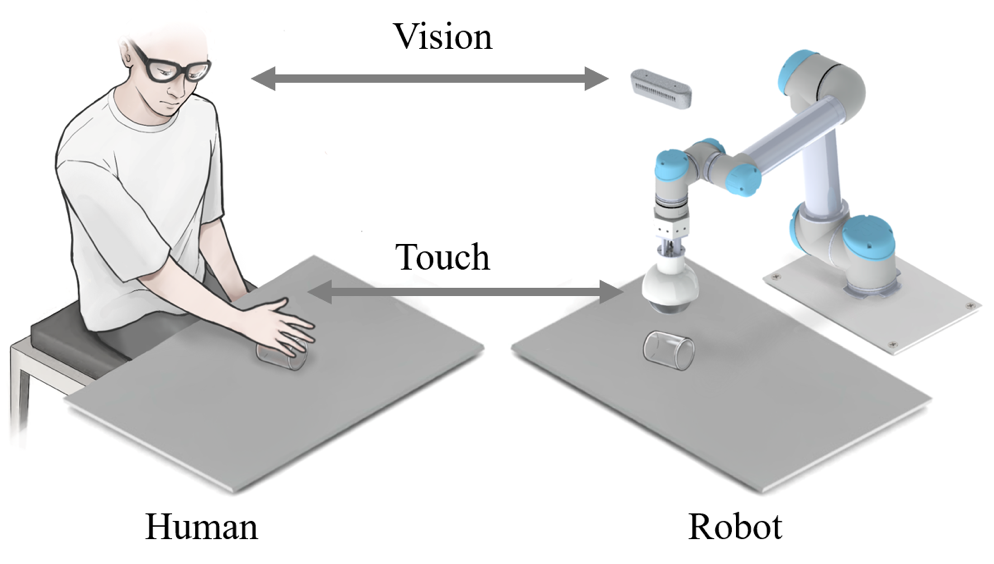

複雜環境下透明物體的感知和抓取是機器人領域和電腦視覺領域公認的難題。近日,來自清華大學深圳國際研究生院的團隊與合作者提出了一種視- 觸融合的透明物體抓取框架,該框架基於RGB 相機和帶有觸覺感知能力的機械爪TaTa, 並通過sim2real 的方式來實現透明物體的抓取位置偵測。該框架不僅可以解決玻璃碎片等不規則透明物體的抓取,還可以實現重疊、堆疊、高低不平、沙堆甚至高動態水下透明物體抓取問題。

圖片

圖片

透明物件因其美觀、簡約等特點而在生活中廣泛應用。例如廚房、商店、工廠都能見到他們的身影。雖然透明物體很常見,但對機器人而言,透明物體的抓取卻是一個非常困難的問題。其主要原因有三:

圖片

圖片

1、沒有自己的紋理屬性。透明物體表面的資訊隨著所在環境的變化而變化,所產生的紋理大都是由於光線折射、反射造成的,這就給透明物體的檢測帶來了很大的困難。

2、透明資料集的標註相比於普通物體標註具有更大的難度。在實際場景中,人類有時也不容易區分玻璃等透明物體,更不用說對透明物體的圖像進行標註。

3、透明物體表面光滑,即使抓取位置有較小偏差也可能導致抓取任務的失敗。

因此,如何利用盡可能少的成本來解決各種複雜場景下的透明物體抓取問題已經成為了透明物體研究領域非常重要的問題。近日,來自清華大學深圳國際研究生院的智能感知與機器人團隊提出了一個基於視觸融合的透明物體抓取框架,該框架模仿了人在低可見度情況下抓取物體的動作,並利用視觸融合來實現透明物體的偵測與抓取。此方法不僅具有極高的抓取成功率,還可以適應各種複雜場景下的透明物件抓取。

圖片

圖片

請看以下論文連結:https://ieeexplore.ieee.org/document/10175024

論文通訊作者、清華大學深圳國際研究生院丁文伯副教授表示:「機器人在家庭服務領域展現了巨大的應用價值,但目前的機器人大多聚焦於某一單一領域,通用型機器人抓取模型的提出將對機器人技術的推廣和應用帶來巨大的推動作用。雖然我們是以透明物體為研究對象,但該框架可以很輕鬆的推廣到生活中常見物體的抓取任務中。」

論文通訊作者、清華大學深圳國際研究生院劉厚德研究員表示:「家庭場景中的非結構化環境對機器人的實際應用帶來了極大的挑戰,我們將視覺與觸覺進行融合感知,進一步模擬了人類與外界互動時的感知過程,為複雜場景下機器人應用的穩定性提供了多方面的保障。除了將視覺與觸覺的融合,我們提出的框架也可同樣推廣到聽覺等更多的模態。」

研究現況

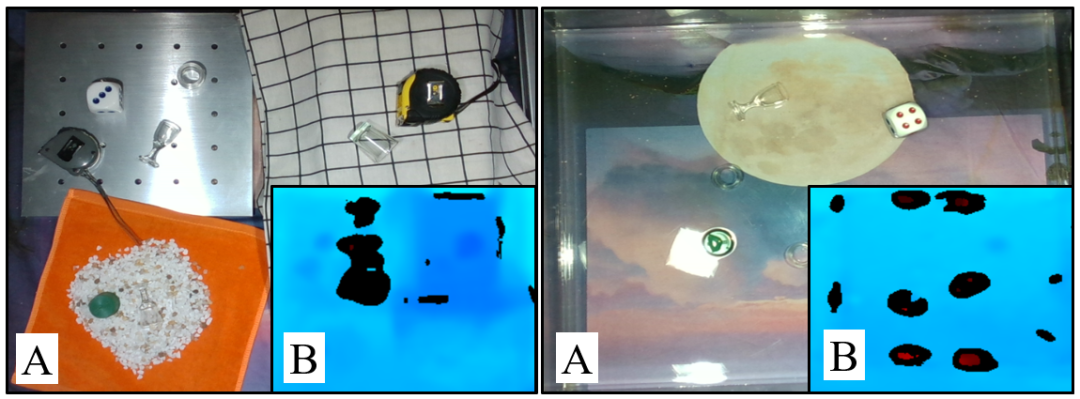

透明物體的抓取是一項具有挑戰性的任務,在抓取過程中除了需要偵測物體的位置外,還應考慮抓取位置和角度。目前對於透明物體的抓取,大部分的工作是在具有簡單背景的平面上進行的,但在實際生活中,大部分的場景都不會像我們的實驗環境那麼理想。一些特殊場景,例如玻璃碎片、堆積、重疊、起伏、沙子和水下場景,都是比較有挑戰性的。

- 首先,玻璃碎片是沒有固定模型的物體,由於其隨機多變的形狀對抓取網路和抓取工具的通用性提出了很高的要求。

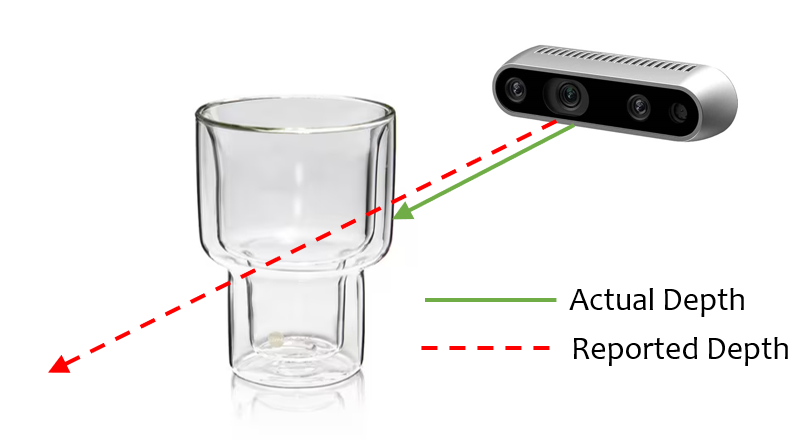

- 其次,起伏的平面的透明物體抓取也具有一定的挑戰性。如下圖所示,一方面,透明物體的深度資訊很難準確獲取,另一方面,起伏的場景有一些陰影、重疊和反射區,這給透明物體的檢測帶來了更多的挑戰。

- 第三,由於水和透明物體的光學特性相似,水下場景中的透明物體抓取也是一個挑戰。即使使用深度相機,透明物體在水中也無法準確的檢測,在不同方向的光線的照射下情況會變得更糟。

圖片

圖片

演算法設計

圖片

圖片

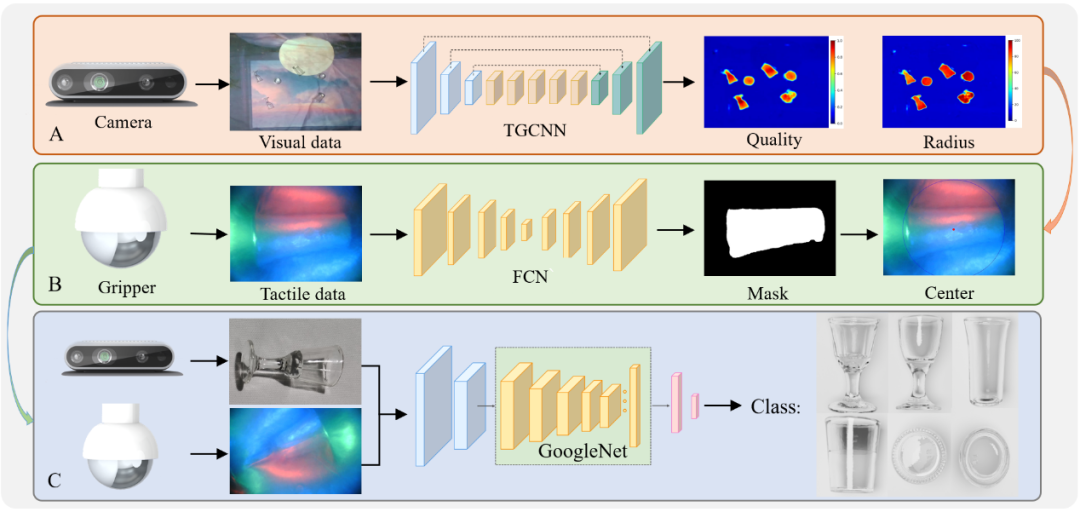

抓取演算法設計如圖所示,為了實現透明物體的抓取,我們分別提出了透明物體抓取位置偵測演算法、觸覺資訊擷取演算法和視- 觸融合分類演算法.為了降低資料集的標註成本,我們採用 Blender 製作了一個多背景透明物件抓取合成資料集 SimTrans12K,其中包含 12000 個合成影像和 160 個真實影像。除了資料集,我們還針對透明物體的獨特的光學屬性提出了一種 Gaussian-Mask 標註方法。由於我們採用 Jamming gripper 作為執行器,我們為其提出了一個專門的抓取網路 TGCNN,該網路在合成資料集訓練之後就可以獲得不錯的偵測效果。

抓取框架

我們將上述演算法進行了整合,以完成不同場景下的透明物件抓取,這構成了我們視觸融合框架的上層抓取策略。我們將一個抓取任務分解為三個子任務,分別是物體分類、抓取位置偵測和抓取高度偵測。每個子任務都可以由視覺、觸覺或視觸融合來完成。

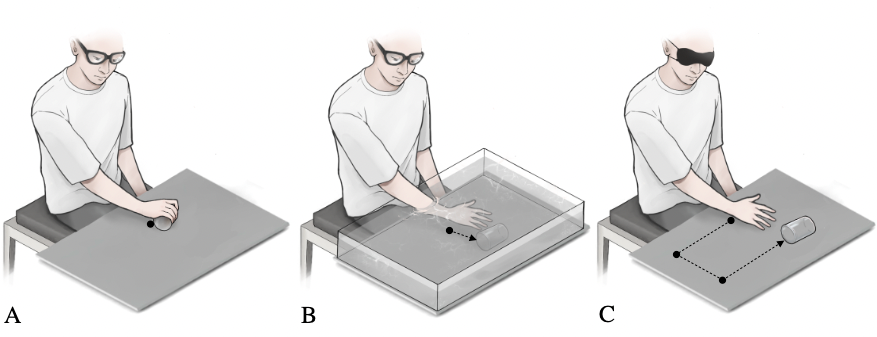

與人類抓取時的行為類似,當視覺可以直接獲得物體的精確位置時,我們可以控製手直接到達物體並完成抓取,如下圖(A)所示。當視覺無法準確地獲得物體的位置資訊時,在利用視覺估計物體的位置之後,我們會用手部的觸覺感知功能慢慢調整抓取位置,直到接觸到物體並達到適當的抓取位置,如下圖(B) 所示。對於視覺受限情況下的物體抓取,如下圖(C) 所示,我們將利用手部豐富的觸覺神經在目標可能存在的範圍內進行搜索,直到與物體發生接觸,這雖然效率很低,但卻是解決這些特殊場景下物件抓取的有效方法。

圖片

圖片

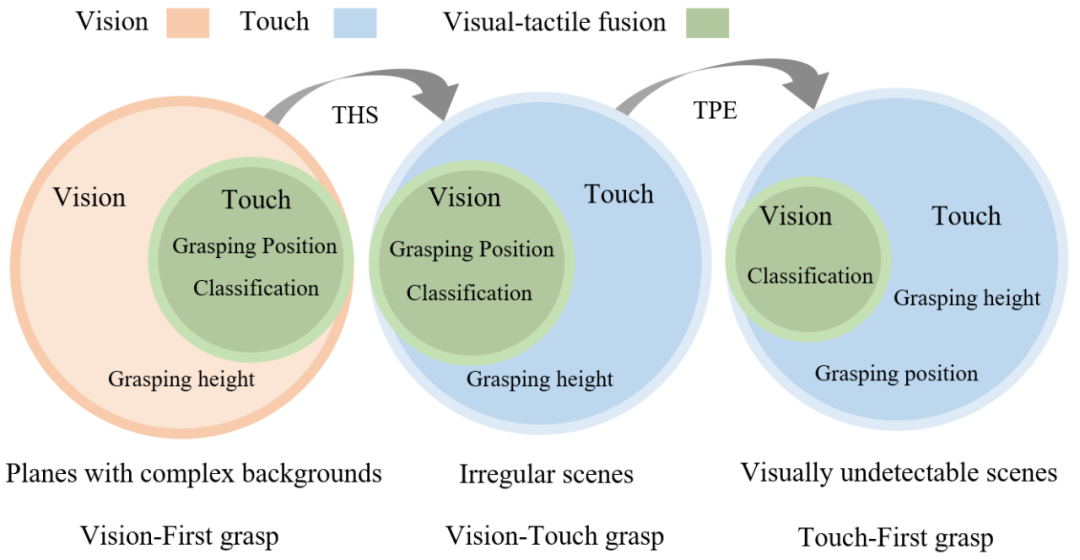

受人類抓取策略的啟發,我們將透明物體的抓取任務分為三種:具有複雜背景的平面、不規則場景和視覺無法偵測的場景,如下圖所示。在第一種類型中,視覺發揮關鍵性的作用,我們將這種場景下的抓取方式定義為視覺優先的抓取方法。在第二種類型中,視覺和觸覺可以協同工作,我們將這種場景下的抓取方式定義為視覺 - 觸覺抓取。而在最後一種類型中,視覺可能失效,觸覺在任務中成為主導,我們將這種場景下的抓取方式定義觸覺優先的抓取方法。

圖片

圖片

視覺優先的抓取方法流程如下圖所示,首先利用TGCNN 來取得抓取位置和高度,之後利用觸覺資訊抓取位置校準,最後利用視- 觸融合演算法進行分類。視 - 觸覺抓取則是在先前的基礎上加入了 THS module,該模組可以利用觸覺來獲取物體的高度。觸覺優先的抓取方法又加入了 TPE modul,可以利用觸覺來獲取透明物體的位置。

實驗驗證

為了驗證我們提出框架及演算法的有效性,我們進行了大量的驗證實驗。

首先,為了測試我們提出的透明物體資料集、註釋方法和抓取位置偵測網路的有效性,我們進行了合成資料偵測實驗和不同背景和亮度下的透明物體抓取位置檢測實驗。其次,為了驗證視覺 - 觸覺融合抓取框架的有效性,我們設計了透明物體分類抓取實驗和透明碎片抓取實驗。第三,我們設計了在不規則和視覺受限的場景中的透明物體抓取實驗,以測試加入 THS 模組和 TPE 模組後框架的有效性。

總結

為了解決偵測、抓取和分類透明物體的挑戰性問題,該研究提出了一個基於合成資料集的視覺- 觸覺融合框架。首先,使用 Blender 模擬引擎來渲染合成資料集,而不是手動註釋的資料集。

此外,使用 Gaussian-Mask 取代了傳統的二進位標註法,使抓取位置的產生更加準確。為了實現透明物體的抓取位置檢測,作者提出了一種名為TGCNN 的演算法,並進行了多次對比實驗,結果表明,即使只用合成資料集進行訓練,該演算法也能在不同的背景和照明條件下實現良好的檢測。

考慮到視覺檢測的局限性造成的抓取困難,該研究提出了一種與軟抓手TaTa 結合的觸覺校準方法,透過用觸覺資訊調整抓取位置來提高抓取成功率。與純視覺抓取相比,該方法提高了 36.7%的抓取成功率。

為了解決複雜場景中透明物體的分類問題,該研究提出了一種基於視覺- 觸覺融合的透明物體分類方法,該方法與僅基於視覺的分類相比,準確率提高了39.1%。

此外,為了實現在不規則和視覺無法檢測的場景中的透明物體抓取,該研究提出了THS 和TPE 模組,它們可以彌補在沒有視覺資訊的情況下方的透明物體抓取問題。研究者有系統地設計了大量的實驗,驗證了所提出的框架在各種疊加、重疊、起伏、沙地、水下場景等複雜場景中的有效性。研究認為,所提出的框架還可以應用於低能見度環境下的物體檢測,如煙霧和渾濁的水下,觸覺感知可以彌補視覺檢測的不足,並透過視覺 - 觸覺融合提高分類精度。

作者簡介

#視觸融合透明物體抓取專案的指導老師是丁文伯,他目前在清華大學深圳國際研究生院擔任副教授,領導智能感知與機器人研究小組。他的研究興趣主要包括訊號處理、機器學習、穿戴式裝置、柔性人機互動與機器感知。此前他本科和博士畢業於清華大學的電子工程系,並在佐治亞理工學院擔任博士後,師從王中林院士。他曾獲清華大學特等獎金、第47 屆日內瓦國際發明展金獎、IEEE Scott Helt 紀念獎、中國電子學會自然科學二等獎等眾多獎項,已在Nature Communications、Science Advances、Energy and Environmental Science、Advanced Energy Materials、IEEE TRO/RAL 等領域權威期刊發表論文70 餘篇,Google學術引用6000 餘次,授權中國和美國專利10 餘項。擔任國際訊號處理權威期刊 Digital Signal Processing 的副編輯、IEEE JSTSP 機器人感知專題的首席客座編輯,以及 IEEE 訊號處理協會 Applied Signal Processing Systems Technical Committee Member。

課題組首頁:http://ssr-group.net/。

由左至右: Shoujie Li,Haixin Yu,Houde Liu

論文的共同一作分別是Shoujie Li (清華大學博士生在讀),Haixin Yu (清華大學碩士生在讀),通訊作者為Wenbo Ding、Houde Liu,其他作者還包括Linqi Ye (上海大學)、 Chongkun Xia (清華大學)、Xueqian Wang (清華大學)、 Xiao-Ping Zhang (清華大學)。其中,Shoujie Li 主要研究方向為機器人抓取、觸覺感知以及深度學習,以第一作者在Soft Robotics、TRO、RAL、ICRA、IROS 等機器人和控制權威期刊和會議發表論文多篇,授權發明專利10餘項,獲省會級競賽獎勵10 項,相關研究成果以第一作者入選“ICRA 2022 Outstanding Mechanisms and Design Paper Finalists”,曾獲清華大學未來學者獎學金、國家獎學金等榮譽。

以上是能抓取玻璃碎片、水下透明物,清華提出通用型透明物體抓取框架,成功率極高的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

怎麼創建oracle數據庫 oracle怎麼創建數據庫

Apr 11, 2025 pm 02:33 PM

怎麼創建oracle數據庫 oracle怎麼創建數據庫

Apr 11, 2025 pm 02:33 PM

創建Oracle數據庫並非易事,需理解底層機制。 1. 需了解數據庫和Oracle DBMS的概念;2. 掌握SID、CDB(容器數據庫)、PDB(可插拔數據庫)等核心概念;3. 使用SQL*Plus創建CDB,再創建PDB,需指定大小、數據文件數、路徑等參數;4. 高級應用需調整字符集、內存等參數,並進行性能調優;5. 需注意磁盤空間、權限和參數設置,並持續監控和優化數據庫性能。 熟練掌握需不斷實踐,才能真正理解Oracle數據庫的創建和管理。

oracle數據庫怎麼創建 oracle數據庫怎麼建庫

Apr 11, 2025 pm 02:36 PM

oracle數據庫怎麼創建 oracle數據庫怎麼建庫

Apr 11, 2025 pm 02:36 PM

創建Oracle數據庫,常用方法是使用dbca圖形化工具,步驟如下:1. 使用dbca工具,設置dbName指定數據庫名;2. 設置sysPassword和systemPassword為強密碼;3. 設置characterSet和nationalCharacterSet為AL32UTF8;4. 設置memorySize和tablespaceSize根據實際需求調整;5. 指定logFile路徑。 高級方法為使用SQL命令手動創建,但更複雜易錯。 需要注意密碼強度、字符集選擇、表空間大小及內存

oracle數據庫的語句怎麼寫

Apr 11, 2025 pm 02:42 PM

oracle數據庫的語句怎麼寫

Apr 11, 2025 pm 02:42 PM

Oracle SQL語句的核心是SELECT、INSERT、UPDATE和DELETE,以及各種子句的靈活運用。理解語句背後的執行機制至關重要,如索引優化。高級用法包括子查詢、連接查詢、分析函數和PL/SQL。常見錯誤包括語法錯誤、性能問題和數據一致性問題。性能優化最佳實踐涉及使用適當的索引、避免使用SELECT *、優化WHERE子句和使用綁定變量。掌握Oracle SQL需要實踐,包括代碼編寫、調試、思考和理解底層機制。

MySQL數據表字段操作指南之添加、修改與刪除方法

Apr 11, 2025 pm 05:42 PM

MySQL數據表字段操作指南之添加、修改與刪除方法

Apr 11, 2025 pm 05:42 PM

MySQL 中字段操作指南:添加、修改和刪除字段。添加字段:ALTER TABLE table_name ADD column_name data_type [NOT NULL] [DEFAULT default_value] [PRIMARY KEY] [AUTO_INCREMENT]修改字段:ALTER TABLE table_name MODIFY column_name data_type [NOT NULL] [DEFAULT default_value] [PRIMARY KEY]

oracle數據庫表的完整性約束有哪些

Apr 11, 2025 pm 03:42 PM

oracle數據庫表的完整性約束有哪些

Apr 11, 2025 pm 03:42 PM

Oracle 數據庫的完整性約束可確保數據準確性,包括:NOT NULL:禁止空值;UNIQUE:保證唯一性,允許單個 NULL 值;PRIMARY KEY:主鍵約束,加強 UNIQUE,禁止 NULL 值;FOREIGN KEY:維護表間關係,外鍵引用主表主鍵;CHECK:根據條件限制列值。

MySQL數據庫中的嵌套查詢實例詳解

Apr 11, 2025 pm 05:48 PM

MySQL數據庫中的嵌套查詢實例詳解

Apr 11, 2025 pm 05:48 PM

嵌套查詢是一種在一個查詢中包含另一個查詢的方式,主要用於檢索滿足複雜條件、關聯多張表以及計算匯總值或統計信息的數據。實例示例包括:查找高於平均工資的僱員、查找特定類別的訂單以及計算每種產品的總訂購量。編寫嵌套查詢時,需要遵循:編寫子查詢、將其結果寫入外層查詢(使用別名或 AS 子句引用)、優化查詢性能(使用索引)。

如何配置Debian Apache日誌格式

Apr 12, 2025 pm 11:30 PM

如何配置Debian Apache日誌格式

Apr 12, 2025 pm 11:30 PM

本文介紹如何在Debian系統上自定義Apache的日誌格式。以下步驟將指導您完成配置過程:第一步:訪問Apache配置文件Debian系統的Apache主配置文件通常位於/etc/apache2/apache2.conf或/etc/apache2/httpd.conf。使用以下命令以root權限打開配置文件:sudonano/etc/apache2/apache2.conf或sudonano/etc/apache2/httpd.conf第二步:定義自定義日誌格式找到或

oracle是乾嘛的

Apr 11, 2025 pm 06:06 PM

oracle是乾嘛的

Apr 11, 2025 pm 06:06 PM

Oracle 是全球最大的數據庫管理系統(DBMS)軟件公司,其主要產品包括以下功能:關係數據庫管理系統(Oracle 數據庫)開發工具(Oracle APEX、Oracle Visual Builder)中間件(Oracle WebLogic Server、Oracle SOA Suite)雲服務(Oracle Cloud Infrastructure)分析和商業智能(Oracle Analytics Cloud、Oracle Essbase)區塊鏈(Oracle Blockchain Pla