PHP和phpSpider:如何應對大規模資料爬取的效能問題?

PHP和phpSpider:如何应对大规模数据爬取的性能问题?

随着互联网的发展和数据的普及,越来越多的公司和个人开始关注数据爬取以获取所需信息。在大规模的数据爬取任务中,性能是一个重要的考量因素。本文将介绍如何利用PHP和phpSpider应对大规模数据爬取的性能问题,并通过代码示例来说明。

1.使用多线程

在进行大规模数据爬取时,使用多线程可以显著提高程序的运行效率。通过PHP的多线程扩展(例如PHP pthreads扩展),可以在一个进程中同时执行多个爬取任务。下面是一个使用多线程的示例代码:

<?php

$urls = array(

'https://example.com/page1',

'https://example.com/page2',

'https://example.com/page3',

// 更多待爬取的URL

);

$threads = array();

// 创建线程

foreach ($urls as $url) {

$thread = new MyThread($url);

$threads[] = $thread;

$thread->start();

}

// 等待线程执行完毕

foreach ($threads as $thread) {

$thread->join();

}

class MyThread extends Thread {

private $url;

public function __construct($url) {

$this->url = $url;

}

public function run() {

// 在这里写爬取逻辑

// 使用$this->url作为爬取的URL

}

}

?>2.优化网络访问

在进行数据爬取时,网络访问是性能的瓶颈之一。为了提高网络访问的效率,可以使用curl库或者Guzzle等优秀的HTTP客户端库,来实现并行请求和连接池管理等功能。

下面的示例代码演示了如何使用Guzzle库进行多个请求的并行执行:

<?php

require 'vendor/autoload.php'; // 请确保已安装Guzzle库

use GuzzleHttpClient;

use GuzzleHttpPool;

use GuzzleHttpPsr7Request;

$urls = array(

'https://example.com/page1',

'https://example.com/page2',

'https://example.com/page3',

// 更多待爬取的URL

);

$client = new Client();

$requests = function ($urls) {

foreach ($urls as $url) {

yield new Request('GET', $url);

}

};

$pool = new Pool($client, $requests($urls), [

'concurrency' => 10, // 并发请求数量

'fulfilled' => function ($response, $index) {

// 在这里处理请求成功的响应

// $response为响应对象

},

'rejected' => function ($reason, $index) {

// 在这里处理请求失败的原因

// $reason为失败原因

},

]);

$promise = $pool->promise();

$promise->wait();

?>3.合理使用缓存

在大规模数据爬取中,往往会访问相同的URL多次。为了减少网络请求的次数和提高程序的性能,可以合理使用缓存机制(例如Memcached或Redis)来存储已经爬取过的数据。下面是一个使用Memcached作为缓存的示例代码:

<?php

$urls = array(

'https://example.com/page1',

'https://example.com/page2',

'https://example.com/page3',

// 更多待爬取的URL

);

$memcached = new Memcached();

$memcached->addServer('localhost', 11211);

foreach ($urls as $url) {

$data = $memcached->get($url);

if ($data === false) {

// 如果缓存中没有数据,则进行爬取并存入缓存

// 爬取逻辑略

$data = $result; // 假设$result为爬取得到的数据

$memcached->set($url, $data);

}

// 使用$data进行后续数据处理

}

?>通过合理的缓存使用,可以减少重复的网络请求,提升数据爬取的效率。

总结:

本文介绍了如何使用多线程、优化网络访问和合理使用缓存来应对大规模数据爬取的性能问题。代码示例展示了如何利用PHP的多线程扩展、Guzzle库和缓存机制来提高爬取效率。在实际应用中,根据具体的需求和环境,还可以采用其他方法来进一步优化性能。

以上是PHP和phpSpider:如何應對大規模資料爬取的效能問題?的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

適用於 Ubuntu 和 Debian 的 PHP 8.4 安裝和升級指南

Dec 24, 2024 pm 04:42 PM

適用於 Ubuntu 和 Debian 的 PHP 8.4 安裝和升級指南

Dec 24, 2024 pm 04:42 PM

PHP 8.4 帶來了多項新功能、安全性改進和效能改進,同時棄用和刪除了大量功能。 本指南介紹如何在 Ubuntu、Debian 或其衍生版本上安裝 PHP 8.4 或升級到 PHP 8.4

討論 CakePHP

Sep 10, 2024 pm 05:28 PM

討論 CakePHP

Sep 10, 2024 pm 05:28 PM

CakePHP 是 PHP 的開源框架。它旨在使應用程式的開發、部署和維護變得更加容易。 CakePHP 基於類似 MVC 的架構,功能強大且易於掌握。模型、視圖和控制器 gu

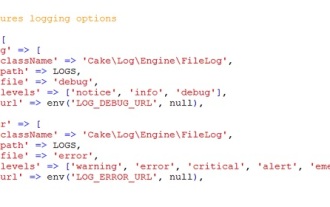

CakePHP 日誌記錄

Sep 10, 2024 pm 05:26 PM

CakePHP 日誌記錄

Sep 10, 2024 pm 05:26 PM

登入 CakePHP 是一項非常簡單的任務。您只需使用一項功能即可。您可以記錄任何後台程序(如 cronjob)的錯誤、異常、使用者活動、使用者採取的操作。在 CakePHP 中記錄資料很容易。提供了 log() 函數

如何設定 Visual Studio Code (VS Code) 進行 PHP 開發

Dec 20, 2024 am 11:31 AM

如何設定 Visual Studio Code (VS Code) 進行 PHP 開發

Dec 20, 2024 am 11:31 AM

Visual Studio Code,也稱為 VS Code,是一個免費的原始碼編輯器 - 或整合開發環境 (IDE) - 可用於所有主要作業系統。 VS Code 擁有大量針對多種程式語言的擴展,可以輕鬆編寫

CakePHP 快速指南

Sep 10, 2024 pm 05:27 PM

CakePHP 快速指南

Sep 10, 2024 pm 05:27 PM

CakePHP 是一個開源MVC 框架。它使應用程式的開發、部署和維護變得更加容易。 CakePHP 有許多函式庫可以減少大多數常見任務的過載。