手把手教你使用Flask搭建ES搜尋引擎(預備篇)

/1 前言/

Elasticsearch 是一個開源的搜尋引擎,建立在一個全文搜尋引擎庫 Apache Lucene™ 基礎之上。

那麼如何實現 #Elasticsearch

Python

/2 Python 互動/

所以,Python 也提供了可以對接 Elasticsearch的依賴函式庫。

pip install elasticsearch

#初始化連接一個 Elasticsearch 操作對象。

def __init__(self, index_type: str, index_name: str, ip="127.0.0.1"):

# self.es = Elasticsearch([ip], http_auth=('username', 'password'), port=9200)

self.es = Elasticsearch("localhost:9200")

self.index_type = index_type

self.index_name = index_name預設連接埠 9200,初始化前請確保本機已建置好 Elasticsearch的所屬環境。

根據ID 取得文件資料

def get_doc(self, uid):

return self.es.get(index=self.index_name, id=uid)插入文档数据

def insert_one(self, doc: dict):

self.es.index(index=self.index_name, doc_type=self.index_type, body=doc)

def insert_array(self, docs: list):

for doc in docs:

self.es.index(index=self.index_name, doc_type=self.index_type, body=doc)搜索文档数据

def search(self, query, count: int = 30):

dsl = {

"query": {

"multi_match": {

"query": query,

"fields": ["title", "content", "link"]

}

},

"highlight": {

"fields": {

"title": {}

}

}

}

match_data = self.es.search(index=self.index_name, body=dsl, size=count)

return match_data

def __search(self, query: dict, count: int = 20): # count: 返回的数据大小

results = []

params = {

'size': count

}

match_data = self.es.search(index=self.index_name, body=query, params=params)

for hit in match_data['hits']['hits']:

results.append(hit['_source'])

return results删除文档数据

def delete_index(self):

try:

self.es.indices.delete(index=self.index_name)

except:

pass好啊,封装 search 类也是为了方便调用,整体贴一下。

from elasticsearch import Elasticsearch

class elasticSearch():

def __init__(self, index_type: str, index_name: str, ip="127.0.0.1"):

# self.es = Elasticsearch([ip], http_auth=('elastic', 'password'), port=9200)

self.es = Elasticsearch("localhost:9200")

self.index_type = index_type

self.index_name = index_name

def create_index(self):

if self.es.indices.exists(index=self.index_name) is True:

self.es.indices.delete(index=self.index_name)

self.es.indices.create(index=self.index_name, ignore=400)

def delete_index(self):

try:

self.es.indices.delete(index=self.index_name)

except:

pass

def get_doc(self, uid):

return self.es.get(index=self.index_name, id=uid)

def insert_one(self, doc: dict):

self.es.index(index=self.index_name, doc_type=self.index_type, body=doc)

def insert_array(self, docs: list):

for doc in docs:

self.es.index(index=self.index_name, doc_type=self.index_type, body=doc)

def search(self, query, count: int = 30):

dsl = {

"query": {

"multi_match": {

"query": query,

"fields": ["title", "content", "link"]

}

},

"highlight": {

"fields": {

"title": {}

}

}

}

match_data = self.es.search(index=self.index_name, body=dsl, size=count)

return match_data尝试一下把 Mongodb 中的数据插入到 ES 中。

import json

from datetime import datetime

import pymongo

from app.elasticsearchClass import elasticSearch

client = pymongo.MongoClient('127.0.0.1', 27017)

db = client['spider']

sheet = db.get_collection('Spider').find({}, {'_id': 0, })

es = elasticSearch(index_type="spider_data",index_name="spider")

es.create_index()

for i in sheet:

data = {

'title': i["title"],

'content':i["data"],

'link': i["link"],

'create_time':datetime.now()

}

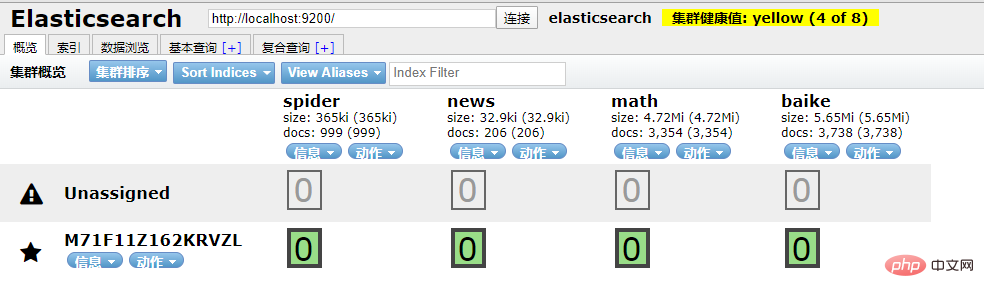

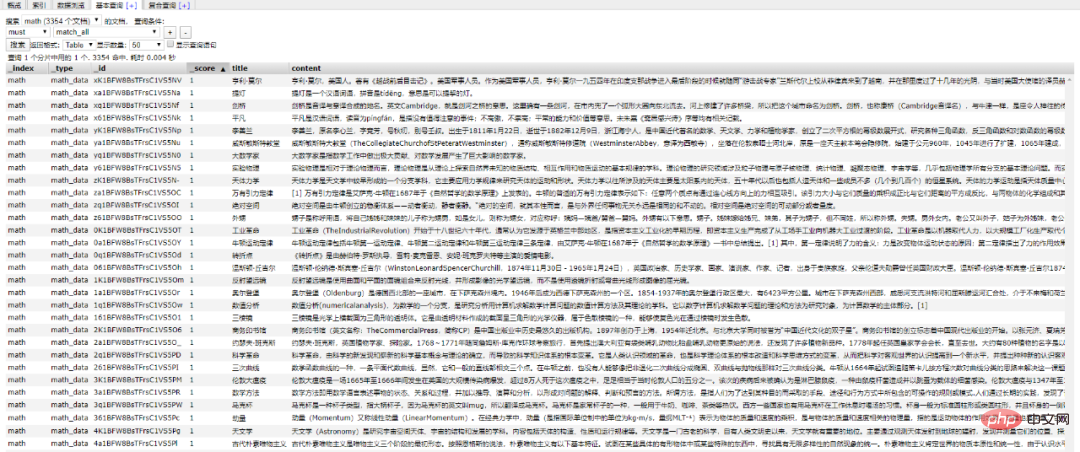

es.insert_one(doc=data)到 ES 中查看一下,启动 elasticsearch-head 插件。

如果是 npm 安装的那么 cd 到根目录之后直接 npm run start 就跑起来了。

本地访问 http://localhost:9100/

发现新加的 spider 数据文档确实已经进去了。

/3 爬虫入库/

要想实现 ES 搜索,首先要有数据支持,而海量的数据往往来自爬虫。

为了节省时间,编写一个最简单的爬虫,抓取 百度百科。

简单粗暴一点,先 递归获取 很多很多的 url 链接

import requests

import re

import time

exist_urls = []

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.62 Safari/537.36',

}

def get_link(url):

try:

response = requests.get(url=url, headers=headers)

response.encoding = 'UTF-8'

html = response.text

link_lists = re.findall('.*?<a target=_blank href="/item/([^:#=<>]*?)".*?</a>', html)

return link_lists

except Exception as e:

pass

finally:

exist_urls.append(url)

# 当爬取深度小于10层时,递归调用主函数,继续爬取第二层的所有链接

def main(start_url, depth=1):

link_lists = get_link(start_url)

if link_lists:

unique_lists = list(set(link_lists) - set(exist_urls))

for unique_url in unique_lists:

unique_url = 'https://baike.baidu.com/item/' + unique_url

with open('url.txt', 'a+') as f:

f.write(unique_url + '\n')

f.close()

if depth < 10:

main(unique_url, depth + 1)

if __name__ == '__main__':

start_url = 'https://baike.baidu.com/item/%E7%99%BE%E5%BA%A6%E7%99%BE%E7%A7%91'

main(start_url)把全部 url 存到 url.txt 文件中之后,然后启动任务。

# parse.py

from celery import Celery

import requests

from lxml import etree

import pymongo

app = Celery('tasks', broker='redis://localhost:6379/2')

client = pymongo.MongoClient('localhost',27017)

db = client['baike']

@app.task

def get_url(link):

item = {}

headers = {'User-Agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_9_2) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/34.0.1847.131 Safari/537.36'}

res = requests.get(link,headers=headers)

res.encoding = 'UTF-8'

doc = etree.HTML(res.text)

content = doc.xpath("//div[@class='lemma-summary']/div[@class='para']//text()")

print(res.status_code)

print(link,'\t','++++++++++++++++++++')

item['link'] = link

data = ''.join(content).replace(' ', '').replace('\t', '').replace('\n', '').replace('\r', '')

item['data'] = data

if db['Baike'].insert(dict(item)):

print("is OK ...")

else:

print('Fail')run.py 飞起来

from parse import get_url

def main(url):

result = get_url.delay(url)

return result

def run():

with open('./url.txt', 'r') as f:

for url in f.readlines():

main(url.strip('\n'))

if __name__ == '__main__':

run()黑窗口键入

celery -A parse worker -l info -P gevent -c 10

哦豁 !! 你居然使用了 Celery 任务队列,gevent 模式,-c 就是10个线程刷刷刷就干起来了,速度杠杠的 !!

啥?分布式? 那就加多几台机器啦,直接把代码拷贝到目标服务器,通过 redis 共享队列协同多机抓取。

这里是先将数据存储到了 MongoDB 上(个人习惯),你也可以直接存到 ES 中,但是单条单条的插入速度堪忧(接下来会讲到优化,哈哈)。

使用前面的例子将 Mongo 中的数据批量导入到 ES 中,OK !!!

到这一个简单的数据抓取就已经完毕了。

好啦,现在 ES 中已经有了数据啦,接下来就应该是 Flask web 的操作啦,当然,Django,FastAPI 也很优秀。嘿嘿,你喜欢 !!

关于FastAPI 的文章可以看这个系列文章:

1、(入门篇)简析Python web框架FastAPI——一个比Flask和Tornada更高性能的API 框架

2、(进阶篇)Python web框架FastAPI——一个比Flask和Tornada更高性能的API 框架

3、(完结篇)Python web框架FastAPI——一个比Flask和Tornada更高性能的API 框架

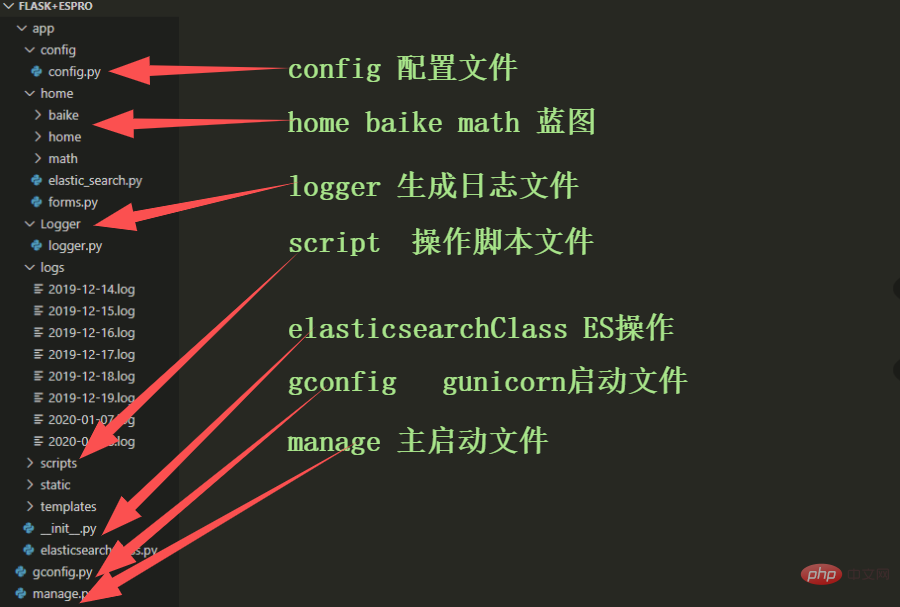

/4 Flask 项目结构/

这样一来前期工作就差不多了,接下来剩下的工作主要集中于 Flask 的实际开发中,蓄力中 !!

以上是手把手教你使用Flask搭建ES搜尋引擎(預備篇)的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

如何利用React和Flask建構簡單易用的網路應用

Sep 27, 2023 am 11:09 AM

如何利用React和Flask建構簡單易用的網路應用

Sep 27, 2023 am 11:09 AM

如何利用React和Flask建構簡單易用的網路應用引言:隨著網路的發展,網路應用的需求也越來越多樣化和複雜化。為了滿足使用者對於易用性和效能的要求,使用現代化的技術堆疊來建立網路應用變得越來越重要。 React和Flask是兩個在前端和後端開發中非常受歡迎的框架,它們可以很好的結合在一起,用來建立簡單易用的網路應用。本文將詳細介紹如何利用React和Flask

Flask和Intellij IDEA整合: Python web應用程式開發技巧(第二部分)

Jun 17, 2023 pm 01:58 PM

Flask和Intellij IDEA整合: Python web應用程式開發技巧(第二部分)

Jun 17, 2023 pm 01:58 PM

在第一部分介紹了基本的Flask和IntellijIDEA整合、專案和虛擬環境的設定、依賴安裝等方面的內容。接下來我們將繼續探討更多的Pythonweb應用程式開發技巧,建立更有效率的工作環境:使用FlaskBlueprintsFlaskBlueprints可讓您組織應用程式程式碼以便於管理和維護。 Blueprint是一個Python模組,能夠包

安裝Flask框架指南:詳細步驟可協助您正確安裝Flask

Feb 18, 2024 pm 10:51 PM

安裝Flask框架指南:詳細步驟可協助您正確安裝Flask

Feb 18, 2024 pm 10:51 PM

Flask框架安裝教學:一步步教你如何正確安裝Flask框架,需要具體程式碼範例引言:Flask是一款簡潔且靈活的PythonWeb開發框架。它易於學習、易於使用,並且具有強大的功能。本文將帶領您一步步正確地安裝Flask框架,並提供詳細的程式碼範例供參考。第一步:安裝Python在安裝Flask框架之前,首先需要確保您的電腦上安裝了Python。您可以從P

Django vs. Flask:Python Web框架的比較分析

Jan 19, 2024 am 08:36 AM

Django vs. Flask:Python Web框架的比較分析

Jan 19, 2024 am 08:36 AM

Django和Flask都是PythonWeb框架中的佼佼者,它們都有著自己的優點和適用場景。本文將對這兩個框架進行比較分析,並提供具體的程式碼範例。開發簡介Django是一個全功能的Web框架,它的主要目的是為了快速開發複雜的Web應用。 Django提供了許多內建的功能,例如ORM(物件關聯映射)、表單、認證、管理後台等。這些功能使得Django在處理大型

從頭開始,逐步引導您安裝Flask,快速建立個人博客

Feb 19, 2024 pm 04:01 PM

從頭開始,逐步引導您安裝Flask,快速建立個人博客

Feb 19, 2024 pm 04:01 PM

從零開始,手把手教你安裝Flask和快速建立個人部落格作為一個喜歡寫作的人來說,擁有個人部落格是非常重要的。而Flask作為一個輕量級的PythonWeb框架,可以幫助我們快速建立一個簡潔而功能完善的個人部落格。在本文中,我將從零開始,手把手教你如何安裝Flask並快速建立個人部落格。第一步:安裝Python和pip在開始之前,我們需要先安裝Python和pi

Flask-RESTful和Swagger: Python web應用程式中建立RESTful API的最佳實務(第二部分)

Jun 17, 2023 am 10:39 AM

Flask-RESTful和Swagger: Python web應用程式中建立RESTful API的最佳實務(第二部分)

Jun 17, 2023 am 10:39 AM

Flask-RESTful和Swagger:Pythonweb應用程式中建立RESTfulAPI的最佳實務(第二部分)在上一篇文章中,我們探討如何使用Flask-RESTful和Swagger來建立RESTfulAPI的最佳實務。我們介紹了Flask-RESTful框架的基礎知識,並展示如何使用Swagger來建立RESTfulAPI的文件。本

比較Flask應用部署的Gunicorn和uWSGI效能對比

Jan 17, 2024 am 08:52 AM

比較Flask應用部署的Gunicorn和uWSGI效能對比

Jan 17, 2024 am 08:52 AM

Flask應用部署:GunicornvsuWSGI的比較引言:Flask作為一種輕量級的PythonWeb框架,受到了許多開發者的喜愛。在將Flask應用程式部署到生產環境時,選擇適合的伺服器閘道介面(ServerGatewayInterface,簡稱SGI)是至關重要的決策。 Gunicorn和uWSGI是兩種常見的SGI伺服器,本文將對它們進行詳細的

Flask vs FastAPI: 高效開發Web API的最佳選擇

Sep 27, 2023 pm 09:01 PM

Flask vs FastAPI: 高效開發Web API的最佳選擇

Sep 27, 2023 pm 09:01 PM

FlaskvsFastAPI:高效開發WebAPI的最佳選擇引言:在現代的軟體開發中,WebAPI已經成為了不可或缺的一部分。它們能夠提供數據和服務,使得不同的應用程式之間能夠進行通訊和互通。而在選擇開發WebAPI的框架時,Flask和FastAPI是兩個備受關注的選擇。這兩個框架都非常流行,而且各有優勢。在本文中,我們將對Fl