如何透過Linux工具對大規模日誌進行分析?

如何通过Linux工具对大规模日志进行分析?

背景:

在现代互联网应用中,产生大量的日志数据是很常见的。这些日志数据包含了应用程序的运行状态、错误信息、访问记录等重要信息。对于系统管理员或开发人员来说,如何高效地对这些大规模的日志进行分析和提取有着举足轻重的意义。本文将介绍一些常用的Linux工具,并提供示例代码,帮助读者更好地理解和掌握如何在Linux平台上对大规模日志进行分析。

一、 grep

grep是Linux中非常常用的命令行工具,用于在文本中查找匹配的字符串。它的基本用法如下:

grep "关键字" 文件名

其中,关键字是你要查找的内容,文件名是你要搜索的文件名。

示例代码:

假设我们有一个包含了大量访问记录的日志文件access.log,我们可以通过下面的命令来查找其中包含特定关键字的记录:

grep "404" access.log

这会返回所有包含关键字"404"的记录。

二、 awk

awk是一种强大的文本处理工具,可以对文本进行各种操作。它的基本用法如下:

awk '{pattern + action}' 文件名其中,pattern是你要匹配的模式,action是对匹配到的文本执行的操作。

示例代码:

假设我们需要提取出access.log中的IP地址和访问时间,我们可以使用以下的awk命令:

awk '{print $1, $4}' access.log这会返回一个以空格分隔的IP地址和访问时间的列表。

三、 sed

sed是一个流编辑器,用于对文本进行各种操作。它的基本用法如下:

sed 's/匹配字符串/替换字符串/g' 文件名

其中,匹配字符串是你要替换的文本,替换字符串是你要替换成的文本。

示例代码:

假设我们需要将access.log中的所有IP地址替换为"xxx.xxx.xxx.xxx",我们可以使用以下的sed命令:

sed 's/[0-9]+.[0-9]+.[0-9]+.[0-9]+/xxx.xxx.xxx.xxx/g' access.log

这会将所有IP地址替换为"xxx.xxx.xxx.xxx"。

四、 sort

sort是一个用于排序文本的工具,它的基本用法如下:

sort 文件名

示例代码:

假设我们有一个包含了大量数字的文件numbers.txt,我们可以使用以下的sort命令对其进行排序:

sort numbers.txt

这会返回一个按照数字升序排列的列表。

五、 head和tail

head和tail是用于提取文件的前n行和后n行的工具,它们的基本用法如下:

head -n 文件名 tail -n 文件名

示例代码:

假设我们需要查看access.log的前10行和后10行,我们可以使用以下的head和tail命令:

head -n 10 access.log tail -n 10 access.log

这会返回access.log的前10行和后10行。

综上所述,通过上述介绍的grep、awk、sed、sort、head和tail等Linux工具,我们可以方便地对大规模日志进行分析和提取。当然,Linux平台还拥有更多类似工具和命令,读者可以通过进一步的研究和实践,发掘更多强大的功能,提高日志分析的效率和准确性。希望本文对读者有所帮助!

以上是如何透過Linux工具對大規模日誌進行分析?的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

如何使用MySQL資料庫進行預測和預測分析?

Jul 12, 2023 pm 08:43 PM

如何使用MySQL資料庫進行預測和預測分析?

Jul 12, 2023 pm 08:43 PM

如何使用MySQL資料庫進行預測和預測分析?概述:預測和預測分析在數據分析中扮演重要角色。 MySQL作為一種廣泛使用的關聯式資料庫管理系統,也可以用於預測和預測分析任務。本文將介紹如何使用MySQL進行預測和預測分析,並提供相關的程式碼範例。資料準備:首先,我們需要準備相關的資料。假設我們要進行銷售預測,我們需要具有銷售資料的表格。在MySQL中,我們可以使用

如何在uniapp中實現資料統計與分析

Oct 24, 2023 pm 12:37 PM

如何在uniapp中實現資料統計與分析

Oct 24, 2023 pm 12:37 PM

如何在uniapp中實現資料統計和分析一、背景介紹資料統計和分析是行動應用開發過程中非常重要的一環,透過對使用者行為的統計和分析,開發者可以深入了解使用者的喜好和使用習慣,從而優化產品設計和使用者體驗。本文將介紹如何在uniapp中實現資料統計和分析的功能,並提供一些具體的程式碼範例。二、選擇合適的資料統計和分析工具在uniapp中實現資料統計和分析的第一步是選擇合

Linux下的即時日誌監控與分析

Jul 29, 2023 am 08:06 AM

Linux下的即時日誌監控與分析

Jul 29, 2023 am 08:06 AM

Linux下的即時日誌監控與分析在日常的系統管理和故障排查中,日誌是一個非常重要的資料來源。透過對系統日誌的即時監控和分析,我們可以及時發現異常情況並進行相應的處理。本文將介紹Linux下如何進行即時日誌監控和分析,並提供對應的程式碼範例。一、即時日誌監控在Linux下,最常用的日誌系統是rsyslog。透過配置rsyslog,我們可以實現將不同應用程式的日誌

如何監控 Linux 上進程的網路使用情況

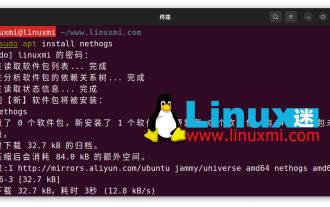

Feb 05, 2024 pm 04:45 PM

如何監控 Linux 上進程的網路使用情況

Feb 05, 2024 pm 04:45 PM

在電腦中,互聯網的存取是絕對必不可少的。然而,您可能會感興趣了解您的電腦上有哪些Linux進程正在最頻繁地使用連線。幸運的是,借助一些常見的Linux工具,監控使用頻寬的進程非常容易。以下是幾個工具的介紹:nethogsnethogs是一個類似於htop或top的程序,用於提供互聯網連接方面的CPU和記憶體使用情況。它可以快速查看哪些進程在使用網路連線。與top、htop或atop類似,nethogs是一個全螢幕程序,每隔幾秒鐘更新一次,以顯示目前進程所建立的網路連線。您可以透過套件管理器輕鬆安裝

織夢CMS二級目錄打不開的原因分析

Mar 13, 2024 pm 06:24 PM

織夢CMS二級目錄打不開的原因分析

Mar 13, 2024 pm 06:24 PM

標題:解析織夢CMS二級目錄打不開的原因及解決方案織夢CMS(DedeCMS)是一款功能強大的開源內容管理系統,被廣泛應用於各類網站建設中。然而,有時在搭建網站過程中可能會遇到二級目錄無法開啟的情況,這給網站的正常運作帶來了困擾。在本文中,我們將分析二級目錄打不開的可能原因,並提供具體的程式碼範例來解決這個問題。一、可能的原因分析:偽靜態規則配置問題:在使用

如何透過Linux工具實現日誌監控和警報?

Jul 28, 2023 pm 08:41 PM

如何透過Linux工具實現日誌監控和警報?

Jul 28, 2023 pm 08:41 PM

如何透過Linux工具實現日誌監控和警報?在日常的伺服器管理和維運過程中,即時監控和分析日誌是非常重要的。 Linux系統提供了一些強大的工具,可以幫助我們實現日誌監控和警報的功能。本文將介紹如何使用Linux工具來監控和警報日誌,並提供一些程式碼範例。使用tail指令即時查看日誌tail指令可以即時查看日誌檔案的更新內容。透過使用tail命令,我們可以在終端機窗

Python在智慧交通系統中的應用案例分析

Sep 08, 2023 am 08:13 AM

Python在智慧交通系統中的應用案例分析

Sep 08, 2023 am 08:13 AM

Python在智慧交通系統中的應用案例分析摘要:隨著智慧交通系統的快速發展,Python作為一種多功能、易於學習和使用的程式語言,被廣泛應用於智慧交通系統的開發和應用中。本文透過分析Python在智慧交通系統中的應用案例,並給出相關的程式碼範例,展示了Python在智慧交通領域的優勢和應用潛力。引言智慧交通系統是指利用現代通訊、資訊、感測等技術手段,透過對交

ThinkPHP6程式碼效能分析:定位效能瓶頸

Aug 27, 2023 pm 01:36 PM

ThinkPHP6程式碼效能分析:定位效能瓶頸

Aug 27, 2023 pm 01:36 PM

ThinkPHP6程式碼效能分析:定位效能瓶頸引言:隨著網路的快速發展,更有效率的程式碼效能分析對開發者來說變得越發重要。本文將介紹如何使用ThinkPHP6進行程式碼效能分析,以便定位並解決效能瓶頸問題。同時,我們也將透過程式碼範例來幫助讀者更好地理解。效能分析的重要性程式碼效能分析是開發過程中不可或缺的一環。透過分析程式碼的效能,我們可以了解到哪些地方消耗了大量資