以 GPU 實例示範 Alibaba Cloud Linux 3 對 AI 生態的支持

日前,Alibaba Cloud Linux 3 為使AI 開發體驗更有效率,提供了一些優化升級,本文為「Alibaba Cloud Linux 3 AI 能力介紹」系列文章預告篇,以GPU 實例為例,為大家示範Alibaba Cloud Linux 3 對AI 生態的支援。接下來也將陸續發布 2 篇系列文章,主要介紹基於 Alinux 的雲端市場鏡像為用戶提供開箱即用的 AI 基礎軟體環境,以及基於 AMD 介紹 AI 能力差異化。敬請期待。更多 Alibaba Cloud Linux 3 資訊可前往官網查看:https://www.aliyun.com/product/ecs/alinux

當在 Linux 作業系統上開發人工智慧(AI)應用程式時,研發人員可能會遇到一些挑戰,這些挑戰包括但不限於:

1. GPU 驅動程式:為了在 Linux 系統上使用 NVIDIA GPU 進行訓練或推理,需要安裝並設定正確的 NVIDIA GPU 驅動程式。由於不同的作業系統和 GPU 型號可能需要不同的驅動程序,因此可能需要一些額外的工作。

2. AI 框架編譯:在 Linux 系統上使用 AI 框架進行程式設計時,需要安裝和設定適當的編譯器和其他依賴項。這些框架通常需要進行編譯,因此需要確保正確安裝了編譯器和其他依賴項,並正確配置編譯器。

3. 軟體相容性:Linux 作業系統支援許多不同的軟體和工具,但不同版本和發行版之間可能存在相容性問題。這可能會導致某些程式無法正常運作或在某些作業系統上不可用。因此,研發人員需要了解其工作環境的軟體相容性,並進行必要的配置和修改。

4. 效能問題:AI 軟體堆疊是一個異常複雜的系統,通常需要對不同型號的 CPU 和 GPU 進行專業的最佳化,才能發揮其最佳效能。軟硬體協同的效能最佳化對於 AI 軟體堆疊來說是一個具有挑戰性的任務,需要擁有高超的技術水平和專業知識。

阿里雲第三代雲端伺服器作業系統Alibaba Cloud Linux 3(以下簡稱「Alinux 3」)是基於龍蜥作業系統Anolis OS 研發的商業版作業系統,為開發人員提供了強大的AI 開發平台,透過支援龍蜥生態repo(epao),Alinux 3 實現了對主流的nvidia GPU 和CUDA 生態的全面支持,使得AI 開發更加便捷高效。此外,Alinux 3 還支援主流的AI 框架TensorFlow/PyTorch,intel/amd 等不同CPU 平台對AI 的優化,還將引入了modelscope、huggingface 等大模型SDK 的原生支持,為開發人員提供了豐富的資源和工具。這些支持,使得 Alinux 3 成為了一個完善的 AI 開發平台,解決 AI 開發人員的痛點問題,不用一直折騰環境,讓 AI 開發體驗更容易更有效率。

Alinux 3 為開發人員提供了強大的 AI 開發平台。為了解決以上研發人員可能遇到的挑戰,Alinux 3 提供了以下幾點最佳化升級:

1. Alinux 3 透過引入龍蜥生態軟體倉庫(epao),支援開發者一鍵安裝主流NVIDIA GPU 驅動以及CUDA 加速庫,節省了開發者需要匹配驅動版本以及手動安裝的時間。

2. epao 倉庫中還提供了對主流AI 框架Tensorflow/PyTorch 的版本支持,同時安裝過程中會自動解決AI 框架的依賴問題,開發者無需進行額外編譯,即可搭配系統Python 環境進行快速開發。

3. Alinux 3 的AI 能力在提供給開發者之前,所有元件均經過相容性測試,開發者可以一鍵安裝對應的AI 能力,免去了環境配置中可能出現的系統依賴項的修改,提高了使用過程中的穩定性。

4. Alinux 3 針對 Intel/AMD 等不同平台的 CPU 進行了 AI 專門優化,更好地釋放硬體的全部性能。

5. 為了更快的適應 AIGC 產業的快速迭代,Alinux 3 還將引入對 ModelScope、HuggingFace 等大模型 SDK 的原生支持,為開發人員提供了豐富的資源和工具。

在多維度的優化加持下,使得 Alinux 3 成為一個完善的 AI 開發平台,解決了 AI 開發人員的痛點問題,讓 AI 開發體驗更容易更有效率。

以下以阿里雲 GPU 實例為例子,示範 Alinux 3 對 AI 生態的支援:

1、購買 GPU 執行個體

2、選擇 Alinux 3 映像

#3、安裝 epao repo 設定

dnf install -y anolis-epao-release

4、安裝nvidia GPU driver

#安裝 nvidia driver 之前先保證 kernel-devel 已安裝,確保 nvidia driver 安裝成功。

dnf install -y kernel-devel-$(uname-r)

安裝 nvidia driver:

dnf install -y nvidia-driver nvidia-driver-cuda

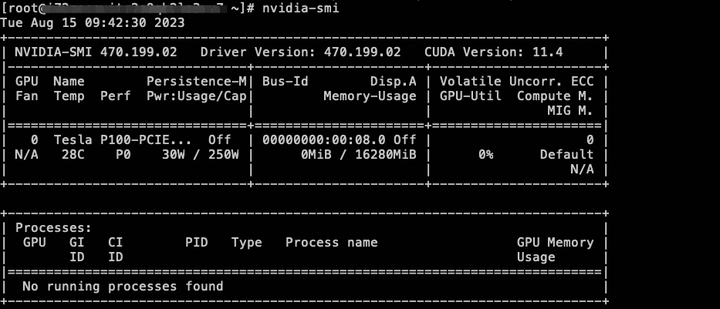

安裝完成後可以透過 nvidia-smi 指令查看 GPU 裝置狀態。

5、安裝 cuda 生態庫

dnf install -y cuda

6、 安裝 AI 框架 tensorflow/pytorch

目前提供 CPU 版的 tensorflow/pytorch,未來將支援 GPU 版的 AI 框架。

dnf install tensorflow -y dnf install pytorch -y

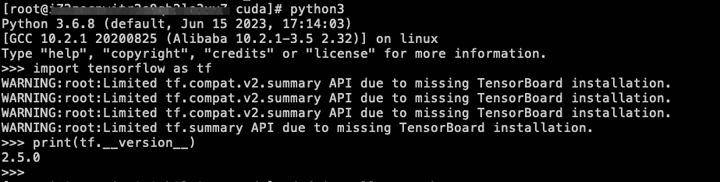

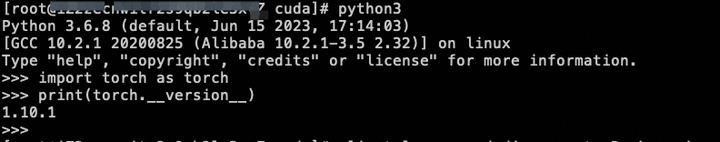

安裝完成後可透過簡單的指令查看是否安裝成功:

7、部署模型

#使用 Alinux 3 對 AI 的生態支持,可以部署 GPT-2 Large 模型來進行本文續寫任務。

安裝 Git 以及 Git LFS 方便後續下載模型。

dnf install -y git git-lfs wget

更新 pip,方便後續部署 Python 環境。

python -m pip install --upgrade pip

啟用 Git LFS 的支援。

git lfs install

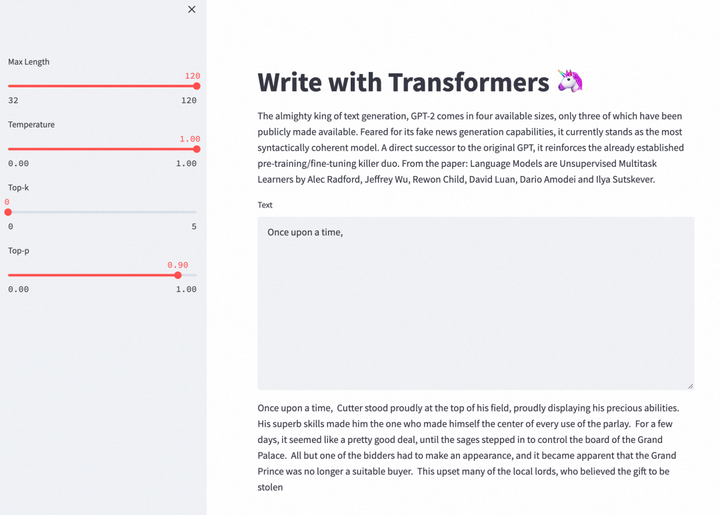

下載 write-with-transformer 專案原始碼,以及預訓練模型。 write-with-transformer 計畫是一個網頁寫作 APP,可以使用 GPT-2 大模型對寫作內容進行續寫。

git clone https://huggingface.co/spaces/merve/write-with-transformer

GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/gpt2-large

wget https://huggingface.co/gpt2-large/resolve/main/pytorch_model.bin -O gpt2-large/pytorch_model.bin

安裝 write-with-transformer 所需的依賴環境。

cd ~/write-with-transformer

pip install --ignore-installed pyyaml==5.1

pip install -r requirements.txt

環境部署完畢後,就可以執行網頁版 APP,來體驗 GPT-2 幫助完成寫作的樂趣。目前 GPT-2 只支援使用英文進行文字產生。

cd ~/write-with-transformer

sed -i 's?"gpt2-large"?"../gpt2-large"?g' app.py

sed -i '34s/10/32/;34s/30/120/' app.py

streamlit run app.py --server.port 7860

回顯訊息出現 External URL: http://

點選立即免費試用雲端產品:https://click.aliyun.com/m/1000373503/

原文連結:https://click.aliyun.com/m/1000379727/

#本文為阿里雲原創內容,未經允許不得轉載。

以上是以 GPU 實例示範 Alibaba Cloud Linux 3 對 AI 生態的支持的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

我嘗試了使用光標AI編碼的Vibe編碼,這太神奇了!

Mar 20, 2025 pm 03:34 PM

我嘗試了使用光標AI編碼的Vibe編碼,這太神奇了!

Mar 20, 2025 pm 03:34 PM

Vibe編碼通過讓我們使用自然語言而不是無盡的代碼行創建應用程序來重塑軟件開發的世界。受Andrej Karpathy等有遠見的人的啟發,這種創新的方法使Dev

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!

Mar 22, 2025 am 10:58 AM

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!

Mar 22, 2025 am 10:58 AM

2025年2月,Generative AI又是一個改變遊戲規則的月份,為我們帶來了一些最令人期待的模型升級和開創性的新功能。從Xai的Grok 3和Anthropic的Claude 3.7十四行詩到Openai的G

如何使用Yolo V12進行對象檢測?

Mar 22, 2025 am 11:07 AM

如何使用Yolo V12進行對象檢測?

Mar 22, 2025 am 11:07 AM

Yolo(您只看一次)一直是領先的實時對象檢測框架,每次迭代都在以前的版本上改善。最新版本Yolo V12引入了進步,可顯著提高準確性

最佳AI藝術生成器(免費付款)創意項目

Apr 02, 2025 pm 06:10 PM

最佳AI藝術生成器(免費付款)創意項目

Apr 02, 2025 pm 06:10 PM

本文回顧了AI最高的藝術生成器,討論了他們的功能,對創意項目的適用性和價值。它重點介紹了Midjourney是專業人士的最佳價值,並建議使用Dall-E 2進行高質量的可定製藝術。

Chatgpt 4 o可用嗎?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o可用嗎?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4當前可用並廣泛使用,與諸如ChatGpt 3.5(例如ChatGpt 3.5)相比,在理解上下文和產生連貫的響應方面取得了重大改進。未來的發展可能包括更多個性化的間

哪個AI比Chatgpt更好?

Mar 18, 2025 pm 06:05 PM

哪個AI比Chatgpt更好?

Mar 18, 2025 pm 06:05 PM

本文討論了AI模型超過Chatgpt,例如Lamda,Llama和Grok,突出了它們在準確性,理解和行業影響方面的優勢。(159個字符)

如何將Mistral OCR用於下一個抹布模型

Mar 21, 2025 am 11:11 AM

如何將Mistral OCR用於下一個抹布模型

Mar 21, 2025 am 11:11 AM

MISTRAL OCR:通過多模式文檔理解徹底改變檢索效果 檢索增強的生成(RAG)系統具有明顯高級的AI功能,從而可以訪問大量的數據存儲,以獲得更明智的響應

最佳AI聊天機器人比較(Chatgpt,Gemini,Claude&更多)

Apr 02, 2025 pm 06:09 PM

最佳AI聊天機器人比較(Chatgpt,Gemini,Claude&更多)

Apr 02, 2025 pm 06:09 PM

本文比較了諸如Chatgpt,Gemini和Claude之類的頂級AI聊天機器人,重點介紹了其獨特功能,自定義選項以及自然語言處理和可靠性的性能。