UniOcc:將以視覺為中心的佔用預測與幾何和語義渲染大一統!

原标题: UniOcc: Unifying Vision-Centric 3D Occupancy Prediction with Geometric and Semantic Rendering

请点击以下链接查看论文:https://arxiv.org/pdf/2306.09117.pdf

论文思路:

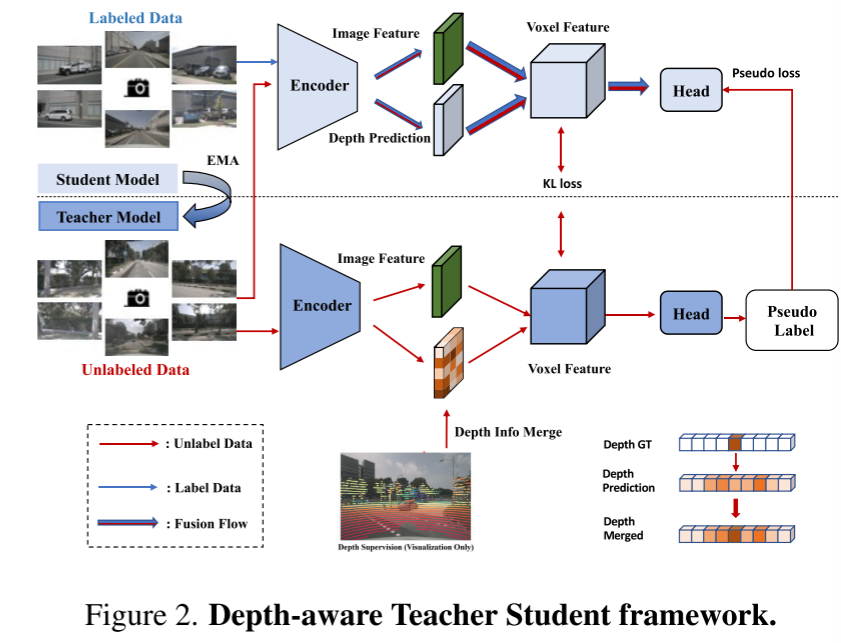

在这篇技术报告中,我们提出了一个名为UniOCC的解决方案,用于在CVPR 2023 nuScenes Open Dataset Challenge中进行以视觉为中心的3D占用预测轨迹。现有的占用预测方法主要专注于使用三维占用标签来优化三维体积空间的投影特征。然而,这些标签的生成过程非常复杂和昂贵(依赖于3D语义标注),并且受到体素分辨率的限制,无法提供细粒度的空间语义。为了解决这个限制,我们提出了一种新的统一占用(UniOcc)预测方法,明确施加空间几何约束,并通过体射线渲染(volume ray rendering)来补充细粒度的语义监督。我们的方法显著提高了模型的性能,并展示了在降低人工标注成本方面的良好潜力。考虑到标注3D占用的费力性,我们进一步提出了深度感知的Teacher Student(DTS)框架,以提高使用无标记数据的预测精度。我们的解决方案在官方单模型排行榜上获得了51.27%的mIoU,在本次挑战赛中排名第三

网络设计:

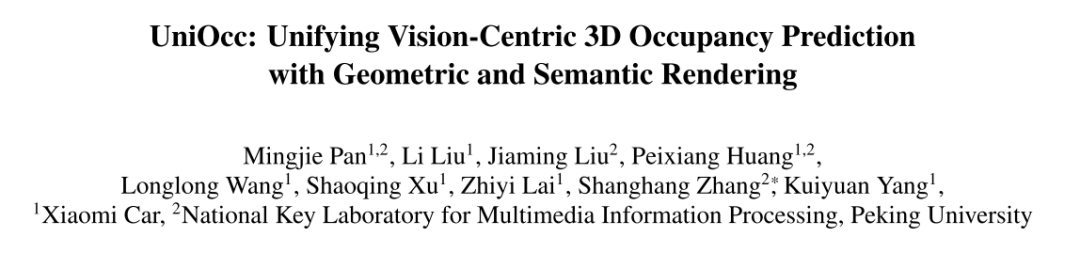

在这一挑战中,本文提出了UniOcc,这是一种利用体渲染(volume rendering)来统一二维和三维表示监督的通用解决方案,改进了多摄像机占用预测模型。本文没有设计新的模型架构,而是将重点放在以通用和即插即用的方式增强现有模型[3,18,20]上。

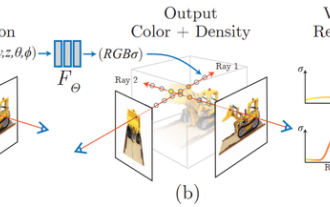

重新写作如下:本文通过将表示提升到NeRF-style表示[1,15,21],实现了使用体渲染(volume rendering)生成2D语义和深度地图的功能。这使得本文能够在2D像素级别上进行细粒度的监督。通过对三维体素进行射线采样,可以获取渲染的二维像素语义和深度信息。通过显式地集成几何遮挡关系和语义一致性约束,本文提供了模型的显式指导,并确保遵守这些约束

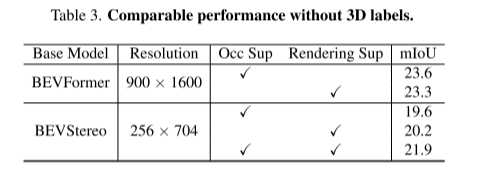

值得一提的是,UniOcc有潜力减少对昂贵的3D语义标注的依赖。在没有3D占用标签的情况下,仅使用本文的体渲染(volume rendering)监督进行训练的模型,甚至比使用3D标签监督进行训练的模型表现更好。这突出了减少对昂贵的3D语义标注的依赖的令人兴奋的潜力,因为场景表示可以直接从负担得起的2D分割标签学习。此外,利用SAM[6]和[14,19]等先进技术,还可以进一步降低二维分割标注的成本。

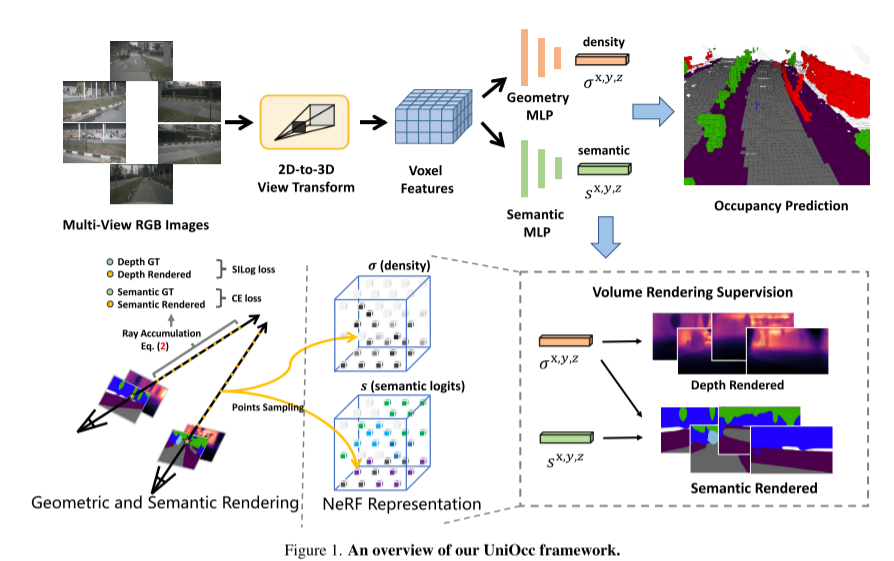

本文还介绍了深度感知师生(DTS)框架,这是一种自我监督的训练方法。与经典的Mean Teacher不同,DTS增强了教师模型的深度预测,在利用无标记数据的同时实现稳定和有效的训练。此外,本文应用了一些简单而有效的技术来提高模型的性能。这包括在训练中使用可见掩模,使用更强的预训练骨干网络,增加体素分辨率,以及实现测试时间数据增强(TTA)

以下是UniOcc框架的概述: 图1

图2。深度感知的Teacher-Student框架。

实验结果:

引用:

潘,M.,刘,L.,刘,J.,黄,P.,王,L.,张,S.,徐,S.,赖,Z.,杨,K.(2023)。UniOcc:将几何和语义渲染与视觉为中心的3D占用预测统一起来。ArXiv。/ abs / 2306.09117

原文链接:https://mp.weixin.qq.com/s/iLPHMtLzc5z0f4bg_W1vIg

以上是UniOcc:將以視覺為中心的佔用預測與幾何和語義渲染大一統!的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

Windows 11 上的智慧型應用程式控制:如何開啟或關閉它

Jun 06, 2023 pm 11:10 PM

Windows 11 上的智慧型應用程式控制:如何開啟或關閉它

Jun 06, 2023 pm 11:10 PM

智慧型應用程式控制是Windows11中非常有用的工具,可幫助保護你的電腦免受可能損害資料的未經授權的應用程式(如勒索軟體或間諜軟體)的侵害。本文將解釋什麼是智慧型應用程式控制、它是如何運作的,以及如何在Windows11中開啟或關閉它。什麼是Windows11中的智慧型應用控制?智慧型應用程式控制(SAC)是Windows1122H2更新中引入的新安全功能。它與MicrosoftDefender或第三方防毒軟體一起運行,以阻止可能不必要的應用,這些應用程式可能會減慢設備速度、顯示意外廣告或執行其他意外操作。智慧應用

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

寫在前面今天我們探討下深度學習技術如何改善在複雜環境中基於視覺的SLAM(同時定位與地圖建構)表現。透過將深度特徵提取和深度匹配方法相結合,這裡介紹了一種多功能的混合視覺SLAM系統,旨在提高在諸如低光條件、動態光照、弱紋理區域和嚴重抖動等挑戰性場景中的適應性。我們的系統支援多種模式,包括拓展單目、立體、單目-慣性以及立體-慣性配置。除此之外,也分析如何將視覺SLAM與深度學習方法結合,以啟發其他研究。透過在公共資料集和自採樣資料上的廣泛實驗,展示了SL-SLAM在定位精度和追蹤魯棒性方面優

五官亂飛,張嘴、瞪眼、挑眉,AI都能模仿到位,影片詐騙要防不住了

Dec 14, 2023 pm 11:30 PM

五官亂飛,張嘴、瞪眼、挑眉,AI都能模仿到位,影片詐騙要防不住了

Dec 14, 2023 pm 11:30 PM

好強大的AI模仿能力,真的防不住,完全防不住。現在AI的發展已經達到這種程度了嗎?你前腳讓自己的五官亂飛,後腳,一模一樣的表情就被復現出來,瞪眼、挑眉、噘嘴,不管多麼誇張的表情,都模仿的非常到位。加大難度,讓眉毛挑的再高些,眼睛睜的再大些,甚至連嘴型都是歪的,虛擬人物頭像也能完美復現表情。當你在左邊調整參數時,右邊的虛擬頭像也會相應地改變動作給嘴巴、眼睛一個特寫,模仿的不能說完全相同,只能說表情一模一樣(最右邊)。這項研究來自慕尼黑工業大學等機構,他們提出了GaussianAvatars,這種

NeRF是什麼?基於NeRF的三維重建是基於體素嗎?

Oct 16, 2023 am 11:33 AM

NeRF是什麼?基於NeRF的三維重建是基於體素嗎?

Oct 16, 2023 am 11:33 AM

1介紹神經輻射場(NeRF)是深度學習和電腦視覺領域的一個相當新的範式。 ECCV2020論文《NeRF:將場景表示為視圖合成的神經輻射場》(該論文獲得了最佳論文獎)中介紹了這項技術,該技術自此大受歡迎,迄今已獲得近800次引用[1 ]。此方法標誌著機器學習處理3D資料的傳統方式發生了巨大變化。神經輻射場場景表示和可微分渲染過程:透過沿著相機射線採樣5D座標(位置和觀看方向)來合成影像;將這些位置輸入MLP以產生顏色和體積密度;並使用體積渲染技術將這些值合成影像;此渲染函數是可微分的,因此可以透過

MotionLM:多智能體運動預測的語言建模技術

Oct 13, 2023 pm 12:09 PM

MotionLM:多智能體運動預測的語言建模技術

Oct 13, 2023 pm 12:09 PM

本文經自動駕駛之心公眾號授權轉載,轉載請洽出處。原標題:MotionLM:Multi-AgentMotionForecastingasLanguageModeling論文連結:https://arxiv.org/pdf/2309.16534.pdf作者單位:Waymo會議:ICCV2023論文想法:對於自動駕駛車輛安全規劃來說,可靠地預測道路代理未來行為是至關重要的。本研究將連續軌跡表示為離散運動令牌序列,並將多智能體運動預測視為語言建模任務。我們提出的模型MotionLM有以下幾個優點:首

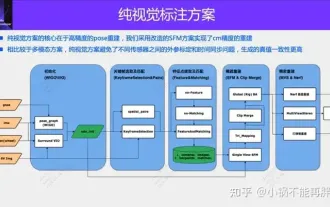

自動駕駛第一性之純視覺靜態重建

Jun 02, 2024 pm 03:24 PM

自動駕駛第一性之純視覺靜態重建

Jun 02, 2024 pm 03:24 PM

純視覺的標註方案,主要利用視覺加上一些GPS、IMU和輪速感測器的資料進行動態標註。當然面向量產場景的話,不一定要純視覺,有些量產的車輛裡面,會有像固態雷達(AT128)這樣的感測器。如果從量產的角度做資料閉環,把這些感測器都用上,可以有效解決動態物體的標註問題。但是我們的方案裡面,是沒有固態雷達的。所以,我們就介紹這個最通用的量產標註方案。純視覺的標註方案的核心在於高精度的pose重建。我們採用StructurefromMotion(SFM)的pose重建方案,來確保重建精確度。但是傳

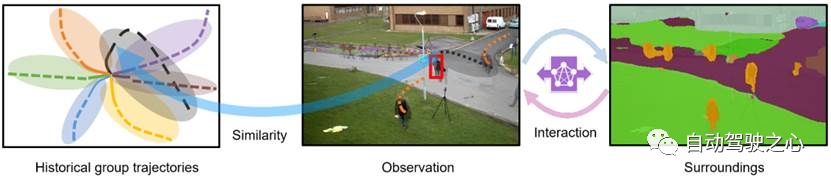

行人軌跡預測有哪些有效的方法和普遍的Base方法?頂會論文分享!

Oct 17, 2023 am 11:13 AM

行人軌跡預測有哪些有效的方法和普遍的Base方法?頂會論文分享!

Oct 17, 2023 am 11:13 AM

軌跡預測近兩年風頭正猛,但大都聚焦於車輛軌跡預測方向,自動駕駛之心今天就為大家分享頂會NeurIPS上關於行人軌跡預測的演算法—SHENet,在受限場景中人類的移動模式通常在一定程度上符合有限的規律。基於這個假設,SHENet透過學習隱含的場景規律來預測一個人的未來軌跡。文章已經授權自動駕駛之心原創!作者的個人理解由於人類運動的隨機性和主觀性,目前預測一個人的未來軌跡仍然是一個具有挑戰性的問題。然而,由於場景限制(例如平面圖、道路和障礙物)以及人與人或人與物體的互動性,在受限場景中人類的移動模式通

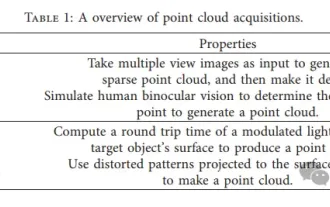

3D視覺繞不開的點雲配準!一文搞懂所有主流方案與挑戰

Apr 02, 2024 am 11:31 AM

3D視覺繞不開的點雲配準!一文搞懂所有主流方案與挑戰

Apr 02, 2024 am 11:31 AM

作為點集合的點雲有望透過3D重建、工業檢測和機器人操作中,在獲取和生成物體的三維(3D)表面資訊方面帶來一場改變。最具挑戰性但必不可少的過程是點雲配準,即獲得一個空間變換,該變換將在兩個不同座標中獲得的兩個點雲對齊並匹配。這篇綜述介紹了點雲配準的概述和基本原理,對各種方法進行了系統的分類和比較,並解決了點雲配準中存在的技術問題,試圖為該領域以外的學術研究人員和工程師提供指導,並促進點雲配準統一願景的討論。點雲獲取的一般方式分為主動和被動方式,由感測器主動獲取的點雲為主動方式,後期透過重建的方式