數據,作為決定機器學習模型效能的三大要素之一,正成為限制大模型發展的瓶頸。正所謂「Garbage in, garbage out」[1],無論你的演算法多麼優秀,你的運算資源多麼強大,模型的品質直接取決於你用來訓練模型的資料。

隨著各種開源大模型的湧現,資料的重要性進一步凸顯,尤其是高品質的產業資料。彭博社以開源的 GPT-3 框架打造金融大模型 BloombergGPT,證明了基於開源的大模型框架開發垂直產業大模型的可行性。事實上,垂直產業建構或客製化閉源的輕量化大模型,也正是國內多數大模型新創公司所選擇的路徑。

在這個賽道,高品質的垂直行業數據、基於專業知識的微調和對齊能力至關重要——BloombergGPT 基於彭博社積累了40 多年的金融文檔構建,訓練語料庫的token 超過7000 億[2]。

然而,要取得高品質的數據並不容易。有研究指出,依照目前大模型吞噬數據的速率,高品質的公域語言數據,例如書籍、新聞報導、科學論文、維基百科等,將在 2026 年左右耗盡[3]。

公開可用的中文高品質資料資源原本就相對較少,而國內的專業資料服務還在起步階段,進行資料收集、清洗、標註和驗證需要投入大量的人力和物力。據悉,國內某高校大模型團隊,收集、清洗3TB 高品質中文資料的成本,包括下載資料頻寬、資料儲存資源(未清洗的原始資料約100TB)、清洗資料的CPU 資源成本總計約數十萬元。

隨著大模型發展走向深度,要訓練出滿足產業需求、精準度極高的垂直產業模型,一定需要更多的產業專業知識,甚至商業機密類型的私域數據。但是,出於隱私權保護的要求,以及確權、收益分割存在的困難,企業往往不願意、不能或不敢分享他們的資料。

有沒有一種方案,既可以享受資料開放和共享的好處,又能保護資料的安全和隱私呢?

隱私計算(Privacy-preserving Computation)能夠在保證資料提供者不洩露原始資料的前提下,對資料進行分析、處理和使用,被視為促進資料要素流通和交易的關鍵技術[4],因此,將隱私計算用於保護大模型的資料安全,似乎成了自然的選擇。

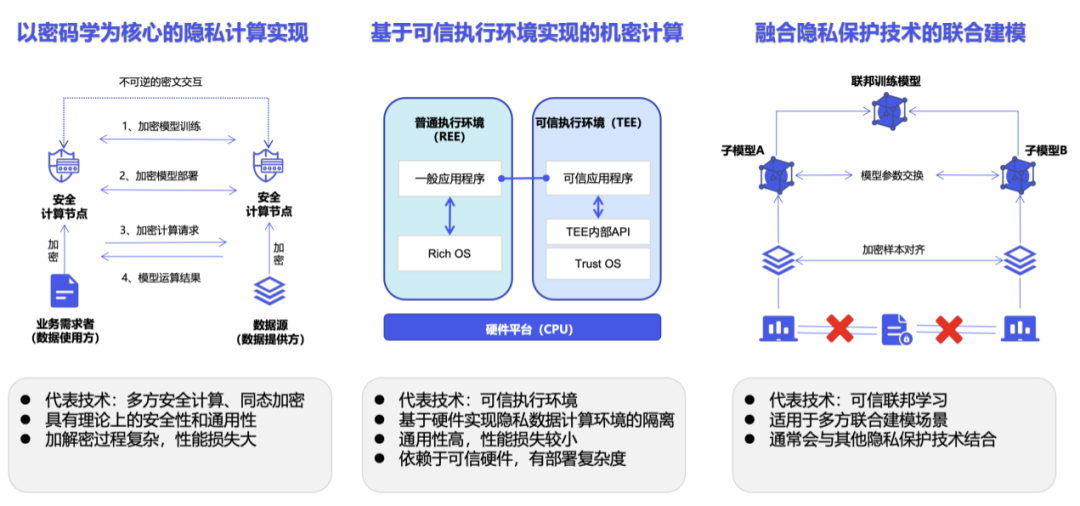

隱私運算不是一種技術,而是技術系統。根據具體的實現,隱私運算主要分為以多方安全運算為代表的密碼學路徑、以可信任執行環境為代表的機密運算路徑,以及以聯邦學習為代表的人工智慧路徑[5]。

不過,在實際應用中,隱私計算存在一些限制。例如,引入隱私計算 SDK 通常會對原業務系統進行程式碼層面的修改[6]。如果是基於密碼學的實現,加解密操作會讓運算量呈幾何級增長,同時密文計算需要更大的運算和儲存資源以及通訊負載[7]。

此外,涉及超大規模資料量的大模型訓練場景,現有的隱私運算方案還會遭遇一些新的問題。

基於聯邦學習的方案

#讓我們先看看聯邦學習的困難。聯邦學習的核心思想是「資料不動模型動」,這種去中心化的方式保證了敏感資料待在本地,無需暴露或傳輸。每個設備或伺服器透過向中心伺服器發送模型的更新,參與到訓練過程中,而中心伺服器則會聚合並融合這些更新,從而改進全域模型[8]。

然而,集中訓練大模型已經是一件非常困難的事情,分散式的訓練方法大大增加了系統的複雜性。我們還需要考慮模型在各個終端上訓練時資料的異質性,以及如何安全地聚合所有設備的學習權重——對於大模型的訓練,模型權重本身就是一項重要資產。此外,還必須防止攻擊者從單一模型更新推斷出私有數據,而相應的防禦措施會進一步增加訓練開銷。

基於密碼學的方案

同態加密能夠直接對加密資料進行計算,讓資料「可用不可見」[9]。在處理或分析敏感資料並保證其機密性的場景中,同態加密是保護隱私的強大工具。這種技術不僅可以應用於大模型的訓練,也能在保護使用者輸入(prompt)的機密性的同時進行推理。

然而,相較於使用未加密資料進行大模型的訓練和推理,使用加密資料要困難得多。同時,處理加密資料需要更多的計算,會指數級地增加處理時間,並進一步增加訓練大模型已經非常高的算力需求。

基於可信任執行環境的方案

#再來說說是基於可信任執行環境(TEE)的解決方案。大部分TEE 解決方案或產品都需要額外採購專門的設備,如多方安全運算節點、可信任執行環境設備、密碼加速卡等,無法適配現有的運算、儲存資源,使得此解決方案對許多中小企業來說並不現實。此外,目前 TEE 方案主要是基於 CPU 進行的,而大模型訓練嚴重依賴 GPU。現階段支援隱私運算的 GPU 方案還不成熟,反而造成了額外的風險[10]。

總的來說,在多方協作計算的場景下,很多時候要求原始資料物理意義上的「不可見」並不合理。此外,由於加密過程為資料添加了噪聲,在加密資料上進行訓練或推理,也會造成模型效能損失和降低模型準確性。現有的隱私計算方案無論是性能和還是在GPU 支持方面,都無法很好地適用於大模型訓練場景,也阻礙了擁有高質量數據資源的企業和機構開放和共享信息,參與到大模型產業中來。

#「當我們把大模型產業看做從資料到應用的一個鏈條,會發現這個鏈條實際上是各種數據(包括原始數據,也包括以參數形式存在於模型中的數據)在不同主體間的流通鏈,而這個產業的商業模式則應該構建於這些流通的數據(或模型)是可以被交易的資產基礎之上。」熠智科技的CEO 湯載陽博士表示。

「資料要素的流通涉及多個主體,而產業鏈的源頭一定是資料提供者。也就是說,所有的業務其實都是由資料提供者來發起,只有資料提供方授權,交易才可能進行,所以應該優先保證資料提供者的權益。」

#目前市場上主流的隱私保護解決方案,如多方安全計算、可信執行環境和聯邦學習,都聚焦在資料使用方如何處理數據,湯載陽認為,我們需要從數據提供者的角度出發去看問題。

熠智科技成立於 2019 年,定位於資料合作的隱私保護解決方案提供者。 2021 年,公司入選了由中國資訊通信研究院發起的「資料安全推進計畫」(Data Security Initiative,DSI)首批參與單位,並由 DSI 認證為 9 家代表性隱私計算企業廠商之一。 2022 年,熠智科技正式成為國內首個國際化自主可控隱私運算開源社群-開放群島(Open Islands)開源社群成員單位,共同推動資料要素流通關鍵基礎設施建設。

針對目前大模型訓練的資料困境,以及更廣泛的資料要素流通問題,熠智科技從實踐出發,提出了一種新的隱私運算解決方案—可控計算。

「可控計算的核心關注點是以保護隱私的方式來發現和共享資訊。我們解決的問題是在訓練的過程中保證所用資料的安全,以及訓練出來的模型不被惡意竊取。」湯載陽說。

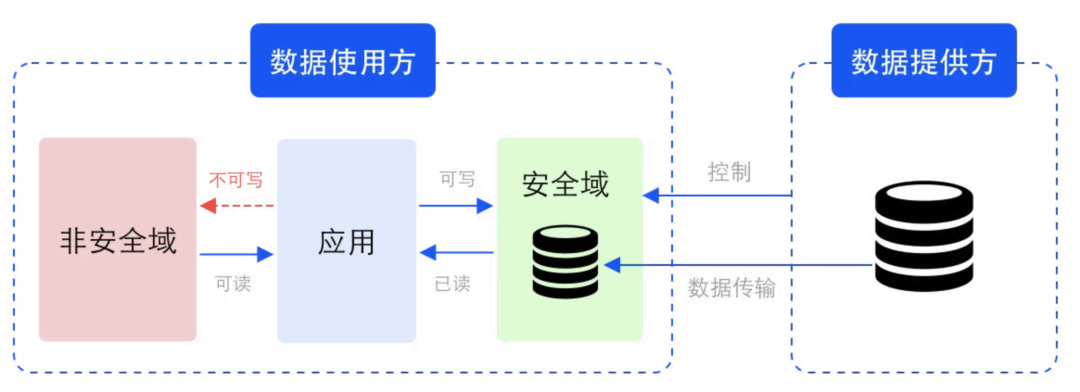

具體地說,可控運算要求資料使用方在資料提供方定義的安全性域中對資料進行加工和處理。

安全域在資料流通場景中的範例

安全域是一個邏輯上的概念,指由對應的金鑰和加密演算法保護的儲存、運算單元。安全域由資料提供方定義和約束,但對應的儲存、運算資源並非由資料提供者提供。物理上,安全域在資料使用方,但是由資料提供方控制。除了原始數據,加工、處理後的中間數據和結果數據也在相同的安全域中。

在安全域中,資料可以是密文(不可見),也可以是明文(可見),在明文情況下,由於資料可見的範圍是受控的,因此確保了資料在使用過程中的安全。

複雜的密文計算導致的效能下降是限制隱私運算應用範圍的一個重要因素,透過強調資料的可控,而不是一味追求不可見,可控運算解決了傳統隱私運算方案對原有業務的侵入性,因此非常適合需要處理超大規模資料的大模型訓練場景。

企業可以選擇將自己的資料存放在多個不同的安全性網域中,並為這些安全性網域設定不同的安全等級、使用權限或白名單。對於分散式應用,也可以在多個電腦節點乃至晶片上設定安全域。

「安全域是可以串起來的,在資料流通的各個環節,資料提供者可以定義多個不同的安全域,讓自己的資料只在這些安全域之間互相流轉,最終這些串聯的安全域就建構起了一個資料的網路。在這個網路上面,資料是可控制的,對資料的流轉、分析、處理等也可度量、可監管,資料的流通也可以做相應的變現。」湯載陽解釋。

基於可控運算的思想,熠智科技推出了「DataVault」。

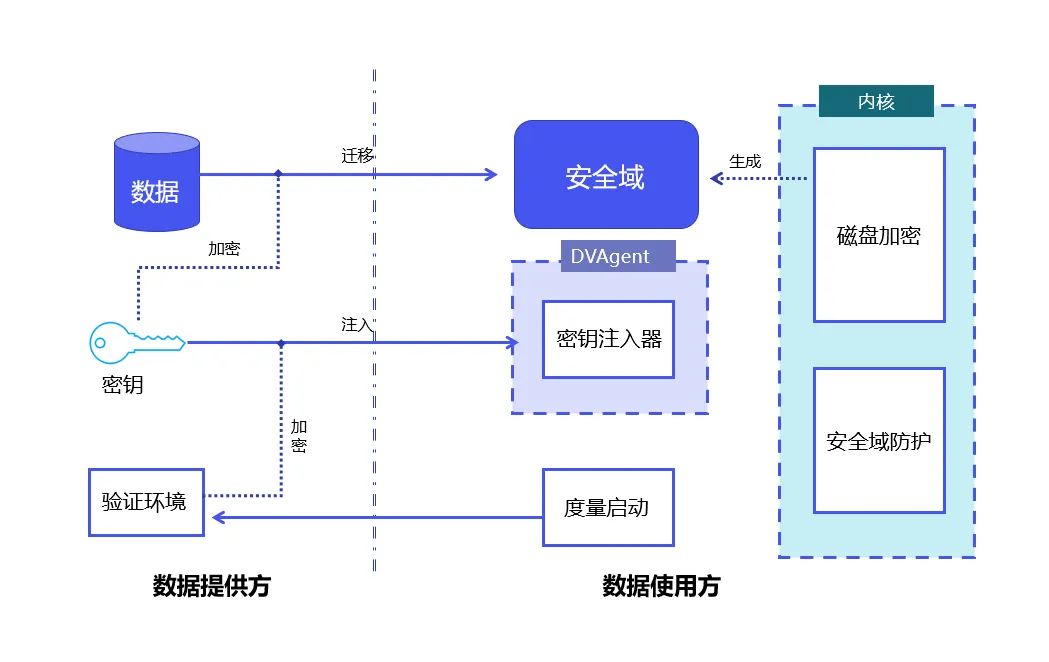

DataVault 原理:結合 Linux 度量啟動和 Linux 全碟加密技術,實現資料在安全域內的可控、防護。

DataVault 將可信任平台模組 TPM(Trusted Platform Module,其核心是提供基於硬體的安全相關功能)做為信任根,保護了系統的完整性;使用Linux 安全模組LSM( Linux Security Modules,Linux 核心中用於支援各種電腦安全模型的框架,其與任何單獨的安全實作無關)技術,使安全域內的資料只在可控範圍內使用。

在此基礎上,DataVault 使用Linux 提供的全碟加密技術將資料置於安全域內,熠智科技自研了完整的金鑰分發以及簽章授權等密碼協議,並做了大量工程上的最佳化,進一步確保了資料的可控。

DataVault 支援多種專用加速卡,包括不同的 CPU、GPU、FPGA 等硬件,也支援多種資料處理框架、模型訓練框架,且二進位相容。

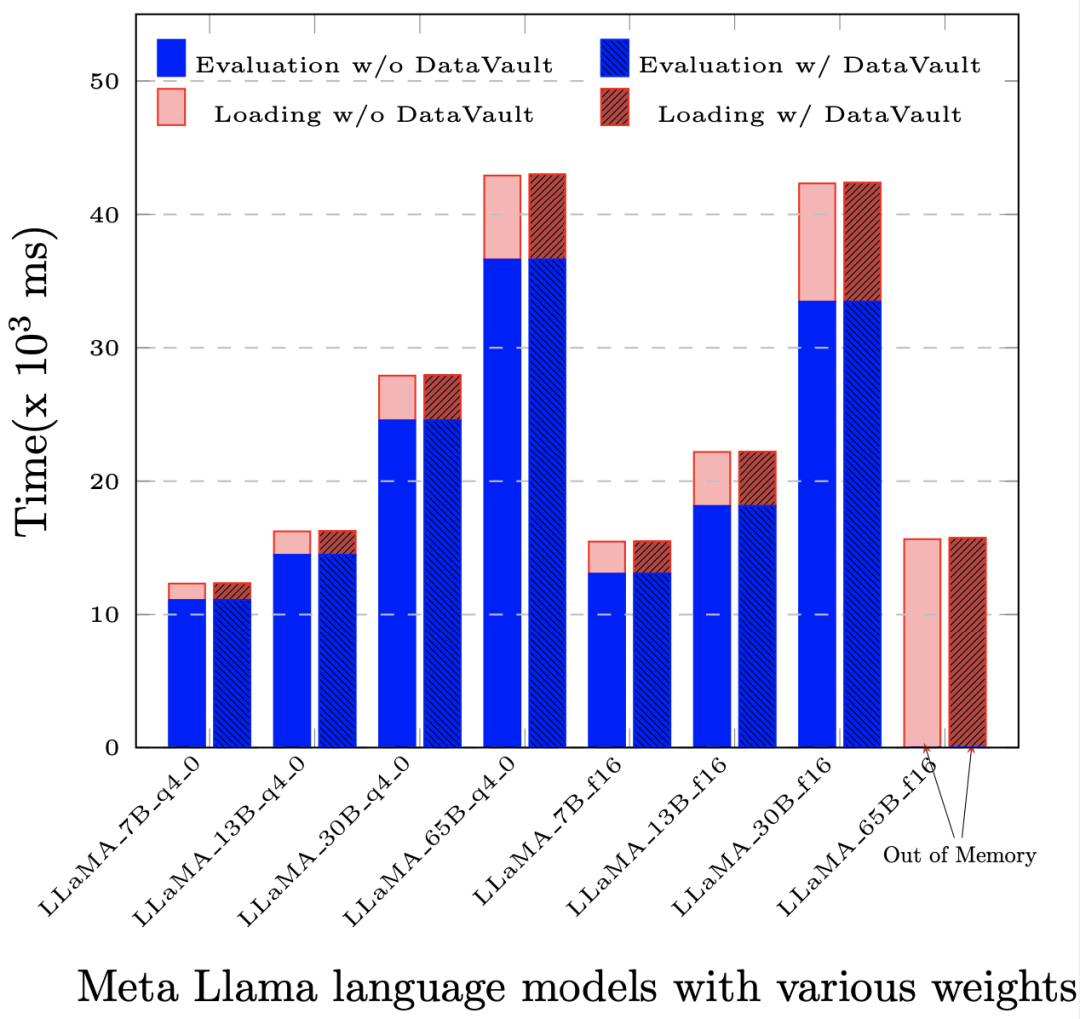

更重要的是,它有著遠低於其他隱私運算解決方案的效能損失,在大部分應用中,相較於原生系統(即不用任何隱私運算技術),整體性能損失不超過5%。

部署 DataVault 後,基於 LLaMA-65B 的評估(Evaluation)和提示評估(Prompt Evaluation)環節中,效能損失小於 1‰。

現在,熠智科技已與國家超級運算中心達成合作,在超算平台上部署以AI 應用為導向的隱私保護高效能運算平台。基於 DataVault,算力使用方可以在運算平台上設定安全域,確保資料從儲存節點轉移到運算節點的全過程都只能在安全域之間移動,不會離開設定的範圍。

除了確保資料在模型訓練中的可控,基於 DataVault 解決方案,訓練好的大模型本身作為一種資料資產,也可以被保護並被安全地交易。

目前,對於那些希望在本地部署大模型的企業,例如金融、醫療等高敏感資料機構,苦於缺少在本地運行大模型的基礎設施,包括訓練大模型的高成本高性能硬件,以及部署大模型後續的維運經驗。而對於建構產業大模型的企業,他們則擔心如果直接將模型交付給客戶,模型本身和模型參數背後累積的產業數據和專業知識存在著被二次販賣的可能。

作為對垂直產業大模型落地的一種探索,熠智科技也正與粵港澳大灣區數位經濟研究院(IDEA 研究院)合作,雙方共同打造了具有模型安全保護功能的大模型一體機。這種一體機內建了若干垂直行業大模型,配備大模型訓推所需的基礎算力資源,可以滿足客戶開箱即用的需求,其中熠智的可控計算組件DataVault 可以確保這些內置模型僅在獲得授權的情況下被使用,模型以及所有中間資料無法被外部環境竊取。

作為一種新的隱私運算範式,熠智科技希望可控運算能為大模型產業和資料要素流通帶來改變。

「DataVault 只是一個輕量級的實作方案。隨著技術和需求的變化,我們會持續更新,在資料要素流通市場有更多的嘗試和貢獻,也歡迎更多產業夥伴加入進來,共建可控計算社區。」湯載陽說。

以上是訓練大模型缺少高品質資料?我們找到了新的解決方案的詳細內容。更多資訊請關注PHP中文網其他相關文章!