智源開放3億個語意向量模型訓練數據,BGE模型持續進行迭代更新

隨著大型模型的開發和應用火熱發展,作為大型模型核心基礎組件的Embedding的重要性變得越來越突出。智源公司在一個月前發布的開源可商用的中英文語義向量模型BGE(BAAI General Embedding)在社區中引起了廣泛的關注,Hugging Face平台上的下載量已經達到了數十萬次。目前,BGE已經快速迭代推出了1.5版本,並公佈了多項更新。其中,BGE首次開源了三億條大規模訓練數據,為社區提供了訓練類似模型的幫助,推動了該領域技術的發展

- MTP資料集連結:https://data.baai.ac.cn/details/BAAI-MTP

- #BGE 模型連結:https://huggingface.co /BAAI

- BGE 程式碼倉庫:https://www.php.cn/link /8944871f1c9865a77a3d9c92cadf124d

3 億中英向量模型訓練資料開放

#第一個開源的業界語意向量模型訓練資料達到了3億個中英文資料

BGE 的出色能力很大程度源自於其大規模、多樣化的訓練資料。此前,業界同業鮮有發布同類數據集。在本次更新中,智源首次將 BGE 的訓練資料向社群開放,為推動此類技術進一步發展打下了基礎。

此發佈的資料集 MTP 由總計 3 億條中英文關聯文字對構成。其中,中文記錄達 1 億條,英文數據達 2 億條。資料的來源包括 Wudao Corpora、Pile、DuReader、Sentence Transformer 等語料。經過必要的取樣、抽取和清洗後獲得

詳細細節請參考 Data Hub:https://data.baai.ac.cn

MTP 為迄今開源的最大規模中英文關聯文字對資料集,為訓練中英文語意向量模型提供重要基礎。

回應開發者社區,BGE 功能升級

#根據社區回饋,BGE 在其1.0 版本的基礎上進行了進一步優化,使其表現更加穩定和出色。具體的升級內容如下:

- 模型更新。 BGE-*-zh-v1.5 緩解了相似度分佈問題,透過對訓練數據進行過濾,刪除低品質數據,提高訓練時溫度係數 temperature 至 0.02,使得相似度數值更加平穩 。

- 新增模型。開源 BGE-reranker 交叉編碼器模型,可更精準找到相關文本,支援中英雙語。有別於向量模型需要輸出向量,BGE-reranker 直接文字對輸出相似度,排序準確度更高,可用於對向量回想結果的重新排序,提升最終結果的相關性。

- 新增功能。 BGE1.1 增加難負樣本挖掘腳本,難負樣本可有效提升微調後檢索的效果;在微調程式碼中增加在微調中增加指令的功能;模型保存也將自動轉成sentence transformer 格式,更方便模型加載。

值得一提的是,日前,智源聯合 Hugging Face 發布了一篇技術報告,報告提出用 C-Pack 增強中文通用語義向量模型。

《C-Pack: Packaged Resources To Advance General Chinese Embedding》

連結:https://arxiv.org/pdf/2309.07597 .pdf

在開發者社群中收穫高熱度

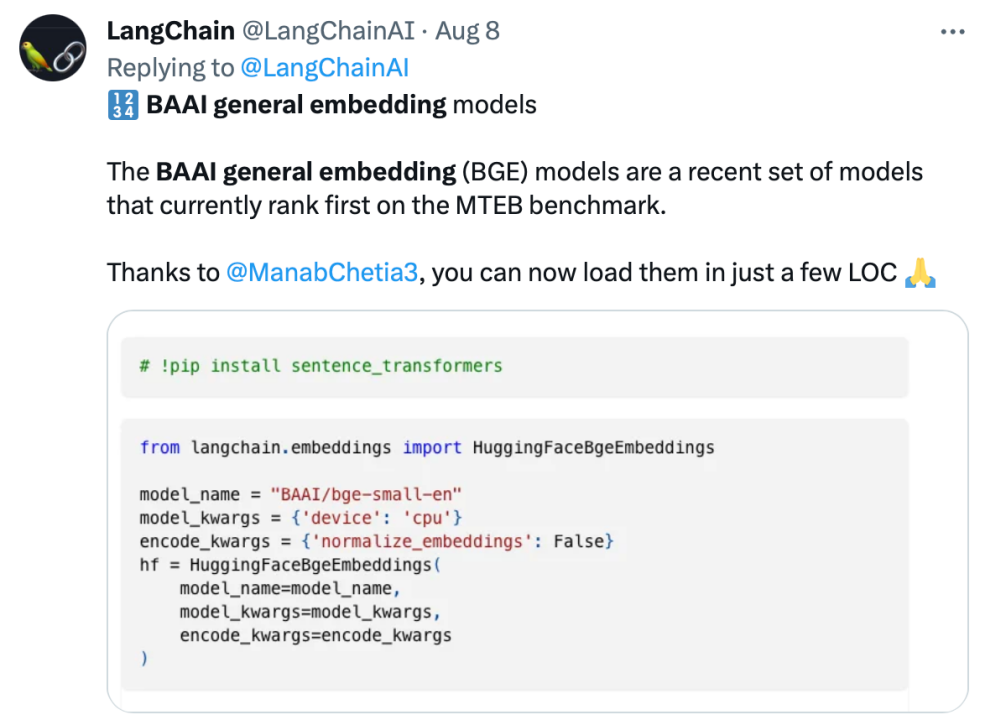

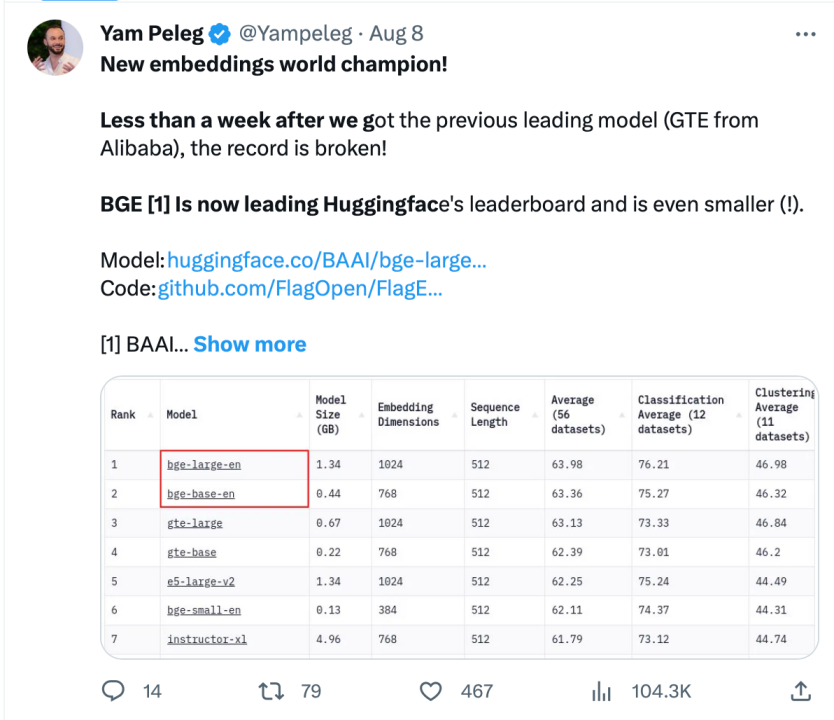

BGE 自發布以來受到了大型模式開發者社群的關注,目前Hugging Face的下載量已經達到了數十萬次,並且已經被知名的開源專案LangChain、LangChain-Chatchat、llama_index 等整合使用

Langchain 官方、LangChain 聯合創始人兼首席執行官Harrison Chase、Deep trading 創辦人Yam Peleg 等社區大V 對BGE 表示關切。

堅持開源開放,促進協同創新,智源大模型技術開體系 FlagOpen BGE 新增 FlagEmbedding 新版塊,專注於 Embedding 技術和模型,BGE 是其中備受矚目的開源專案之一。 FlagOpen 致力於建構大模型時代的人工智慧技術基礎設施,未來將繼續向學術界和產業界開放更完整的大模型全端技術

#以上是智源開放3億個語意向量模型訓練數據,BGE模型持續進行迭代更新的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

比特幣值多少美金

Apr 28, 2025 pm 07:42 PM

比特幣值多少美金

Apr 28, 2025 pm 07:42 PM

比特幣的價格在20,000到30,000美元之間。 1. 比特幣自2009年以來價格波動劇烈,2017年達到近20,000美元,2021年達到近60,000美元。 2. 價格受市場需求、供應量、宏觀經濟環境等因素影響。 3. 通過交易所、移動應用和網站可獲取實時價格。 4. 比特幣價格波動性大,受市場情緒和外部因素驅動。 5. 與傳統金融市場有一定關係,受全球股市、美元強弱等影響。 6. 長期趨勢看漲,但需謹慎評估風險。

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台最新版

Apr 28, 2025 pm 08:09 PM

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台最新版

Apr 28, 2025 pm 08:09 PM

全球十大加密貨幣交易平台包括Binance、OKX、Gate.io、Coinbase、Kraken、Huobi Global、Bitfinex、Bittrex、KuCoin和Poloniex,均提供多種交易方式和強大的安全措施。

排名前十的虛擬幣交易app有哪 最新數字貨幣交易所排行榜

Apr 28, 2025 pm 08:03 PM

排名前十的虛擬幣交易app有哪 最新數字貨幣交易所排行榜

Apr 28, 2025 pm 08:03 PM

Binance、OKX、gate.io等十大數字貨幣交易所完善系統、高效多元化交易和嚴密安全措施嚴重推崇。

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台2025

Apr 28, 2025 pm 08:12 PM

全球幣圈十大交易所有哪些 排名前十的貨幣交易平台2025

Apr 28, 2025 pm 08:12 PM

2025年全球十大加密貨幣交易所包括Binance、OKX、Gate.io、Coinbase、Kraken、Huobi、Bitfinex、KuCoin、Bittrex和Poloniex,均以高交易量和安全性著稱。

解密Gate.io戰略升級:MeMebox 2.0如何重新定義加密資產管理?

Apr 28, 2025 pm 03:33 PM

解密Gate.io戰略升級:MeMebox 2.0如何重新定義加密資產管理?

Apr 28, 2025 pm 03:33 PM

MeMebox 2.0通過創新架構和性能突破重新定義了加密資產管理。 1) 它解決了資產孤島、收益衰減和安全與便利悖論三大痛點。 2) 通過智能資產樞紐、動態風險管理和收益增強引擎,提升了跨鏈轉賬速度、平均收益率和安全事件響應速度。 3) 為用戶提供資產可視化、策略自動化和治理一體化,實現了用戶價值重構。 4) 通過生態協同和合規化創新,增強了平台的整體效能。 5) 未來將推出智能合約保險池、預測市場集成和AI驅動資產配置,繼續引領行業發展。

靠譜的數字貨幣交易平台推薦 全球十大數字貨幣交易所排行榜2025

Apr 28, 2025 pm 04:30 PM

靠譜的數字貨幣交易平台推薦 全球十大數字貨幣交易所排行榜2025

Apr 28, 2025 pm 04:30 PM

靠谱的数字货币交易平台推荐:1. OKX,2. Binance,3. Coinbase,4. Kraken,5. Huobi,6. KuCoin,7. Bitfinex,8. Gemini,9. Bitstamp,10. Poloniex,这些平台均以其安全性、用户体验和多样化的功能著称,适合不同层次的用户进行数字货币交易

排名靠前的貨幣交易平台有哪些 最新虛擬幣交易所排名榜前10

Apr 28, 2025 pm 08:06 PM

排名靠前的貨幣交易平台有哪些 最新虛擬幣交易所排名榜前10

Apr 28, 2025 pm 08:06 PM

目前排名前十的虛擬幣交易所:1.幣安,2. OKX,3. Gate.io,4。幣庫,5。海妖,6。火幣全球站,7.拜比特,8.庫幣,9.比特幣,10。比特戳。

怎樣在C 中測量線程性能?

Apr 28, 2025 pm 10:21 PM

怎樣在C 中測量線程性能?

Apr 28, 2025 pm 10:21 PM

在C 中測量線程性能可以使用標準庫中的計時工具、性能分析工具和自定義計時器。 1.使用庫測量執行時間。 2.使用gprof進行性能分析,步驟包括編譯時添加-pg選項、運行程序生成gmon.out文件、生成性能報告。 3.使用Valgrind的Callgrind模塊進行更詳細的分析,步驟包括運行程序生成callgrind.out文件、使用kcachegrind查看結果。 4.自定義計時器可靈活測量特定代碼段的執行時間。這些方法幫助全面了解線程性能,並優化代碼。