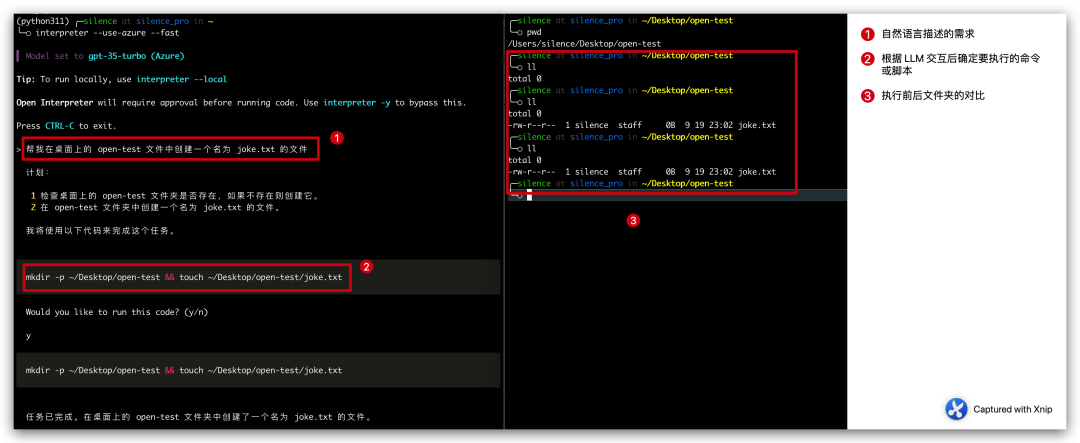

最近在逛 Github 的時候發現了一款神器,叫做 Open Interpreter,主要是用來實現在本地和大語言模型進行交互的,透過大語言模型將自然語言轉換為腳本代碼,然後在本地執行從而實現目標。

簡而言之,如果你想在桌面上創建一個名為joke.txt的文件,你不需要手動創建,而是可以透過自然語言告訴Open Interpreter,讓它幫助我們產生創建文件的腳本,然後在本地執行,從而產生一個joke.txt檔案

我們要做的就是告訴它我們的需求是什麼,以及允許它在本地執行程式碼即可。

請將內容改寫,但不改變原本的意思,改寫成中文。不需要出現原句

圖片

圖片

上面的 case 整個過程分三步驟:

计划: 1 检查桌面上的 open-test 文件夹是否存在,如果不存在则创建它。 2 在 open-test 文件夹中创建一个名为 joke.txt 的文件。我将使用以下代码来完成这个任务。mkdir -p ~/Desktop/open-test && touch ~/Desktop/open-test/joke.txt

這個專案剛起步,這個 case 也很簡單,但是我們要知道這彷彿打開了另一扇大門,以後只要是透過程式碼能實現的功能,我們都可以透過自然語言來實現了,想想都很激動(可怕)。

官方的介紹這個工具都可以用來編輯影片以及發送郵件,只能說很有前景。

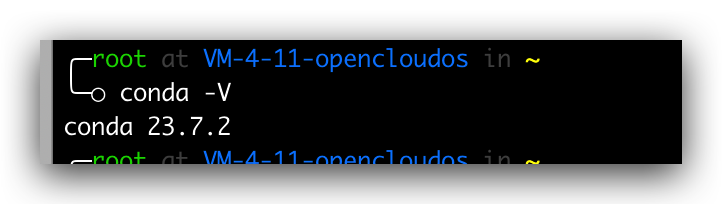

安裝這個專案非常簡單。通常情況下,我們只需在命令列中執行 pip install open-interpreter 即可。然而,為了確保環境的穩定性,我們準備好使用 conda 進行環境隔離。因此,我們首先需要安裝 conda,並按照以下命令依次執行

# 获取脚本wget https://repo.anaconda.com/archive/Anaconda3-2023.07-2-Linux-x86_64.sh# 增加可执行权限chmod +x Anaconda3-2023.07-2-Linux-x86_64.sh# 运行安装脚本./Anaconda3-2023.07-2-Linux-x86_64.sh# 查询版本conda -V

如何能正常輸出版本號,則表明安裝成功,如果提示命令不存在,那我們就需要配置一下環境變量,在

vim .bash_profile# 加入下面一行PATH=$PATH:$HOME/bin:$NODE_PATH/bin:/root/anaconda3/bin# 再次执行conda -V

圖片

圖片

#安裝完成 conda 過後,我們就創建指定 Python 版本的隔離環境了,透過以下命令

conda create -n python311 pythnotallow=3.11

這行程式碼的意思是透過 conda create 建立一個名字叫 python311 的隔離環境,隔離環境的 python 版本指定為3.11,建立完成過後我們可以透過下面的指令查詢隔離環境的清單。

conda env list

圖片

圖片

然後我們進入到隔離環境中,在隔離環境中安裝 open interpreter,指令如下

conda activate python311pip install open-interpreter

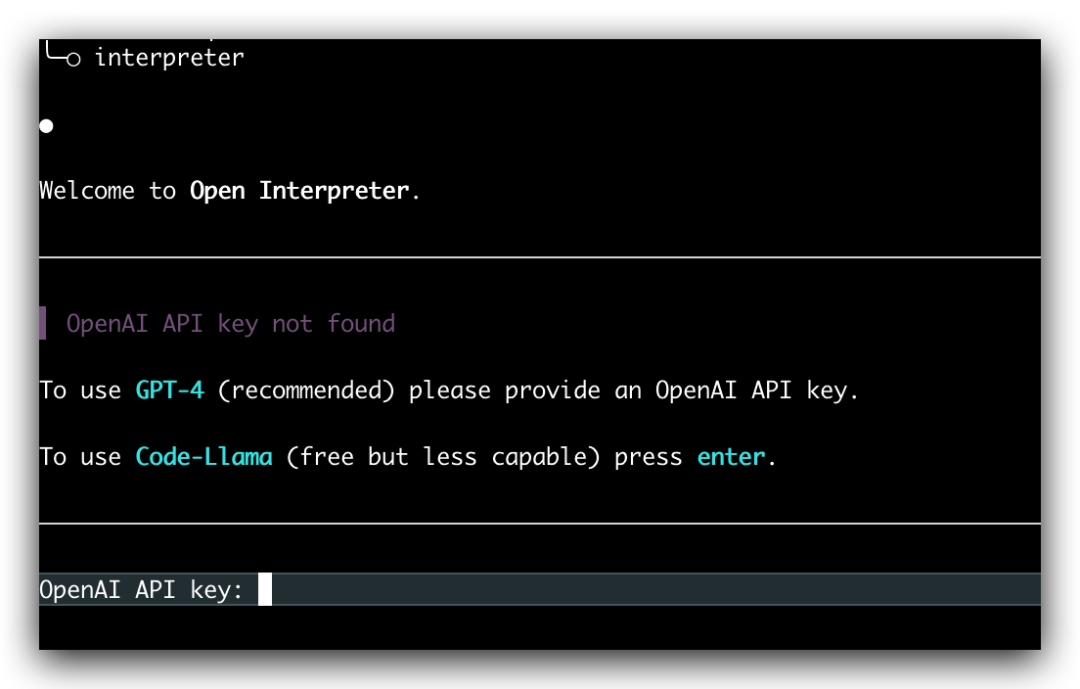

等待一會即可安裝成功,安裝成功過後輸入下方指令,即可開啟本機大語言模型互動。

interpreter

圖片

圖片

不需要改變原意,需要重新寫入的內容是:當我們直接輸入「interpreter」指令時,會要求我們輸入自己的OpenAI API金鑰。此時,預設使用的是GPT-4模型,但我們可以透過新增「--fast」參數來使用GPT-3.5模型

interpreter --fast

這裡我們每次執行都需要手動填入 OpenAI API key 比較麻煩,可以設定環境變數

export OPENAI_API_KEY=skxxxx

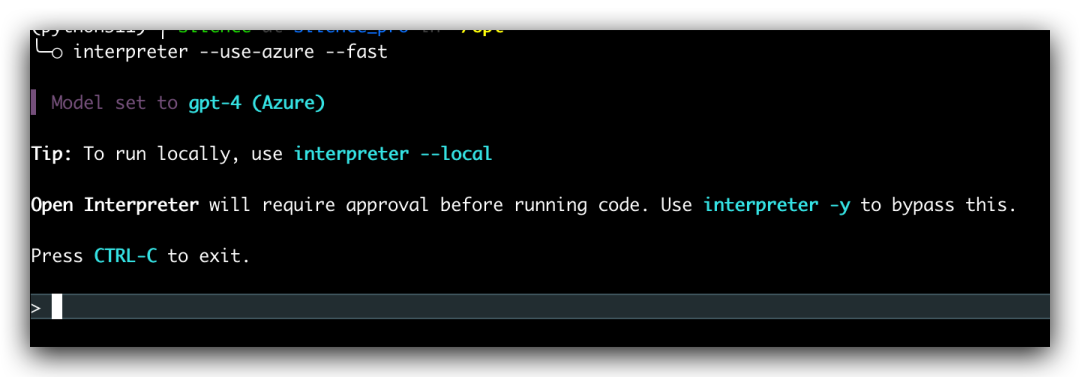

這樣我們後續執行就不用在手動填 OpenAI 的API key 了,如果想用微軟的 Azure OpenAI 的話,也是支援的,只要設定下面的環境變量,然後在啟動的時候增加 --use-azure 參數就可以了

export AZURE_API_KEY=export AZURE_API_BASE=export AZURE_API_VERSION=export AZURE_DEPLOYMENT_NAME=

interpreter --use-azure

#圖片

#圖片

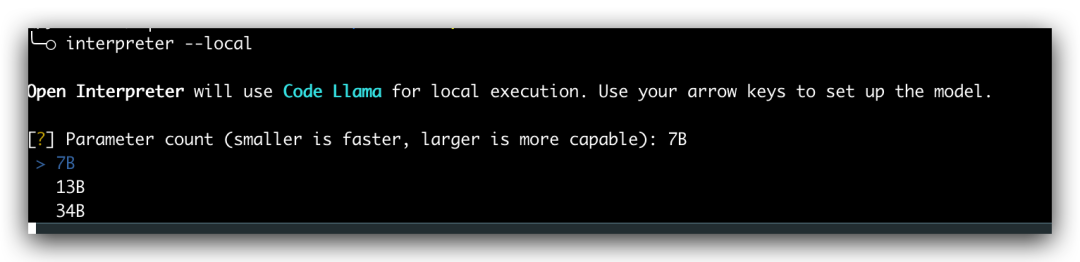

所有操作都需要我們擁有對應的OpenAI API金鑰或Azure的OpenAI端點。實際上,Open Interpreter也支援本地運行,只需在啟動時新增--local參數,然後選擇對應的模型。但是,本地運行需要我們的電腦配置支援。對此有興趣的朋友可以參考官方文件進行實踐,但我的配置不允許這樣做

圖片

圖片

今天我向大家介紹了一下 Open interpreter 的安裝方法和簡單玩法。這個計畫目前正在快速迭代中,相信不久的將來將會帶來一場改變。不得不說,人工智慧的時代真正到來了,未來幾年將會是人工智慧產品的蓬勃發展時期。身為程式設計師,我們要緊跟時代的步伐,不要掉隊

以上是Open Interpreter:一款讓大型語言模型在本地執行程式碼的開源工具的詳細內容。更多資訊請關注PHP中文網其他相關文章!