打破大模型黑盒,徹底分解神經元! OpenAI對頭Anthropic擊破AI不可解釋性障礙

多年來,我們一直無法理解人工智慧是如何做出決策和產生輸出的

模型開發人員只能決定演算法、數據,最後得到模型的輸出結果,而中間部分-模型是怎麼根據這些演算法和資料輸出結果,就成為了不可見的「黑箱」。

所以就出現了「模型的訓練就像煉丹」這樣的戲言。

但現在,模型黑盒子終於有了可解釋性!

來自Anthropic的研究團隊提取了模型的神經網路中最基本的單位神經元的可解釋特徵。

這將是人類揭開AI黑箱的里程碑式的一步。

Anthropic充滿激動地表示:

#「如果我們能夠理解模型中的神經網路是如何運作的,那麼診斷模型的故障模式、設計修復程序,並讓模型安全地被企業和社會採用就將成為觸手可及的現實!」

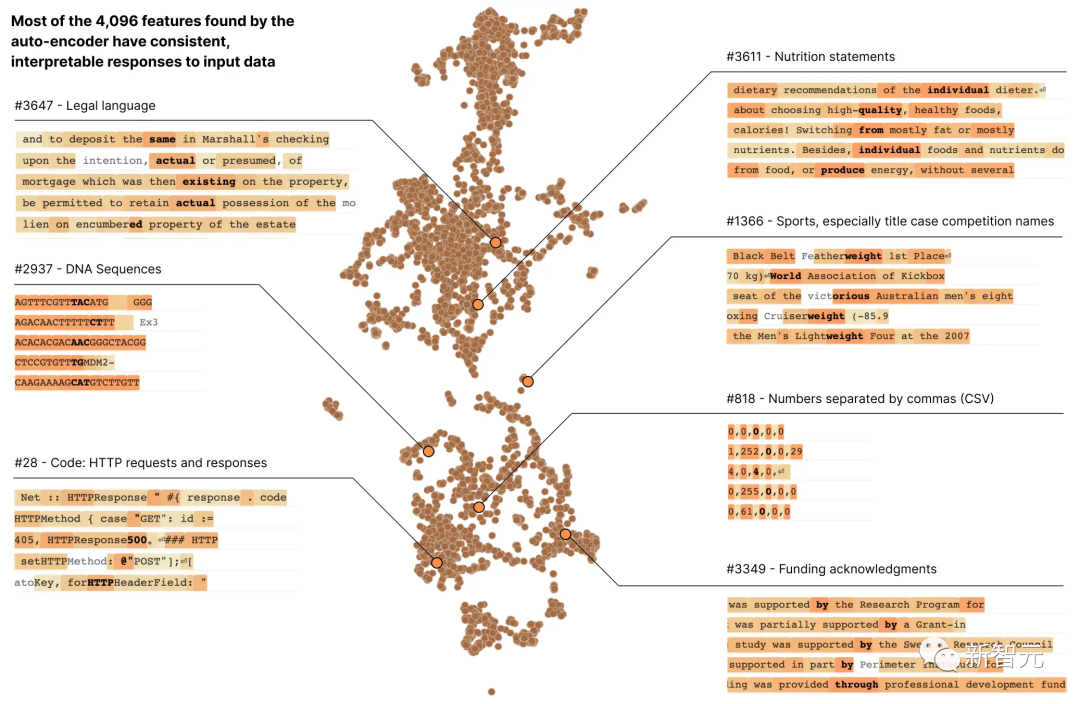

在Anthropic的最新研究報告《走向單語意性:用字典學習分解語言模型》中,研究人員使用字典學習的方法,成功地將包含512個神經元的層分解成了4000多個可解釋的特徵

研究報告網址:https://transformer-circuits.pub/2023/monosemantic-features/index.html

#這些特徵分別代表了DNA序列、法律語言、HTTP請求、希伯來文本和營養成分說明等

當我們孤立地觀察單一神經元的活化時,我們無法看到這些模型屬性中的大部分

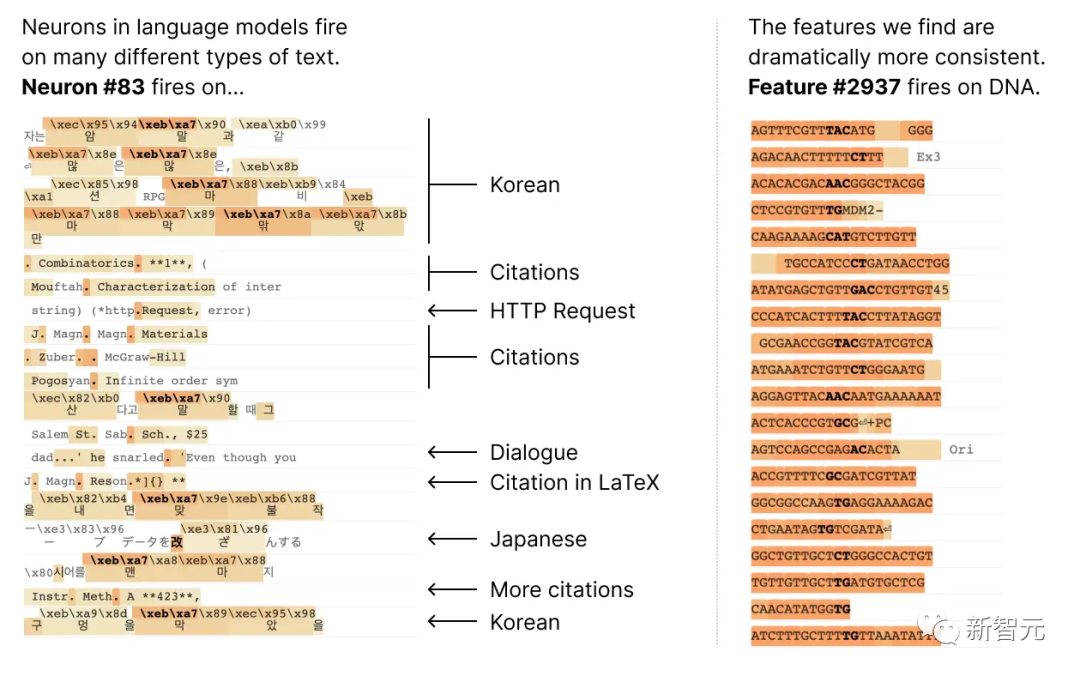

大多數神經元都是「多語義」的,這意味著單一神經元與網路行為之間沒有一致的對應關係

例如,在一個小型語言模型中,單一神經元在許多不相關的上下文中都很活躍,包括:學術引文、英語對話、HTTP 請求和韓文文字。

而在經典視覺模型中,單一神經元會對貓的臉和汽車的前臉做出反應。

在不同的脈絡中,許多研究證明了一個神經元的活化可能具有不同的意義

一個潛在的原因是神經元的多語意性是由於疊加效應。這是一種假設的現象,即神經網路透過為每個特徵分配自己的神經元線性組合來表示資料的獨立特徵,而這種特徵的數量超過了神經元的數量

##如果將每個特徵視為神經元上的一個向量,那麼特徵集就構成了網路神經元活化的一個過完備線性基礎。

在Anthropic之前的Toy Models of Superposition(《疊加玩具模型》)論文中,證明了稀疏性在神經網路訓練中可以消除歧義,幫助模型更好地理解特徵之間的關係,從而減少激活向量的來源特徵的不確定性,使模型的預測和決策更可靠。

這個概念類似於壓縮感知中的思想,其中訊號的稀疏性允許從有限的觀測中還原出完整的訊號。

但在Toy Models of Superposition中提出的三種策略中:

(1)建立沒有疊加的模型,或許可以鼓勵激活稀疏性;

(2)在展現出疊加態的模型中,採用字典學習來尋找過完備特徵

(3)依賴兩者結合的混合方法。

需要進行改寫的內容是:方法(1)無法解決多義性問題,而方法(2)則容易出現嚴重的過度擬合情況

#因此,這次Anthropic的研究人員使用了一種稱為稀疏自動編碼器的弱字典學習演算法,從經過訓練的模型中生成學習到的特徵,這些特徵提供了比模型神經元本身更單一的語意分析單位。

具體來說,研究人員採用了具有512個神經元的MLP單層transformer,並透過從80億個資料點的MLP激活上訓練稀疏自動編碼器,最終將MLP活化分解為相對可解釋的特徵,擴展因子範圍從1×(512個特徵)到256×(131,072個特徵)。

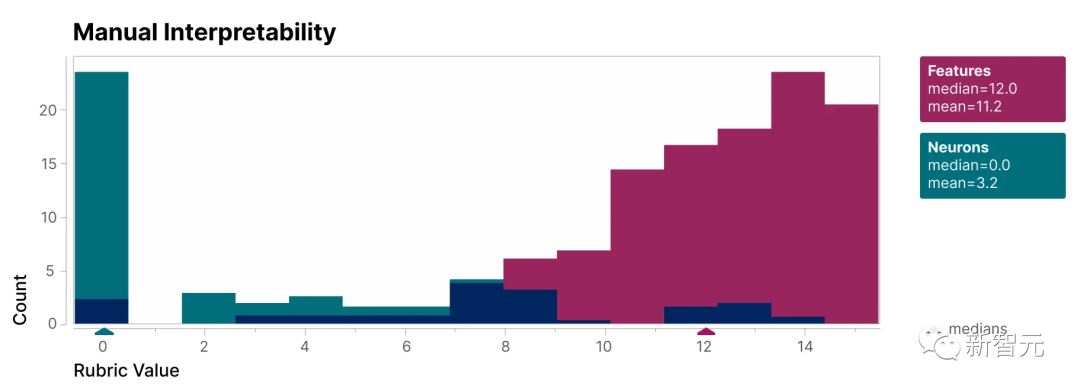

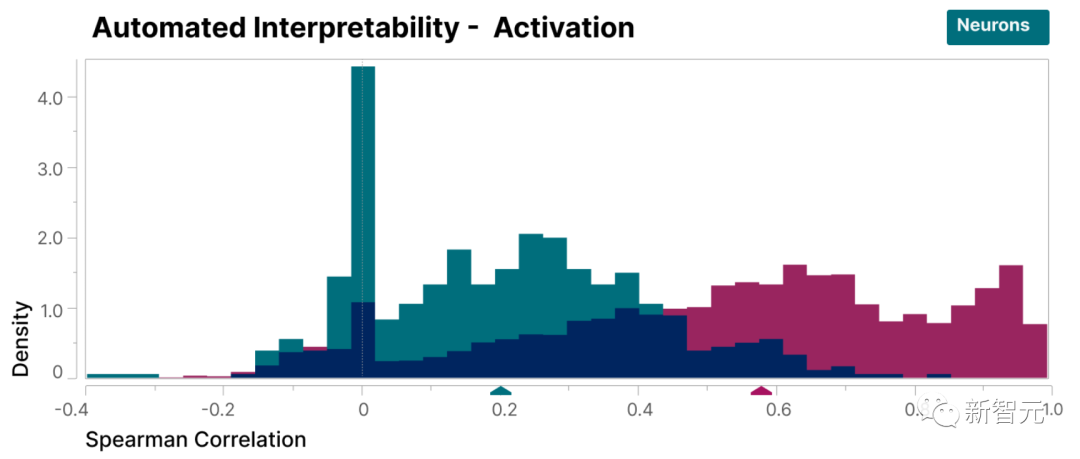

為了驗證本研究發現的特徵比模型的神經元更具可解釋性,我們進行了盲審評估,讓一位人類評估員對它們的可解釋性進行評分

可以看到,特徵(紅色)的得分比神經元(青色)高得多。

研究人員發現的特徵相對於模型內部的神經元來說更容易理解,這一點已經被證明

#此外,研究人員還採用了「自動解釋性」方法,透過使用大型語言模型產生小型模型特徵的簡短描述,並讓另一個模型根據該描述預測特徵激活的能力對其進行評分。

同樣,特徵得分高於神經元,證明了特徵的活化及其對模型行為的下游影響具有一致的解釋。

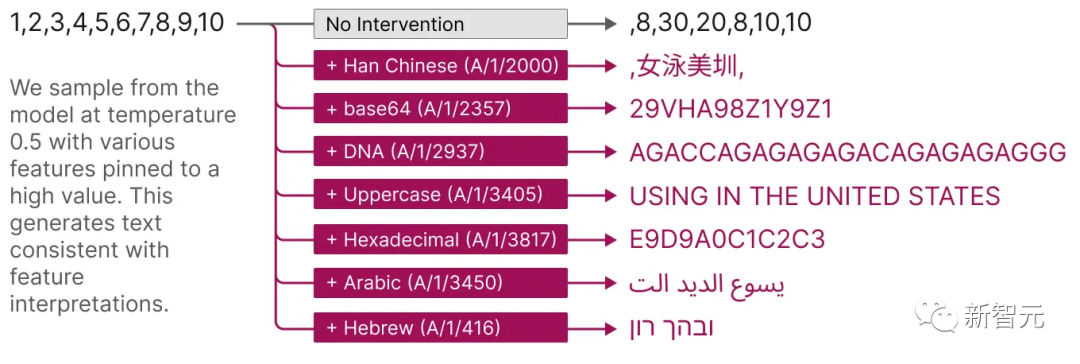

並且,這些擷取的特徵也提供了一種有針對性的方法來引導模型。

如下圖所示,人為啟動特徵會導致模型行為以可預測的方式變更。

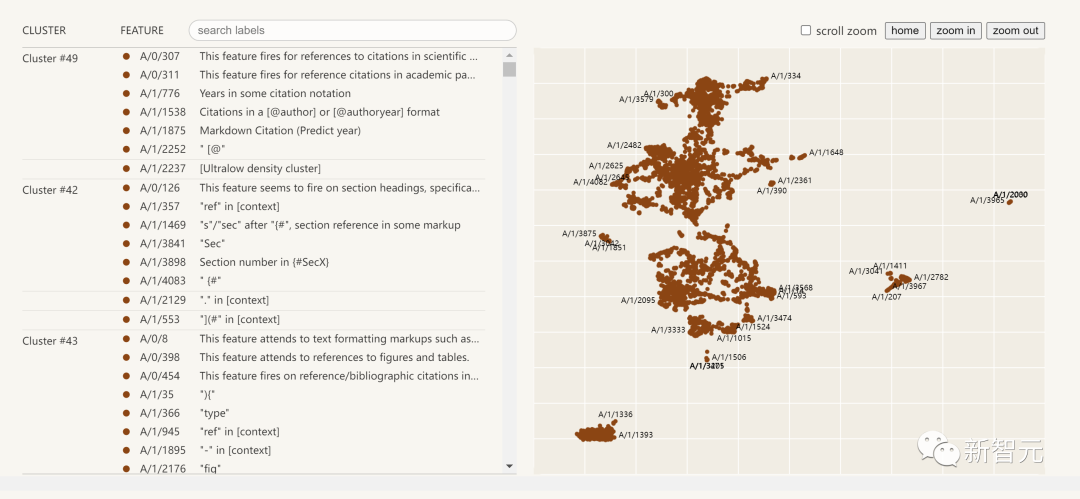

以下是提取出的可解釋性特徵的視覺化圖:

點擊左邊的特徵列表,您可以與神經網路中的特徵空間進行互動式探索

#研究報告摘要

這份來自Anthropic的研究報告,Towards Monosemanticity: Decomposing Language Models With Dictionary Learning,主要可以分為四個部分。

問題設置,研究人員介紹了研究動機,並闡述訓練的transfomer和稀疏自動編碼器。

單一特徵詳細調查,證明了研究發現的幾個特徵是功能上特定的因果單元。

透過全域分析,我們得出結論,典型特徵是可以解釋的,並且它們能夠解釋MLP層的重要組成部分

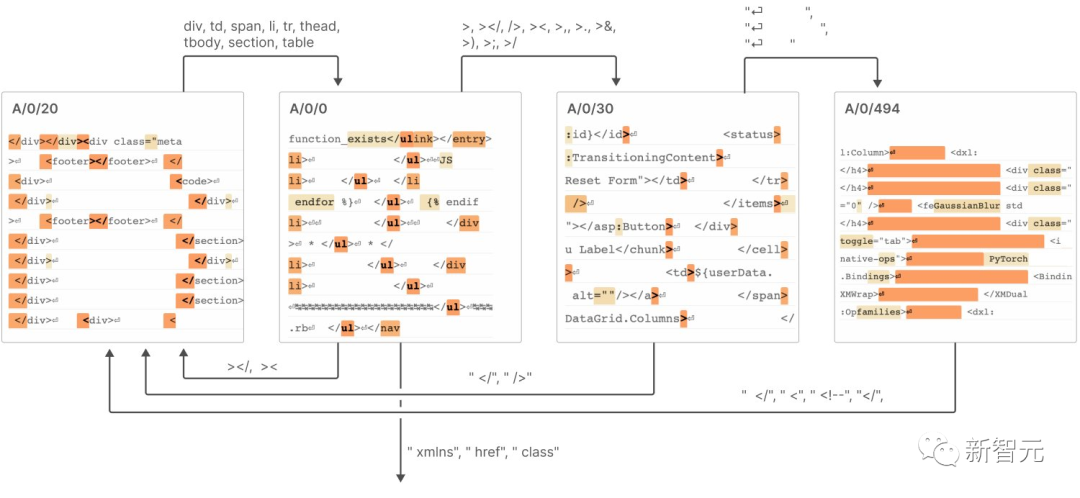

現象分析,描述了特徵的幾個屬性,包括特徵分割、普遍性,以及它們如何形成類似於「有限狀態自動機」的系統來實現複雜的行為。

結論包括以下7個:

稀疏自動編碼器具有提取相對單一的語意特徵的能力

#稀疏自編碼器能夠產生可解釋的特徵,而這些特徵在神經元的基礎中實際上是不可見的

3. 稀疏自動編碼器特徵可用於介入和引導變壓器的生成。

4. 稀疏自編碼器能產生相對通用的特徵。

隨著自動編碼器大小的增加,特徵有「分裂」的傾向。 重寫後:隨著自動編碼器尺寸的增加,特徵呈現出“分裂”的趨勢

#6. 只需512個神經元即可表示成千上萬個特徵

7. 這些特徵透過連結在一起,類似於「有限狀態自動機」的系統,實現了複雜的行為,如下圖所示

##具體詳細內容可見報告。

Anthropic認為,要將本研究報告中小模型的成功複製到更大的模型上,我們今後面臨的挑戰將不再是科學問題,而是工程問題

為了在大型模型上實現解釋性,需要在工程領域投入更多的努力和資源,以克服模型複雜性和規模帶來的挑戰

包括開發新的工具、技術和方法,以應對模型複雜性和資料規模的挑戰;也包括建立可擴展的解釋性框架和工具,以適應大規模模型的需求。

這將成為解釋性人工智慧和大規模深度學習研究領域的最新趨勢#

以上是打破大模型黑盒,徹底分解神經元! OpenAI對頭Anthropic擊破AI不可解釋性障礙的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

開源!超越ZoeDepth! DepthFM:快速且精確的單目深度估計!

Apr 03, 2024 pm 12:04 PM

開源!超越ZoeDepth! DepthFM:快速且精確的單目深度估計!

Apr 03, 2024 pm 12:04 PM

0.這篇文章乾了啥?提出了DepthFM:一個多功能且快速的最先進的生成式單目深度估計模型。除了傳統的深度估計任務外,DepthFM還展示了在深度修復等下游任務中的最先進能力。 DepthFM效率高,可以在少數推理步驟內合成深度圖。以下一起來閱讀這項工作~1.論文資訊標題:DepthFM:FastMonocularDepthEstimationwithFlowMatching作者:MingGui,JohannesS.Fischer,UlrichPrestel,PingchuanMa,Dmytr

使用ddrescue在Linux上恢復數據

Mar 20, 2024 pm 01:37 PM

使用ddrescue在Linux上恢復數據

Mar 20, 2024 pm 01:37 PM

DDREASE是一種用於從檔案或區塊裝置(如硬碟、SSD、RAM磁碟、CD、DVD和USB儲存裝置)復原資料的工具。它將資料從一個區塊設備複製到另一個區塊設備,留下損壞的資料區塊,只移動好的資料區塊。 ddreasue是一種強大的恢復工具,完全自動化,因為它在恢復操作期間不需要任何干擾。此外,由於有了ddasue地圖文件,它可以隨時停止和恢復。 DDREASE的其他主要功能如下:它不會覆寫恢復的數據,但會在迭代恢復的情況下填補空白。但是,如果指示工具明確執行此操作,則可以將其截斷。將資料從多個檔案或區塊還原到單

如何多條件使用Excel過濾功能

Feb 26, 2024 am 10:19 AM

如何多條件使用Excel過濾功能

Feb 26, 2024 am 10:19 AM

如果您需要了解如何在Excel中使用具有多個條件的篩選功能,以下教學將引導您完成對應步驟,確保您可以有效地篩選資料和排序資料。 Excel的篩選功能是非常強大的,能夠幫助您從大量資料中提取所需的資訊。這個功能可以根據您設定的條件,過濾資料並只顯示符合條件的部分,讓資料的管理變得更有效率。透過使用篩選功能,您可以快速找到目標數據,節省了尋找和整理數據的時間。這個功能不僅可以應用在簡單的資料清單上,還可以根據多個條件進行篩選,幫助您更精準地定位所需資訊。總的來說,Excel的篩選功能是一個非常實用的

Google狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理訓練最快選擇

Apr 01, 2024 pm 07:46 PM

Google狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理訓練最快選擇

Apr 01, 2024 pm 07:46 PM

谷歌力推的JAX在最近的基準測試中表現已經超過Pytorch和TensorFlow,7項指標排名第一。而且測試並不是JAX性能表現最好的TPU上完成的。雖然現在在開發者中,Pytorch依然比Tensorflow更受歡迎。但未來,也許有更多的大型模型會基於JAX平台進行訓練和運行。模型最近,Keras團隊為三個後端(TensorFlow、JAX、PyTorch)與原生PyTorch實作以及搭配TensorFlow的Keras2進行了基準測試。首先,他們為生成式和非生成式人工智慧任務選擇了一組主流

iPhone上的蜂窩數據網路速度慢:修復

May 03, 2024 pm 09:01 PM

iPhone上的蜂窩數據網路速度慢:修復

May 03, 2024 pm 09:01 PM

在iPhone上面臨滯後,緩慢的行動數據連線?通常,手機上蜂窩互聯網的強度取決於幾個因素,例如區域、蜂窩網絡類型、漫遊類型等。您可以採取一些措施來獲得更快、更可靠的蜂窩網路連線。修復1–強制重啟iPhone有時,強制重啟設備只會重置許多內容,包括蜂窩網路連線。步驟1–只需按一次音量調高鍵並放開即可。接下來,按降低音量鍵並再次釋放它。步驟2–過程的下一部分是按住右側的按鈕。讓iPhone完成重啟。啟用蜂窩數據並檢查網路速度。再次檢查修復2–更改資料模式雖然5G提供了更好的網路速度,但在訊號較弱

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人Optimus最新影片出爐,已經可以在工廠裡打工了。正常速度下,它分揀電池(特斯拉的4680電池)是這樣的:官方還放出了20倍速下的樣子——在小小的「工位」上,揀啊揀啊揀:這次放出的影片亮點之一在於Optimus在廠子裡完成這項工作,是完全自主的,全程沒有人為的干預。而且在Optimus的視角之下,它還可以把放歪了的電池重新撿起來放置,主打一個自動糾錯:對於Optimus的手,英偉達科學家JimFan給出了高度的評價:Optimus的手是全球五指機器人裡最靈巧的之一。它的手不僅有觸覺

超級智能體生命力覺醒!可自我更新的AI來了,媽媽再也不用擔心資料瓶頸難題

Apr 29, 2024 pm 06:55 PM

超級智能體生命力覺醒!可自我更新的AI來了,媽媽再也不用擔心資料瓶頸難題

Apr 29, 2024 pm 06:55 PM

哭死啊,全球狂煉大模型,一網路的資料不夠用,根本不夠用。訓練模型搞得跟《飢餓遊戲》似的,全球AI研究者,都在苦惱怎麼才能餵飽這群資料大胃王。尤其在多模態任務中,這問題尤其突出。一籌莫展之際,來自人大系的初創團隊,用自家的新模型,率先在國內把「模型生成數據自己餵自己」變成了現實。而且還是理解側和生成側雙管齊下,兩側都能產生高品質、多模態的新數據,對模型本身進行數據反哺。模型是啥?中關村論壇上剛露面的多模態大模型Awaker1.0。團隊是誰?智子引擎。由人大高瓴人工智慧學院博士生高一鑷創立,高

阿里7B多模態文件理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

阿里7B多模態文件理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

多模態文件理解能力新SOTA!阿里mPLUG團隊發布最新開源工作mPLUG-DocOwl1.5,針對高解析度圖片文字辨識、通用文件結構理解、指令遵循、外部知識引入四大挑戰,提出了一系列解決方案。話不多說,先來看效果。複雜結構的圖表一鍵識別轉換為Markdown格式:不同樣式的圖表都可以:更細節的文字識別和定位也能輕鬆搞定:還能對文檔理解給出詳細解釋:要知道,“文檔理解”目前是大語言模型實現落地的一個重要場景,市面上有許多輔助文檔閱讀的產品,有的主要透過OCR系統進行文字識別,配合LLM進行文字理