強化學習中的獎勵函數設計問題

強化學習中的獎勵函數設計問題

引言

強化學習是一種透過智能體與環境的互動來學習最佳策略的方法。在強化學習中,獎勵函數的設計對於智能體的學習效果至關重要。本文將探討強化學習中的獎勵函數設計問題,並提供具體程式碼範例。

- 獎勵函數的作用及目標

獎勵函數是強化學習中的重要組成部分,用來評估智能體在某一狀態下所獲得的獎勵值。它的設計有助於引導智能體透過選擇最優行動來最大化長期累積獎勵。

一個好的獎勵函數應具備以下兩個目標:

(1) 提供足夠的資訊使得智能體能夠學習到最優策略;

(2) 透過適當的獎勵回饋,指導智能體避免無效和有害的行為。

- 獎勵函數設計的挑戰

獎勵函數的設計可能面臨以下挑戰:

(1) 稀疏性:在某些情況下,環境的獎勵訊號可能很稀疏,導致學習過程變慢或不穩定。

(2) 誤導性:不正確或不充分的獎勵訊號可能導致智能體學習到錯誤的策略。

(3) 高維度:在具有大量狀態和動作的複雜環境中,設計獎勵函數變得更加困難。

(4) 目標衝突:不同的目標可能會導致獎勵函數設計的衝突,例如短期與長期目標的平衡。 - 獎勵函數設計的方法

為了克服獎勵函數設計中的挑戰,可以採用以下方法:

(1) 手動設計:根據先驗知識和經驗,手動設計獎勵函數。這種方法通常適用於簡單的問題,但對於複雜問題可能會面臨挑戰。

(2) 獎勵工程:透過引入輔助獎勵或懲罰來改善獎勵函數的表現。例如,對某些狀態或動作進行額外的獎勵或懲罰,以便更好地指導智能體學習。

(3) 自適應獎勵函數:採用自適應演算法來動態地調整獎勵函數。這種方法可以透過隨時間推進而改變獎勵函數的權重,以適應不同階段的學習需求。

- 具體程式碼範例

以下是一個使用深度強化學習框架TensorFlow和Keras的範例程式碼,展示了獎勵函數的設計方式:

import numpy as np

from tensorflow import keras

# 定义强化学习智能体的奖励函数

def reward_function(state, action):

# 根据当前状态和动作计算奖励值

reward = 0

# 添加奖励和惩罚条件

if state == 0 and action == 0:

reward += 1

elif state == 1 and action == 1:

reward -= 1

return reward

# 定义强化学习智能体的神经网络模型

def create_model():

model = keras.Sequential([

keras.layers.Dense(64, activation='relu', input_shape=(2,)),

keras.layers.Dense(64, activation='relu'),

keras.layers.Dense(1)

])

model.compile(optimizer='adam', loss='mean_squared_error')

return model

# 训练智能体

def train_agent():

model = create_model()

# 智能体的训练过程

for episode in range(num_episodes):

state = initial_state

# 智能体根据当前策略选择动作

action = model.predict(state)

# 获得当前状态下的奖励值

reward = reward_function(state, action)

# 更新模型的权重

model.fit(state, reward)在上述在程式碼中,我們透過定義reward_function函數來設計獎勵函數,在訓練智能體時根據目前狀態和動作計算獎勵值。同時,我們使用create_model函數建立了一個神經網路模型來訓練智能體,並使用model.predict函數根據當前策略選擇動作。

結論

強化學習中的獎勵函數設計是一個重要且有挑戰性的問題。正確設計的獎勵函數可以有效地引導智能體學習最優策略。本文透過討論獎勵函數的作用及目標、設計挑戰以及具體程式碼範例,希望能為讀者在強化學習中的獎勵函數設計提供一些參考與啟示。

以上是強化學習中的獎勵函數設計問題的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

使用Panda-Gym的機器臂模擬實現Deep Q-learning強化學習

Oct 31, 2023 pm 05:57 PM

使用Panda-Gym的機器臂模擬實現Deep Q-learning強化學習

Oct 31, 2023 pm 05:57 PM

強化學習(RL)是一種機器學習方法,它允許代理透過試誤來學習如何在環境中表現。行為主體會因為採取行動導致預期結果而獲得獎勵或懲罰。隨著時間的推移,代理人會學會採取行動,以使得其預期回報最大化RL代理通常使用馬可夫決策過程(MDP)進行訓練,MDP是為順序決策問題建模的數學框架。 MDP由四個部分組成:狀態:環境的可能狀態的集合。動作:代理人可以採取的一組動作。轉換函數:在給定當前狀態和動作的情況下,預測轉換到新狀態的機率的函數。獎勵函數:為每次轉換分配獎勵給代理的函數。代理的目標是學習策略函數,

強化學習中的獎勵函數設計問題

Oct 09, 2023 am 11:58 AM

強化學習中的獎勵函數設計問題

Oct 09, 2023 am 11:58 AM

強化學習中的獎勵函數設計問題引言強化學習是一種透過智能體與環境的互動來學習最優策略的方法。在強化學習中,獎勵函數的設計對於智能體的學習效果至關重要。本文將探討強化學習中的獎勵函數設計問題,並提供具體程式碼範例。獎勵函數的作用及目標獎勵函數是強化學習中的重要組成部分,用來評估智能體在某一狀態下所獲得的獎勵值。它的設計有助於引導智能體透過選擇最優行動來最大化長期累

C++中的深度強化學習技術

Aug 21, 2023 pm 11:33 PM

C++中的深度強化學習技術

Aug 21, 2023 pm 11:33 PM

深度強化學習技術是人工智慧領域備受關注的一個分支,目前在贏得多個國際競賽的同時也被廣泛應用於個人助理、自動駕駛、遊戲智慧等領域。而在實現深度強化學習的過程中,C++作為一種高效率、優秀的程式語言,在硬體資源有限的情況下尤其重要。深度強化學習,顧名思義,結合了深度學習和強化學習兩個領域的技術。簡單理解,深度學習是指透過建立多層神經網絡,從數據中學習特徵並進行決策

如何使用 Go 語言進行深度強化學習研究?

Jun 10, 2023 pm 02:15 PM

如何使用 Go 語言進行深度強化學習研究?

Jun 10, 2023 pm 02:15 PM

深度強化學習(DeepReinforcementLearning)是一種結合了深度學習和強化學習的先進技術,被廣泛應用於語音辨識、影像辨識、自然語言處理等領域。 Go語言作為一門快速、有效率、可靠的程式語言,可以為深度強化學習研究提供幫助。本文將介紹如何使用Go語言進行深度強化學習研究。一、安裝Go語言和相關函式庫在開始使用Go語言進行深度強化學習

使用Actor-Critic的DDPG強化學習演算法控制雙關節機械手臂

May 12, 2023 pm 09:55 PM

使用Actor-Critic的DDPG強化學習演算法控制雙關節機械手臂

May 12, 2023 pm 09:55 PM

在本文中,我們將介紹在Reacher環境中訓練智慧代理控制雙關節機械手臂,這是一種使用UnityML-Agents工具包開發的基於Unity的模擬程式。我們的目標是高精準度的到達目標位置,所以這裡我們可以使用專為連續狀態和動作空間設計的最先進的DeepDeterministicPolicyGradient(DDPG)演算法。現實世界的應用程式機械手臂在製造業、生產設施、空間探索和搜救行動中發揮關鍵作用。控制機械手臂的高精度和靈活性是非常重要的。透過採用強化學習技術,可以使這些機器人系統即時學習並調整其行

再掀強化學習變革! DeepMind提出「演算法蒸餾」:可探索的預訓練強化學習Transformer

Apr 12, 2023 pm 06:58 PM

再掀強化學習變革! DeepMind提出「演算法蒸餾」:可探索的預訓練強化學習Transformer

Apr 12, 2023 pm 06:58 PM

在當下的序列建模任務上,Transformer可謂是最強大的神經網路架構,並且經過預先訓練的Transformer模型可以將prompt作為條件或上下文學習(in-context learning)適應不同的下游任務。大型預訓練Transformer模型的泛化能力已經在多個領域得到驗證,例如文字補全、語言理解、圖像生成等等。從去年開始,已經有相關工作證明,透過將離線強化學習(offline RL)視為序列預測問題,那麼模型就可以從離線資料中學習策略。但目前的方法要不是從不包含學習的數據中學習策略

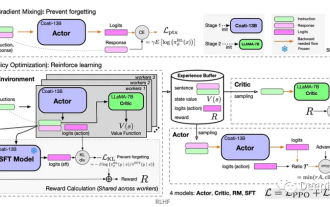

如何運用強化學習來提升快手用戶留存?

May 07, 2023 pm 06:31 PM

如何運用強化學習來提升快手用戶留存?

May 07, 2023 pm 06:31 PM

短視頻推薦系統的核心目標是透過提升用戶留存,牽引DAU成長。因此留存是各APP的核心業務優化指標之一。然而留存是使用者和系統多次互動後的長期回饋,很難分解到單一item或單一list,因此傳統的point-wise和list-wise模型難以直接優化留存。強化學習(RL)方法透過和環境互動的方式優化長期獎勵,適合直接優化用戶留存。此工作將留存優化問題建模成一個無窮視野請求粒度的馬爾科夫決策過程(MDP),使用者每次請求推薦系統決策一個動作(action),用於聚合多個不同的短期回饋預估(觀看時長、

強化學習再登Nature封面,自動駕駛安全驗證新典範大幅減少測試里程

Mar 31, 2023 pm 10:38 PM

強化學習再登Nature封面,自動駕駛安全驗證新典範大幅減少測試里程

Mar 31, 2023 pm 10:38 PM

引入密集強化學習,以 AI 驗證 AI。自動駕駛汽車 (AV) 技術的快速發展,使得我們正處於交通革命的風口浪尖,其規模是自一個世紀前汽車問世以來從未見過的。自動駕駛技術具有顯著提高交通安全性、機動性和永續性的潛力,因此引起了工業界、政府機構、專業組織和學術機構的共同關注。在過去 20 年裡,自動駕駛汽車的發展取得了長足的進步,尤其是隨著深度學習的出現更是如此。到 2015 年,開始有公司宣布他們將在 2020 之前量產 AV。不過到目前為止,並且沒有 level 4 等級的 AV 可以在市場