文生3D模型大突破! MVDream重磅來襲,一句話生成超逼真三維模型

這真是太不可思議了!

現在只需打幾個字就能輕鬆地創造出精美而高品質的3D模型了?

這不,國外一篇部落格引爆網絡,把一個叫MVDream的東西擺到了我們面前。

用戶只要寥寥數語,就可以創造出一個栩栩如生的3D模型。

而且和之前不同的是,MVDream看起來是真的「懂」物理。

下面就來看看這個MVDream有多神奇吧~

MVDream

小哥表示,大模型時代,我們已經看到太多太多文字生成模型、圖片產生模型了。而且這些模型的性能也越來越強大。

我們後來也親眼目睹了文生視訊模型的誕生,當然還有今天要提到的3D模型

想像一下,只需輸入一句話,就能生成一個彷彿真實世界中存在的物體模型,甚至還包含所有必要的細節,這樣的場景有多酷啊

而且這絕對不是一件簡單的事,尤其是使用者需要產生的模型所呈現的細節要夠逼真。

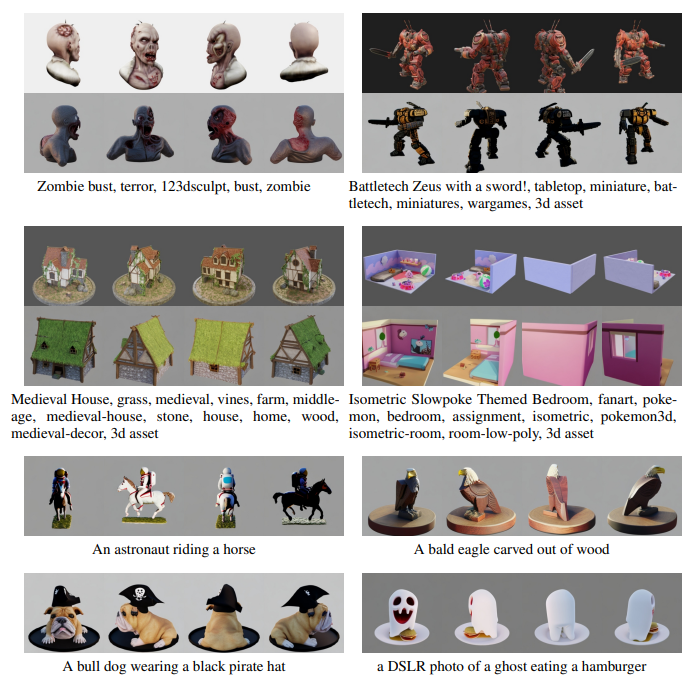

先來看看效果~

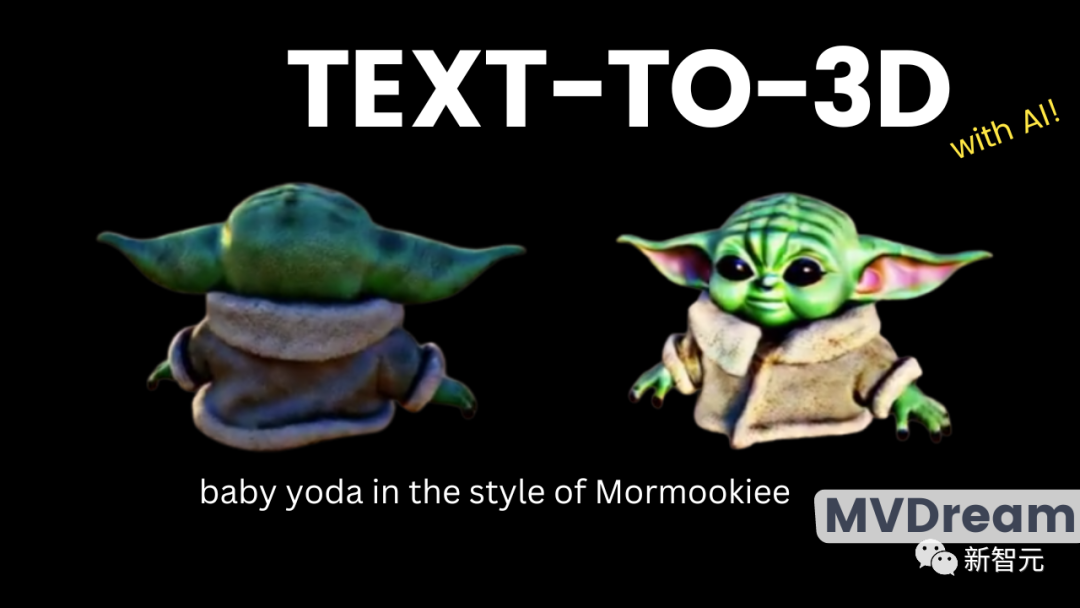

在同在一個提示下,最右邊展示的是MVDream的成品

肉眼可見5個模型的差距。前幾個模型完全違背了客觀事實,只有從某幾個角度看才是對的。

例如前四張圖片,生成的模型居然有不只兩隻耳朵。而第四張圖片雖然看起來細節更豐滿一點,但是轉到某個角度我們能發現,人物的臉是凹進去的,上面還插著一隻耳朵。

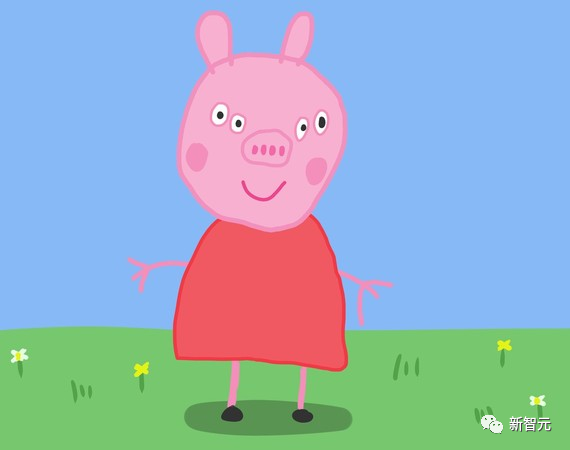

誰懂啊,小編一下就想起了之前很火的小豬佩琪正面視圖。

這是一種情況,從某些角度來看是向你展示的,但絕對不能從其他角度去看,會有生命危險

可最右邊MVDream的生成模型顯然不一樣。無論3D模型怎麼轉動,你都不會覺得有任何反常規的地方。

這也就是之前提到的,MVDream對物理常識瞭如指掌,不會為了確保每個視圖都有兩隻耳朵而製造一些奇怪的東西

小哥指出,判斷3D模型是否成功的關鍵在於觀察其不同視角是否逼真且品質是否高

而且還要保證模型在空間上的連貫性,而不是像上面多個耳朵的模型。

產生3D模型的主要方法之一,就是將攝影機的視角模擬,然後產生某一視角下所能看到的東西。

換個詞,這就是所謂的2D提升(2D lifting)。就是將不同的視角拼接在一起,形成最終的3D模型。

出現上面多耳的情況,就是因為生成模型對整個物體在三維空間的樣態資訊掌握的不充分。而MVDream恰恰就是在這方面往前邁了一大步。

這個新模型解決了先前一直存在的3D視角下的一致性問題

分數蒸餾取樣

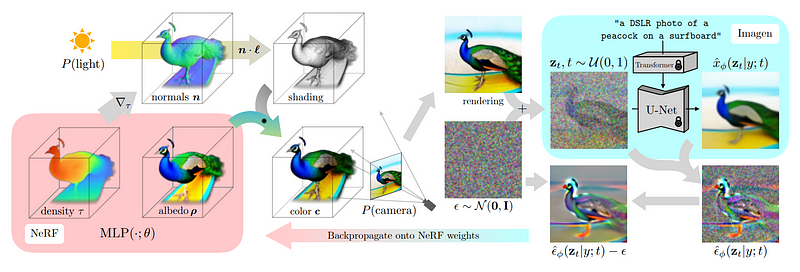

這種方法稱為分數蒸餾採樣(score distillation sampling),是由DreamFusion開發的

在開始學習分數蒸餾採樣技術之前,我們需要先了解一下該方法所採用的架構

換句話說,這其實只是另一個二維影像擴散模型,類似的還有DALLE、MidJourney和Stable Diffusion模型

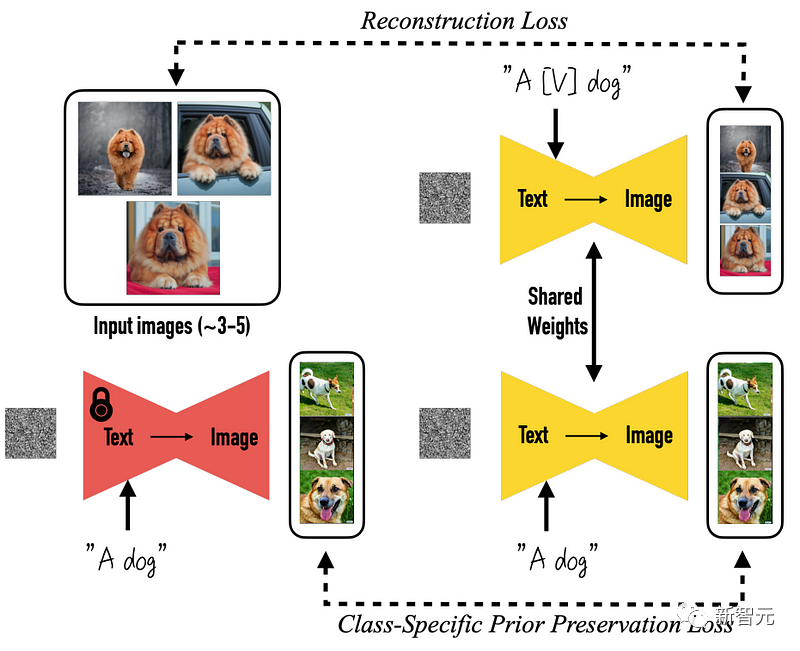

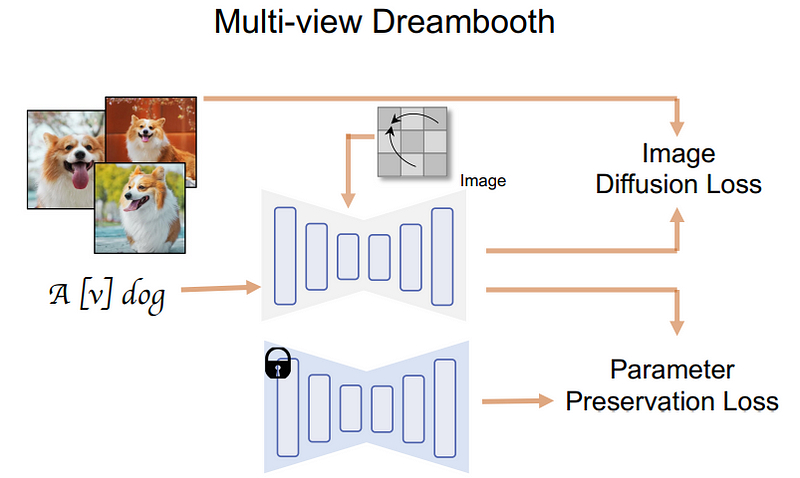

更具體地說,一切的一切都是從預先訓練好的DreamBooth模型開始的,DreamBooth是一個基於Stable Diffusion生圖的開源模型。

改變來了,這意味著事情發生了轉變

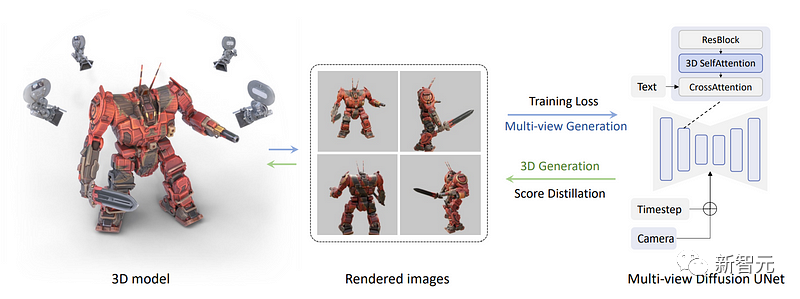

##研究團隊後續所做的是,直接渲染一組多視角影像,而不是只渲染一張影像,這一步需要有各種物件的三維資料集才可以完成。

在這裡,研究人員從資料集中獲取了三維物件的多個視圖,利用它們來訓練模型,再使其向後產生這些視圖。

具體做法是將下圖中的藍色自註意區塊改為三維自註意區塊,也就是說,研究人員只需要增加一個維度來重建多個影像,而不是一個圖像。

在下圖中,我們可以看到每個視圖的模型中都輸入了攝影機和時間步(timestep),以幫助模型了解哪個影像將用在哪裡,以及需要生成的是哪個視圖

現在,所有圖像都連接在一起,生成也同樣在一起完成。因此它們就可以共享訊息,更好地理解全局的情況。

首先,將文字輸入模型,然後透過訓練模型從資料集中準確地重建物件

##而這裡也就是研究團隊應用多視圖分數蒸餾採樣過程的地方。

接下來,我們需要使用這些視圖來重建一個與真實世界一致的三維模型,而不僅僅是視圖

這裡需要使用NeRF(neural radiance fields,神經輻射場)來實現,就像前面提到的DreamFusion一樣。

#在初始渲染的指導下,研究人員開始使用多視角擴散模型生成一些帶有噪聲的初始圖像版本

為了讓模型了解到需要生成不同版本的圖像,研究人員添加了噪聲,但同時仍然能夠接收到背景資訊

#接下來,可以利用這個模型進一步生成更高品質的圖像

添加用於生成該圖像的圖像,並移除我們手動添加的噪聲,以便在下一步中使用該結果來指導和改進NeRF模型。

為了在下一步中產生更好的結果,這些步驟的目的是更好地理解NeRF模型應該集中在圖像的哪個部分

不斷重複這個過程,直到產生一個令人滿意的3D模型

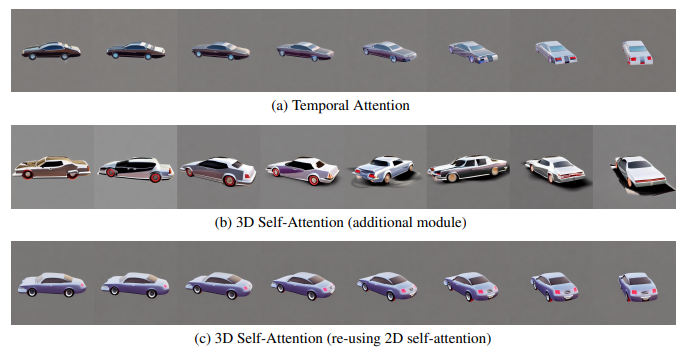

首先,他們比較了用於建立跨視角一致性模型的注意力模組的選擇。

這些選項包括:

(1)在視訊擴散模型中廣泛使用的一維時間自註意;

#(2)在現有模型中增加全新的三維自註意模組;

(3)重新使用現有的二維自註意模組進行三維注意。

為了準確展示這些模組之間的差異,在這項實驗中,研究人員採用了8幀的90度視角變化來訓練模型,以更貼近視訊的設定 #在實驗中,研究團隊同時保持了較高的影像分辨率,即512×512作為原始的標清模型。如下圖所示,研究人員發現,即使在靜態場景中進行瞭如此有限的視角變化,時間自註意力仍然會受到內容偏移的影響,無法保持視角的一致性 ##團隊假設,這是因為時間注意力只能在不同幀的相同像素之間交換訊息,而在視點變化時,對應像素之間可能相距甚遠。 另一方面,在不學習一致性的情況下,增加新的三維注意會導致嚴重的品質下降。 研究人員認為,這是因為從頭開始學習新的參數會消耗更多的訓練資料和時間,而對於這種三維模型有限的情況並不適用。他們提出了重新使用二維自註意機制的策略,以實現最佳的一致性而不降低生成質量 團隊也注意到,如果將圖像大小減小到256 ,視圖數減小到4,這些模組之間的差異會小得多。然而,為了達到最佳一致性,研究人員在以下實驗中根據初步觀察做出了選擇。 此外,研究人員在threestudio(thr)庫中實現了多視角的分數蒸餾採樣,並引入了多視角擴散的引導。該庫在一個統一的框架下實現了最先進的文本到三維模型的生成方法 研究人員使用threestudio中的隱式容積(implicit-volume)作為三維表示的實作方式,其中包括多解析度的雜湊網格(hash-grid) 在研究攝影機視圖時,研究人員採用了與渲染三維資料集時完全相同的方式對攝影機進行了倆採樣 在此之外,研究人員還對3D模型進行了10000步的優化,使用了AdamW優化器,並將學習率設置為0.01 在分數蒸餾取樣中,最初的8000步驟中,最大和最小時間步長分別從0.98步降至0.5步和0.02步 #渲染的起始解析度是64×64,經過5000步逐漸增加至256×256 以下是更多的案例: 研究團隊利用二維文字到圖像模型,進行多重視角合成,並透過迭代的過程,創建了文本到3D模型的方法 這種新方法目前還存在一些局限性,最主要的問題是生成的圖像分辨率只有256x256像素,可以說非常低了 此外,研究人員也指出,執行這項任務的資料集的大小在某種程度上一定會限制這種方法的通用性,因為資料集的太小的話,就沒辦法更逼真的反應我們這個複雜的世界。

以上是文生3D模型大突破! MVDream重磅來襲,一句話生成超逼真三維模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

使用ddrescue在Linux上恢復數據

Mar 20, 2024 pm 01:37 PM

使用ddrescue在Linux上恢復數據

Mar 20, 2024 pm 01:37 PM

DDREASE是一種用於從檔案或區塊裝置(如硬碟、SSD、RAM磁碟、CD、DVD和USB儲存裝置)復原資料的工具。它將資料從一個區塊設備複製到另一個區塊設備,留下損壞的資料區塊,只移動好的資料區塊。 ddreasue是一種強大的恢復工具,完全自動化,因為它在恢復操作期間不需要任何干擾。此外,由於有了ddasue地圖文件,它可以隨時停止和恢復。 DDREASE的其他主要功能如下:它不會覆寫恢復的數據,但會在迭代恢復的情況下填補空白。但是,如果指示工具明確執行此操作,則可以將其截斷。將資料從多個檔案或區塊還原到單

開源!超越ZoeDepth! DepthFM:快速且精確的單目深度估計!

Apr 03, 2024 pm 12:04 PM

開源!超越ZoeDepth! DepthFM:快速且精確的單目深度估計!

Apr 03, 2024 pm 12:04 PM

0.這篇文章乾了啥?提出了DepthFM:一個多功能且快速的最先進的生成式單目深度估計模型。除了傳統的深度估計任務外,DepthFM還展示了在深度修復等下游任務中的最先進能力。 DepthFM效率高,可以在少數推理步驟內合成深度圖。以下一起來閱讀這項工作~1.論文資訊標題:DepthFM:FastMonocularDepthEstimationwithFlowMatching作者:MingGui,JohannesS.Fischer,UlrichPrestel,PingchuanMa,Dmytr

Google狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理訓練最快選擇

Apr 01, 2024 pm 07:46 PM

Google狂喜:JAX性能超越Pytorch、TensorFlow!或成GPU推理訓練最快選擇

Apr 01, 2024 pm 07:46 PM

谷歌力推的JAX在最近的基準測試中表現已經超過Pytorch和TensorFlow,7項指標排名第一。而且測試並不是JAX性能表現最好的TPU上完成的。雖然現在在開發者中,Pytorch依然比Tensorflow更受歡迎。但未來,也許有更多的大型模型會基於JAX平台進行訓練和運行。模型最近,Keras團隊為三個後端(TensorFlow、JAX、PyTorch)與原生PyTorch實作以及搭配TensorFlow的Keras2進行了基準測試。首先,他們為生成式和非生成式人工智慧任務選擇了一組主流

你好,電動Atlas!波士頓動力機器人復活,180度詭異動作嚇到馬斯克

Apr 18, 2024 pm 07:58 PM

你好,電動Atlas!波士頓動力機器人復活,180度詭異動作嚇到馬斯克

Apr 18, 2024 pm 07:58 PM

波士頓動力Atlas,正式進入電動機器人時代!昨天,液壓Atlas剛「含淚」退出歷史舞台,今天波士頓動力就宣布:電動Atlas上崗。看來,在商用人形機器人領域,波士頓動力是下定決心要跟特斯拉硬剛一把了。新影片放出後,短短十幾小時內,就已經有一百多萬觀看。舊人離去,新角色登場,這是歷史的必然。毫無疑問,今年是人形機器人的爆發年。網友銳評:機器人的進步,讓今年看起來像人類的開幕式動作、自由度遠超人類,但這真不是恐怖片?影片一開始,Atlas平靜地躺在地上,看起來應該是仰面朝天。接下來,讓人驚掉下巴

iPhone上的蜂窩數據網路速度慢:修復

May 03, 2024 pm 09:01 PM

iPhone上的蜂窩數據網路速度慢:修復

May 03, 2024 pm 09:01 PM

在iPhone上面臨滯後,緩慢的行動數據連線?通常,手機上蜂窩互聯網的強度取決於幾個因素,例如區域、蜂窩網絡類型、漫遊類型等。您可以採取一些措施來獲得更快、更可靠的蜂窩網路連線。修復1–強制重啟iPhone有時,強制重啟設備只會重置許多內容,包括蜂窩網路連線。步驟1–只需按一次音量調高鍵並放開即可。接下來,按降低音量鍵並再次釋放它。步驟2–過程的下一部分是按住右側的按鈕。讓iPhone完成重啟。啟用蜂窩數據並檢查網路速度。再次檢查修復2–更改資料模式雖然5G提供了更好的網路速度,但在訊號較弱

超級智能體生命力覺醒!可自我更新的AI來了,媽媽再也不用擔心資料瓶頸難題

Apr 29, 2024 pm 06:55 PM

超級智能體生命力覺醒!可自我更新的AI來了,媽媽再也不用擔心資料瓶頸難題

Apr 29, 2024 pm 06:55 PM

哭死啊,全球狂煉大模型,一網路的資料不夠用,根本不夠用。訓練模型搞得跟《飢餓遊戲》似的,全球AI研究者,都在苦惱怎麼才能餵飽這群資料大胃王。尤其在多模態任務中,這問題尤其突出。一籌莫展之際,來自人大系的初創團隊,用自家的新模型,率先在國內把「模型生成數據自己餵自己」變成了現實。而且還是理解側和生成側雙管齊下,兩側都能產生高品質、多模態的新數據,對模型本身進行數據反哺。模型是啥?中關村論壇上剛露面的多模態大模型Awaker1.0。團隊是誰?智子引擎。由人大高瓴人工智慧學院博士生高一鑷創立,高

快手版Sora「可靈」開放測試:生成超120s視頻,更懂物理,複雜運動也能精準建模

Jun 11, 2024 am 09:51 AM

快手版Sora「可靈」開放測試:生成超120s視頻,更懂物理,複雜運動也能精準建模

Jun 11, 2024 am 09:51 AM

什麼?瘋狂動物城被國產AI搬進現實了?與影片一同曝光的,是一款名為「可靈」全新國產影片生成大模型。 Sora利用了相似的技術路線,結合多項自研技術創新,生產的影片不僅運動幅度大且合理,還能模擬物理世界特性,具備強大的概念組合能力與想像。數據上看,可靈支持生成長達2分鐘的30fps的超長視頻,分辨率高達1080p,且支援多種寬高比。另外再劃個重點,可靈不是實驗室放出的Demo或影片結果演示,而是短影片領域頭部玩家快手推出的產品級應用。而且主打一個務實,不開空頭支票、發布即上線,可靈大模型已在快影

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人Optimus最新影片出爐,已經可以在工廠裡打工了。正常速度下,它分揀電池(特斯拉的4680電池)是這樣的:官方還放出了20倍速下的樣子——在小小的「工位」上,揀啊揀啊揀:這次放出的影片亮點之一在於Optimus在廠子裡完成這項工作,是完全自主的,全程沒有人為的干預。而且在Optimus的視角之下,它還可以把放歪了的電池重新撿起來放置,主打一個自動糾錯:對於Optimus的手,英偉達科學家JimFan給出了高度的評價:Optimus的手是全球五指機器人裡最靈巧的之一。它的手不僅有觸覺