今天跟大家聊一聊大模型在時間序列預測的應用。隨著大模型在NLP領域的發展,越來越多的工作嘗試將大模型應用到時間序列預測領域。這篇文章介紹了大模型應用到時間序列預測的主要方法,並彙整了一些近期相關的工作,幫助大家理解大模型時代時間序列預測的研究方法。

最近三個月湧現了很多大模型做時間序列預測的工作,基本上可以分為2種類型。

重寫後的內容:一種方法是直接使用NLP的大型模型進行時間序列預測。在這種方法中,使用GPT、Llama等NLP大型模型來進行時間序列預測,關鍵在於如何將時間序列資料轉換為適合大型模型輸入的資料

第二種是訓練時間序列領域的大模型。這類方法中,使用大量的時間序列資料集,共同訓練一個時間序列領域的GPT或Llama等大模型,並用於下游時間序列任務。

針對上述兩類方法,以下將分別為大家介紹幾篇相關的經典大模型時間序列代表工作。

這種方法是最早出現的一批大型模型時間序列預測工作

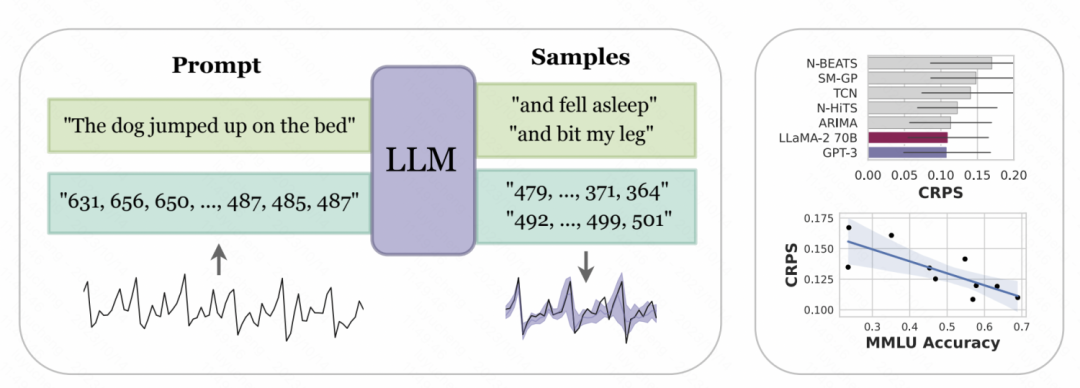

#紐約大學和卡內基梅隆大學合作發表的論文《大型語言模型作為零樣本時間序列預測器》中,透過對時間序列的數字表示進行了tokenize的設計,以便轉換成GPT、LLaMa等大型模型可以識別的輸入。由於不同的大型模式對數字的tokenize方式不同,因此在使用不同的模型時需要進行個人化處理。例如,GPT會將一串數字分割成不同的子序列,這會影響模型的學習。因此,本文在數字之間強制添加了一個空格,以適應GPT的輸入格式。而對於LLaMa等最近發布的大型模型,一般會將單獨的數字進行分割,因此不再需要添加空格。同時,為了避免時間序列數值過大導致輸入序列過長,文中進行了一些縮放操作,將原始時間序列的值限定在一個較合理的範圍內

圖片

圖片

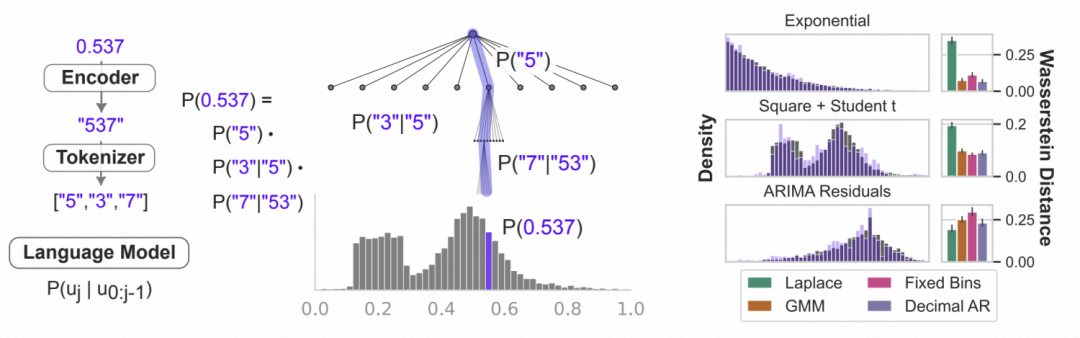

上述處理後的數字字串,輸入到大模型中,讓大模型自迴歸的預測下一個數字,最後再將預測的數字轉換成對應的時間序列數值。下圖中給出了一個示意圖,利用語言模型的條件機率建模數字,就是根據前面的數字預測下一位為各個數字的機率,是一種迭代的層次softmax結構,加上大模型的表徵能力,可以適配各種各樣的分佈類型,這也是大模型可以以這種方式用於時間序列預測的原因。同時,模型對於下一個數字預測的機率,也可以轉換成對不確定性的預測,實現時間序列的不確定性預估。

圖片

圖片

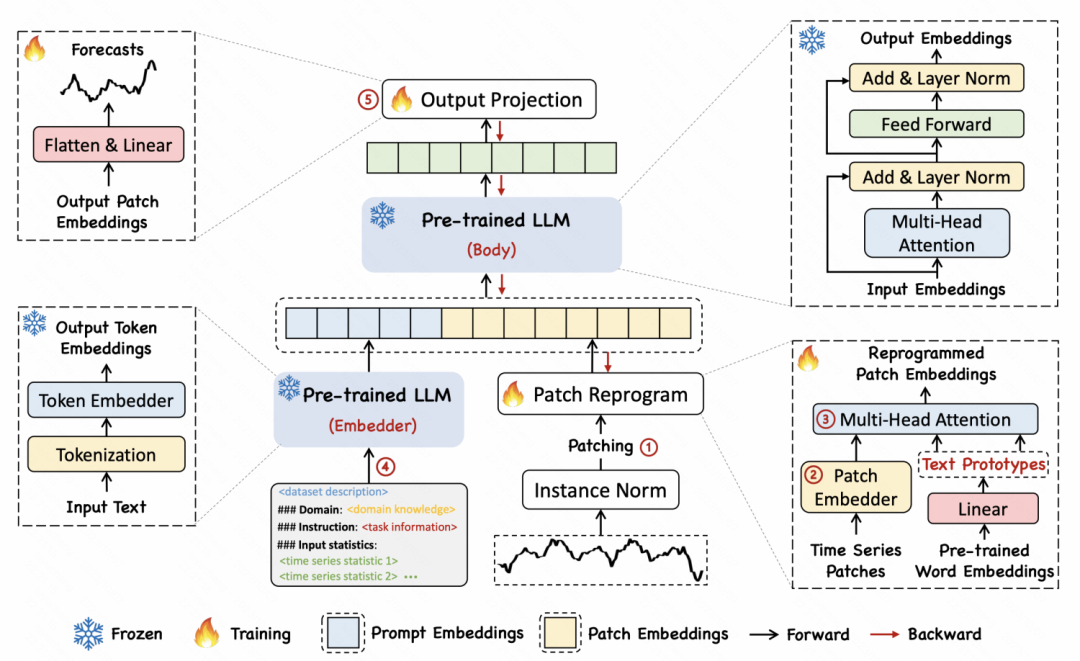

在另一篇名為「TIME-LLM: TIME SERIES FORECASTING BY REPROGRAMMING LARGE LANGUAGE MODELS」的文章中,作者提出了一種重新編程的方法,將時間序列轉換為文本,以實現時間序列和文本這兩種形式之間的對齊

具體實現方法為,首先將時間序列分成多個patch,每個patch透過MLP得到一個embedding。然後,將patch embedding映射到語言模型中的詞向量上,實現時間序列片段和文字的映射和跨模態對齊。文中提出了一種text prototype的思路,將多個字映射到一個prototype,以此來表示一段時間序列patch的語意。例如下圖範例中,shot和up兩個字對應到紅色三角,對應時間序列中短期上升形式子序列的patch。

圖片

圖片

另一個研究方向是參考自然語言處理領域的大模型建構方法,直接建立一個用於時間序列預測的大模型

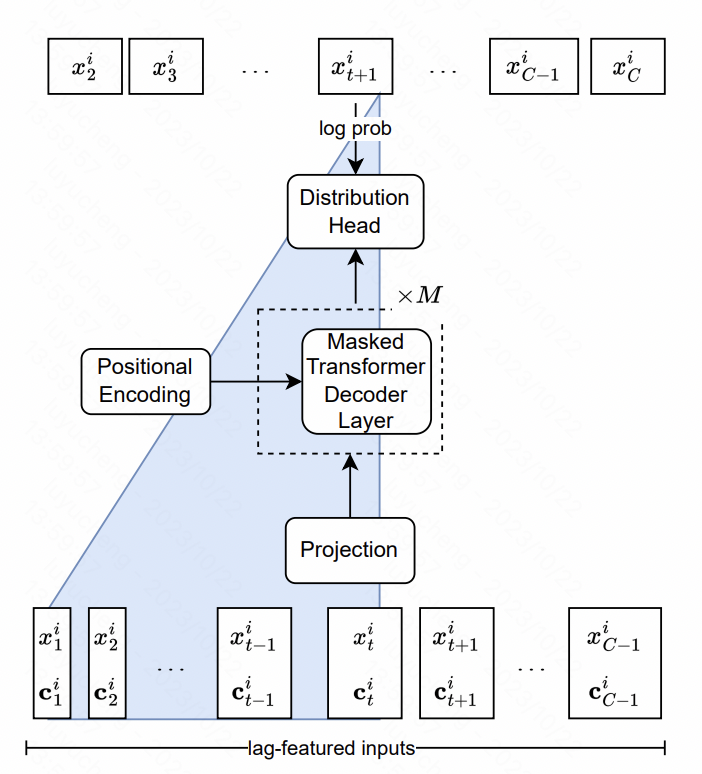

Lag-Llama: Towards Foundation Models for Time Series Forecasting這篇文章搭建了時間序列中的Llama模型。核心包括特徵層面和模型結構層面的設計。

在特徵方面,文中提取了多尺度多類型的lag feature,主要是原始時間序列不同時間視窗的歷史序列統計值。這些序列作為額外的特徵輸入到模型中。在模型結構方面,NLP中的LlaMA結構,核心是Transformer,對其中normalization的方式和position encoding部分做了最佳化。最後的輸出層,使用多個head擬合機率分佈的參數,例如高斯分佈就擬合均值方差,文中採用的是student-t分佈,輸出freedom、mean、scale三個對應參數,最後得到每個時間點的預測機率分佈結果。

圖片

圖片

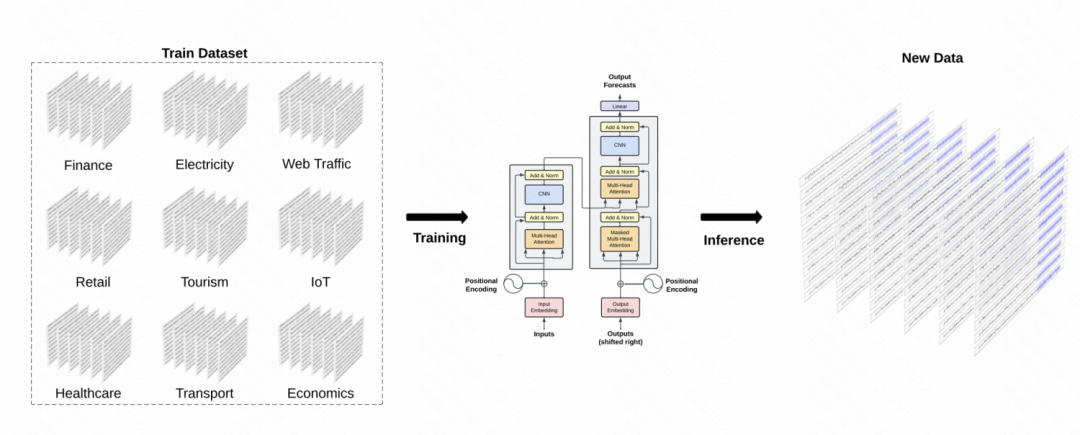

另一個類似的工作是TimeGPT-1,該模型建構了時間序列領域的GPT模型。在數據訓練方面,TimeGPT採用了大量的時間序列數據,總共達到了100億個數據樣本點,涉及多種類型的領域數據。在訓練過程中,採用更大的批量大小和更小的學習率來提高訓練的穩健性。模型主要結構為經典的GPT模型

圖片

圖片

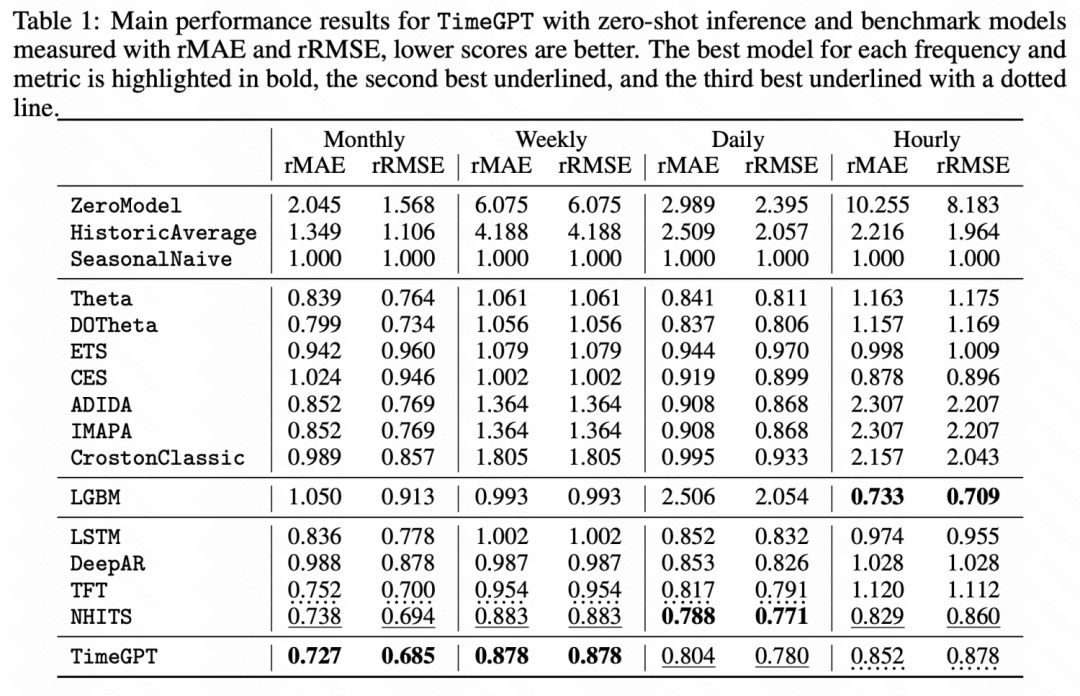

#透過下面的實驗結果也可以看出,在一些零樣本學習任務中,這種時間序列預訓練大模型相比基礎的模型都取得了顯著的效果提升。

圖片

圖片

這篇文章介紹了大模型浪潮下的時間序列預測研究思路,整體包括直接利用NLP大模型做時間序列預測,以及訓練時間序列領域的大模型。無論哪種方法,都向我們展現了大模型 時間序列的潛力,是值得深入研究的方向。

以上是一篇學會大模型浪潮下的時間序列預測的詳細內容。更多資訊請關注PHP中文網其他相關文章!