北大具身智能新成果:無需訓練,聽指令就能靈活走位

北京大學董豪團隊具身導航最新成果來了:

無需額外建圖和訓練,只需說出導航指令,如:

# Walk forward across the room and walk through the panty followed by the kitchen. Stand at the end of the kitchen

我們就能控制機器人靈活移動。

在此,機器人靠的是主動與大模型構成的「專家團隊」溝通完成指令分析、視覺感知、完成估計和決策測試等一系列視覺語言導航關鍵任務。

目前專案首頁和論文都已上線,程式碼即將推出:

北大董豪團隊#提出DiscussNav導航系統。

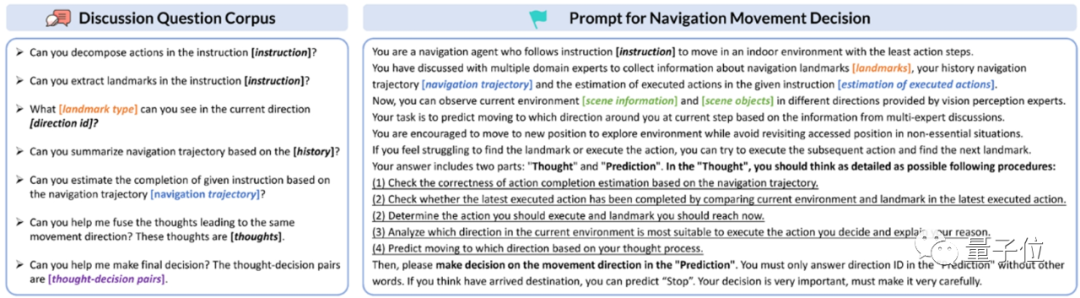

作者首先以提示方式賦予LLM(大語言模型)和MLM(多模態大模型)專家角色和特定任務,激活它們的領域知識和能力,由此建構具備不同專長的視覺導航專家團隊。

在每一步移動前,導航機器人都會與專家討論來理解人類指令中要求的動作和提及的物體標誌。

進而依據這些物體標誌的類型有傾向性地對周圍環境進行感知,指令完成情況估計,由此做出初步的移動決策。

(思維鏈)同時產生N個獨立的預測結果,當這些預測結果之間不一致時,機器人會向決策測試專家求助,篩選出最終的移動決策。

從這個過程我們可以看到,相比傳統方法需要進行額外的預訓練,這個方法透過與大模型專家互動指導機器人根據人類指令移動,直接解決了機器人導航訓練數據稀缺的問題。

更進一步,正是由於這個特點,它也實現了零樣本能力,只要遵循以上討論流程,就能follow多樣的導航指令。 以下是DiscussNav在經典的視覺語言導航資料集Room2Room上的表現。

顯著高於所有零樣本方法,甚至超過兩個經過訓練的方法。

作者進一步在Turtlebot4移動機器人上進行真實室內場景導航實驗。 憑藉專家角色扮演和討論激發出的大模型強大的語言和視覺泛化能力,DiscussNav在真實世界的表現明顯優於之前最優的零樣本方法和經過預訓練微調的方法,展現出良好的sim-to-real遷移能力。

4個強大的能力:

1、識別開放世界物體,例如“白色桌子上的機械手臂”,“椅子上的泰迪熊”。

2、識別細粒度的導航標誌物體,例如“廚房檯面上的植物”,“桌上的紙箱”。

3、修正其它專家在討論中回覆的錯誤訊息,例如標誌提取專家在從導航動作序列提取導航標誌前會檢查並糾正被錯誤分解的動作序列。

4、排除不一致的移動決策,例如決策測試專家可以根據當前環境資訊從DiscussNav預測的多個不一致的移動決策中選擇最合理的一個作為最終移動決定。

「模擬與大模型先驗是Free Lunch」

通訊作者董豪在先前的報告中提出,深入探討如何有效利用模擬資料和大模型從海量資料中學習到的先驗知識是未來具身智能研究的發展方向。

目前受限於資料規模和探索真實環境的高昂成本,具身智慧研究仍將聚焦於模擬平台實驗和模擬資料訓練。

近期大模型的進展為具身智能提供新方向,合理發掘和利用大模型中存在的語言常識和物理世界先驗將推動具身智能發展。

論文網址: https://arxiv.org/abs/2309.11382

#以上是北大具身智能新成果:無需訓練,聽指令就能靈活走位的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

寫在前面今天我們探討下深度學習技術如何改善在複雜環境中基於視覺的SLAM(同時定位與地圖建構)表現。透過將深度特徵提取和深度匹配方法相結合,這裡介紹了一種多功能的混合視覺SLAM系統,旨在提高在諸如低光條件、動態光照、弱紋理區域和嚴重抖動等挑戰性場景中的適應性。我們的系統支援多種模式,包括拓展單目、立體、單目-慣性以及立體-慣性配置。除此之外,也分析如何將視覺SLAM與深度學習方法結合,以啟發其他研究。透過在公共資料集和自採樣資料上的廣泛實驗,展示了SL-SLAM在定位精度和追蹤魯棒性方面優

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

人形機器人Ameca升級第二代了!最近,在世界行動通訊大會MWC2024上,世界上最先進機器人Ameca又現身了。會場周圍,Ameca引來一大波觀眾。得到GPT-4加持後,Ameca能夠對各種問題做出即時反應。 「來一段舞蹈」。當被問及是否有情感時,Ameca用一系列的面部表情做出回應,看起來非常逼真。就在前幾天,Ameca背後的英國機器人公司EngineeredArts剛剛示範了團隊最新的開發成果。影片中,機器人Ameca具備了視覺能力,能看見並描述房間整個狀況、描述具體物體。最厲害的是,她還能

2 個月不見,人形機器人 Walker S 會摺衣服了

Apr 03, 2024 am 08:01 AM

2 個月不見,人形機器人 Walker S 會摺衣服了

Apr 03, 2024 am 08:01 AM

機器之能報道編輯:吳昕國內版的人形機器人+大模型組隊,首次完成疊衣服這類複雜柔性材料的操作任務。隨著融合了OpenAI多模態大模型的Figure01揭開神秘面紗,國內同行的相關進展一直備受關注。就在昨天,國內"人形機器人第一股"優必選發布了人形機器人WalkerS深入融合百度文心大模型後的首個Demo,展示了一些有趣的新功能。現在,得到百度文心大模型能力加持的WalkerS是這個樣子的。和Figure01一樣,WalkerS沒有走動,而是站在桌子後面完成一系列任務。它可以聽從人類的命令,折疊衣物

AI如何使機器人更具自主性和適應性?

Jun 03, 2024 pm 07:18 PM

AI如何使機器人更具自主性和適應性?

Jun 03, 2024 pm 07:18 PM

在工業自動化技術領域,最近有兩個熱點很難被忽視:人工智慧(AI)和英偉達(Nvidia)。不要改變原內容的意思,微調內容,重寫內容,不要續寫:「不僅如此,這兩者密切相關,因為英偉達在不僅僅局限於其最開始的圖形處理單元(GPU),正在將其GPU科技擴展到數位孿生領域,同時緊密連接著新興的AI技術。泰瑞達機器人及其MiR和優傲機器人公司。 Recently,Nvidiahascoll

首個自主完成人類任務機器人出現,五指靈活速度超人,大模型加持虛擬空間訓練

Mar 11, 2024 pm 12:10 PM

首個自主完成人類任務機器人出現,五指靈活速度超人,大模型加持虛擬空間訓練

Mar 11, 2024 pm 12:10 PM

這週,由OpenAI、微軟、貝佐斯和英偉達投資的機器人公司FigureAI宣布獲得接近7億美元的融資,計劃在未來一年內研發出可獨立行走的人形機器人。而特斯拉的擎天柱也屢屢傳出好消息。沒人懷疑,今年會是人形機器人爆發的一年。一家位於加拿大的機器人公司SanctuaryAI最近發布了一款全新的人形機器人Phoenix。官方號稱它能以和人類一樣的速率自主完成許多工作。世界上第一台能以人類速度自主完成任務的機器人Pheonix可以輕輕地抓取、移動並優雅地將每個物件放置在它的左右兩側。它能夠自主辨識物體的

人形機器人會變魔術了,春晚節目組了解一下

Feb 04, 2024 am 09:03 AM

人形機器人會變魔術了,春晚節目組了解一下

Feb 04, 2024 am 09:03 AM

一眨眼的功夫,機器人都已經學會變魔術了?只見它先是拿起桌上的水勺,向觀眾證明了裡面什麼也沒有……然後,它又把手中雞蛋似的物體放了進去,然後把水勺放回桌子上,開始「施法」… …就在它把水勺再次拿起的時候,奇蹟發生了。原先放進去的雞蛋不翼而飛,跳出的東西變成了一個籃球……再來看一遍連貫動作:△此動圖為二倍速一套動作下來如行雲流水,只有把視頻用0.5倍速反复觀看,才終於發現其中的端倪了:如果手速再快一些,大概真的就可以瞞天過海了。有網友感嘆,機器人變魔術的程度比自己還要高:為我們表演這段魔術的,是Mag

雲鯨逍遙001掃拖機器人,長「腦子」了! | 體驗

Apr 26, 2024 pm 04:22 PM

雲鯨逍遙001掃拖機器人,長「腦子」了! | 體驗

Apr 26, 2024 pm 04:22 PM

近幾年最受消費者歡迎的智慧家電,掃拖機器人可謂是其中之一。它所帶來的操作便利性,甚至是無需操作,讓懶人們釋放了雙手,讓消費者能夠從日常的家務中「解放」出來,也能拿更多的時間花在自己喜歡的事情上,變相提高了生活品質。藉著這股熱潮,市面上幾乎所有的家電產品品牌都在做自己的掃拖機器人,一時間使得整個掃拖機器人市場熱鬧非凡。但市場的快速拓張必然會帶來一個隱患:很多廠商會採用機海戰術的方式快速佔領更多的市場份額,從而導致很多新品並沒有什麼升級點,說它是“套娃”機型也不為過。不過,並不是所有的掃拖機器人都是

自動駕駛第一性之純視覺靜態重建

Jun 02, 2024 pm 03:24 PM

自動駕駛第一性之純視覺靜態重建

Jun 02, 2024 pm 03:24 PM

純視覺的標註方案,主要利用視覺加上一些GPS、IMU和輪速感測器的資料進行動態標註。當然面向量產場景的話,不一定要純視覺,有些量產的車輛裡面,會有像固態雷達(AT128)這樣的感測器。如果從量產的角度做資料閉環,把這些感測器都用上,可以有效解決動態物體的標註問題。但是我們的方案裡面,是沒有固態雷達的。所以,我們就介紹這個最通用的量產標註方案。純視覺的標註方案的核心在於高精度的pose重建。我們採用StructurefromMotion(SFM)的pose重建方案,來確保重建精確度。但是傳