谷歌大模型研究引發激烈爭議:訓練資料以外的泛化能力受到質疑,網友表示AGI奇點或被延後

GoogleDeepMind最近發現的一項新結果在Transformer領域引起了廣泛爭議:

它的泛化能力,無法擴展到訓練資料以外的內容。

目前這一結論還沒有進一步得到驗證,但已經驚動了一眾大佬,比如Keras之父Francois Chollet表示,如果消息為真,將成為大模型界的一件大事。

GoogleTransformer是今天大模型背後的基礎架構,我們所熟悉的GPT裡的「T」指的就是它。

一系列大模型表現出強大的上下文學習能力,可以快速學習範例並完成新的任務。

但現在,同樣來自Google的研究人員似乎指出了它的致命缺陷──超越訓練資料也就是人類已有知識之外,全都無能為力。

一時間,不少從業人員認為AGI又變得遙不可及。

有些網友指出,論文中還有一些被忽略的關鍵細節,例如實驗只涉及了GPT-2的規模,訓練資料也不夠豐富

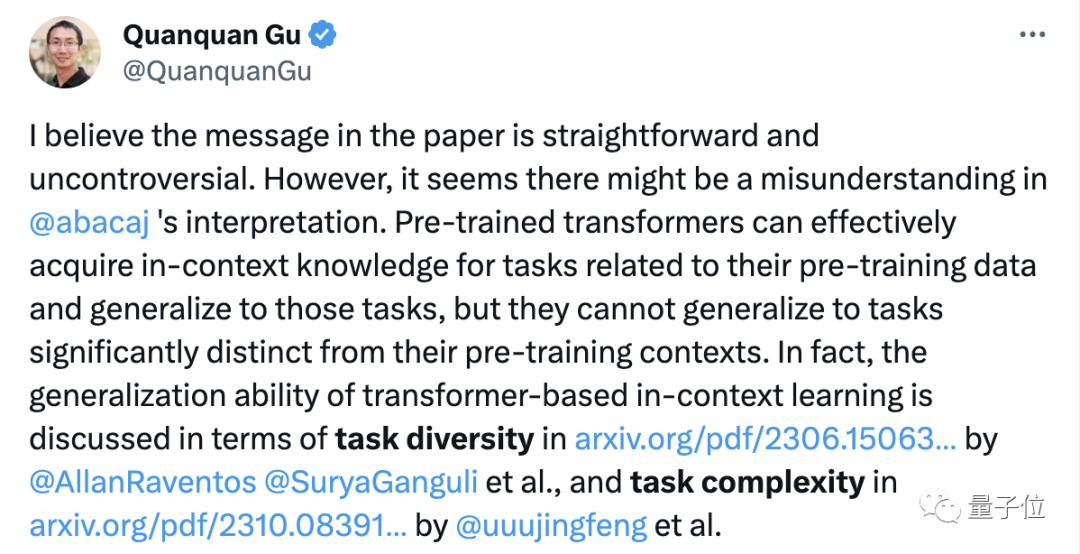

隨著時間的推移,更多認真研究了這篇論文的網友則指出,研究結論本身沒什麼問題,但人們卻基於此做出過度的解讀。

在論文引發網友熱議後,其中一位作者也公開進行了兩點澄清:

#首先,實驗中採用的是簡單的Transformer,既不是「大」模型,也不是語言模型;

其次,模型是可以學習新任務的,只是無法泛化到新類型的任務

此後,又有網友在Colab中重複了這項實驗,卻得到了完全不同的結果。

那麼,我們就先來看看這篇論文,還有提出不同結果的Samuel,到底都說了什麼。

新函數幾乎無法預測

在這個實驗中,作者使用基於Jax的機器學習框架訓練了一個規模接近GPT-2的Transformer模型,該模型僅包含解碼器部分

這個模型包含12層,8個注意力頭,嵌入空間維度為256,參數量約為950萬

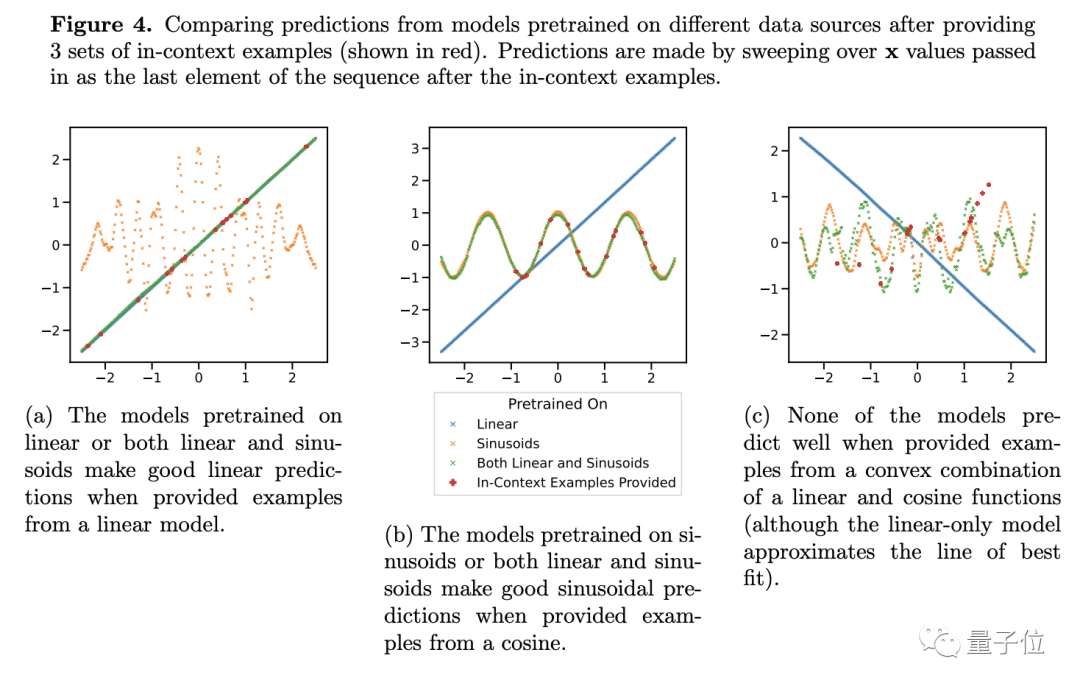

為了測試它的泛化能力,作者選擇了函數作為測試對象。他們將線性函數和正弦函數作為訓練資料輸入模型中

這兩個函數對於此時的模型來說是已知,預測的結果自然也很好,但當研究者把線性函數和當正弦函數進行了凸性組合時,問題就出現了。

凸性組合並沒有那麼神秘,作者建構出了形如f(x)=a·kx (1-a)sin(x)的函數,在我們看來不過是兩個函數按比例簡單相加。

我們之所以會這麼認為是因為我們的大腦具備這種泛化能力,而大規模模型則不同

對於只學過線性和正弦函數的模型來說,簡單的相加看起來很新穎

針對這種新函數,Transformer的預測幾乎沒有任何準確性(見圖4c),因此作者認為該模型在函數上缺乏泛化能力

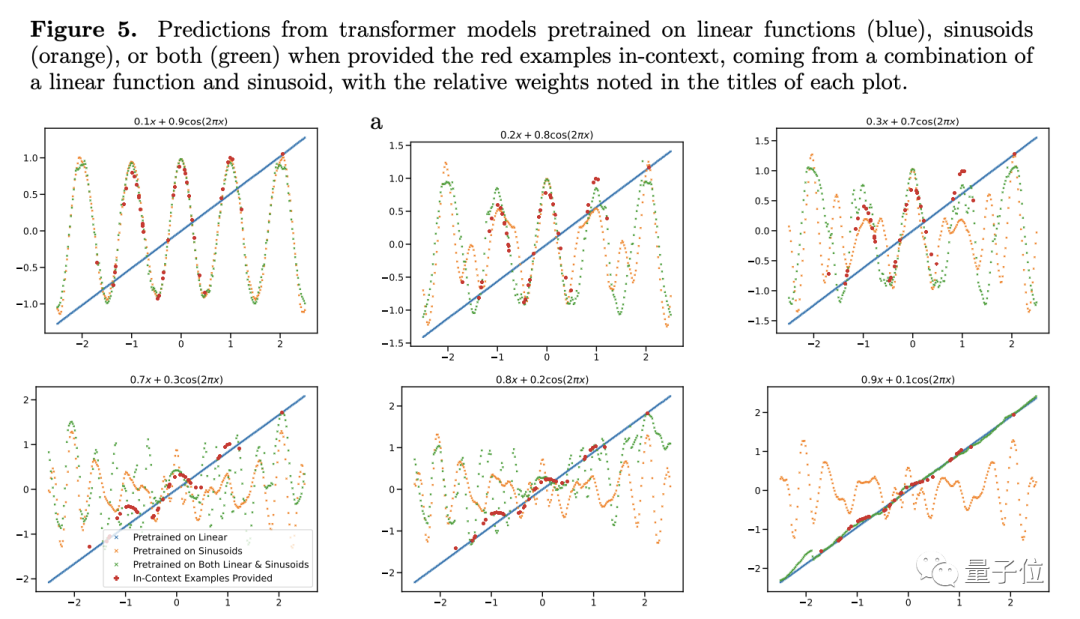

为了进一步验证自己的结论,作者调整了线性或正弦函数的权重,但即使这样Transformer的预测表现也没有显著的变化。

只有一点例外——当其中一项的权重接近1时,模型的预测结果和实际就比较吻合了。

如果权重为1,则表示陌生的新函数直接变成了训练时已经见过的函数,这种数据对于模型的泛化能力显然没有什么帮助

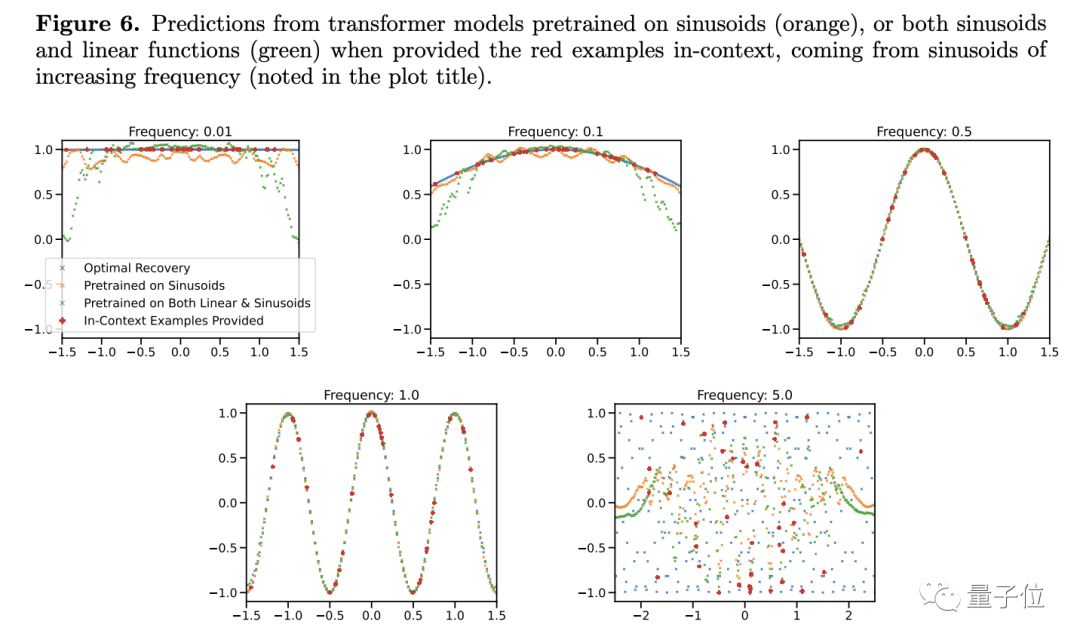

进一步实验还显示,Transformer不仅对于函数的种类十分敏感,甚至同种函数也可能变成陌生条件。

研究人员发现,在改变正弦函数的频率时,即使是简单的函数模型,预测结果也会出现线束变化

只有当频率接近训练数据中的函数时,模型才能给出比较准确的预测,当频率过高或过低时,预测结果出现了严重的偏差……

据此,作者认为,条件只要稍微有点不一样,大模型就不知道怎么做了,这不就是说明泛化能力差吗?

作者在文中也自述了研究中存在的一些局限性,如何将函数数据上的观察应用到token化的自然语言问题上。

团队也在语言模型上尝试了相似的试验但遇到一些障碍,如何适当定义任务族(相当于这里的函数种类)、凸组合等还有待解决。

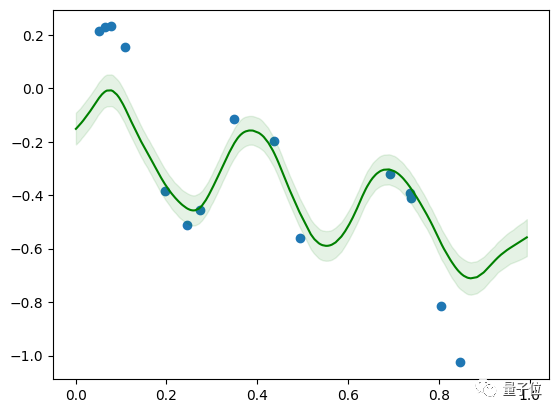

然而,萨缪尔的模型规模较小,只有4层,在Colab上训练5分钟后就可以适用于线性与正弦函数的组合

不能泛化又如何

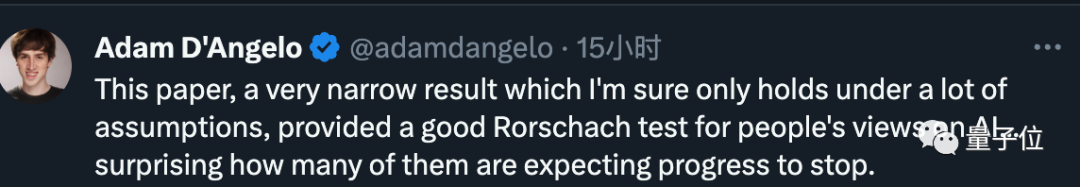

根据整篇文章的综合内容来看,Quora CEO在这篇文章中的结论非常狭隘,只有在许多假设成立的情况下才能成立

斯隆奖得主、UCLA教授顾全全说,这篇论文本身的结论不存在争议,但不应该被过度解读。

根据之前的研究,Transformer模型只有在面对与预训练数据明显不同的内容时才无法泛化。事实上,大型模型的泛化能力通常是通过任务的多样性和复杂性来评估的

如果仔细追究Transformer的泛化能力,恐怕要让子弹再飞一会儿了。

但是,就算真的缺乏泛化能力,又能怎么样呢?

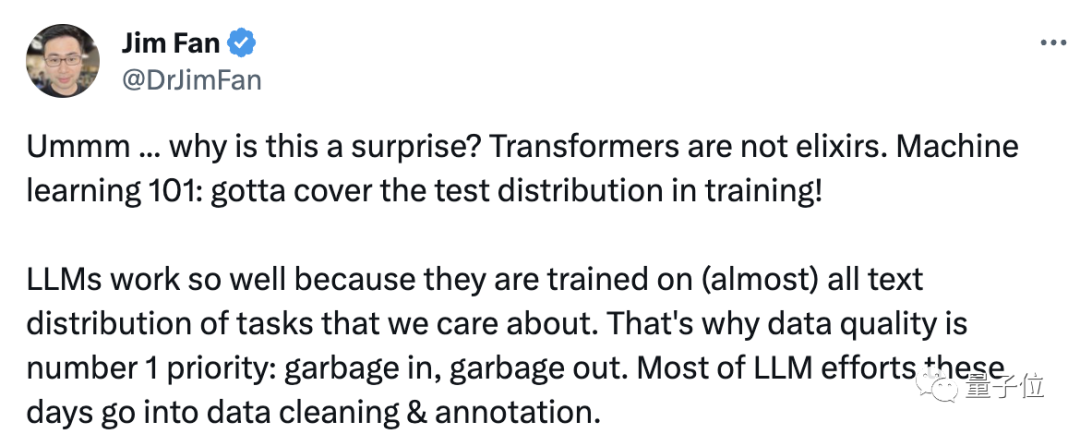

英伟达AI科学家Jim Fan就说,这种现象其实没啥奇怪的,因为Transformer本来就不是万金油,大模型表现得好,是因为训练数据刚好是我们关心的内容。

Jim进一步补充道,这就好像是在说,用一千亿张猫狗的照片训练视觉模型,接着让模型去识别飞机,然后发现,哇,居然真的不认识诶。

人类在面对一些未知任务时,不仅仅是大规模模型,也未必能够找到解决方案。这是否也暗示了人类缺乏泛化能力呢?

因此,在以目标为导向的过程中,不论是大型模型还是人类,最终的目的都是解决问题,而泛化只是一种手段

將這個表達方式換成中文,既然泛化能力不足,那就將其訓練到沒有訓練樣本之外的數據為止

那麼,對於這項研究,你有什麼看法呢?

論文網址:https://arxiv.org/abs/2311.00871

以上是谷歌大模型研究引發激烈爭議:訓練資料以外的泛化能力受到質疑,網友表示AGI奇點或被延後的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

加密數字資產交易APP推薦top10(2025全球排名)

Mar 18, 2025 pm 12:15 PM

加密數字資產交易APP推薦top10(2025全球排名)

Mar 18, 2025 pm 12:15 PM

本文推荐十大值得关注的加密货币交易平台,涵盖币安(Binance)、OKX、Gate.io、BitFlyer、KuCoin、Bybit、Coinbase Pro、Kraken、BYDFi和XBIT去中心化交易所。这些平台在交易币种数量、交易类型、安全性、合规性、特色功能等方面各有千秋,例如币安以其全球最大的交易量和丰富的功能著称,而BitFlyer则凭借其日本金融厅牌照和高安全性吸引亚洲用户。选择合适的平台需要根据自身交易经验、风险承受能力和投资偏好进行综合考量。 希望本文能帮助您找到最适合自

歐易okex賬號怎麼註冊、使用、註銷教程

Mar 31, 2025 pm 04:21 PM

歐易okex賬號怎麼註冊、使用、註銷教程

Mar 31, 2025 pm 04:21 PM

本文詳細介紹了歐易OKEx賬號的註冊、使用和註銷流程。註冊需下載APP,輸入手機號或郵箱註冊,完成實名認證。使用方面涵蓋登錄、充值提現、交易以及安全設置等操作步驟。而註銷賬號則需要聯繫歐易OKEx客服,提供必要信息並等待處理,最終獲得賬號註銷確認。 通過本文,用戶可以輕鬆掌握歐易OKEx賬號的完整生命週期管理,安全便捷地進行數字資產交易。

binance怎麼註冊詳細教程(2025新手指南)

Mar 18, 2025 pm 01:57 PM

binance怎麼註冊詳細教程(2025新手指南)

Mar 18, 2025 pm 01:57 PM

本文提供Binance幣安註冊及安全設置的完整指南,涵蓋註冊前的準備工作(包括設備、郵箱、手機號及身份證明文件準備),詳細介紹了官網及APP兩種註冊方式,以及不同級別的身份驗證(KYC)流程。此外,文章還重點講解瞭如何設置資金密碼、開啟雙重驗證(2FA,包括谷歌身份驗證器和短信驗證)以及設置防釣魚碼等關鍵安全步驟,幫助用戶安全便捷地註冊和使用Binance幣安平台進行加密貨幣交易。 請務必在交易前了解相關法律法規及市場風險,謹慎投資。

如何優化jieba分詞以改善景區評論的關鍵詞提取效果?

Apr 01, 2025 pm 06:24 PM

如何優化jieba分詞以改善景區評論的關鍵詞提取效果?

Apr 01, 2025 pm 06:24 PM

如何優化jieba分詞以改善景區評論的關鍵詞提取?在使用jieba分詞處理景區評論數據時,如果發現分詞結果不理�...

gate.io手機app使用教程

Mar 26, 2025 pm 05:15 PM

gate.io手機app使用教程

Mar 26, 2025 pm 05:15 PM

gate.io手機app使用教程:1、安卓用戶,訪問 Gate.io 官方網站,下載安卓安裝包,您可能需要在手機設置中允許安裝來自未知來源的應用;2、ios用戶,在 App Store 中搜索 "Gate.io" 下載。

虛擬幣最老的幣排行榜最新更新

Apr 22, 2025 am 07:18 AM

虛擬幣最老的幣排行榜最新更新

Apr 22, 2025 am 07:18 AM

虛擬貨幣“最老”排行榜如下:1. 比特幣(BTC),發行於2009年1月3日,是首個去中心化數字貨幣。 2. 萊特幣(LTC),發行於2011年10月7日,被稱為“比特幣的輕量版”。 3. 瑞波幣(XRP),發行於2011年,專為跨境支付設計。 4. 狗狗幣(DOGE),發行於2013年12月6日,基於萊特幣代碼的“迷因幣”。 5. 以太坊(ETH),發行於2015年7月30日,首個支持智能合約的平台。 6. 泰達幣(USDT),發行於2014年,是首個與美元1:1錨定的穩定幣。 7. 艾達幣(ADA),發

okex交易平台官網登錄入口

Mar 18, 2025 pm 12:42 PM

okex交易平台官網登錄入口

Mar 18, 2025 pm 12:42 PM

本文詳細介紹了歐易OKEx網頁版登錄的完整步驟,包括準備工作(確保網絡連接穩定及瀏覽器更新)、訪問官網(注意網址準確性,避免釣魚網站)、找到登錄入口(點擊官網首頁右上角的“登錄”按鈕)、輸入登錄信息(郵箱/手機號及密碼,支持驗證碼登錄)、完成安全驗證(滑動驗證、谷歌驗證或短信驗證)等五個步驟,最終成功登錄後即可進行數字資產交易等操作。 安全便捷的登錄流程,保障用戶資產安全。

虛擬幣購買app安全靠譜的top10推薦

Mar 18, 2025 pm 12:12 PM

虛擬幣購買app安全靠譜的top10推薦

Mar 18, 2025 pm 12:12 PM

2025年全球虛擬幣交易平台Top 10推薦,助您玩轉數字貨幣市場!本文將為您深度解析幣安(Binance)、OKX、Gate.io、BitFlyer、KuCoin、Bybit、Coinbase Pro、Kraken、BYDFi和XBIT去中心化交易所等十家頂級平台的核心優勢和特色功能。無論是追求高流動性、豐富的交易類型,還是注重安全合規、創新功能,都能在此找到適合您的平台。 我們將從交易品種、安全性、特色功能等方面進行全面對比,助您選擇最合適的虛擬貨幣交易平台,把握2025年數字貨幣投資機遇