新標題:英偉達H200發表:HBM容量提升76%,大幅提升大模型效能90%的最強AI晶片

11月14日消息,英偉達(Nvidia)在當地時間13日上午的「Supercomputing 23」會議上正式發布了全新的H200 GPU,並更新了GH200產品線

其中,H200仍然是建立在現有的Hopper H100 架構之上,但增加了更多高頻寬記憶體(HBM3e),從而更好地處理開發和實施人工智慧所需的大型資料集,使得運行大模型的綜合性能相比前代H100提升了60%到90%。而更新後的GH200,也將為下一代 AI 超級電腦提供動力。 2024 年將會有超過 200 exaflops 的 AI 運算能力上線。

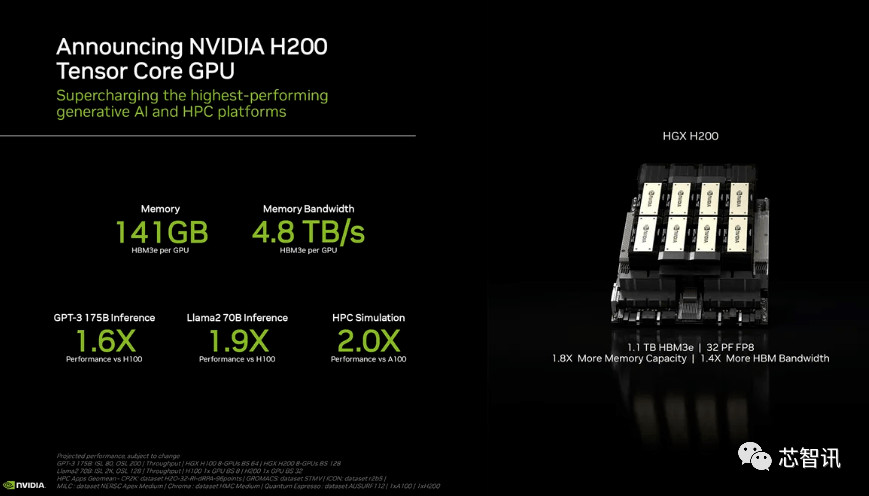

H200:HBM容量增加了76%,大型機型的效能提升了90%

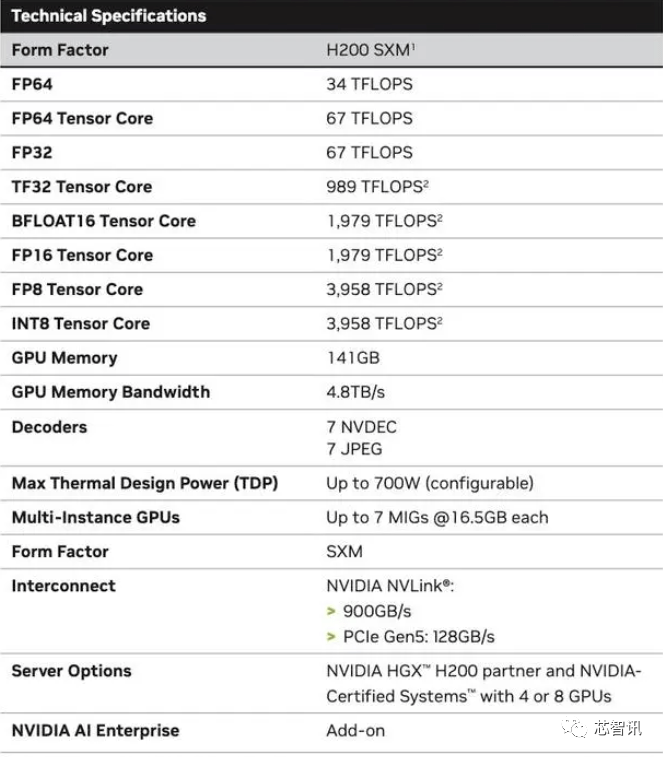

具體來說,全新的H200提供了高達141GB的HBM3e內存,有效運行速度約為6.25 Gbps,六個HBM3e堆疊中每個GPU的總頻寬為4.8 TB/s。與上一代的H100(具有80GB HBM3和3.35 TB/s頻寬)相比,這是一個巨大的改進,HBM容量提升了超過76%。根據官方提供的數據,在運行大模型時,H200相比H100將帶來60%(GPT3 175B)到90%(Llama 2 70B)的提升

雖然H100 的某些配置確實提供了更多內存,例如H100 NVL 將兩塊板配對,並提供總計188GB 內存(每個GPU 94GB),但即便是與H100 SXM 變體相比,新的H200 SXM 也提供了76% 以上的記憶體容量和43 % 更多頻寬。

要指出的是,H200原始運算效能似乎沒有太大變化。英偉達所展示的唯一體現運算效能的投影片是基於使用了8個GPU的HGX 200配置,總效能為「32 PFLOPS FP8」。而最初的H100提供了3,958 teraflops的FP8算力,因此八個這樣的GPU也提供了大約32 PFLOPS的FP8算力

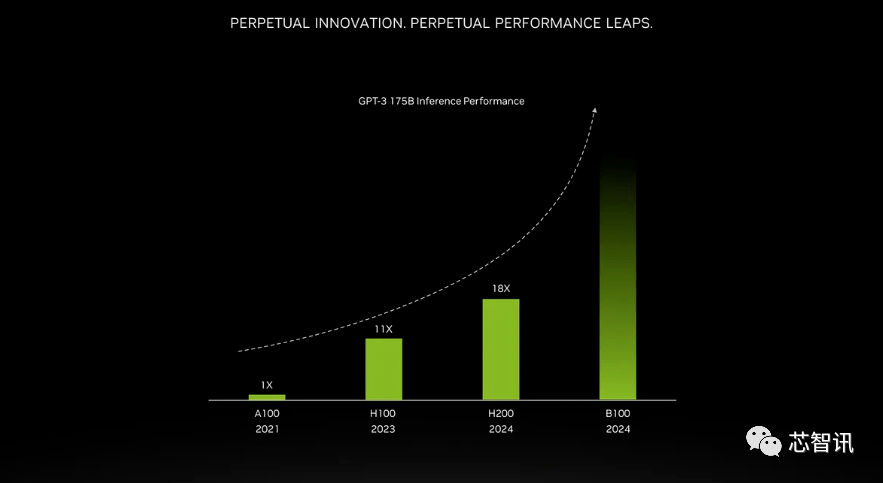

更高頻寬記憶體帶來的提升取決於工作量。大型模型(如GPT-3)將極大受益於HBM記憶體容量的增加。根據英偉達表示,H200在運行GPT-3時的性能將比原始A100高出18倍,比H100快約11倍。此外,即將推出的Blackwell B100的預告片顯示,它包含一個逐漸變黑的更高條,大約是H200的兩倍最右

不僅如此,H200和H100是互相相容的。也就是說,使用H100訓練/推理模型的AI企業,可以無縫更換成最新的H200晶片。雲端服務商將H200新增至產品組合時也不需要進行任何修改。

英偉達表示,透過推出新產品,他們希望跟上用於創建人工智慧模型和服務的資料集規模的成長。增強的記憶體能力將使H200在向軟體提供資料的過程中更快速,這個過程有助於訓練人工智慧執行識別影像和語音等任務。

“整合更快、更大容量的HBM內存有助於對運算要求較高的任務提升性能,包括生成式AI模型和高性能運算應用程序,同時優化GPU使用率和效率”,NVIDIA高性能計算產品副總裁Ian Buck表示。

英偉達資料中心產品負責人迪翁·哈里斯(Dion Harris)表示:「當你觀察市場發展的趨勢時,會發現模型規模正在迅速增大。這是我們持續引入最新和最優秀技術的典範。

預計大型電腦製造商和雲端服務供應商將於2024年第二季開始使用H200。英偉達伺服器製造夥伴(包括永擎、華碩、戴爾、Eviden、技嘉、HPE、鴻佰、聯想、雲端達、美超威、緯創資通以及緯穎科技)可以使用H200更新現有系統,而亞馬遜、Google、微軟、甲骨文等將成為首批採用H200的雲端服務商。鑑於目前市場對於英偉達AI晶片的旺盛需求,以及全新的H200增加了更多的昂貴的HBM3e內存,因此H200的價格肯定會更昂貴。英偉達沒有列出它的價格,但上一代H100價格就已經高達25,000美元至40,000美元。

英偉達發言人Kristin Uchiyama表示,最終的定價將由英偉達的製造夥伴來決定

對於H200的推出是否會影響H100的生產,Kristin Uchiyama表示:「我們預計全年的總供應量將會增加。」

英偉達的高階AI晶片一直以來被視為處理大量資料和訓練大型語言模式、AI生成工具的最佳選擇。然而,在推出H200晶片之時,AI公司仍在市場上拼命尋求A100/H100晶片。市場的焦點仍然在於,英偉達是否能夠提供足夠的供應來滿足市場需求。因此,H200晶片是否會像H100晶片一樣供不應求,NVIDIA並沒有給出答案

不過,明年對GPU買家來說可能將是一個更有利時期,根據《金融時報》8月報導曾指出,NVIDIA計劃在2024年將H100產量提升三倍,產量目標將從2023年約50萬個增加至2024年200萬個。但生成式AI仍在蓬勃發展,未來需求也可能更大。

舉個例子,最新推出的GPT-4大約是在10000-25000塊A100上進行訓練的。 Meta的AI大模型需要大約21000塊A100進行訓練。 Stability AI使用了大約5000塊A100。 Falcon-40B的訓練則需要384塊A100

根據馬斯克的說法,GPT-5可能需要30000-50000塊H100。摩根士丹利的說法是25000個GPU。

Sam Altman否認了在訓練GPT-5,但卻提過「OpenAI的GPU嚴重短缺,使用我們產品的人越少越好」。

當然,除了英偉達之外,AMD和英特爾也在積極的進入AI市場與英偉達展開競爭。先前AMD推出的MI300X就配備192GB的HBM3和5.2TB/s的顯存頻寬,這將使其在容量和頻寬上遠超H200。

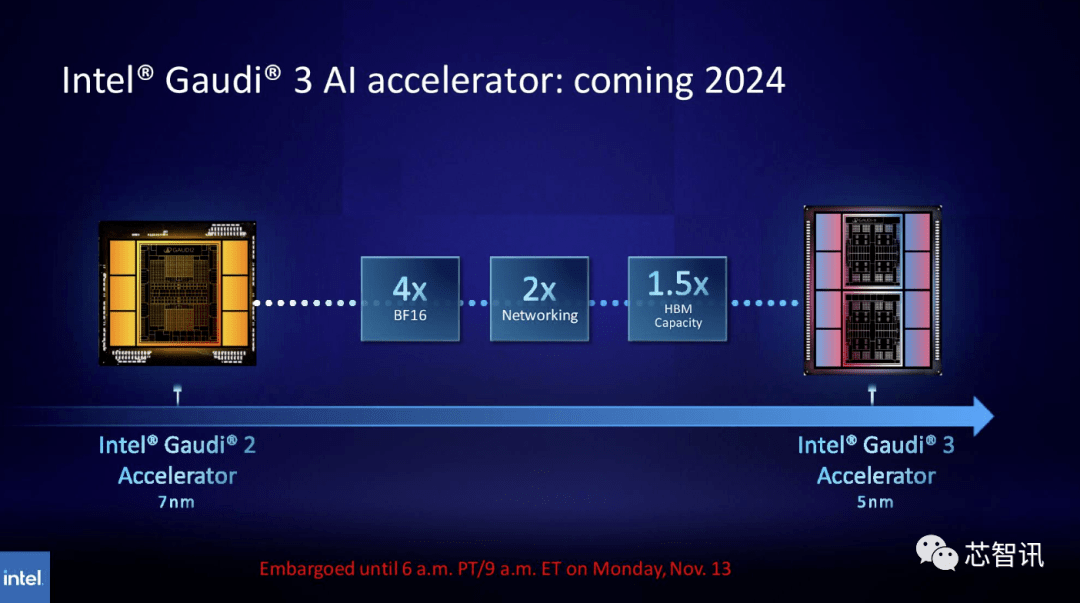

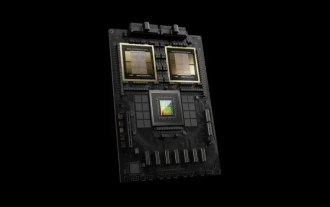

同樣,英特爾計劃提升Gaudi AI晶片的HBM容量。根據最新公佈的資訊顯示,Gaudi 3採用5nm工藝,其在BF16工作負載方面的性能將是Gaudi 2的四倍,網絡性能也將是其的兩倍(Gaudi 2有24個內置的100 GbE RoCE Nic )。此外,Gaudi 3的HBM容量是Gaudi 2的1.5倍(Gaudi 2有96 GB的HBM2E)。從下圖可以看出,Gaudi 3採用了基於chiplet的設計,具有兩個計算集群,而不像Gaudi 2使用英特爾的單晶片解決方案

全新GH200超級晶片:為下一代 AI 超級電腦提供動力

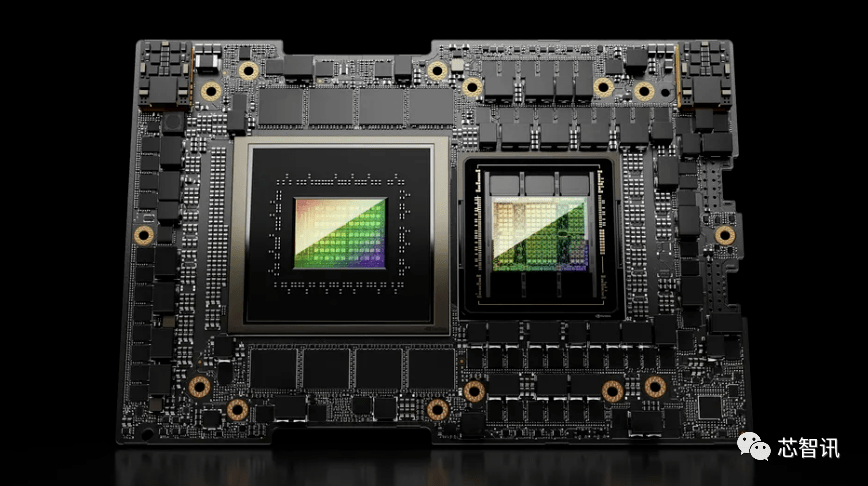

英偉達除了發表全新的H200 GPU外,還推出了升級版的GH200超級晶片。這款晶片採用了NVIDIA NVLink-C2C晶片互連技術,結合了最新的H200 GPU和Grace CPU(不確定是否為升級版)。每台GH200超級晶片也將搭載總計624GB的記憶體

作為對比,上一代的GH200則是基於H100 GPU和 72 核心的Grace CPU,提供了96GB 的 HBM3 和 512 GB 的 LPDDR5X 整合在同一個封裝中。

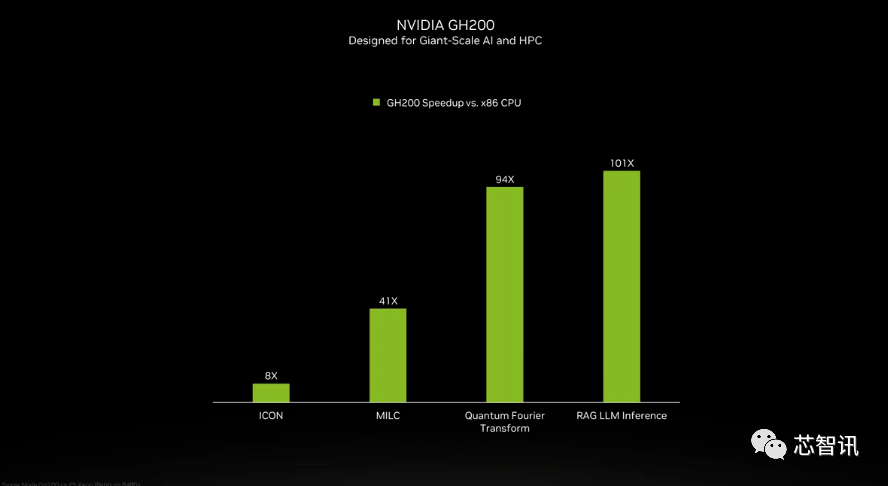

雖然英偉達並未介紹GH200超級晶片當中的Grace CPU細節,但是英偉達提供了GH200 和「現代雙路 x86 CPU」之間的一些比較。可以看到,GH200帶來了ICON性能8倍的提升,MILC、Quantum Fourier Transform、RAG LLM Inference等更是帶來數十倍乃至百倍的提升。

但需要指出的是,其中提到了加速與「非加速系統」。這意味著什麼?我們只能假設 x86 伺服器運行的是未完全優化的程式碼,特別是考慮到人工智慧世界正在快速發展,並且優化方面似乎定期出現新的進展。

全新的GH200 也將用於新的 HGX H200 系統。據說這些與現有的 HGX H100 系統“無縫兼容”,這意味著 HGX H200 可以在相同的安裝中使用,以提高性能和內存容量,而無需重新設計基礎設施。

據介紹,瑞士國家超級電腦中心的阿爾卑斯超級電腦可能是明年第一批投入使用的基於GH100的Grace Hopper超級電腦之一。第一個在美國投入使用的GH200系統將是洛斯阿拉莫斯國家實驗室的Venado超級電腦。德州高階運算中心(TACC) Vista系統也將使用剛剛宣布的Grace CPU和Grace Hopper超級晶片,但尚不清楚它們是基於H100還是H200

目前,即將安裝的最大的超級電腦是Jϋlich超級計算中心的Jupiter 超級電腦。它將容納「近」24000 個 GH200 超級晶片,總共 93 exaflops 的 AI 計算(大概是使用 FP8,雖然大多數 AI 仍然使用 BF16 或 FP16)。它還將提供 1 exaflop 的傳統 FP64 計算。它將使用具有四個 GH200 超級晶片的“Quad GH200”板。

英偉達預計在未來一年左右安裝的這些新型超級計算機,總體來說,將實現超過200 exaflops的人工智慧運算能力

不需要改變原始意思的情況下,需要將內容改寫成中文,不需要出現原句

以上是新標題:英偉達H200發表:HBM容量提升76%,大幅提升大模型效能90%的最強AI晶片的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

英偉達上線 RTX HDR 功能:不支援的遊戲透過 AI 濾鏡達到 HDR 艷麗視覺效果

Feb 24, 2024 pm 06:37 PM

英偉達上線 RTX HDR 功能:不支援的遊戲透過 AI 濾鏡達到 HDR 艷麗視覺效果

Feb 24, 2024 pm 06:37 PM

本站2月23日消息,英偉達昨晚更新推出了NVIDIA應用程序,為玩家提供了全新的統一GPU控制中心,便於玩家透過遊戲內懸浮窗提供的強大錄影工具捕捉精彩時刻。在本次更新中,英偉達也引入了RTXHDR功能,本站附上官方介紹如下:RTXHDR是一款AI賦能的全新Freestyle濾鏡,可以將高動態範圍(HDR)的艷麗視覺效果無縫引入到原本不支援HDR的遊戲中。你只需擁有相容HDR的顯示器,即可對大量基於DirectX和Vulkan的遊戲使用此功能。玩家在啟用RTXHDR功能之後,運行即便不支援HD

消息指出英偉達 RTX 50 系列顯示卡原生配 16-Pin PCIe Gen 6 供電接口

Feb 20, 2024 pm 12:00 PM

消息指出英偉達 RTX 50 系列顯示卡原生配 16-Pin PCIe Gen 6 供電接口

Feb 20, 2024 pm 12:00 PM

本站2月19日訊息,Moore'sLawisDead頻道最新一期影片中,主播Tom透露英偉達GeForceRTX50系列顯示卡將原生配備PCIeGen6的16-Pin供電介面。 Tom表示除了高階的GeForceRTX5080和GeForceRTX5090系列之外,中階GeForceRTX5060也會啟用新的供電介面。消息稱英偉達設定明確要求,未來每塊GeForceRTX50系列都配備PCIeGen6的16-Pin供電接口,從而簡化供應鏈。本站附上截圖如下:Tom也表示GeForceRTX5090在

英偉達 RTX 4070 和 4060 Ti FE 顯示卡已降至建議零售價以下,分別為 4599/2999 元

Feb 22, 2024 pm 09:43 PM

英偉達 RTX 4070 和 4060 Ti FE 顯示卡已降至建議零售價以下,分別為 4599/2999 元

Feb 22, 2024 pm 09:43 PM

本站2月22日消息,一般來說,英偉達和AMD對於通路定價是有限制的,對於一些私自大幅降價的經銷商還會進行處罰,例如AMD最近就對6750GRE顯示卡低於最低限價的經銷商進行了處罰。本站注意到,英偉達GeForceRTX4070和4060Ti已降至歷史新低,其創辦人版本,也就是公版顯示卡目前在京東自營店可以領取200元優惠券,到手價4599元、2999元。當然,若是考慮第三方店舖的話還會有更低的價格。參數方面,RTX4070顯示卡擁有5888CUDA核心,採用12GBGDDR6X記憶體,位元寬為192bi

英偉達對話模式ChatQA進化到2.0版本,上下文長度提到128K

Jul 26, 2024 am 08:40 AM

英偉達對話模式ChatQA進化到2.0版本,上下文長度提到128K

Jul 26, 2024 am 08:40 AM

開放LLM社群正是百花齊放、競相爭鳴的時代,你能看到Llama-3-70B-Instruct、QWen2-72B-Instruct、Nemotron-4-340B-Instruct、Mixtral-8x22BInstruct-v0.1等許多表現優良的模型。但是,相較於以GPT-4-Turbo為代表的專有大模型,開放模型在許多領域仍有明顯差距。在通用模型之外,也有一些專精關鍵領域的開放模型已被開發出來,例如用於程式設計和數學的DeepSeek-Coder-V2、用於視覺-語言任務的InternVL

「AI 工廠」將推動軟體全端重塑,英偉達提供 Llama3 NIM 容器供用戶部署

Jun 08, 2024 pm 07:25 PM

「AI 工廠」將推動軟體全端重塑,英偉達提供 Llama3 NIM 容器供用戶部署

Jun 08, 2024 pm 07:25 PM

本站6月2日消息,在目前正在進行的黃仁勳2024台北電腦展主題演講上,黃仁勳介紹生成式人工智慧將推動軟體全端重塑,展示其NIM(NvidiaInferenceMicroservices)雲端原生微服務。英偉達認為「AI工廠」將掀起一場新產業革命:以微軟開創的軟體產業為例,黃仁勳認為生成式人工智慧將推動其全端重塑。為方便各種規模的企業部署AI服務,英偉達今年3月推出了NIM(NvidiaInferenceMicroservices)雲端原生微服務。 NIM+是一套經過優化的雲端原生微服務,旨在縮短上市時間

多次轉型,與AI巨擘英偉達合作,Vanar Chain憑何30天暴漲4.6倍?

Mar 14, 2024 pm 05:31 PM

多次轉型,與AI巨擘英偉達合作,Vanar Chain憑何30天暴漲4.6倍?

Mar 14, 2024 pm 05:31 PM

近來,Layer1區塊鏈VanarChain憑藉高漲幅以及與AI巨頭英偉達合作備受市場關注。 VanarChain走紅背後,除了經歷多次品牌轉型,主打遊戲、元宇宙和AI等熱門概念也為這個項目賺足了熱度和話題。在進行轉型之前,Vanar的前身是TerraVirtua,成立於2018年,最初是一個支援付費訂閱、提供虛擬實境(VR)和擴增實境(AR)內容的平台,並接受加密貨幣支付。該平台由聯合創始人GaryBracey和JawadAshraf創建,其中GaryBracey在參與電玩遊戲製作和開發方面擁有超

戀與深空暴擊率怎麼提升

Mar 23, 2024 pm 01:31 PM

戀與深空暴擊率怎麼提升

Mar 23, 2024 pm 01:31 PM

戀與深空中人物有著各方面的數值屬性,遊戲內的每一種屬性都有其特定的作用,而暴擊率這一屬性就會影響到角色的傷害,可以說是一項很重要的屬性了,而下面要帶來的就是這屬性的提升方法了,所以想知道的玩家就可以來看看了。戀與深空暴擊率提升方法一、核心方法要想達到80%的暴擊率,關鍵在於你手中的六張卡的爆擊屬性總和。日冕卡的選擇:選擇兩張日冕卡時,確保它們的芯核α和芯核β副屬性詞條中至少有一條是暴擊屬性。月冕卡的優勢:月冕卡不僅基礎屬性中包含暴擊,而且當它們達到60級且未突破時,每張卡可以提供4.1%的暴

集邦諮詢:英偉達 Blackwell 平台產品帶動台積電今年 CoWoS 產能提升 150%

Apr 17, 2024 pm 08:00 PM

集邦諮詢:英偉達 Blackwell 平台產品帶動台積電今年 CoWoS 產能提升 150%

Apr 17, 2024 pm 08:00 PM

本站4月17日消息,集邦諮詢(TrendForce)近日發布報告,認為英偉達Blackwell新平台產品需求看漲,預估帶動台積電2024年CoWoS封裝總產能提升逾150%。英偉達Blackwell新平台產品包含B系列的GPU,以及整合英偉達自家GraceArmCPU的GB200加速卡等。集邦諮詢確認為供應鏈目前非常看好GB200,預估2025年出貨量預計超過百萬片,在英偉達高階GPU中的佔比達到40-50%。在英偉達計畫下半年交付GB200以及B100等產品,但上游晶圓封裝方面須進一步採用更複