NVIDIA RTX顯示卡AI推理提速5倍! RTX PC輕鬆在本地搞定大模型

在微軟Iginte全球技術大會上,微軟發布了一系列AI相關的全新優化模型和開發工具資源,旨在幫助開發者更充分地發揮硬體性能,擴展AI應用領域

特別是對於當下在AI領域佔據絕對主導地位的NVIDIA來說,微軟這次送上了一份大禮包,無論是面向OpenAI Chat API的TensorRT-LLM封裝接口,還是RTX驅動的效能改進DirectML for Llama 2,以及其他熱門大語言模型(LLM),都可以在NVIDIA硬體上獲得更好的加速和應用。

其中,TensorRT-LLM是一款用於加速LLM推理的函式庫,可大幅提升AI推理效能,還在持續更以支援越來越多的語言模型,而且它還是開源的。

NVIDIA在10月發布了適用於Windows平台的TensorRT-LLM。對於配備RTX 30/40系列GPU顯示卡的桌上型電腦和筆記型電腦來說,只要顯存達到8GB以上,就能更輕鬆地完成高要求的AI工作負載

現在,Tensor RT-LLM for Windows可以透過全新的封裝接口,與OpenAI 廣受歡迎的聊天API 相容,因此可以在本地直接運行各種相關應用,而不需要連接雲端,有利於在PC 上保留私人和專有數據,防範隱私外洩。

只要是經過TensorRT-LLM優化的大型語言模型,都可以與這個封裝介面配合使用,包括Llama 2、Mistral、NV LLM等等

對於開發者來說,無需繁瑣的程式碼重寫和移植,只需修改一兩行程式碼,就可以讓AI應用程式在本地快速執行。

↑↑↑基於TensorRT-LLM的微軟Visual Studio程式碼外掛程式-Continue.dev程式設計助理

本月底還會有TensorRT-LLM v0.6.0版本更新,將會在RTX GPU上帶來最多達5倍的推理性能提升,並支援更多熱門的LLM,包括全新的70億參數Mistral、80億參數Nemotron-3,讓桌上型電腦和筆電也能隨時、快速、準確地本地運行LLM。

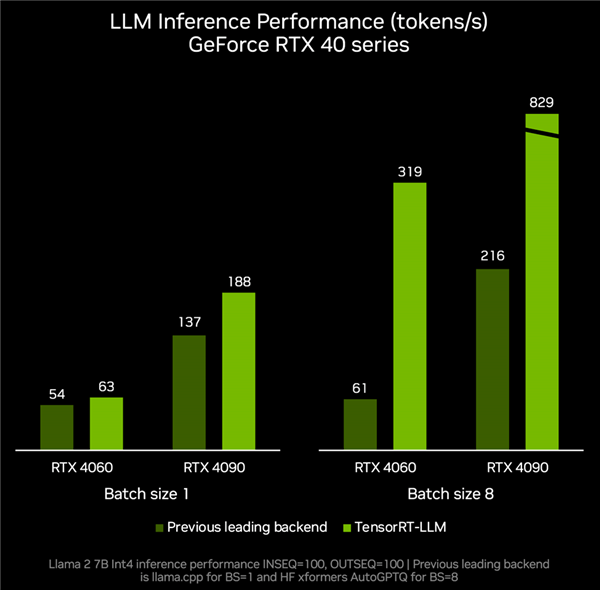

根據實測數據,RTX 4060顯示卡搭配TenroRT-LLM,推理表現可以跑到每秒319 tokens,相比其他後端的每秒61 tokens提速足足4.2倍。

RTX 4090則可以從每秒tokens加速到每秒829 tokens,提升幅度達2.8倍。

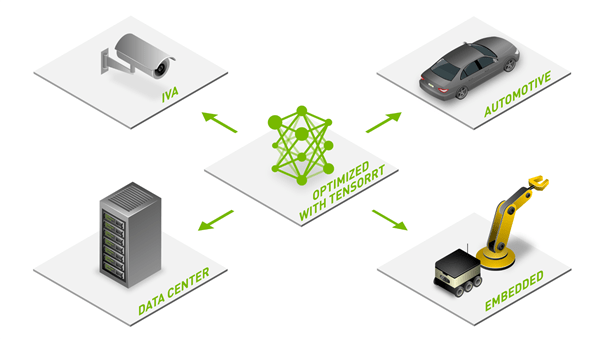

憑藉著強大的硬體效能、豐富的開發生態和廣泛的應用場景,NVIDIA RTX正在成為本地AI不可或缺的有力助手。同時,隨著最佳化、模型和資源的不斷豐富,AI功能在億萬台RTX PC上的普及也加速推進

目前已經有400多個合作夥伴發布了支援RTX GPU加速的AI應用、遊戲,而隨著模型易用性的不斷提高,相信會有越來越多的AIGC功能出現在Windows PC平台上。

以上是NVIDIA RTX顯示卡AI推理提速5倍! RTX PC輕鬆在本地搞定大模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

10個生成AI編碼擴展,在VS代碼中,您必須探索

Apr 13, 2025 am 01:14 AM

10個生成AI編碼擴展,在VS代碼中,您必須探索

Apr 13, 2025 am 01:14 AM

嘿,編碼忍者!您當天計劃哪些與編碼有關的任務?在您進一步研究此博客之前,我希望您考慮所有與編碼相關的困境,這是將其列出的。 完畢? - 讓&#8217

GPT-4O vs OpenAI O1:新的Openai模型值得炒作嗎?

Apr 13, 2025 am 10:18 AM

GPT-4O vs OpenAI O1:新的Openai模型值得炒作嗎?

Apr 13, 2025 am 10:18 AM

介紹 Openai已根據備受期待的“草莓”建築發布了其新模型。這種稱為O1的創新模型增強了推理能力,使其可以通過問題進行思考

視覺語言模型(VLMS)的綜合指南

Apr 12, 2025 am 11:58 AM

視覺語言模型(VLMS)的綜合指南

Apr 12, 2025 am 11:58 AM

介紹 想像一下,穿過美術館,周圍是生動的繪畫和雕塑。現在,如果您可以向每一部分提出一個問題並獲得有意義的答案,該怎麼辦?您可能會問:“您在講什麼故事?

如何在SQL中添加列? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

如何在SQL中添加列? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

SQL的Alter表語句:動態地將列添加到數據庫 在數據管理中,SQL的適應性至關重要。 需要即時調整數據庫結構嗎? Alter表語句是您的解決方案。本指南的詳細信息添加了Colu

pixtral -12b:Mistral AI'第一個多模型模型 - 分析Vidhya

Apr 13, 2025 am 11:20 AM

pixtral -12b:Mistral AI'第一個多模型模型 - 分析Vidhya

Apr 13, 2025 am 11:20 AM

介紹 Mistral發布了其第一個多模式模型,即Pixtral-12b-2409。該模型建立在Mistral的120億參數Nemo 12B之上。是什麼設置了該模型?現在可以拍攝圖像和Tex

超越駱駝戲:大型語言模型的4個新基準

Apr 14, 2025 am 11:09 AM

超越駱駝戲:大型語言模型的4個新基準

Apr 14, 2025 am 11:09 AM

陷入困境的基準:駱駝案例研究 2025年4月上旬,梅塔(Meta)揭開了其Llama 4套件的模特,擁有令人印象深刻的性能指標,使他們對GPT-4O和Claude 3.5 Sonnet等競爭對手的良好定位。倫斯的中心

如何使用AGNO框架構建多模式AI代理?

Apr 23, 2025 am 11:30 AM

如何使用AGNO框架構建多模式AI代理?

Apr 23, 2025 am 11:30 AM

在從事代理AI時,開發人員經常發現自己在速度,靈活性和資源效率之間進行權衡。我一直在探索代理AI框架,並遇到了Agno(以前是Phi-

多動症遊戲,健康工具和AI聊天機器人如何改變全球健康

Apr 14, 2025 am 11:27 AM

多動症遊戲,健康工具和AI聊天機器人如何改變全球健康

Apr 14, 2025 am 11:27 AM

視頻遊戲可以緩解焦慮,建立焦點或支持多動症的孩子嗎? 隨著醫療保健在全球範圍內挑戰,尤其是在青年中的挑戰,創新者正在轉向一種不太可能的工具:視頻遊戲。現在是世界上最大的娛樂印度河之一