即時文生圖速度提升5-10倍,清華LCM/LCM-LoRA爆火,瀏覽超百萬、下載超20萬

生成式模型進入「即時」時代?

使用文生圖和圖生圖已經不再是一件新鮮事了。然而,在使用這些工具的過程中,我們發現它們常常運行緩慢,導致我們需要等待一段時間才能獲取生成的結果

但最近,一種名為“LCM”的模型改變了這種情況,它甚至能做到即時的連續生圖。

itter162/126212222121212212121262221262#. ##LCM 的全名是Latent Consistency Models(潛在一致性模型),由清華大學交叉資訊研究院的研究者們建構。在這個模型發布之前,Stable Diffusion 等潛在擴散模型(LDM)由於迭代採樣過程計算量大,生成速度非常緩慢。透過一些創新的方法,LCM 只用少數的幾步推理就能產生高解析度影像。根據統計,LCM 能將主流文生圖模型的效率提高 5-10 倍,所以能呈現即時的效果。

- 請點選以下連結查看論文:https://arxiv.org/pdf/2310.04378.pdf

- ##計畫網址: https://github.com/luosiallen/latent-consistency-model

- #該內容發布後一個月內瀏覽量超過一百萬次,作者也受邀在Hugging Face、 Replicate、浦源等多個平台上部署新開發的LCM模型和演示。其中,Hugging Face平台上LCM模型的下載量已經超過二十萬次,而在Replicate平台上的在線API調用次數已經超過五十四萬次

技術報告連結:https://arxiv.org/ pdf/2311.05556.pdf

需要重新寫作的內容是:圖片來源:https://twitter.com/javilopen/status/1724398708052414748

我們的團隊已經完全開源了LCM的程式碼,並且公開了基於SD-v1.5和SDXL等預訓練模型進行內部蒸餾得到的模型權重檔案和線上示範。此外,Hugging Face團隊已將潛在一致性模型整合到diffusers官方倉庫中,並在兩個連續的正式版本v0.22.0和v0.23.0中更新了LCM和LCM-LoRA的相關程式碼框架,提供了對潛在一致性模型的良好支持。在Hugging Face上公開的模型在今天的熱度榜中排名第一,成為全平台文生圖模型熱度第一並且全類別模型熱度第三

接下來,我們將分別介紹 LCM 和 LCM-LoRA 這兩項研究成果。

LCM:只用幾步推理就能產生高解析度影像

AIGC 時代,包括Stable Diffusion 和DALL-E 3 等基於擴散模型的文生圖模型受到了廣泛關注。擴散模型透過向訓練資料添加噪聲,然後逆轉這一過程來產生高品質影像。然而,擴散模型產生圖片需要多步驟取樣,這個過程相對較慢,增加了推理成本。緩慢的多步驟採樣問題是部署這類模型時的主要瓶頸。

OpenAI 的宋颯博士在今年提出的一致性模型(Consistency Model,CM)為解決上述問題提供了一個思路。一致性模型被指出在設計上具有單步生成的能力,展現出極大的加速擴散模型的生成的潛力。然而,由於一致性模型局限於無條件圖片生成,導致包括文生圖、圖生圖等在內的許多實際應用仍難以享受此模型的潛在優勢。

潛在一致性模型(Latent Consistency Model,LCM)就是為解決上述問題而誕生的。潛在一致性模型支援給定條件的影像生成任務,並結合了潛在編碼、無分類器引導等諸多在擴散模型中被廣泛應用的技術,大大加速了條件去噪過程,為諸多具有實際應用意義的任務打開了一條通路。

LCM 技術細節

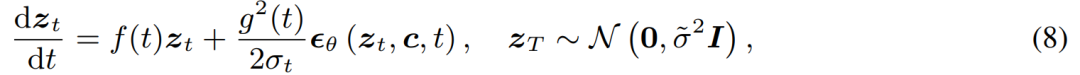

具體而言,潛在一致性模型將擴散模型的去噪問題解讀為求解如下所示的增廣機率流常微分方程的過程。

可以透過改進傳統的擴散模型來提高求解效率。傳統的方法使用數值迭代來求解常微分方程,但即使使用更精確的求解器,每一步的精度也有限,需要進行大約10次迭代才能得到滿意的結果

#與傳統的迭代求解常微分方程不同,潛在一致性模型要求直接對常微分方程進行單步求解,預測方程的最終解,從理論上可以在單步內產生圖片

為了訓練潛在的一致性模型,研究提出可以透過對預先訓練的擴散模型(例如,穩定擴散)進行參數微調,在極少的資源消耗下實現模型的快速生成效果。這個蒸餾過程是基於宋颮博士提出的一致性損失函數的最佳化。為了在文生圖任務上獲得更好的表現並減少計算開銷,本文提出了三個關鍵技術:

重寫後的內容:(1)透過使用預先訓練的自動編碼器,將原始圖片編碼成潛在空間中的表示,以在壓縮圖片時減少冗餘訊息,並使圖片在語義上更加一致

(2)將無分類器引導作為模型的一個輸入參數蒸餾進潛在一致性模型中,在享受無分類器引導帶來的更好的圖片- 文本的一致性的同時,由於無分類器引導幅度被作為輸入參數蒸餾進了潛在一致性模型,從而能夠減少推理時的所需的計算開銷;

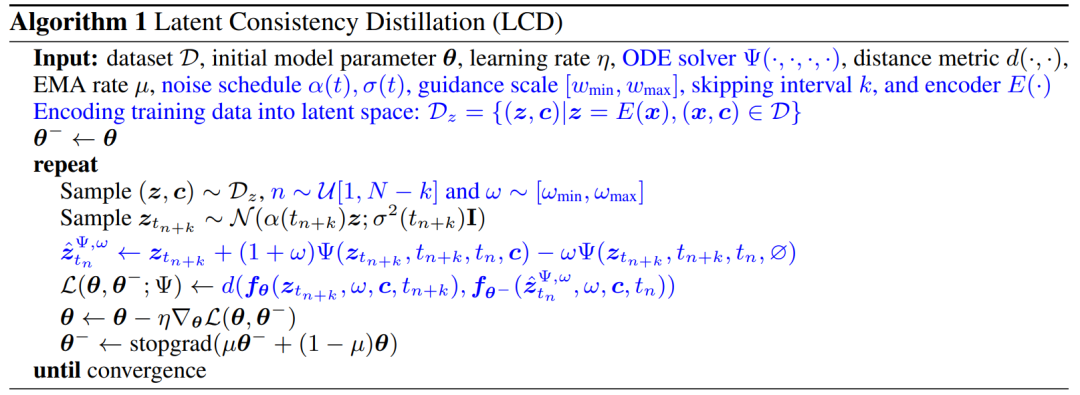

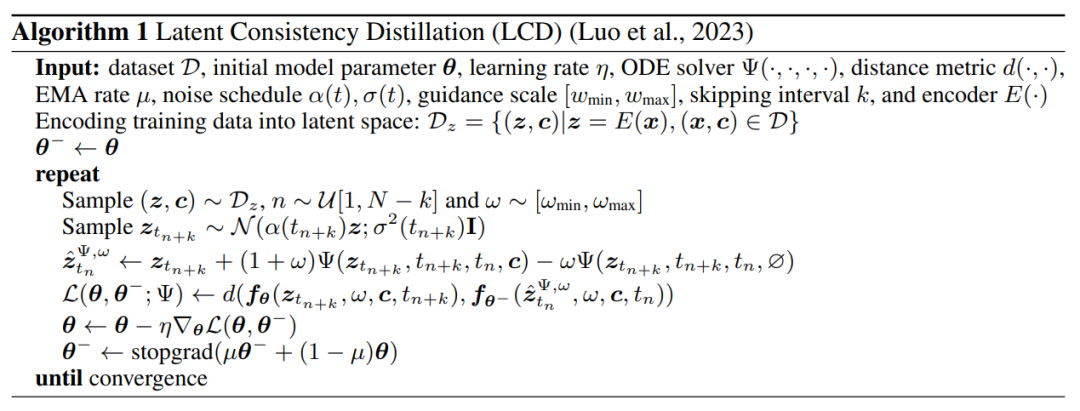

(3)使用跳步策略來計算一致性損失,大大加快了潛在一致性模型的蒸餾過程。潛在一致性模型的蒸餾演算法的偽代碼見下圖。

定性和定量化的結果表明,潛在一致性模型具有快速生成高品質圖片的能力。此模型能夠在1~4步內產生高品質的圖片。透過比較實際的推理時間和產生品質指標FID,可以看出潛在一致性模型相對於現有最快的取樣器之一DPM solver ,在維持同等生成品質的情況下,實際推理時間能夠加速約4倍

LCM 上產生的圖片上RA#.一款通用的穩定傳輸加速模組

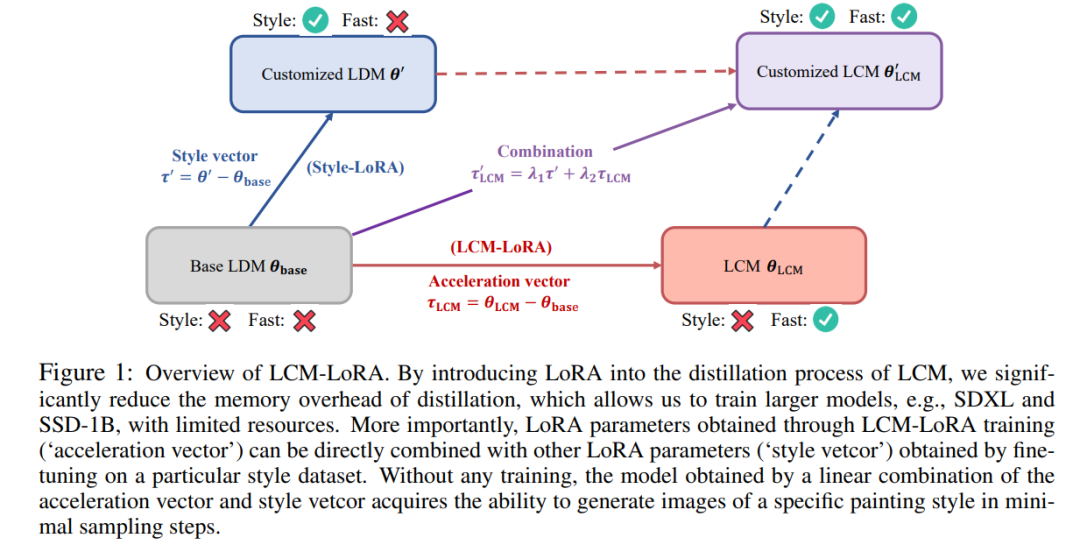

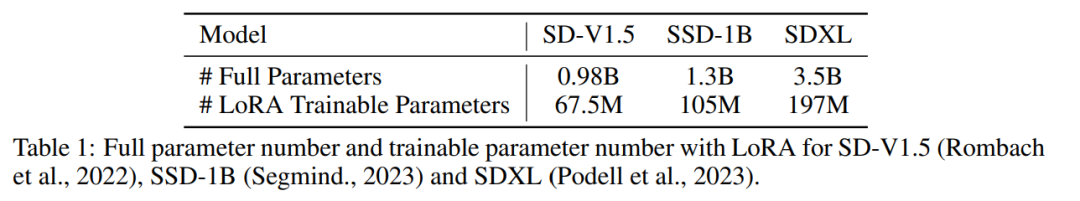

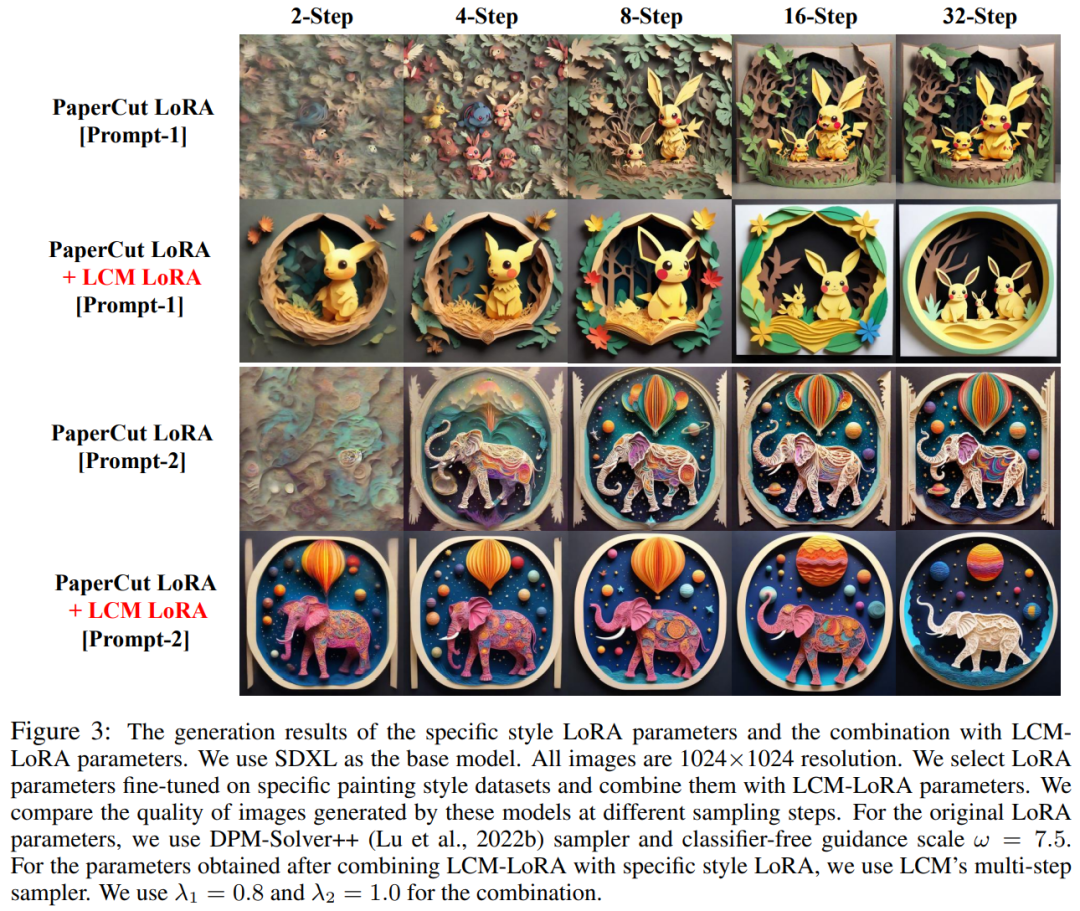

在潛在一致性模型的基礎上,作者團隊隨後進一步發布了他們關於LCM-LoRA 的技術報告。由於潛在一致性模型的蒸餾過程可以被視為是對於原有的預訓練模型的微調過程,從而可以使用 LoRA 等高效微調技術來訓練潛在一致性模型。得益於LoRA 技術帶來的資源節省,作者團隊在Stable Diffusion 系列中參數量最大的SDXL 模型上進行了蒸餾,成功得到了能夠在極少步數內生成與SDXL 數十步相媲美的潛在一致性模型。 在論文引言部分,研究指出儘管潛在擴散模型(LDM)在生成文字圖像和線稿圖像方面取得了成功,但其緩慢的反向採樣過程限制了即時應用,對用戶體驗產生了影響。目前的開源模型和加速技術尚不能在普通消費級GPU上實現即時生成 加速LDM 的方法一般分為兩類:第一類涉及先進的ODE 求解器,如DDIM、DPMSolver 和DPM -Solver ,以加快生成過程。第二類涉及蒸餾 LDM 以簡化其功能。 ODE - 解算器減少了推理步驟,但仍需要大量的計算開銷,尤其是在採用無分類器指導時。同時,蒸餾方法(如 Guided-Distill)雖然前景廣闊,但由於其密集的計算要求而面臨實際限制。在 LDM 生成影像的速度和品質之間尋求平衡仍然是該領域的一項挑戰。 最近,受到一致性模型(Consistency Model,CM)的啟發,出現了潛在一致性模型(Latent Consistency Model,LCM)作為影像生成中緩慢取樣問題的解決方案。 LCM將反向擴散過程視為增強機率流ODE(PF-ODE)問題。這類模型創新地預測了潛空間中的解,無需透過數值ODE求解器進行迭代求解。因此,它們能夠有效率地合成高解析度影像,只需進行1到4個推理步驟。此外,LCM在蒸餾效率方面也表現出色,只需用A100進行32個小時的訓練即可完成最小步驟的推理 在這個基礎上,開發了一種名為潛在一致性微調( LCF)的方法,它可以在無需從教師擴散模型開始的情況下對預訓練的LCM進行微調。對於專業資料集,例如動漫、真實照片或奇幻影像資料集,還需要額外的步驟,例如使用潛在一致性蒸餾(LCD)將預先訓練的LDM蒸餾為LCM,或直接使用LCF對LCM進行微調。然而,這種額外的訓練可能會阻礙LCM在不同資料集上的快速部署,這就提出了一個關鍵問題:是否可以在自訂資料集上實現快速、無需訓練的推理 為了回答上述問題,研究人員提出了LCM-LoRA。 LCM-LoRA是一種通用的免訓練加速模組,可以直接插入各種Stable-Diffusion(SD)微調模型或SD LoRA中,以最少的步驟支援快速推理。與早期的數值機率流ODE(PF-ODE)求解器如DDIM、DPM-Solver和DPM-Solver 相比,LCM-LoRA代表了一類基於神經網路的新型PF-ODE求解器模組。它展示了在各種微調的SD模型和LoRA中的強大泛化能力 LCM-LoRA 概況圖。透過在 LCM 的蒸餾過程中引入 LoRA,該研究大大減少了蒸餾的記憶體開銷,這使得他們能夠利用有限的資源訓練更大的模型,例如 SDXL 和 SSD-1B。更重要的是,透過 LCM-LoRA 訓練獲得的 LoRA 參數(acceleration vector)可以直接與在特定風格資料集上微調獲得的其他 LoRA 參數(style vetcor)相結合。無需任何訓練,透過 acceleration vector 和 style vetcor 的線性組合獲得的模型就能以最少的採樣步驟生成特定繪畫風格的圖像。 LCM-LoRA 技術細節可以重寫為: 通常來講,潛在一致性模型的訓練採用單階段指導蒸餾方式進行,這種方法利用預先訓練的自編碼器潛在空間將指導擴散模型蒸餾為LCM。此過程涉及增強機率流 ODE,我們可以將其理解為一種數學公式,這樣一來可確保生成的樣本遵循生成高品質影像的軌跡。 值得一提的是,蒸餾的重點在於維持這些軌跡的保真度,同時大幅減少所需的取樣步驟數。演算法 1 提供了 LCD 的偽代碼。 由於LCM 的蒸餾過程是在預訓練擴散模型的參數上進行的,因此我們可以將潛在一致性蒸餾視為擴散模型的微調過程,從而就可以採用一些高效率的調參方法,如LoRA。 LoRA updates the pre-trained weight matrix by applying low-rank decomposition. Specifically, given a weight matrix The table below compares the total number of parameters in the full model to the trainable parameters when using LoRA technology. Obviously, by incorporating LoRA technology in the LCM distillation process, the number of trainable parameters is significantly reduced, effectively reducing the memory requirements for training. This study shows through a series of experiments that the LCD paradigm can be well adapted to larger models such as SDXL and SSD-1B. The generation results of different models are shown in Figure 2 Show. The author found that using LoRA technology can improve the efficiency of the distillation process, and also found that the LoRA parameters obtained through training can be used as a general acceleration module that can be directly used with other LoRA Combination use of parameters As shown in Figure 1 above, the author team found that it only needs to simply combine the "style parameters" obtained by fine-tuning on a specific style data set with the "acceleration parameters" obtained by latent consistency distillation. By linear combination, a new potential consistency model with both rapid generation capability and specific style can be obtained. This discovery provides a strong boost to the large number of open source models that already exist in the existing open source community, allowing these models to even enjoy the acceleration effects brought by the latent consistency model without any additional training. In short, LCM -LoRA is a general training-free acceleration module for Stable-Diffusion (SD) models. It functions as a standalone and efficient neural network-based solver module to predict solutions to PF-ODE, enabling fast inference with minimal steps on various fine-tuned SD models and SD LoRA. A large number of text-to-image generation experiments prove the strong generalization ability and superiority of LCM-LoRA Luo Simian is a second-year master's student in the Department of Computer Science and Technology at Tsinghua University, and his supervisor is Professor Zhao Xing. He graduated from the Big Data School of Fudan University with a bachelor's degree. His research direction is multi-modal generative models. He is interested in diffusion models, consistency models and AIGC acceleration, and is committed to developing the next generation of generative models. Previously, he published many papers as the first author at top conferences such as ICCV and NeurIPS The first row (from left to right): Luo Simian, Tan Yiqin. Second row (from left to right): Huang Longbo, Li Jian, Zhao Xing.

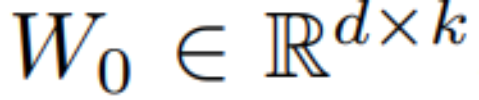

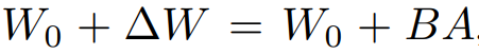

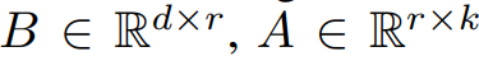

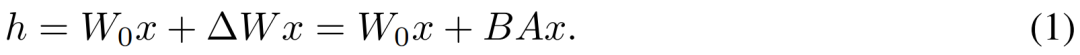

, its update method is expressed as

, its update method is expressed as  , where

, where  , during the training process, W_0 remains unchanged, and the gradient update is only applied to the two parameters A and B. Therefore, for the input As a product of low-rank matrices, LoRA significantly reduces the number of trainable parameters, thereby reducing memory usage.

, during the training process, W_0 remains unchanged, and the gradient update is only applied to the two parameters A and B. Therefore, for the input As a product of low-rank matrices, LoRA significantly reduces the number of trainable parameters, thereby reducing memory usage.

Team introduction

Team introduction

以上是即時文生圖速度提升5-10倍,清華LCM/LCM-LoRA爆火,瀏覽超百萬、下載超20萬的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

ControlNet作者又出爆款!一張圖生成繪畫全過程,兩天狂攬1.4k Star

Jul 17, 2024 am 01:56 AM

ControlNet作者又出爆款!一張圖生成繪畫全過程,兩天狂攬1.4k Star

Jul 17, 2024 am 01:56 AM

同樣是圖生視頻,PaintsUndo走出了不一樣的路線。 ControlNet作者LvminZhang又開始整活了!這次瞄準繪畫領域。新項目PaintsUndo剛上線不久,就收穫1.4kstar(還在瘋狂漲)。項目地址:https://github.com/lllyasviel/Paints-UNDO透過這個項目,用戶輸入一張靜態圖像,PaintsUndo就能自動幫你生成整個繪畫的全過程視頻,從線稿到成品都有跡可循。繪製過程,線條變化多端甚是神奇,最終視頻結果和原始圖像非常相似:我們再來看一個完整的繪

從RLHF到DPO再到TDPO,大模型對齊演算法已經是「token-level」

Jun 24, 2024 pm 03:04 PM

從RLHF到DPO再到TDPO,大模型對齊演算法已經是「token-level」

Jun 24, 2024 pm 03:04 PM

AIxiv專欄是本站發布學術、技術內容的欄位。過去數年,本站AIxiv專欄接收通報了2,000多篇內容,涵蓋全球各大專院校與企業的頂尖實驗室,有效促進了學術交流與傳播。如果您有優秀的工作想要分享,歡迎投稿或聯絡報道。投稿信箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com在人工智慧領域的發展過程中,對大語言模型(LLM)的控制與指導始終是核心挑戰之一,旨在確保這些模型既強大又安全地服務人類社會。早期的努力集中在透過人類回饋的強化學習方法(RL

登頂開源AI軟體工程師榜首,UIUC無Agent方案輕鬆解決SWE-bench真實程式設計問題

Jul 17, 2024 pm 10:02 PM

登頂開源AI軟體工程師榜首,UIUC無Agent方案輕鬆解決SWE-bench真實程式設計問題

Jul 17, 2024 pm 10:02 PM

AIxiv專欄是本站發布學術、技術內容的欄位。過去數年,本站AIxiv專欄接收通報了2,000多篇內容,涵蓋全球各大專院校與企業的頂尖實驗室,有效促進了學術交流與傳播。如果您有優秀的工作想要分享,歡迎投稿或聯絡報道。投稿信箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com這篇論文的作者皆來自伊利諾大學香檳分校(UIUC)張令明老師團隊,包括:StevenXia,四年級博士生,研究方向是基於AI大模型的自動代碼修復;鄧茵琳,四年級博士生,研究方

OpenAI超級對齊團隊遺作:兩個大模型博弈一番,輸出更好懂了

Jul 19, 2024 am 01:29 AM

OpenAI超級對齊團隊遺作:兩個大模型博弈一番,輸出更好懂了

Jul 19, 2024 am 01:29 AM

如果AI模型給的答案一點也看不懂,你敢用嗎?隨著機器學習系統在更重要的領域中得到應用,證明為什麼我們可以信任它們的輸出,並明確何時不應信任它們,變得越來越重要。獲得對複雜系統輸出結果信任的一個可行方法是,要求系統對其輸出產生一種解釋,這種解釋對人類或另一個受信任的系統來說是可讀的,即可以完全理解以至於任何可能的錯誤都可以被發現。例如,為了建立對司法系統的信任,我們要求法院提供清晰易讀的書面意見,解釋並支持其決策。對於大型語言模型來說,我們也可以採用類似的方法。不過,在採用這種方法時,確保語言模型生

公理訓練讓LLM學會因果推理:6700萬參數模型比肩萬億參數級GPT-4

Jul 17, 2024 am 10:14 AM

公理訓練讓LLM學會因果推理:6700萬參數模型比肩萬億參數級GPT-4

Jul 17, 2024 am 10:14 AM

把因果鏈展示給LLM,它就能學會公理。 AI已經在幫助數學家和科學家做研究了,例如著名數學家陶哲軒就曾多次分享自己借助GPT等AI工具研究探索的經驗。 AI要在這些領域大戰拳腳,強大可靠的因果推理能力是不可或缺的。本文要介紹的研究發現:在小圖譜的因果傳遞性公理演示上訓練的Transformer模型可以泛化用於大圖譜的傳遞性公理。也就是說,如果讓Transformer學會執行簡單的因果推理,就可能用於更複雜的因果推理。該團隊提出的公理訓練框架是一種基於被動資料來學習因果推理的新範式,只有演示

arXiv論文可以發「彈幕」了,史丹佛alphaXiv討論平台上線,LeCun按讚

Aug 01, 2024 pm 05:18 PM

arXiv論文可以發「彈幕」了,史丹佛alphaXiv討論平台上線,LeCun按讚

Aug 01, 2024 pm 05:18 PM

乾杯!當論文討論細緻到詞句,是什麼體驗?最近,史丹佛大學的學生針對arXiv論文創建了一個開放討論論壇——alphaXiv,可以直接在任何arXiv論文之上發布問題和評論。網站連結:https://alphaxiv.org/其實不需要專門訪問這個網站,只需將任何URL中的arXiv更改為alphaXiv就可以直接在alphaXiv論壇上打開相應論文:可以精準定位到論文中的段落、句子:右側討論區,使用者可以發表問題詢問作者論文想法、細節,例如:也可以針對論文內容發表評論,例如:「給出至

黎曼猜想显著突破!陶哲轩强推MIT、牛津新论文,37岁菲尔兹奖得主参与

Aug 05, 2024 pm 03:32 PM

黎曼猜想显著突破!陶哲轩强推MIT、牛津新论文,37岁菲尔兹奖得主参与

Aug 05, 2024 pm 03:32 PM

最近,被稱為千禧年七大難題之一的黎曼猜想迎來了新突破。黎曼猜想是數學中一個非常重要的未解決問題,與素數分佈的精確性質有關(素數是那些只能被1和自身整除的數字,它們在數論中扮演著基礎性的角色)。在當今的數學文獻中,已有超過一千個數學命題以黎曼猜想(或其推廣形式)的成立為前提。也就是說,黎曼猜想及其推廣形式一旦被證明,這一千多個命題將被確立為定理,對數學領域產生深遠的影響;而如果黎曼猜想被證明是錯誤的,那麼這些命題中的一部分也將隨之失去其有效性。新的突破來自MIT數學教授LarryGuth和牛津大學

LLM用於時序預測真的不行,連推理能力都沒用到

Jul 15, 2024 pm 03:59 PM

LLM用於時序預測真的不行,連推理能力都沒用到

Jul 15, 2024 pm 03:59 PM

語言模型真的能用於時序預測嗎?根據貝特里奇頭條定律(任何以問號結尾的新聞標題,都能夠用「不」來回答),答案應該是否定的。事實似乎也果然如此:強大如斯的LLM並不能很好地處理時序資料。時序,即時間序列,顧名思義,是指一組依照時間發生先後順序排列的資料點序列。在許多領域,時序分析都很關鍵,包括疾病傳播預測、零售分析、醫療和金融。在時序分析領域,近期不少研究者都在研究如何使用大型語言模型(LLM)來分類、預測和偵測時間序列中的異常。這些論文假設擅長處理文本中順序依賴關係的語言模型也能泛化用於時間序