來一趟未來之旅,首個多視圖預測+規劃自動駕駛世界模型抵達

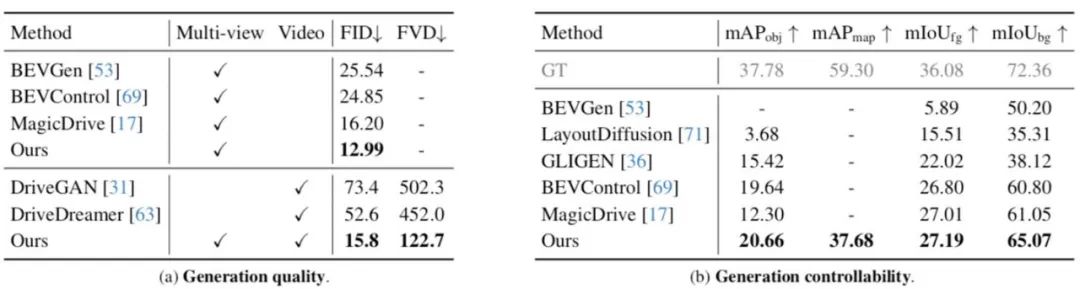

近期,世界模型的概念引發了火熱浪潮,而自動駕駛領域豈能隔岸觀「火」。來自中科院自動化所的團隊,首次提出了名為 Drive-WM 的全新多視圖世界模型,旨在增強端到端自動駕駛規劃的安全性。

網址:https://drive-wm.github.io

論文網址:https ://arxiv.org/abs/2311.17918

首個多視圖預測與規劃的自動駕駛世界模型

在CVPR2023 自動駕駛的研討會上,特斯拉和Wayve 兩大科技巨頭狂秀黑科技,一種名為「生成式世界模型」的全新概念隨之火爆自動駕駛領域。 Wayve 更是發布了 GAIA-1 的生成式 AI 模型,展現了令人震撼的影片場景產生能力。而最近,中科院自動化所的研究者們也提出了一個新的自動駕駛世界模型——Drive-WM,首次實現了多視圖預測的世界模型,與當下主流的端到端自動駕駛規劃器無縫結合。

Drive-WM 利用了 Diffusion 模型的強大生成能力,能夠產生逼真的影片場景。

想像一下,你正在開車,而你的車載系統正在根據你的駕駛習慣和路況預測未來的發展,並產生相應的視覺回饋來指導軌跡路線的選擇。這種預見未來的能力和規劃器結合,將大大提高自動駕駛的安全性!

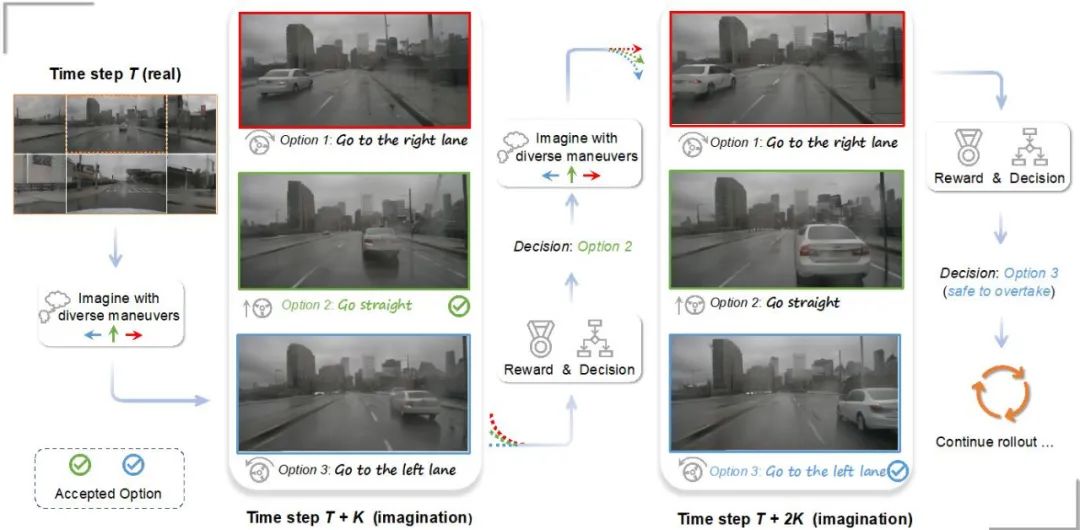

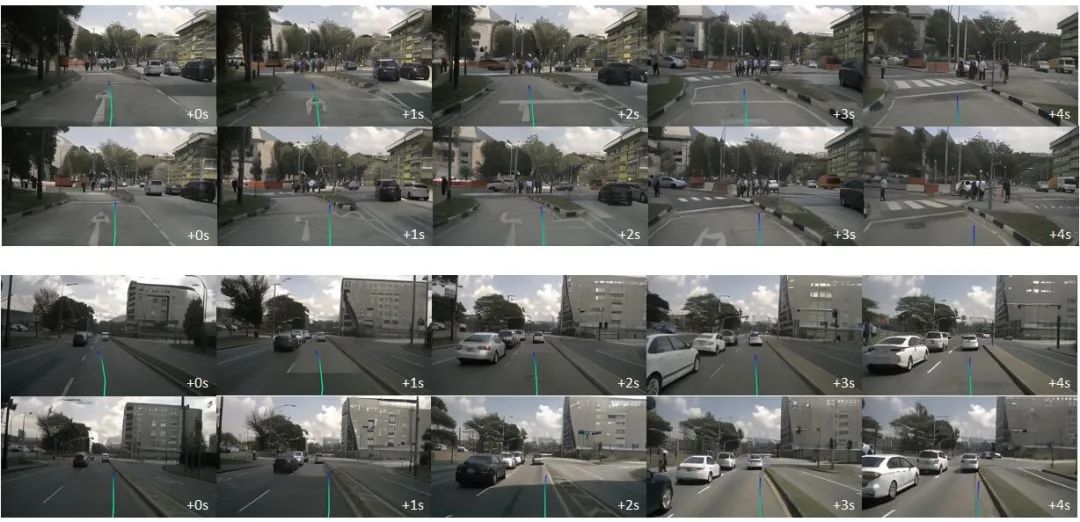

基於多重視圖世界模型的預測與規劃。

世界模型與端對端自動駕駛的結合提升駕駛安全性

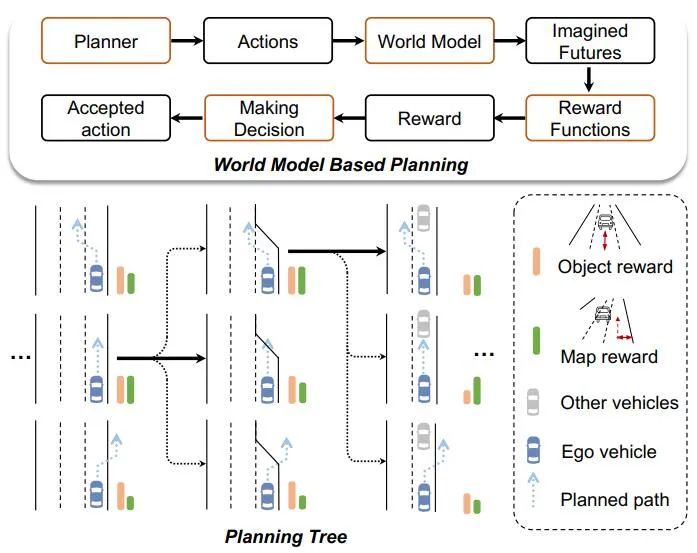

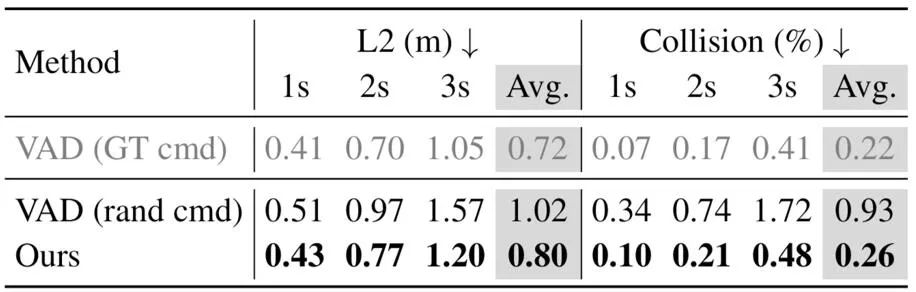

Drive-WM 模型首次將世界模型與端到端規劃相結合,為端到端自動駕駛的發展開啟了新的篇章。在每個時間步上,規劃器可以藉助世界模型預測未來可能發生的情景,再利用影像獎勵函數全面評估。

基於世界模型的端對端軌跡規劃樹可以進行重寫

採用最佳估計法和擴展規劃樹技術,可以實現更有效和安全的規劃

Drive-WM透過創新地研究,探索了世界模型在端到端規劃中的兩種應用

1. 展示了世界模型在面對OOD場景時的穩健性。作者透過對比實驗發現了目前的端到端規劃者在面對 OOD 情境時的表現並不理想。

作者給出了以下圖片,當對初始位置進行輕微的橫向偏移擾動後,目前的端到端規劃器就難以輸出合理的規劃路線。

端到端規劃器在面對 OOD 情況時難以輸出合理的規劃路線。

Drive-WM的強大生成能力為解決OOD問題提供了新的思路。作者利用產生的影片來微調規劃器,從OOD資料中進行學習,使得規劃器在面對這樣的場景時可以擁有更好的性能

2. 這表明了引入未來場景評估對於端到端規劃的增強作用

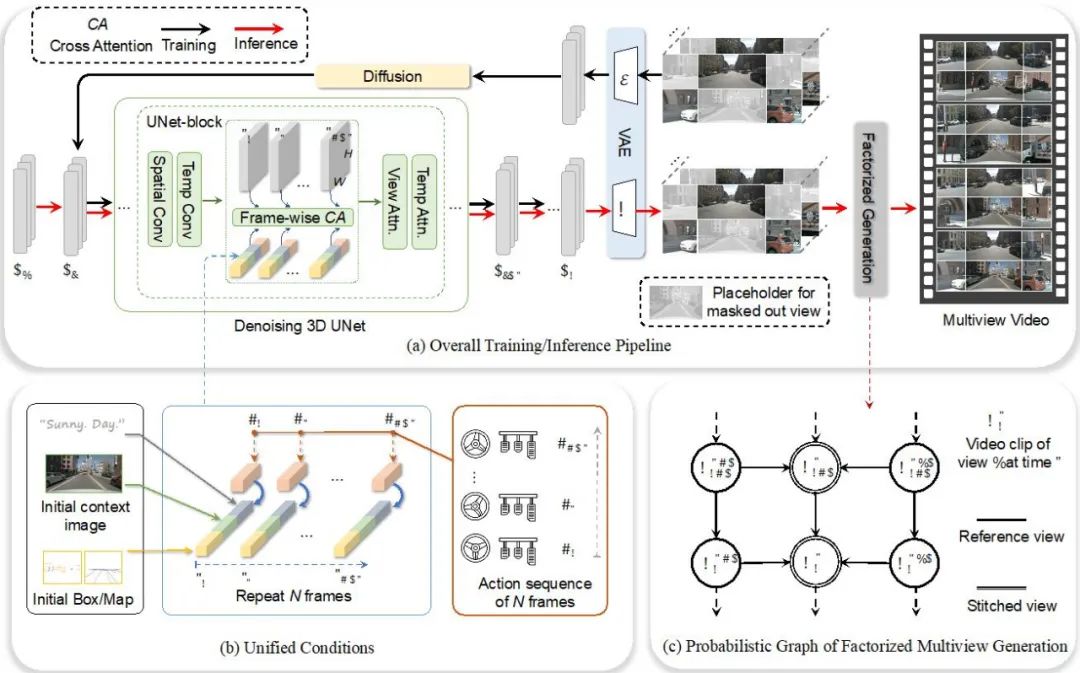

#如何建立多視圖的視訊生成模型

#多視圖影片產生的時空一致性一直以來都是一個具有挑戰性的問題。 Drive-WM 透過引入時序層的編碼來擴展視訊生成的能力,並透過視圖分解建模的方式實現多視圖的視訊生成。這種視圖分解的產生方式可以大幅提升視圖之間的一致性

#Drive-WM 整體模型設計

#高品質的影片生成與可控性

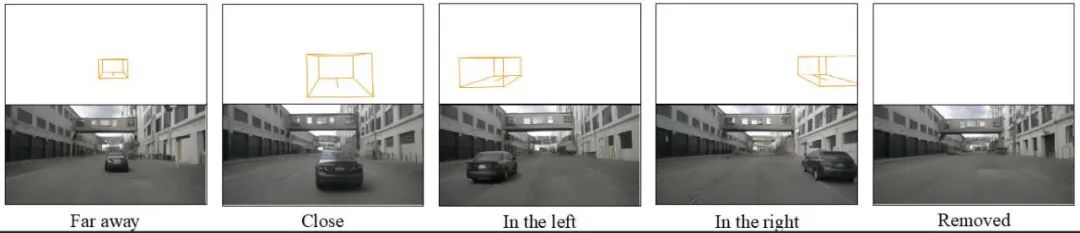

Drive-WM實現了高品質的多視圖影片生成,並且具有出色的可控性。它提供了多種控制選項,可以透過文字、場景佈局、運動資訊來控制多視圖影片的生成,也為未來的神經模擬器提供了新的可能性

例如使用文字來改變天氣和光照:

例如,行人的產生和前景的編輯:

利用速度和方向的控制方法:

###來產生稀有事件,例如在路口掉頭或開進側方草叢######

結語

Drive-WM 不僅展示了其強大的多視圖視訊生成能力,也揭示了世界模型與端到端駕駛模型結合的巨大潛力。相信在未來,世界模型可以幫助實現更安全、穩定、可靠的端到端自動駕駛系統。

以上是來一趟未來之旅,首個多視圖預測+規劃自動駕駛世界模型抵達的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

為何在自動駕駛方面Gaussian Splatting如此受歡迎,開始放棄NeRF?

Jan 17, 2024 pm 02:57 PM

為何在自動駕駛方面Gaussian Splatting如此受歡迎,開始放棄NeRF?

Jan 17, 2024 pm 02:57 PM

寫在前面&筆者的個人理解三維Gaussiansplatting(3DGS)是近年來在顯式輻射場和電腦圖形學領域出現的一種變革性技術。這種創新方法的特點是使用了數百萬個3D高斯,這與神經輻射場(NeRF)方法有很大的不同,後者主要使用隱式的基於座標的模型將空間座標映射到像素值。 3DGS憑藉其明確的場景表示和可微分的渲染演算法,不僅保證了即時渲染能力,而且引入了前所未有的控制和場景編輯水平。這將3DGS定位為下一代3D重建和表示的潛在遊戲規則改變者。為此我們首次系統性地概述了3DGS領域的最新發展與關

自動駕駛場景中的長尾問題怎麼解決?

Jun 02, 2024 pm 02:44 PM

自動駕駛場景中的長尾問題怎麼解決?

Jun 02, 2024 pm 02:44 PM

昨天面試被問到了是否做過長尾相關的問題,所以就想著簡單總結一下。自動駕駛長尾問題是指自動駕駛汽車中的邊緣情況,即發生機率較低的可能場景。感知的長尾問題是目前限制單車智慧自動駕駛車輛運行設計域的主要原因之一。自動駕駛的底層架構和大部分技術問題已經解決,剩下的5%的長尾問題,逐漸成了限制自動駕駛發展的關鍵。這些問題包括各種零碎的場景、極端的情況和無法預測的人類行為。自動駕駛中的邊緣場景"長尾"是指自動駕駛汽車(AV)中的邊緣情況,邊緣情況是發生機率較低的可能場景。這些罕見的事件

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

超越ORB-SLAM3! SL-SLAM:低光、嚴重抖動和弱紋理場景全搞定

May 30, 2024 am 09:35 AM

寫在前面今天我們探討下深度學習技術如何改善在複雜環境中基於視覺的SLAM(同時定位與地圖建構)表現。透過將深度特徵提取和深度匹配方法相結合,這裡介紹了一種多功能的混合視覺SLAM系統,旨在提高在諸如低光條件、動態光照、弱紋理區域和嚴重抖動等挑戰性場景中的適應性。我們的系統支援多種模式,包括拓展單目、立體、單目-慣性以及立體-慣性配置。除此之外,也分析如何將視覺SLAM與深度學習方法結合,以啟發其他研究。透過在公共資料集和自採樣資料上的廣泛實驗,展示了SL-SLAM在定位精度和追蹤魯棒性方面優

選擇相機還是光達?實現穩健的三維目標檢測的最新綜述

Jan 26, 2024 am 11:18 AM

選擇相機還是光達?實現穩健的三維目標檢測的最新綜述

Jan 26, 2024 am 11:18 AM

0.寫在前面&&個人理解自動駕駛系統依賴先進的感知、決策和控制技術,透過使用各種感測器(如相機、光達、雷達等)來感知周圍環境,並利用演算法和模型進行即時分析和決策。這使得車輛能夠識別道路標誌、檢測和追蹤其他車輛、預測行人行為等,從而安全地操作和適應複雜的交通環境。這項技術目前引起了廣泛的關注,並認為是未來交通領域的重要發展領域之一。但是,讓自動駕駛變得困難的是弄清楚如何讓汽車了解周圍發生的事情。這需要自動駕駛系統中的三維物體偵測演算法可以準確地感知和描述周圍環境中的物體,包括它們的位置、

你是否真正掌握了座標系轉換?自動駕駛離不開的多感測器問題

Oct 12, 2023 am 11:21 AM

你是否真正掌握了座標系轉換?自動駕駛離不開的多感測器問題

Oct 12, 2023 am 11:21 AM

一先導與重點文章主要介紹自動駕駛技術中幾種常用的座標系統,以及他們之間如何完成關聯與轉換,最終建構出統一的環境模型。這裡重點理解自車到相機剛體轉換(外參),相機到影像轉換(內參),影像到像素有單位轉換。 3d向2d轉換會有對應的畸變,平移等。重點:自車座標系相機機體座標系需要被重寫的是:平面座標系像素座標系難點:要考慮影像畸變,去畸變和加畸變都是在像平面上去補償二簡介視覺系統一共有四個座標系:像素平面座標系(u,v)、影像座標系(x,y)、相機座標系()與世界座標系()。每種座標系之間均有聯繫,

自動駕駛與軌跡預測看這篇就夠了!

Feb 28, 2024 pm 07:20 PM

自動駕駛與軌跡預測看這篇就夠了!

Feb 28, 2024 pm 07:20 PM

軌跡預測在自動駕駛中承擔著重要的角色,自動駕駛軌跡預測是指透過分析車輛行駛過程中的各種數據,預測車輛未來的行駛軌跡。作為自動駕駛的核心模組,軌跡預測的品質對於下游的規劃控制至關重要。軌跡預測任務技術堆疊豐富,需熟悉自動駕駛動/靜態感知、高精地圖、車道線、神經網路架構(CNN&GNN&Transformer)技能等,入門難度很高!許多粉絲期望能夠盡快上手軌跡預測,少踩坑,今天就為大家盤點下軌跡預測常見的一些問題和入門學習方法!入門相關知識1.預習的論文有沒有切入順序? A:先看survey,p

SIMPL:用於自動駕駛的簡單高效的多智能體運動預測基準

Feb 20, 2024 am 11:48 AM

SIMPL:用於自動駕駛的簡單高效的多智能體運動預測基準

Feb 20, 2024 am 11:48 AM

原文標題:SIMPL:ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving論文連結:https://arxiv.org/pdf/2402.02519.pdf程式碼連結:https://github.com/HKUST-Aerial-Robotics/SIMPLobotics單位論文想法:本文提出了一種用於自動駕駛車輛的簡單且有效率的運動預測基線(SIMPL)。與傳統的以代理為中心(agent-cent

聊聊端到端與下一代自動駕駛系統,以及端到端自動駕駛的一些迷思?

Apr 15, 2024 pm 04:13 PM

聊聊端到端與下一代自動駕駛系統,以及端到端自動駕駛的一些迷思?

Apr 15, 2024 pm 04:13 PM

最近一個月由於眾所周知的一些原因,非常密集地和業界的各種老師同學進行了交流。交流中必不可免的一個話題自然是端到端與火辣的特斯拉FSDV12。想藉此機會,整理當下這個時刻的一些想法和觀點,供大家參考和討論。如何定義端到端的自動駕駛系統,應該期望端到端解決什麼問題?依照最傳統的定義,端到端的系統指的是一套系統,輸入感測器的原始訊息,直接輸出任務關心的變數。例如,在影像辨識中,CNN相對於傳統的特徵提取器+分類器的方法就可以稱之為端到端。在自動駕駛任務中,輸入各種感測器的資料(相機/LiDAR