AI影片生成神器再次登場。最近,阿里巴巴和位元組跳動秘密上線了各自的工具

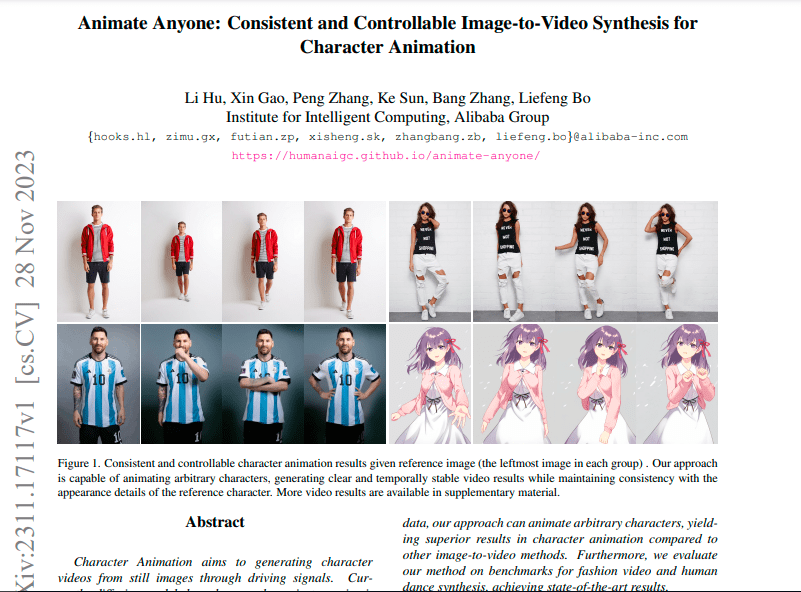

阿里推出了Animate Anyone,該專案由阿里巴巴智慧計算研究院開發,你只需提供一個靜態的角色圖像(包括真人、動畫/卡通角色等)和一些動作、姿勢(例如跳舞、走路) ,便可將其動畫化,同時保留角色的細節特徵(如面部表情、服裝細節等)。

只要有一張梅西的照片,就能讓「球王」擺上各種Pose(見下圖),照著這原理,讓梅西跳舞也不在話下。

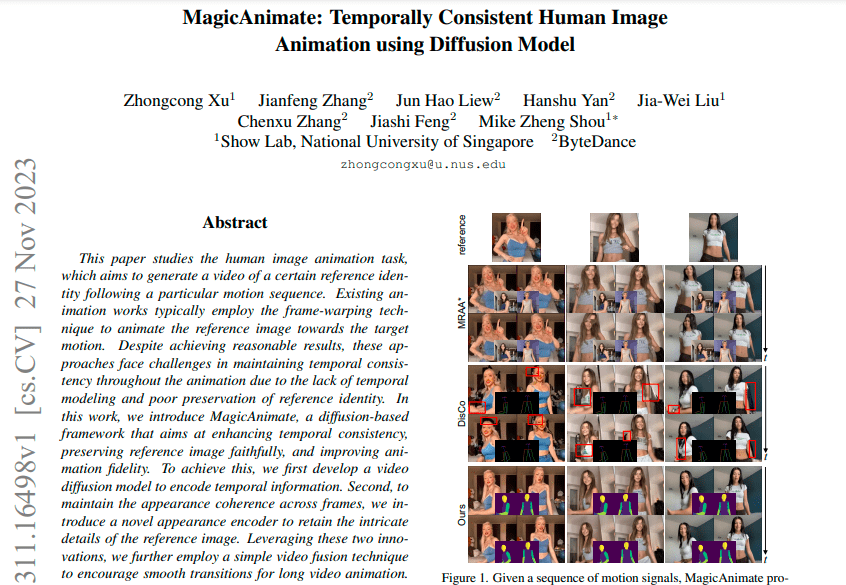

新加坡國立大學和位元組跳動則聯合推出了Magic Animate,同樣是利用AI技術,將靜態影像變成動態影片。位元組方面表示,在挑戰性極高的TikTok舞蹈資料集上,Magic Animate產生的影片的真實性比最強基線提高了超過38%。

在圖生影片專案中,阿里巴巴和位元組跳動齊頭並進,幾乎同時完成了論文發布、程式碼公開和測試地址公開等一系列操作,兩者的相關論文發佈時間僅相差一天

11月27日發布了有關位元組的相關論文:

阿里相關的論文將於11月28日發布:

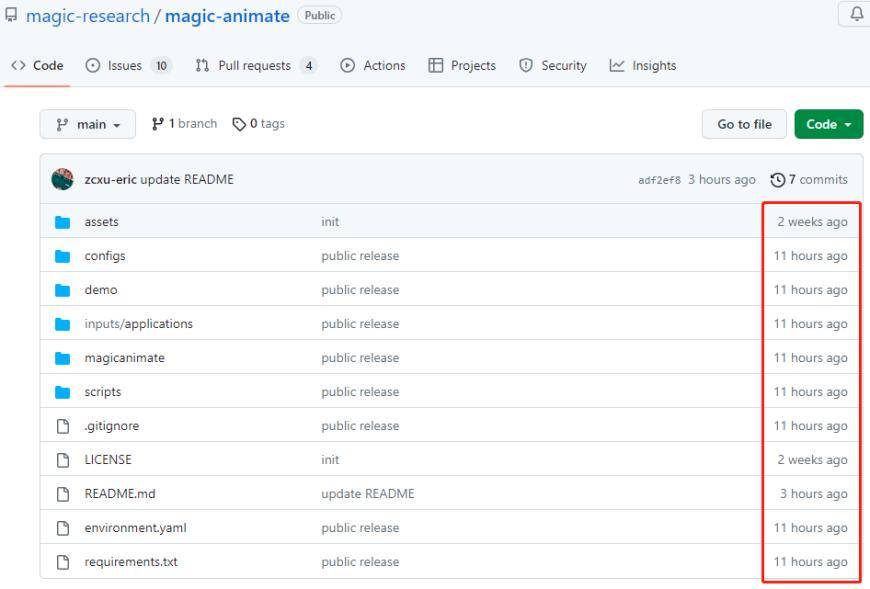

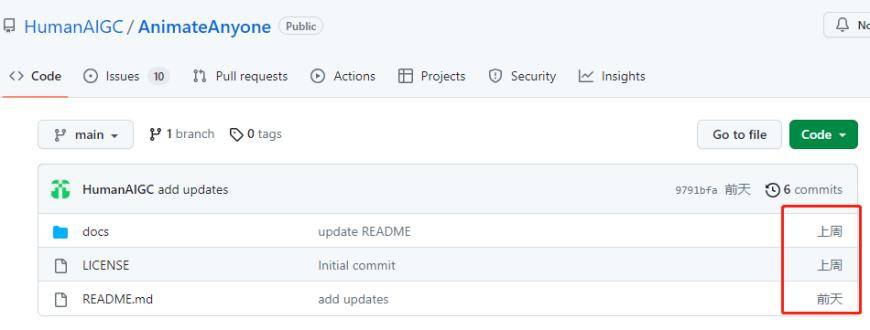

兩家公司的開源檔案在Github上持續更新

需要重寫的內容是:Magic Animate的開源專案檔案包

Animate Anyone的開源專案檔案包

這又點出一個事實:影片產生是AIGC熱門競技項目,科技巨頭、明星公司均密切關注並積極投入。據了解,Runway、Meta、Stable AI已經推出AI文生視訊應用,Adobe也在近日宣布收購AI影片創作公司Rephrase.ai。

從上述兩家公司的展示影片來看,生成效果有了十分顯著的提升,流暢度、真實感更勝以往。一改當下影像/影片產生應用程式存在的缺點,如局部扭曲、細節模糊、不符合提示詞、與原圖有差異、掉幀、畫面抖動。

這兩個工具都是透過擴散模型(diffusion models)創造時間連貫的人像動畫,其訓練資料很多是一樣的。兩者都用到的Stable Diffusion是由CompVis、Stability AI和LAION的研究人員和工程師創建的文本到圖像的潛在擴散模型,該模型使用來自LAION-5B數據庫子集的 512x512圖像進行訓練。 LAION-5B是目前存在的最大的、可免費存取的多模式資料集。

談到應用,阿里的研究人員在論文中表示,Animate Anybody作為基礎方法,未來有可能擴展到各種圖生視訊應用,該工具有許多潛在的應用場景,例如線上零售、娛樂影片、藝術創作和虛擬角色。位元組跳動也強調Magic Animate展現了強大的泛化能力,可以應用到多個場景。

多模態應用的「聖杯」:文生視頻 文生視訊是指透過結合文字和語音的技術,實現對視訊內容進行多模態分析和處理的應用。它將文字和語音訊息與視訊影像進行關聯,從而提供更豐富的視訊理解和互動體驗。 文生視訊應用具有廣泛的應用領域,包括智慧視訊監控、虛擬實境、影片編輯和內容分析等。透過文字和語音的分析,文生影片可以識別和理解影片中的物件、場景和動作,從而為使用者提供更智慧化的視訊處理和控制功能。 在智慧視訊監控領域,文生視訊可以實現監控視訊內容的自動標註和分類,從而提高監控效率和準確性。在虛擬實境領域,文生視訊可以將使用者的語音指令與虛擬環境進行交互,實現更沉浸式的虛擬體驗。在影片編輯和內容分析領域,文生影片可以幫助用戶自動提取影片中的關鍵訊息,並進行智慧編輯和剪輯。 總之,文生影片作為多模態應用的“聖杯”,為影片內容的理解和互動提供了更全面和智慧化的解決方案。它的發展將為各個領域帶來更多的創新和便利,推動科技進步和社會發展

#影片比文字和圖片更具優勢,它能夠更好地表達訊息,豐富畫面,並具有動態性。影片可以將文字、圖像、聲音和視覺效果結合,融合多種訊息形式在一個媒體中呈現

AI視訊工具具備強大的產品功能,可以開拓更廣闊的應用場景。透過簡單的文字描述或其他操作,AI影片工具能夠產生高品質和完整度的影片內容,從而降低了影片創作的門檻。這使得非專業人士也能夠透過影片準確地展示內容,並有望在各個細分行業中提高內容生產的效率並輸出更多創意

國盛證券宋嘉吉此前指出,AI文生視頻是多模態應用的下一站,是多模態AIGC“聖杯”,隨著AI視頻補齊了AI創作多模態的最後一塊拼圖,下游應用的加速時刻也將到來;申港證券表示,視頻AI是多模態領域的最後一環;華泰證券表示,AIGC大潮已逐步從文生文和文生圖轉向文生視頻領域,文生視頻的高計算難度和高數據要求將支撐上游AI算力需求持續旺盛。

不過,大公司之間、大公司與新創企業間的差距不算大,甚至可以說處於同一起跑線。目前文生影片可公測應用程式較少,僅有Runway Gen-2、Zero Scope及Pika等少數。即便如Meta和Google這樣的矽谷人工智慧巨頭,在文生影片上同樣進展緩慢,它們分別推出的Make-A-Video和Phenaki均尚未公測。

從技術面來看,影片產生工具的底層模型和技術仍在不斷優化。目前主流的文生視訊模型主要使用Transformer模型和擴散模型。擴散模型的工具主要致力於提升視訊質量,克服了效果粗糙、缺乏細節的問題。不過,這些影片的長度都在4秒內

另一方面,儘管擴散模型效果出色,但其訓練過程需要大量的記憶體和算力,這使得只有大公司和獲得大量投資的新創公司才能承擔得起模型訓練的成本

來源:科創板日報

以上是AI應用下一個熱門應用程式已經出現:阿里巴巴和位元組跳動悄悄上線了一款類似神器,可以讓梅西跳舞輕而易舉的詳細內容。更多資訊請關注PHP中文網其他相關文章!