開源大模型必須超越閉源——LeCun揭示2024年AI趨勢圖

2023 年即將過去。一年以來,各式各樣的大模型爭相發布。當 OpenAI 和Google等科技巨頭正在競爭時,另一方「勢力」悄悄崛起 —— 開源。

開源模型受到的質疑一向不少。它們是否能像專有模型一樣優秀?是否能夠媲美專有模型的性能?到目前為止,我們一直只能說是某些方面接近。即便如此,開源模型總是會為我們帶來經驗的表現,讓我們刮目相看。

開源模型的興起正在改變遊戲規則。如 Meta 的 LLaMA 系列以其快速迭代、可自訂性和隱私性正受到追捧。這些模型被社群迅速發展,為專有模型帶來了強大的挑戰,能夠改變大型科技公司的競爭格局。

不過先前人們的想法大多只是來自於「感覺」。今天早上,Meta 首席AI 科學家、圖靈獎得主Yann LeCun 突然發出了這樣的感嘆:「開源人工智慧模型正走在超越專有模型的路上。」

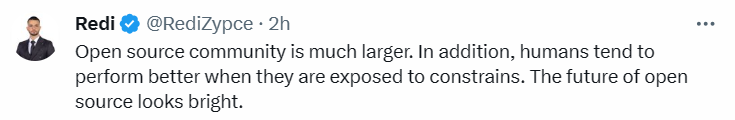

這個由方舟投資(ARK Invest)團隊製作的趨勢圖被認為可能預測了2024年的人工智慧發展。它展示了開源社群與專有模式在生成式人工智慧方面的發展

#隨著OpenAI和Google等公司變得越來越封閉,他們公開最新模型資訊的頻率越來越少。因此,開源社群及其企業支持者Meta開始步入其後,使得生成式AI更加民主化,這或許會對專有模式的商業模式構成挑戰

在這個散佈圖中顯示了各種AI 模型的性能百分比。專有模型以藍色表示,開源模型以黑色表示。我們可以看到不同的 AI 模型如 GPT-3、Chinchilla 70B(Google)、PaLM(Google)、GPT-4(OpenAI)和 Llama65B(Meta)等在不同時間點的表現。

Meta 最初發布 LLaMA 時,參數量從 70 億到 650 億不等。這些模型的性能非常優異:具有130 億參數的Llama 模型「在大多數基準上」可以勝過GPT-3(參數量達1750 億),而且可以在單塊V100 GPU 上運行;而最大的650 億參數的Llama 模型可以媲美Google的Chinchilla-70B 和PaLM-540B。

Falcon-40B 剛發布就衝上了 Huggingface 的 OpenLLM 排行榜首位,改變了 Llama 一枝獨秀的場面。

Llama 2 開源,再一次使大模型格局發生巨變。相較於 Llama 1,Llama 2 的訓練資料多了 40%,上下文長度也翻倍,並採用了分組查詢注意力機制。

最近,開源大模型宇宙又有了新的重量級成員 ——Yi 模型。它能一次處理 40 萬漢字、中英均霸榜。 Yi-34B 也成為迄今為止唯一成功登頂 Hugging Face 開源模型排行榜的國產模型。

根據散佈圖所示,開源模型的效能不斷追趕專有模型。這意味著在不久的將來,開源模型有望與專有模型在性能上並駕齊驅,甚至超越

Mistral 8x7B在上週末以最樸素的發布方式和強大的性能引起了研究者的高度評價,他們表示「閉源大模型走到結局了。」

#已經有網友開始預祝「2024年成為開源人工智慧年」,認為「我們正在接近一個臨界點。考慮到當前開源社群專案的發展速度,我們預計未來12個月內將達到GPT-4的水平。」

##接下來,我們將拭目以待開源模型的未來是否一帆風順,以及它將展現出怎樣的表現

以上是開源大模型必須超越閉源——LeCun揭示2024年AI趨勢圖的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

大宗交易的虛擬貨幣交易平台排行榜top10最新發布

Apr 22, 2025 am 08:18 AM

大宗交易的虛擬貨幣交易平台排行榜top10最新發布

Apr 22, 2025 am 08:18 AM

選擇大宗交易平台時應考慮以下因素:1. 流動性:優先選擇日均交易量超50億美元的平台。 2. 合規性:查看平台是否持有美國FinCEN、歐盟MiCA等牌照。 3. 安全性:冷錢包存儲比例和保險機制是關鍵指標。 4. 服務能力:是否提供專屬客戶經理和定制化交易工具。

數字貨幣交易所App前十名蘋果版下載入口匯總

Apr 22, 2025 am 09:27 AM

數字貨幣交易所App前十名蘋果版下載入口匯總

Apr 22, 2025 am 09:27 AM

提供各種複雜的交易工具和市場分析。覆蓋 100 多個國家,日均衍生品交易量超 300 億美元,支持 300 多個交易對與 200 倍槓桿,技術實力強大,擁有龐大的全球用戶基礎,提供專業的交易平台、安全存儲解決方案以及豐富的交易對。

排名前十的虛擬貨幣交易app有哪些 十大數字貨幣交易所平台推薦

Apr 22, 2025 pm 01:12 PM

排名前十的虛擬貨幣交易app有哪些 十大數字貨幣交易所平台推薦

Apr 22, 2025 pm 01:12 PM

2025年安全的數字貨幣交易所排名前十依次為:1. Binance,2. OKX,3. gate.io,4. Coinbase,5. Kraken,6. Huobi,7. Bitfinex,8. KuCoin,9. Bybit,10. Bitstamp,這些平台均採用了多層次的安全措施,包括冷熱錢包分離、多重簽名技術以及24/7的監控系統,確保用戶資金的安全。

穩定幣有哪些?穩定幣如何交易?

Apr 22, 2025 am 10:12 AM

穩定幣有哪些?穩定幣如何交易?

Apr 22, 2025 am 10:12 AM

常見的穩定幣有:1. 泰達幣(USDT),由Tether發行,與美元掛鉤,應用廣泛但透明性曾受質疑;2. 美元幣(USDC),由Circle和Coinbase發行,透明度高,受機構青睞;3. 戴幣(DAI),由MakerDAO發行,去中心化,DeFi領域受歡迎;4. 幣安美元(BUSD),由幣安和Paxos合作,交易和支付表現出色;5. 真實美元(TUSD),由TrustTo

目前有多少穩定幣交易所?穩定幣種類有多少?

Apr 22, 2025 am 10:09 AM

目前有多少穩定幣交易所?穩定幣種類有多少?

Apr 22, 2025 am 10:09 AM

截至2025年,穩定幣交易所數量約為千家。 1. 法定貨幣支持的穩定幣包括USDT、USDC等。 2. 加密貨幣支持的穩定幣如DAI、sUSD。 3. 算法穩定幣如TerraUSD。 4. 還有混合型穩定幣。

幣圈十大交易所有哪些 最新幣圈app推薦

Apr 24, 2025 am 11:57 AM

幣圈十大交易所有哪些 最新幣圈app推薦

Apr 24, 2025 am 11:57 AM

選擇可靠的交易所至關重要,Binance、OKX、Gate.io等十大交易所各具特色,CoinGecko、Crypto.com等新app也值得關注。

2025下一個千倍幣可能有哪些

Apr 24, 2025 pm 01:45 PM

2025下一個千倍幣可能有哪些

Apr 24, 2025 pm 01:45 PM

截至2025年4月,有七个加密货币项目被认为具有显著增长潜力:1. Filecoin(FIL)通过分布式存储网络实现快速发展;2. Aptos(APT)以高性能Layer 1公链吸引DApp开发者;3. Polygon(MATIC)提升以太坊网络性能;4. Chainlink(LINK)作为去中心化预言机网络满足智能合约需求;5. Avalanche(AVAX)以快速交易和