最近在 Arxiv 上阅读到一篇关于纯视觉环视感知的最新研究,该研究基于 PETR 系列方法,并专注于解决远距离目标检测的纯视觉感知问题,将感知范围扩大到150米。这篇论文的方法和结果对我们来说有很大的参考价值,所以我尝试着对其进行解读

原标题:Far3D: Expanding the Horizon for Surround-view 3D Object Detection

论文链接:https://arxiv.org/abs/2308.09616

作者单位:北京理工大学 & 旷视科技

三维物体检测在理解自动驾驶的三维场景方面发挥着重要作用,其目的是对自车周围的物体进行精确定位和分类。纯视觉环视感知方法具有成本低、适用性广等优点,已取得显著进展。然而,它们大多侧重于近距离感知(例如,nuScenes的感知距离约为 50 米),对远距离探测领域的探索较少。检测远距离物体对于实际驾驶中保持安全距离至关重要,尤其是在高速或复杂路况下。

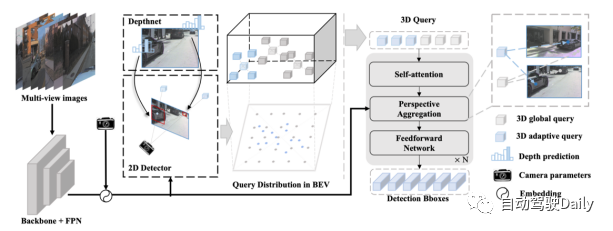

近来,从环视图像中进行三维物体检测取得了显著进展,其部署成本较低。然而,大多数研究主要集中在近距离感知范围,对远距离检测的研究较少。将现有方法直接扩展到覆盖长距离会面临计算成本高、收敛性不稳定等挑战。为了解决这些局限性,本文提出了一种新的基于稀疏查询的框架,称为 Far3D。

根据中间表征,现有的环视感知方法可以大致分为两类:基于BEV表征和基于稀疏查询表征的方法。基于BEV表征的方法由于需要计算密集的BEV特征,计算量非常大,难以扩展到远距离场景。而基于稀疏查询表征的方法会从训练数据中学习到全局的3D查询,计算量相对较小,且具有较强的扩展性。然而,它也存在一些弱点,尽管可以避免查询数量的平方增长,但全局固定查询不易适应动态场景,在远距离检测中通常会遗漏目标

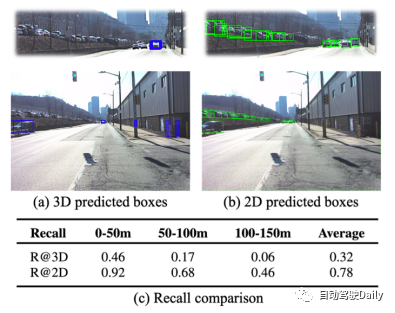

图1:Argoverse 2 数据集上,3D 检测和 2D 检测的性能对比。

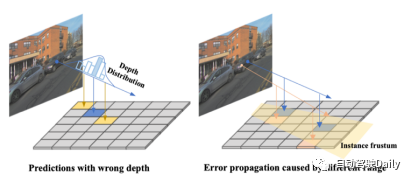

在远距离检测中,基于稀疏 query 表征的方法有两个主要挑战。

为了应对以上提到的问题,本文采取了以下设计方案:

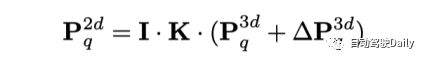

為了給遠距離偵測模型引入多尺度特徵,本文應用了3D spatial deformable attention。它先在 query 對應的 3D 位置附近進行偏移取樣,而後透過 3D-2D 視圖變換聚合影像特徵。這種方法取代 PETR 系列中的 global attention 的優點在於,計算量可以大幅降低。具體地,對於 3D 空間中的每個 query 的參考點,模型會學習其周圍的 M 個取樣偏移,並將這些偏移點投影到不同的 2D 視圖特徵中。

其後,3D query 與投影得到的取樣特徵互動。透過這種方式,來自不同視角和尺度的各種特徵將透過考慮其相對重要性而匯聚到三維查詢中。

不同距離的3D query 具有不同的回歸難度,這不同於現有的2D Denoising 方法(如DN-DETR,通常同等對待的2D query)。難度差異來自於 query 匹配密度和誤差傳播。一方面,與遠處物體相對應的 query 匹配度低於近處物體。另一方面,在 3D adaptive query 中引入二維先驗時,2D 物體框的微小誤差會被放大,更不用說這種影響會隨著物體距離的增加而增加。因此,GT 框附近的一些 query 可被視為 positive query,而其他有明顯偏差則應被視為 negative query。本文提出一種 3D Denoising 方法,旨在優化那些正樣本,並直接捨棄負樣本。

具體而言,作者透過同時添加正樣本和負樣本組來建立基於 GT 的嘈雜查詢。對於這兩種類型,都會根據物體的位置和大小應用隨機噪聲,以促進遠距離感知中的去噪學習。具體來說,正樣本是在3D框內的隨機點,而負樣本則在GT上施加更大的偏移,偏移範圍隨著物體的距離而變化。這種方法可以在訓練過程中模擬有雜訊的候選正樣本和誤報樣本

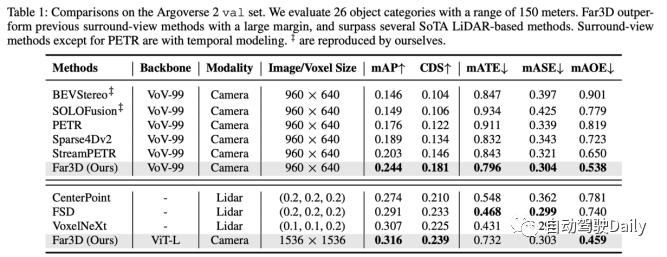

Far3D 在150m 感知範圍的Argoverse 2 上取得了最高的性能。而模型 scale up 之後,可以達到幾個 Lidar-based 方法的性能,展現了純視覺方法的潛力。

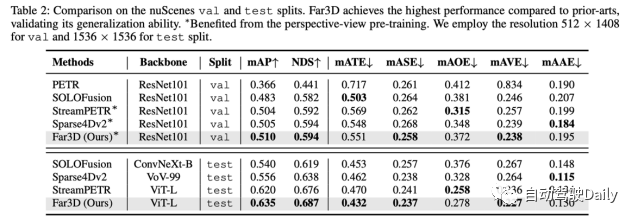

為了驗證泛化效能,作者也在 nuScenes 資料集上做了實驗,顯示在驗證集和測試集上都達到 SoTA 效能。

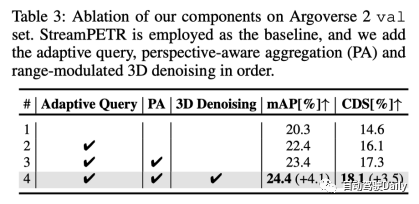

經過消融實驗,我們得出了以下結論:3D自適應查詢、透視感知聚合和範圍調節的3D降噪各自都具有一定的增益

Q:這篇文章有什麼novelty?

A:主要novelty 是解決遠距離場景的感知問題。現有方法拓展到遠距離場景有許多問題,計算成本和收斂困難等。本文作者為這個任務提出了一個高效率的架構。儘管單拎出來各個模組似曾相識,它們都是服務於遠處目標的檢測的,目標明確。

Q:比起 BevFormer v2, MV2D 有什麼差別?

A: MV2D 主要是依賴2D anchor 去取對應的特徵對3D 進行了綁定,但是沒有顯式的深度估計,所以對於遠距離物體來說不確定性就會比較大,然後難收斂; BevFormer v2 主要解決的是2D backbone與3D 任務場景之間的domain gap,一般2D 辨識任務上預訓練的backbone 察覺3D 場景的能力存在不足,並沒有探索遠距離任務中的問題。

Q: 時序上能否改進,如 query propagation 再加上 feature propagation?

A: 理論上是可行的,但是實際應用上應該考慮performance-efficiency tradeoff。

Q: 還有哪些需要改進的地方?

A: 在長尾問題和遠距離評測指標上都值得改進。在 Argoverse 2 這樣的 26 類目標上,模型在長尾類別上表現不佳,最終也會降低平均精度,這一點尚未被探索。另一方面,使用統一的指標來評估遠距離和近距離物體可能並不合適,這就強調了對實用的動態評估標準的需求,以適應現實世界的不同場景。

原文連結:https://mp.weixin.qq.com/s/xxaaYQsjuWzMI7PnSmuaWg

以上是AAAI2024:Far3D - 創新的直接幹到150m視覺3D目標偵測思路的詳細內容。更多資訊請關注PHP中文網其他相關文章!