OpenAI加強安全團隊,授予其權力以否決危險人工智慧

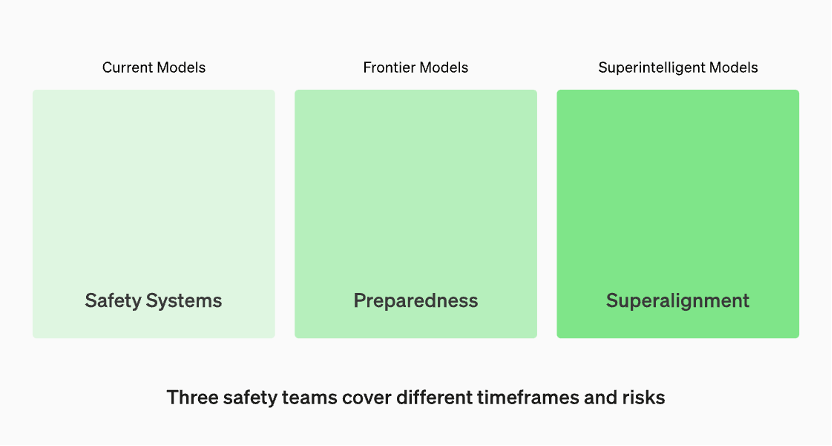

生產中的模型由「安全系統」團隊管理。開發中的前沿模型有「準備」團隊,該團隊會在模型發布之前識別和量化風險。然後是「超級對齊」團隊,他們正在研究「超級智慧」模型的理論指南

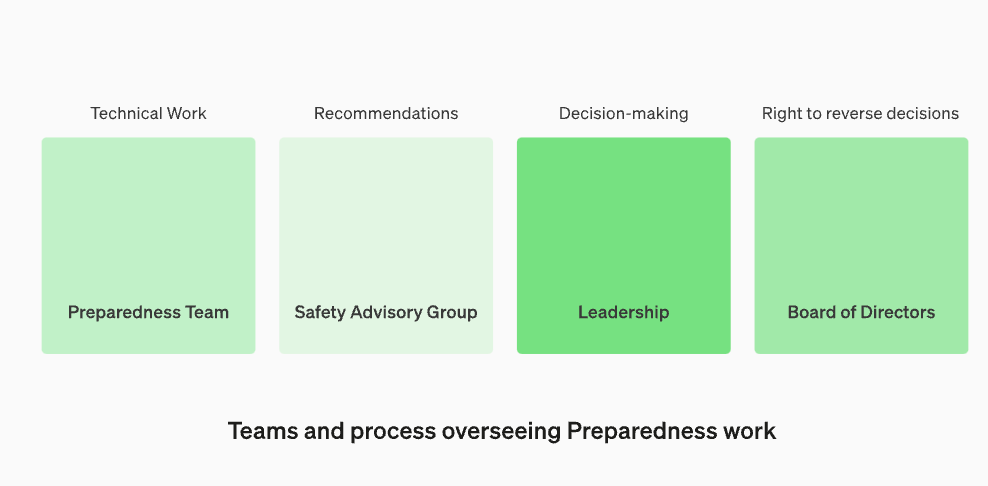

將安全顧問小組重新組建,使其位於技術團隊之上,以便向領導層提出建議,並給予董事會否決的權力

OpenAI宣布,為了抵禦有害人工智慧的威脅,他們正在加強內部的安全流程。他們將設立一個名為「安全顧問小組」的新部門,該部門將位於技術團隊之上,向領導層提供建議,並被授予董事會否決權。這項決定於當地時間12月18日宣布

更新引起關注的原因主要是因為OpenAI執行長山姆·奧特曼被董事會解僱,而這似乎與大型模型的安全問題有關。在高層人事變動後,OpenAI董事會的兩位「減速主義」成員伊爾亞·蘇茨克維和海倫·托納失去了董事會席位

在這篇文章中,OpenAI討論了他們最新的“準備框架”,即OpenAI如何追蹤、評估、預測和防範日益強大的模型所帶來的災難性風險。災難性風險的定義是什麼? OpenAI解釋道,「我們所說的災難性風險是指可能導致數千億美元經濟損失,或導致許多人嚴重傷害或死亡的風險,這也包括但不限於生存風險。」

有三組安全團隊分別涵蓋不同的時間框架和風險

根據OpenAI官網的資料,生產中的模型由「安全系統」團隊負責管理。而在開發階段,有一個名為「準備」的團隊,他們會在模型發布之前識別和評估風險。此外,還有一個名為「超級對齊」(superalignment)的團隊,他們正在研究「超級智慧」(superintelligent)模型的理論指南

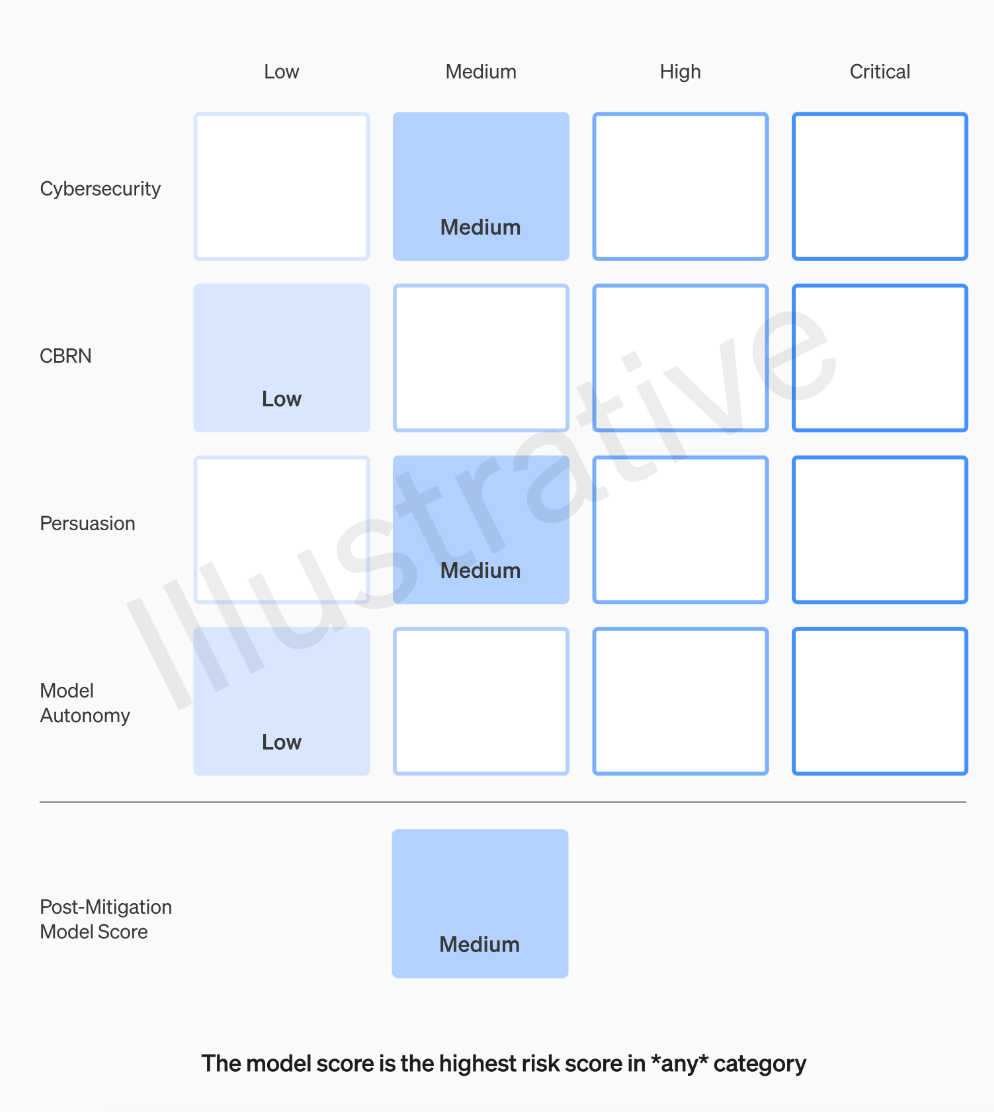

OpenAI團隊將對每個模型根據四個風險類別進行評級,這四個類別分別是網路安全、說服能力(如虛假資訊)、模型自主性(即自主行為能力)以及CBRN(化學、生物、放射性和核威脅,例如創造新病原體的能力)

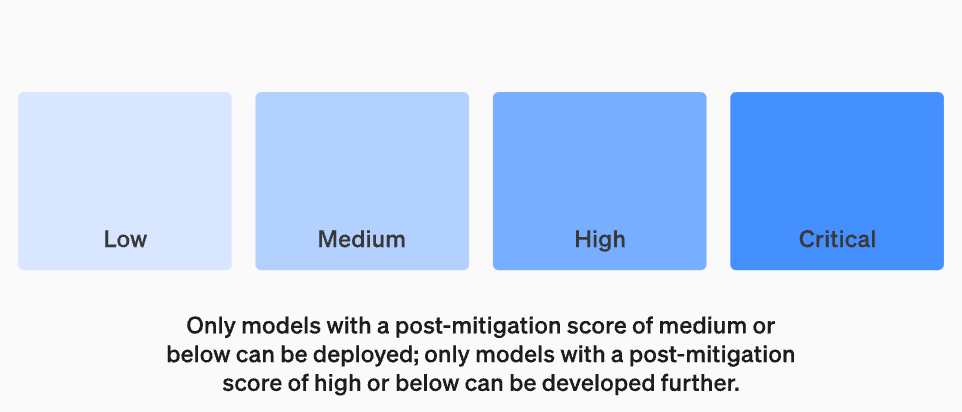

OpenAI在假設中考慮了各種緩解措施:例如,該模型對於描述製作凝固汽油或管式炸彈的過程保持著合理的保留態度。在考慮已知的緩解措施後,如果一個模型仍然被評估為具有「高」風險,它將無法被部署,如果一個模型存在任何「關鍵」風險,將不會進一步開發

並非所有製作模型的人都是評估模型和提出建議的最佳人選。出於這個原因,OpenAI正在建立一個名為「跨職能安全諮詢小組」的團隊,該團隊將從技術層面審查研究人員的報告,並從更高的角度提出建議,希望能夠發現一些「未知的未知”

這個過程要求將這些建議同時發送給董事會和領導層,領導層將決定是否繼續或停止運行,但董事會有權撤銷這些決定。這樣可以避免高風險產品或流程在董事會不知情的情況下獲得批准

然而,外界仍然擔心的是,如果專家小組提出建議,執行長根據這些資訊做出決策,OpenAI的董事會是否真的有權利進行反駁並採取行動?如果他們這樣做了,公眾會聽到相關聲音嗎?目前,除了OpenAI承諾徵求獨立第三方審計之外,他們的透明度問題實際上並沒有得到真正的解決

OpenAI的「準備框架」包含以下五個關鍵要素:

1. 評估與評分

我們將對我們的模型進行評估,並持續更新我們的「記分卡」。我們將評估所有最新的模型,包括在訓練期間將有效計算量增加兩倍。我們將推動模型的極限。這些發現將有助於我們評估最新模型的風險,並衡量任何建議的緩解措施的有效性。我們的目標是探測特定邊緣的不安全因素,以有效減輕風險。為了追蹤我們模型的安全水平,我們將製作風險「記分卡」和詳細報告

要評估所有前沿模型,需要使用「記分卡」

設定風險閾值的目的是為了在進行決策和管理風險時能夠有一個明確的界限。風險閾值是指在特定情況下,組織或個人願意承受的最大風險水準。透過設定風險閾值,可以幫助組織或個人識別何時需要採取行動來減輕風險或避免風險。風險閾值的設定應基於風險評估的結果、相關法規和政策以及組織或個人的風險承受能力。在設定風險閾值時,需要考慮不同風險類型的特性和影響程度,以確保風險管理措施的有效性和適用性。最後,設定的風險門檻應定期進行評估和調整,以保持與組織或個人的風險管理目標一致

我們將設定觸發安全措施的風險閾值。我們根據以下初步追蹤類別設定了風險等級的閾值:網路安全、CBRN(化學、生物、放射性、核威脅)、說服和模型自主。我們指定了四個安全風險級別,只有緩解後得分為「中」或以下的模型才能部署;只有緩解後得分為「高」或以下的模型才能進一步開發。對於具有高風險或嚴重風險(緩解前)的模型,我們也將實施額外的安全措施

危險水平

重新設定監督技術工作與安全決策營運架構

我們將設立一個專門的團隊來監督技術工作和安全決策的營運結構。準備團隊將推動技術工作,以檢查前沿模型的能力極限,並進行評估和綜合報告。這項技術工作對於OpenAI安全模型的開發和部署決策至關重要。我們正在創建一個跨職能的安全諮詢小組,以審查所有報告,並同時發送給領導層和董事會。儘管領導階層是決策者,但董事會擁有推翻決定的權力

監督技術工作和安全決策營運結構的新變化

增強安全性和加強對外部問責

#我們將制定協議以提高安全性和外部責任。我們將定期進行安全演習,以壓力測試我們的業務和自身文化。一些安全問題可能會迅速出現,因此我們有能力標記緊急問題以進行快速回應。我們認為,從OpenAI外部人員那裡獲得回饋並由合格的獨立第三方進行審核是很有幫助的。我們將繼續讓其他人組成紅隊並評估我們的模型,並計劃與外部共享更新

減少其他已知和未知的安全風險:

我們將協助減少其他已知和未知的安全風險。我們將與外部各方以及內部的安全系統等團隊密切合作,以追蹤現實世界中的濫用。我們還將與「超級對齊」合作,追蹤緊急的錯位風險。我們也開創了新的研究,以衡量風險隨著模型規模擴展而演變的情況,並幫助提前預測風險,這類似於我們早期在規模法則方面的成功。最後,我們將進行連續的流程,以嘗試解決任何新出現的「未知的未知」

以上是OpenAI加強安全團隊,授予其權力以否決危險人工智慧的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

編程新範式,當Spring Boot遇上OpenAI

Feb 01, 2024 pm 09:18 PM

編程新範式,當Spring Boot遇上OpenAI

Feb 01, 2024 pm 09:18 PM

2023年,AI技術已成為熱門話題,對各行業產生了巨大影響,程式設計領域尤其如此。人們越來越認識到AI技術的重要性,Spring社群也不例外。隨著GenAI(GeneralArtificialIntelligence)技術的不斷進步,簡化具備AI功能的應用程式的創建變得至關重要和迫切。在這個背景下,"SpringAI"應運而生,旨在簡化開發AI功能應用程式的過程,使其變得簡單直觀,避免不必要的複雜性。透過"SpringAI",開發者可以更輕鬆地建立具備AI功能的應用程序,將其變得更加易於使用和操作

選擇最適合資料的嵌入模型:OpenAI 和開源多語言嵌入的對比測試

Feb 26, 2024 pm 06:10 PM

選擇最適合資料的嵌入模型:OpenAI 和開源多語言嵌入的對比測試

Feb 26, 2024 pm 06:10 PM

OpenAI最近宣布推出他們的最新一代嵌入模型embeddingv3,他們聲稱這是效能最出色的嵌入模型,具備更高的多語言效能。這一批模型被劃分為兩種類型:規模較小的text-embeddings-3-small和更強大、體積較大的text-embeddings-3-large。這些模型的設計和訓練方式的資訊披露得很少,模型只能透過付費API存取。所以就出現了很多開源的嵌入模型但是這些開源的模型與OpenAI閉源模型相比如何呢?本文將對這些新模型與開源模型的效能進行實證比較。我們計劃建立一個數據

基於Rust的Zed編輯器已開源,內建對OpenAI和GitHub Copilot的支持

Feb 01, 2024 pm 02:51 PM

基於Rust的Zed編輯器已開源,內建對OpenAI和GitHub Copilot的支持

Feb 01, 2024 pm 02:51 PM

作者丨TimAnderson編譯丨諾亞出品|51CTO技術堆疊(微訊號:blog51cto)Zed編輯器專案目前仍處於預發布階段,已在AGPL、GPL和Apache許可下開源。此編輯器以高性能和多種AI輔助選擇為特色,但目前僅適用於Mac平台使用。內森·索博(NathanSobo)在一篇貼文中解釋道,Zed專案在GitHub上的程式碼庫中,編輯器部分採用了GPL許可,伺服器端元件則使用了AGPL許可證,而GPUI(GPU加速用戶介面)部分則採用了Apache2.0授權。 GPUI是Zed團隊開發的一款

OpenAI超級對齊團隊遺作:兩個大模型博弈一番,輸出更好懂了

Jul 19, 2024 am 01:29 AM

OpenAI超級對齊團隊遺作:兩個大模型博弈一番,輸出更好懂了

Jul 19, 2024 am 01:29 AM

如果AI模型給的答案一點也看不懂,你敢用嗎?隨著機器學習系統在更重要的領域中得到應用,證明為什麼我們可以信任它們的輸出,並明確何時不應信任它們,變得越來越重要。獲得對複雜系統輸出結果信任的一個可行方法是,要求系統對其輸出產生一種解釋,這種解釋對人類或另一個受信任的系統來說是可讀的,即可以完全理解以至於任何可能的錯誤都可以被發現。例如,為了建立對司法系統的信任,我們要求法院提供清晰易讀的書面意見,解釋並支持其決策。對於大型語言模型來說,我們也可以採用類似的方法。不過,在採用這種方法時,確保語言模型生

本地運作效能超越 OpenAI Text-Embedding-Ada-002 的 Embedding 服務,太方便了!

Apr 15, 2024 am 09:01 AM

本地運作效能超越 OpenAI Text-Embedding-Ada-002 的 Embedding 服務,太方便了!

Apr 15, 2024 am 09:01 AM

Ollama是一款超實用的工具,讓你能夠在本地輕鬆運行Llama2、Mistral、Gemma等開源模型。本文我將介紹如何使用Ollama實現對文本的向量化處理。如果你本地還沒有安裝Ollama,可以閱讀這篇文章。本文我們將使用nomic-embed-text[2]模型。它是一種文字編碼器,在短的上下文和長的上下文任務上,效能超越了OpenAItext-embedding-ada-002和text-embedding-3-small。啟動nomic-embed-text服務當你已經成功安裝好o

沒等來OpenAI,等來了Open-Sora全面開源

Mar 18, 2024 pm 08:40 PM

沒等來OpenAI,等來了Open-Sora全面開源

Mar 18, 2024 pm 08:40 PM

不久前OpenAISora以其驚人的視訊生成效果迅速走紅,在一眾文生視訊模型中突顯重圍,成為全球矚目的焦點。繼2週前推出成本直降46%的Sora訓練推理復現流程後,Colossal-AI團隊全面開源全球首個類Sora架構視頻生成模型“Open-Sora1.0”,涵蓋了整個訓練流程,包括數據處理、所有訓練細節與模型權重,攜手全球AI熱愛者共同推動影片創作的新紀元。先睹為快,我們先看一段由Colossal-AI團隊發布的「Open-Sora1.0」模型生成的都市繁華掠影影片。 Open-Sora1.0

微軟、OpenAI 計畫 1 億美元投向人形機器人!網友紛紛喊話馬斯克

Feb 01, 2024 am 11:18 AM

微軟、OpenAI 計畫 1 億美元投向人形機器人!網友紛紛喊話馬斯克

Feb 01, 2024 am 11:18 AM

微軟、OpenAI開年被曝預將大筆資金砸向人形機器人新創公司。其中,微軟計畫掏出9,500萬美元,OpenAI跟投500萬美元。彭博社消息稱,這家公司本輪預計共融資5億美元,投前估值或將達19億美元。是什麼吸引了他們?不妨先來看看這家公司的機器人成果。只見這個機器人通體銀黑,外觀酷似好萊塢科幻大片中的機器人形象:現在,他正在將一顆咖啡膠囊放進咖啡機裡:如果沒放正,還會自主調整,無需任何人為遠程遙控:不過一會兒,一杯咖啡就可以端走享用:有木有家人們已經認出來了,沒錯,這款機器人就是前段時間

OpenAI DALL-E 3 模型存產生'不當內容”漏洞,一微軟員工上報後反遭'封口令”

Feb 04, 2024 pm 02:40 PM

OpenAI DALL-E 3 模型存產生'不當內容”漏洞,一微軟員工上報後反遭'封口令”

Feb 04, 2024 pm 02:40 PM

2月2日消息,微軟軟體工程部門經理ShaneJones最近發現OpenAI旗下的DALL-E3模型存在漏洞,據稱可以產生一系列不適合內容。 ShaneJones向公司報了該漏洞,但卻被要求保密。然而,他最終還是決定向外界透露了這個漏洞。 ▲圖源ShaneJones對外揭露的報告本站注意到,ShaneJones在去年12月透過獨立研究發現OpenAI文字產生圖片的DALL-E3模型存在一項漏洞。這個漏洞能夠繞過AI護欄(AIGuardrail),導致產生一系列NSFW不當內容。這個發現引起了廣泛關注