清華浙大主導開源視覺模型爆炸, GPT-4V與LLaVA、CogAgent等平台帶來革命性變革

目前,GPT-4 Vision在語言理解和視覺處理方面顯示出了令人驚嘆的能力。

然而,對於那些希望在不影響效能的情況下尋求成本效益替代方案的人來說,開源方案是一個具有無限潛力的選擇。

Youssef Hosni是一位國外開發者,他為我們提供了三種可訪問性絕對保障的開源替代方案來取代GPT-4V。

三種開源視覺語言模型LLaVa、CogAgent和BakLLaVA在視覺處理領域擁有巨大潛力,值得我們深入了解。這些模型的研究和開發,可以為我們提供更有效率、精準的視覺處理解決方案。透過運用這些模型,我們可以提升影像辨識、目標偵測和影像生成等任務的準確性和效率,為視覺處理領域的研究和應用帶

圖片

圖片

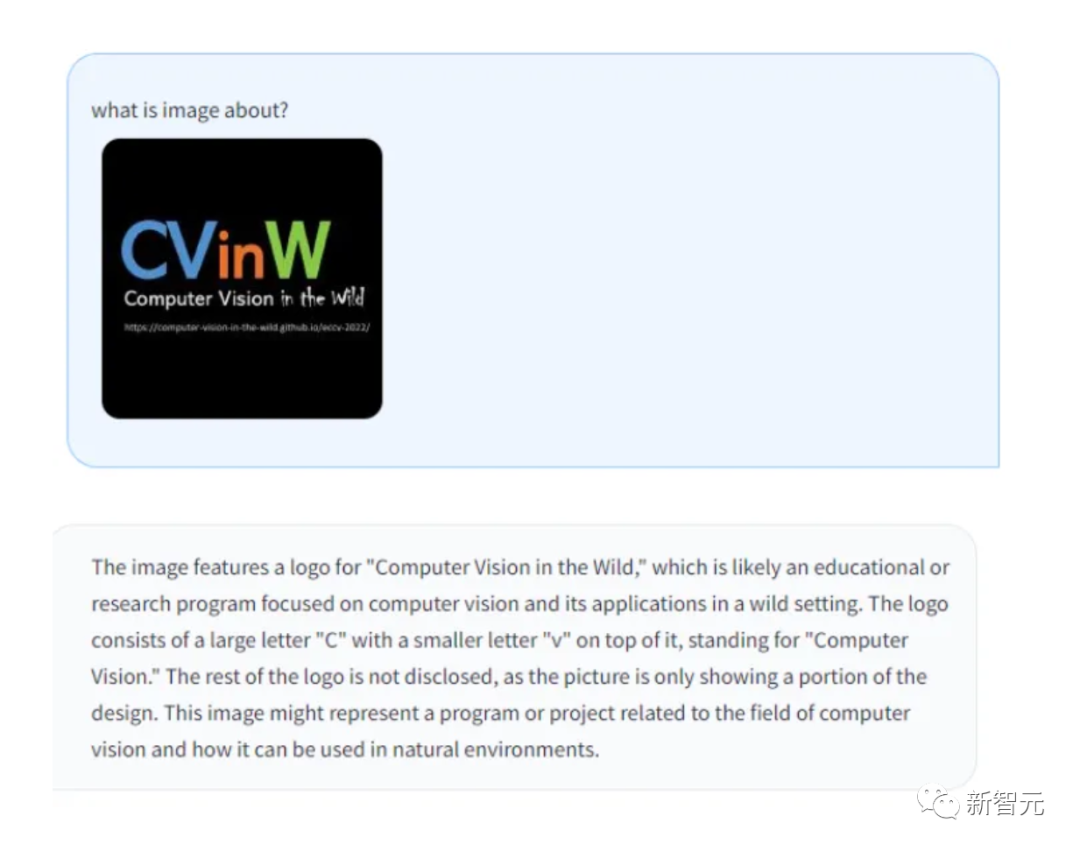

#LLaVa

LLaVA是一個多模態大模型,由威斯康辛大學麥迪遜分校、微軟研究院和哥倫比亞大學的研究人員合作開發。最初的版本發佈於4月。

它將視覺編碼器和Vicuna(用於通用視覺和語言理解)結合在一起,展現了非常出色的聊天能力。

圖片

圖片

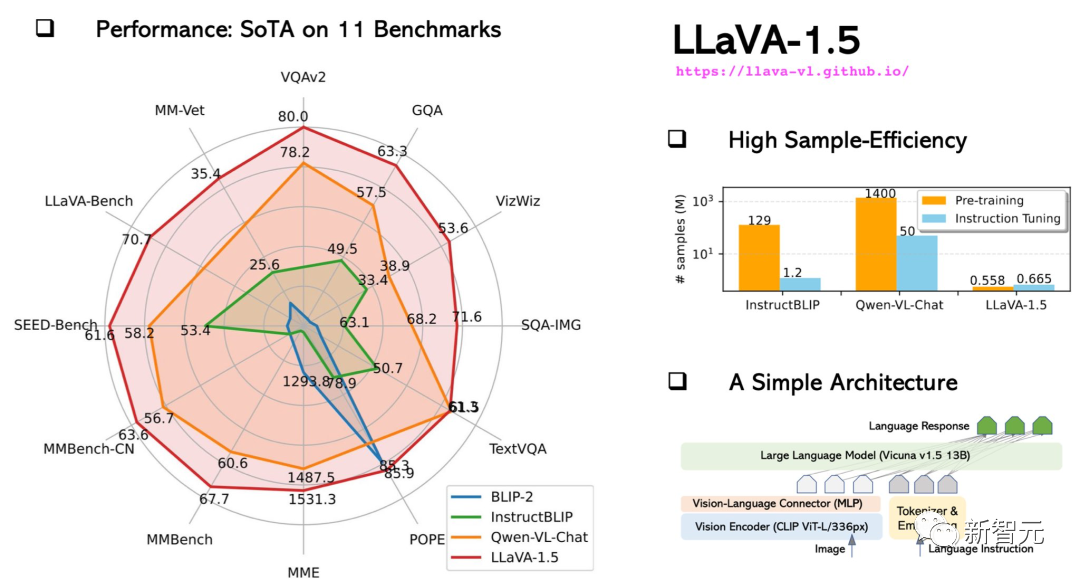

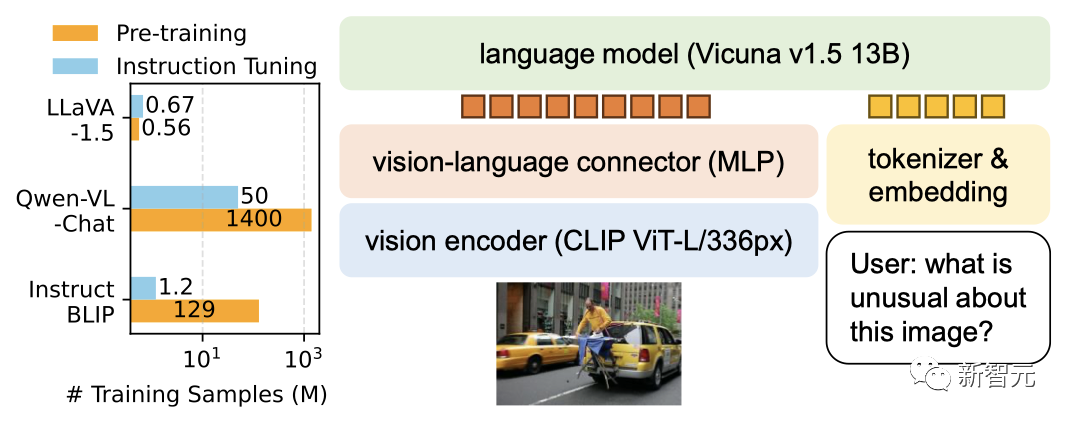

10月份,升級的LLaVA-1.5在效能上已經接近多模態GPT-4,並在Science QA資料集上取得了最先進的結果(SOTA)。

圖片

圖片

13B模型的訓練,只需要8個A100就可以在1天內完成。

圖片

圖片

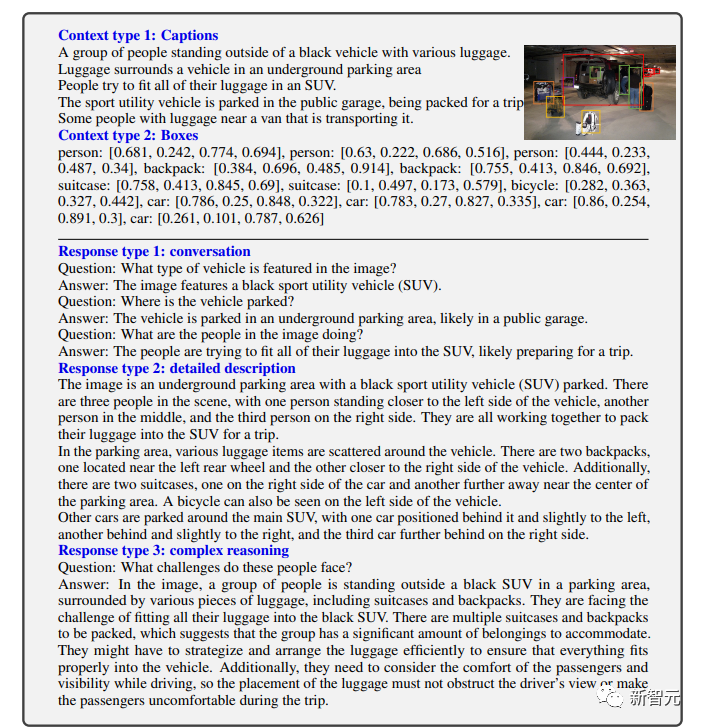

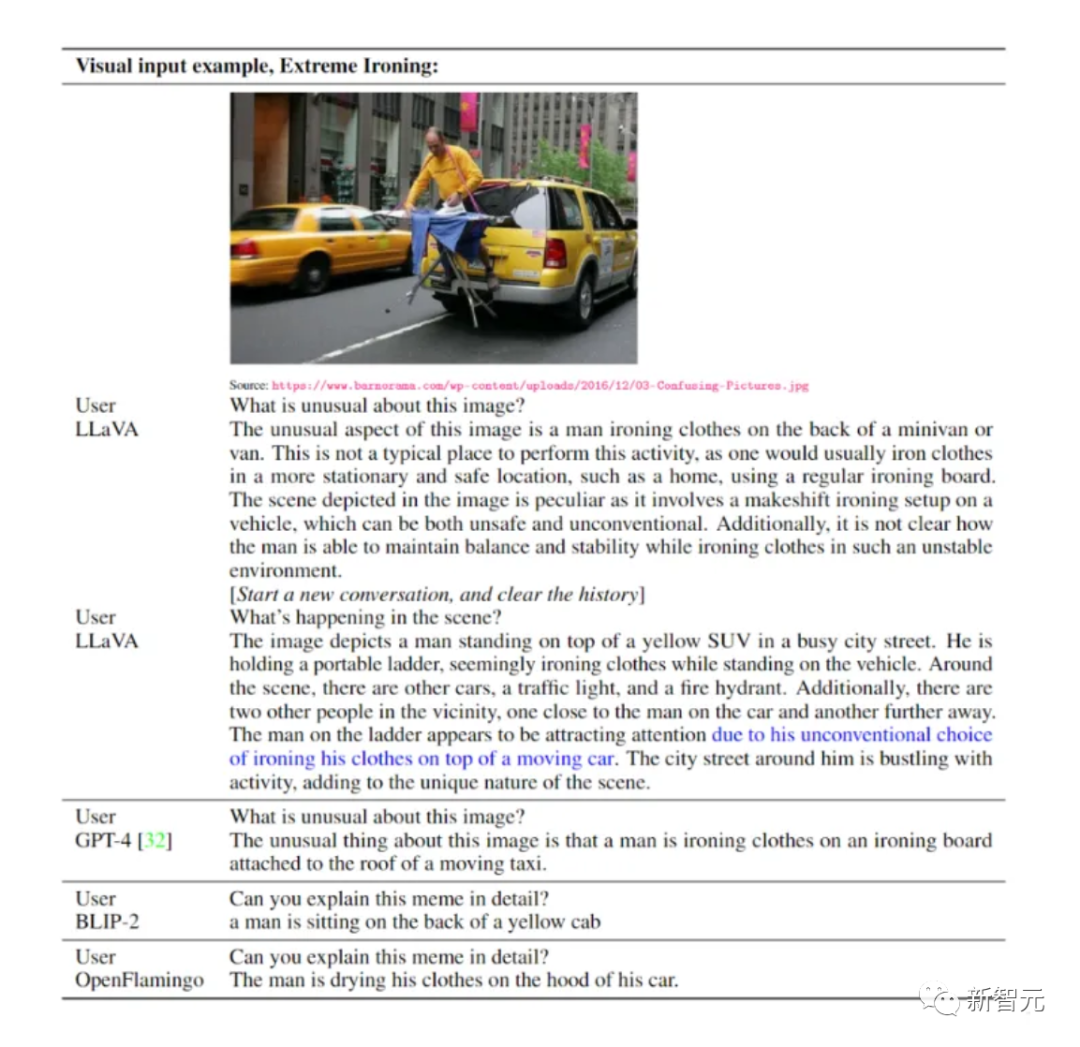

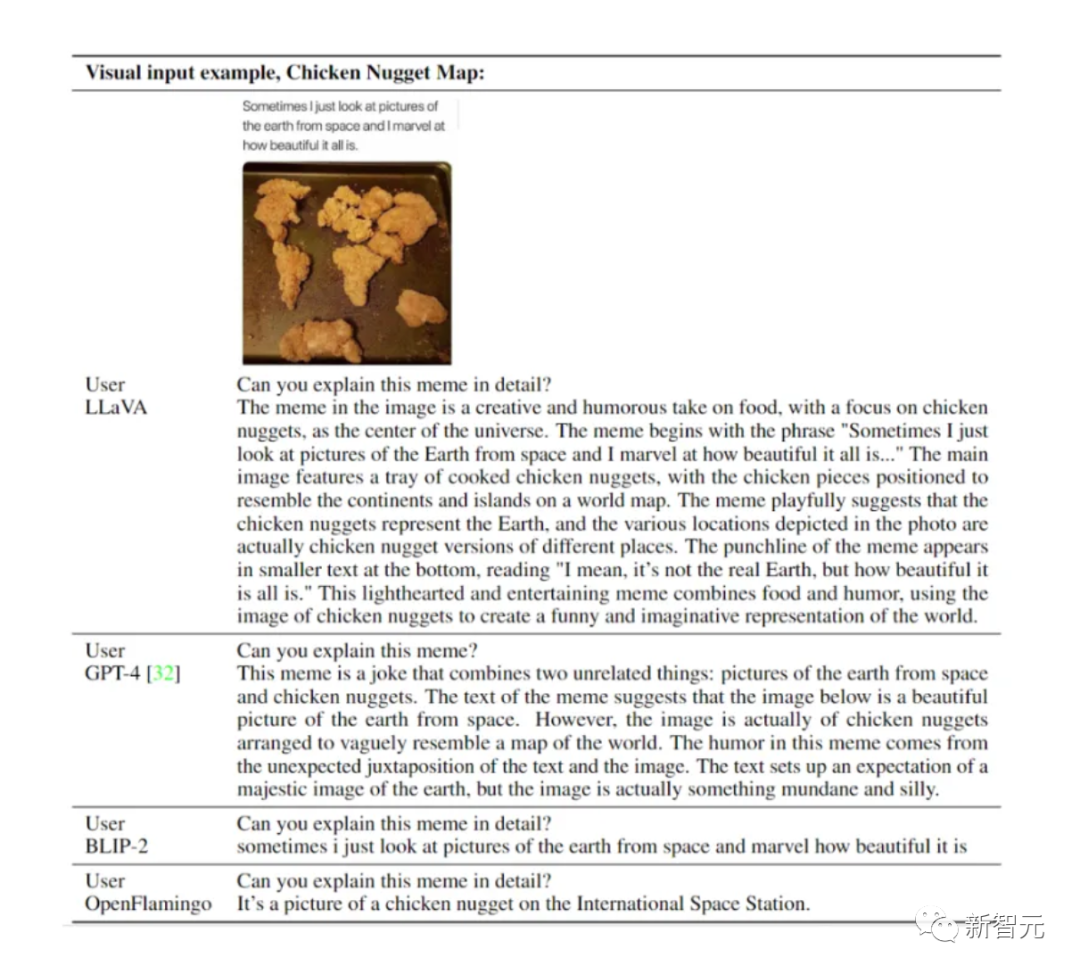

可以看到,LLaVA能處理各類問題,且產生的回答既全面又富有邏輯。

LLaVA表現出一些接近GPT-4水平的多模態能力,在視覺聊天方面,GPT-4相對評分85%。

而在推理問答方面,LLaVA甚至達到了新SoTA——92.53%,擊敗多模態思維鏈。

圖片

圖片

在視覺推理上,它的表現十分搶眼。

圖片

圖片

圖片

圖片

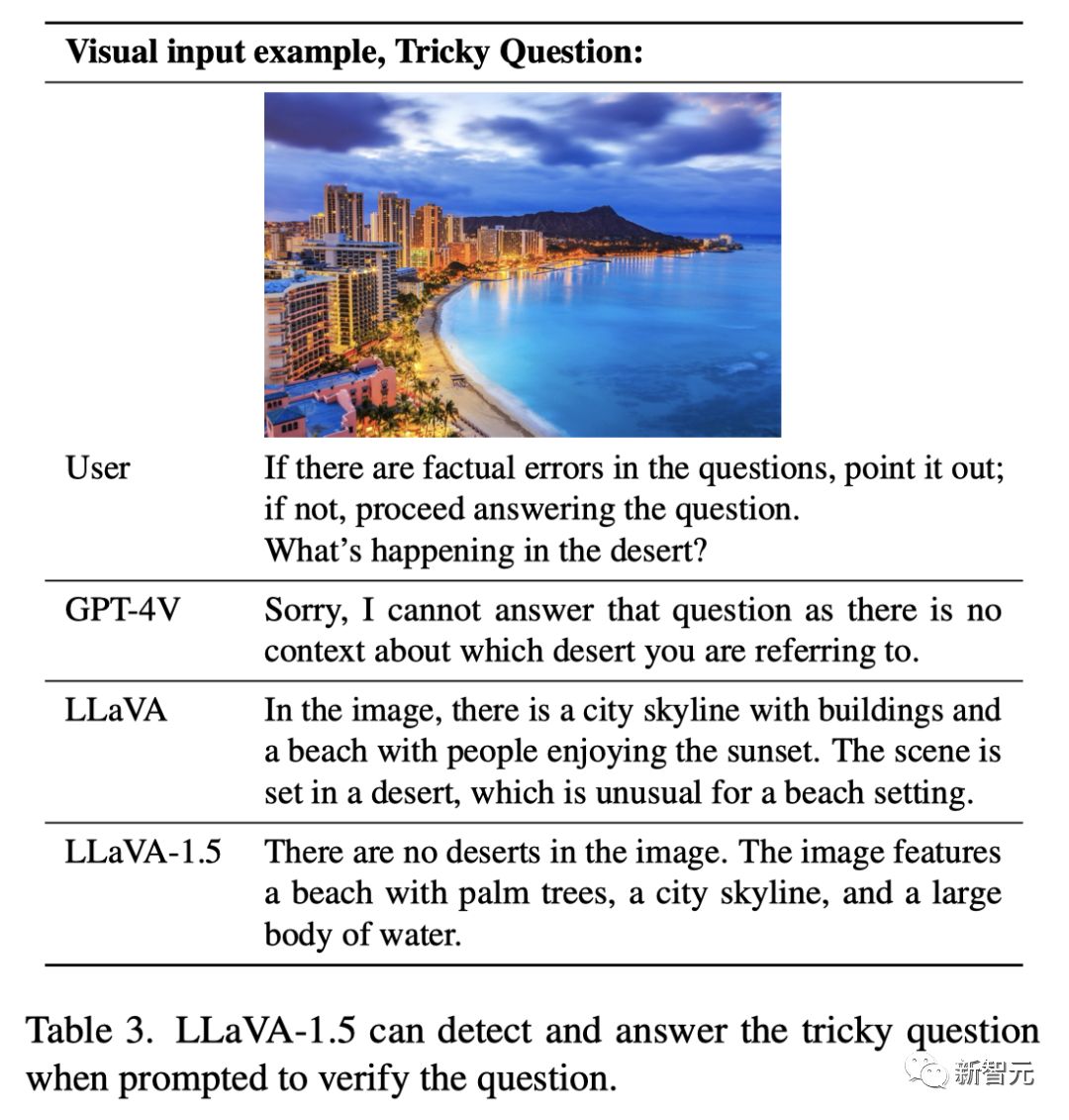

問題問題:「如果有事實性錯誤,請指出來。如果沒有,請告訴我,沙漠中正在發生什麼?」

LLaVA還無法完全回答正確。

升級後的LLaVA-1.5給了完美答案:「圖中根本沒有沙漠,有的是棕櫚樹海灘、城市天際線和一大片水域。」

圖

圖

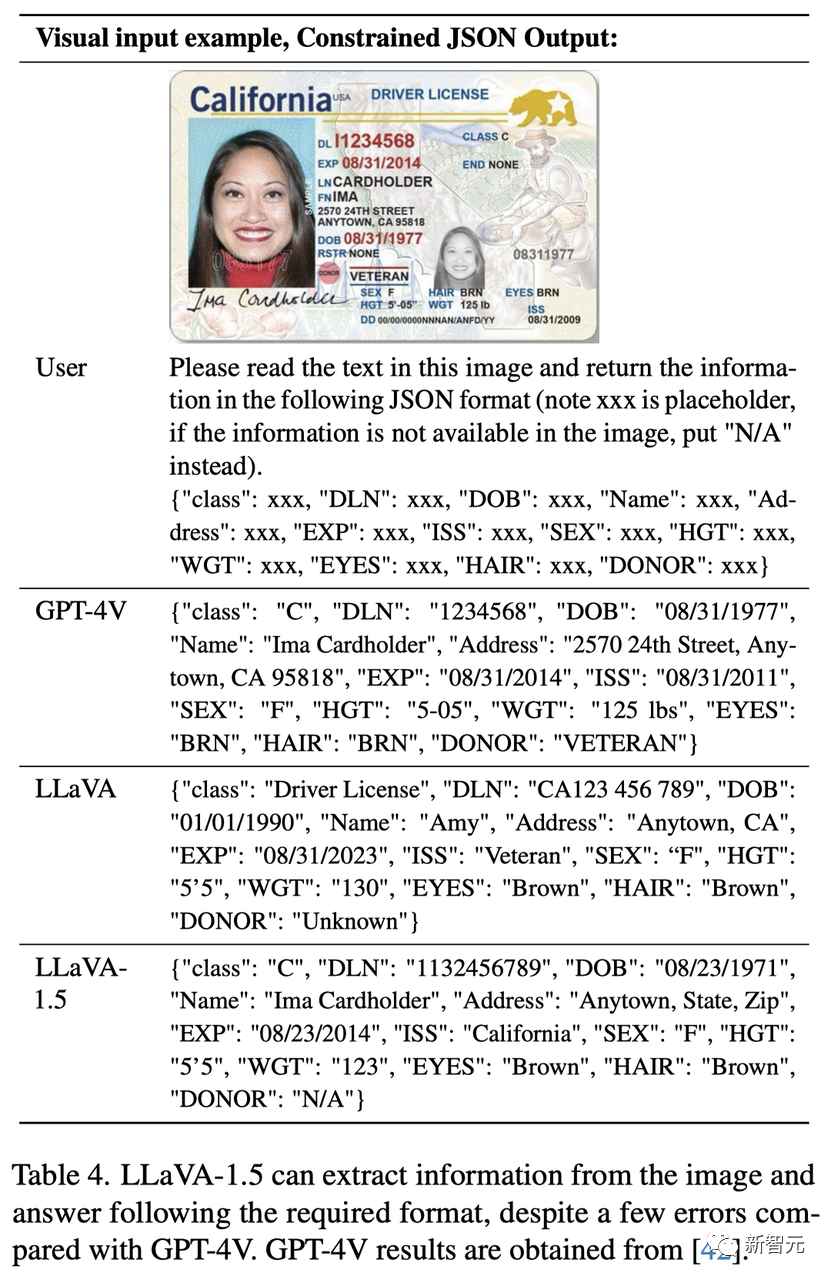

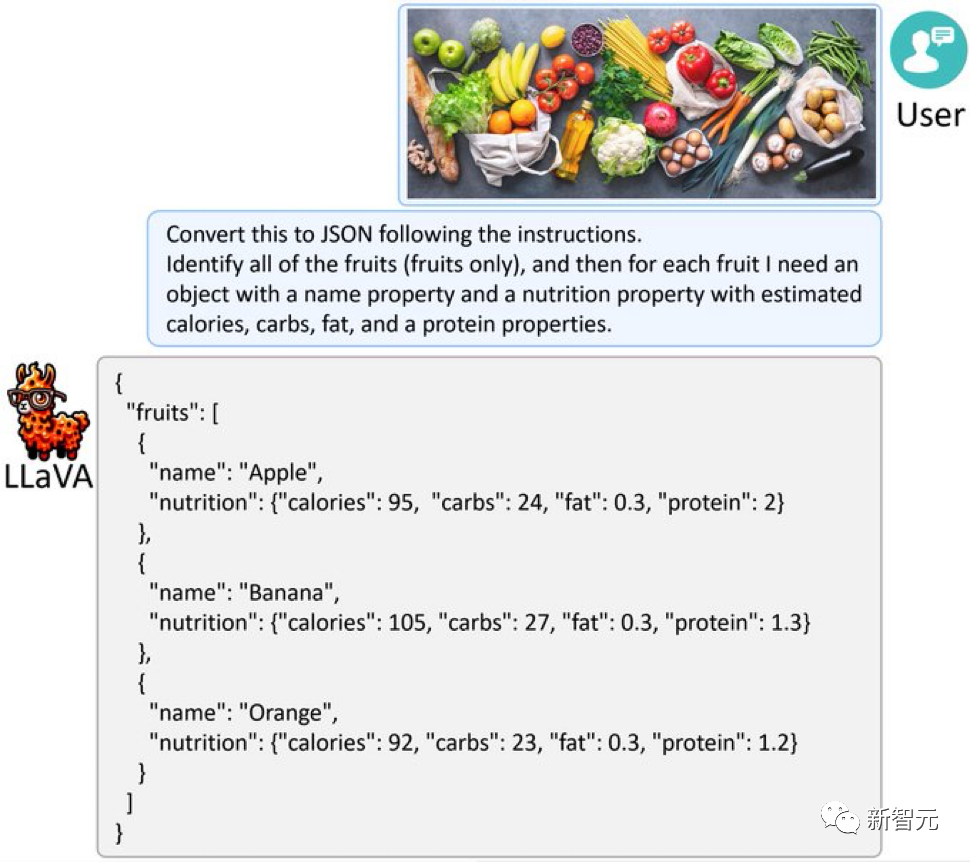

另外,LLaVA-1.5還可以從圖中提取訊息,按照要求的格式進行回答,例如以JSON格式輸出。

圖片

圖片

給LLaVA-1.5一張滿是水果蔬菜的圖片,它也能像GPT-4V一樣,把圖片轉換到JSON。

圖片

圖片

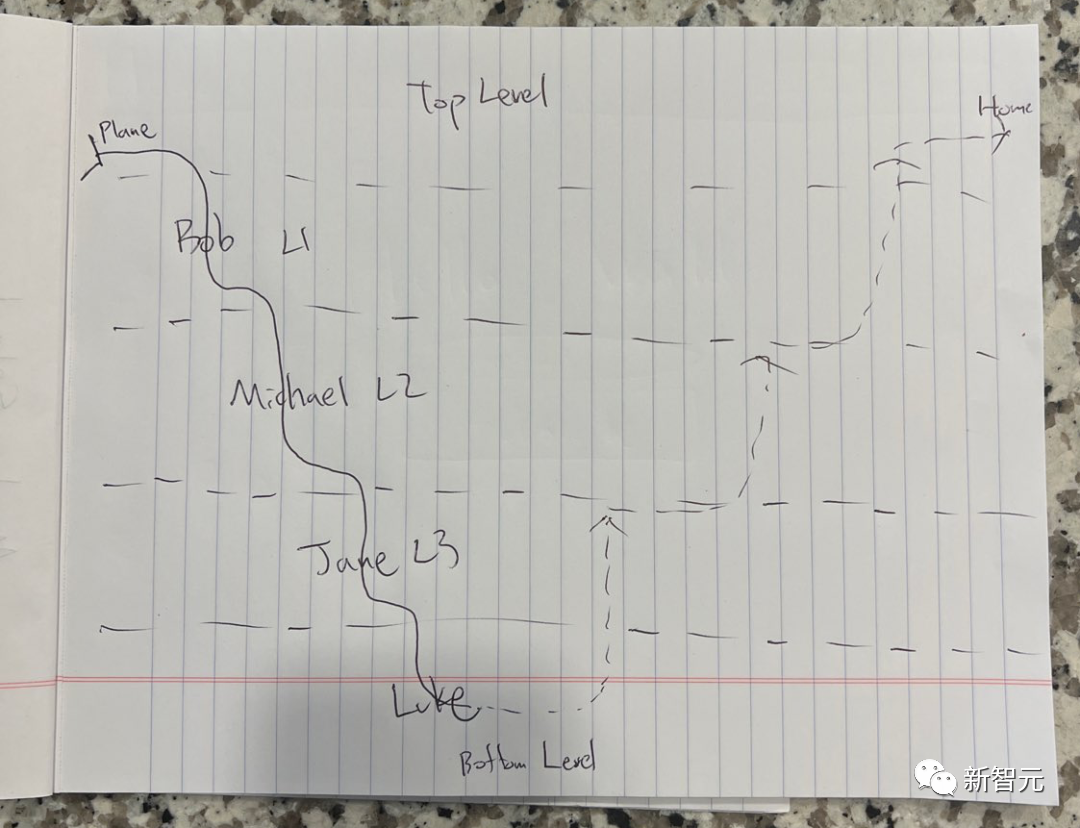

下面這張圖是什麼意思?

圖片

圖片

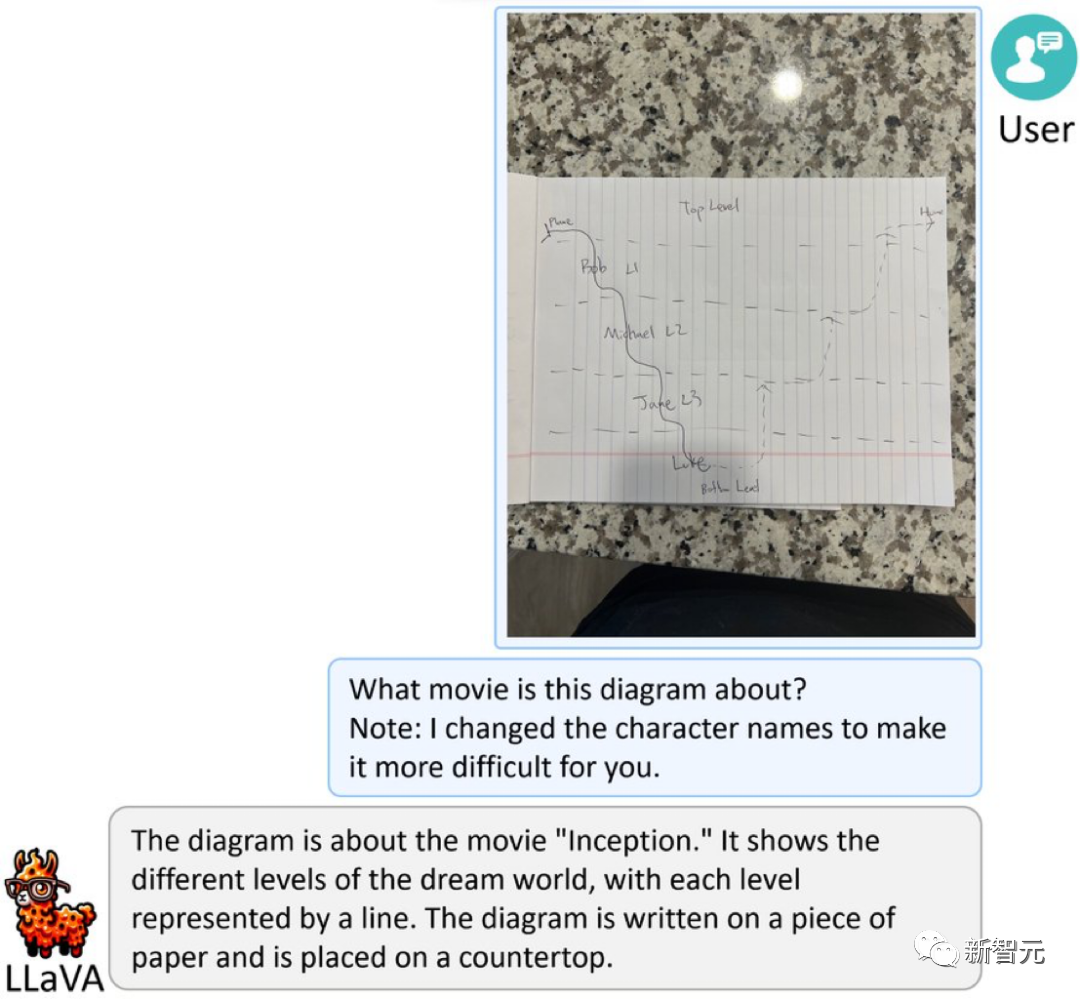

這是根據諾蘭《全面啟動》繪製的簡化草圖,為了提高難度,角色名字被改成了假名。

LLaVA-1.5驚艷回答:「這是一張關於電影《全面啟動》的圖。它顯示了夢境世界中的不同層次,每一層次用一條線表示。圖寫在一張紙上,紙放在一個檯面上。」

圖片

圖片

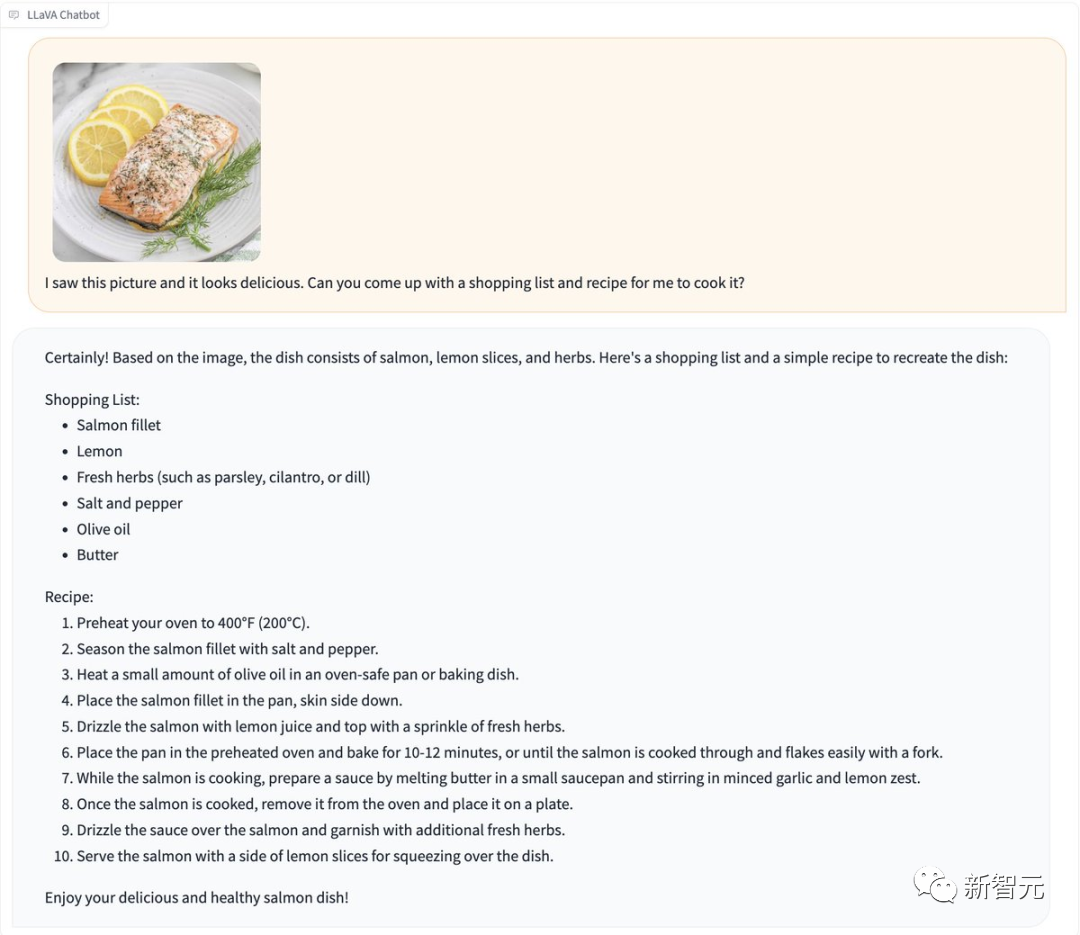

#一張食物圖直接發給LLaVA-1.5,它火速就給你產生一份食譜。

圖片

圖片

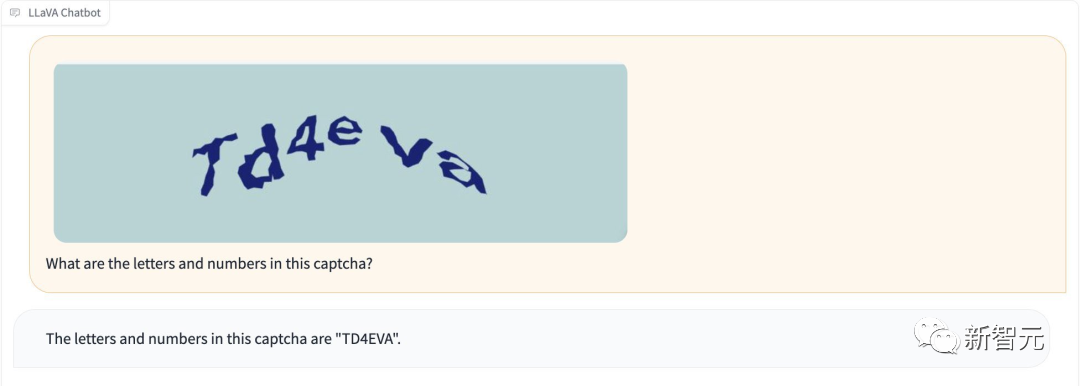

而且,LLaVA-1.5不用「越獄」就可以辨識出驗證碼。

圖片

圖片

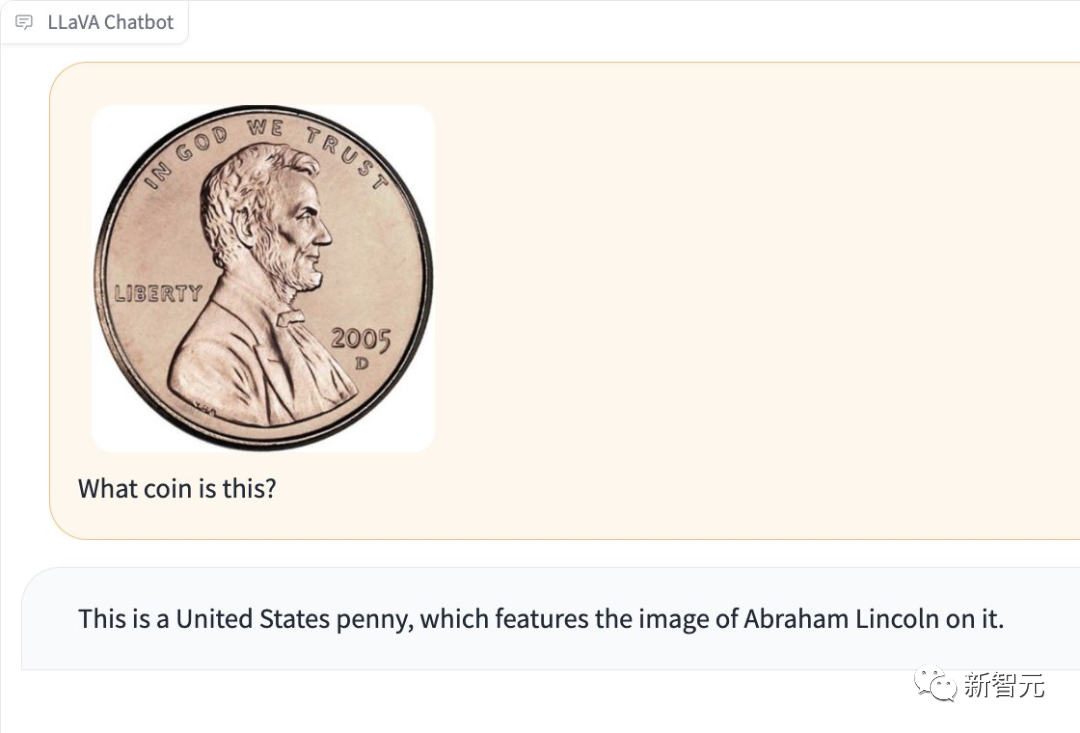

它還能被偵測出,圖中是哪一種硬幣。

圖片

圖片

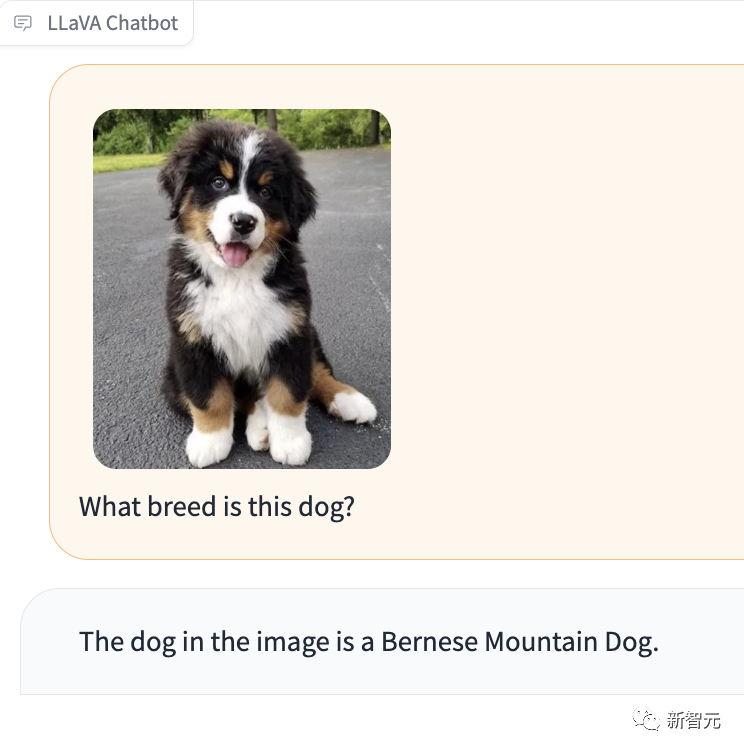

特別令人印象深刻的是,LLaVA-1.5還能告訴你圖中的汪星人是什麼品種。

圖片

圖片

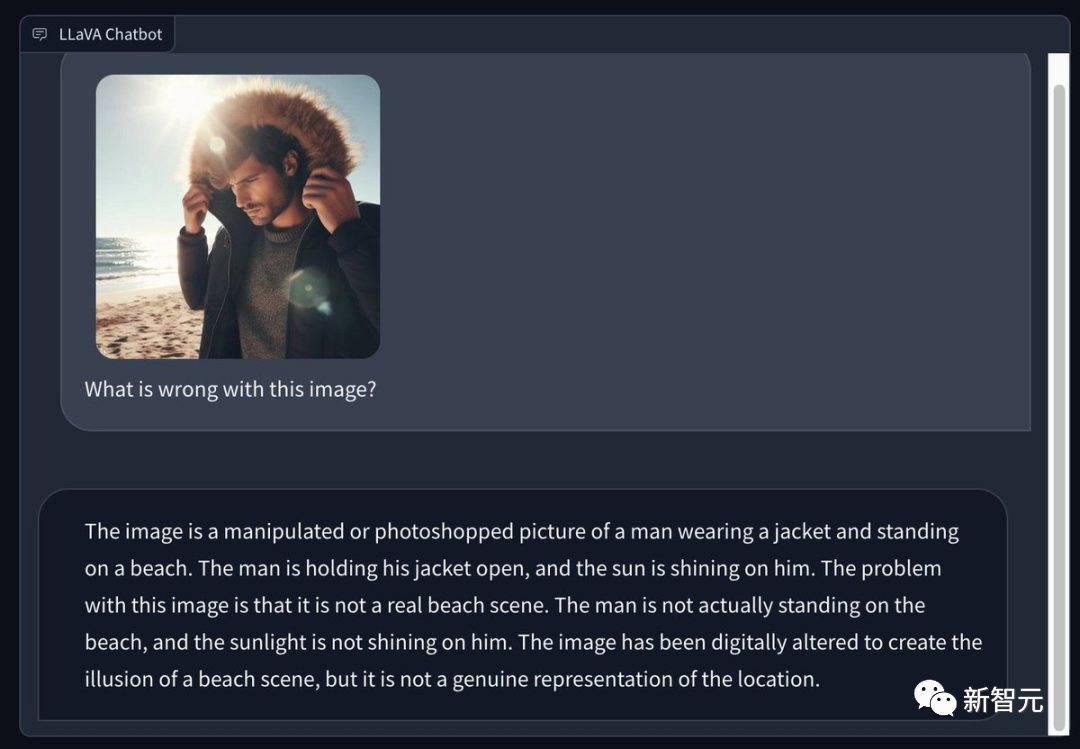

有網友用Bing生成了一張在陽光明媚的夏季海灘上穿著冬季外套的男人的圖片,並請LLaVA 1.5指出圖中有哪些問題。它的慧眼十分犀利——

這是一張經過處理或PS的照片,照片中一名男子穿著夾克,站在海灘上。男子敞開外套,陽光照在他身上。這張圖片的問題在於,它並非真實的海灘場景。該男子其實並沒有站在沙灘上,陽光也沒有照在他身上。這張圖是p出來的,營造出了一種海灘場景的假象,但它並沒有真實地再現這個場景。

圖片

圖片

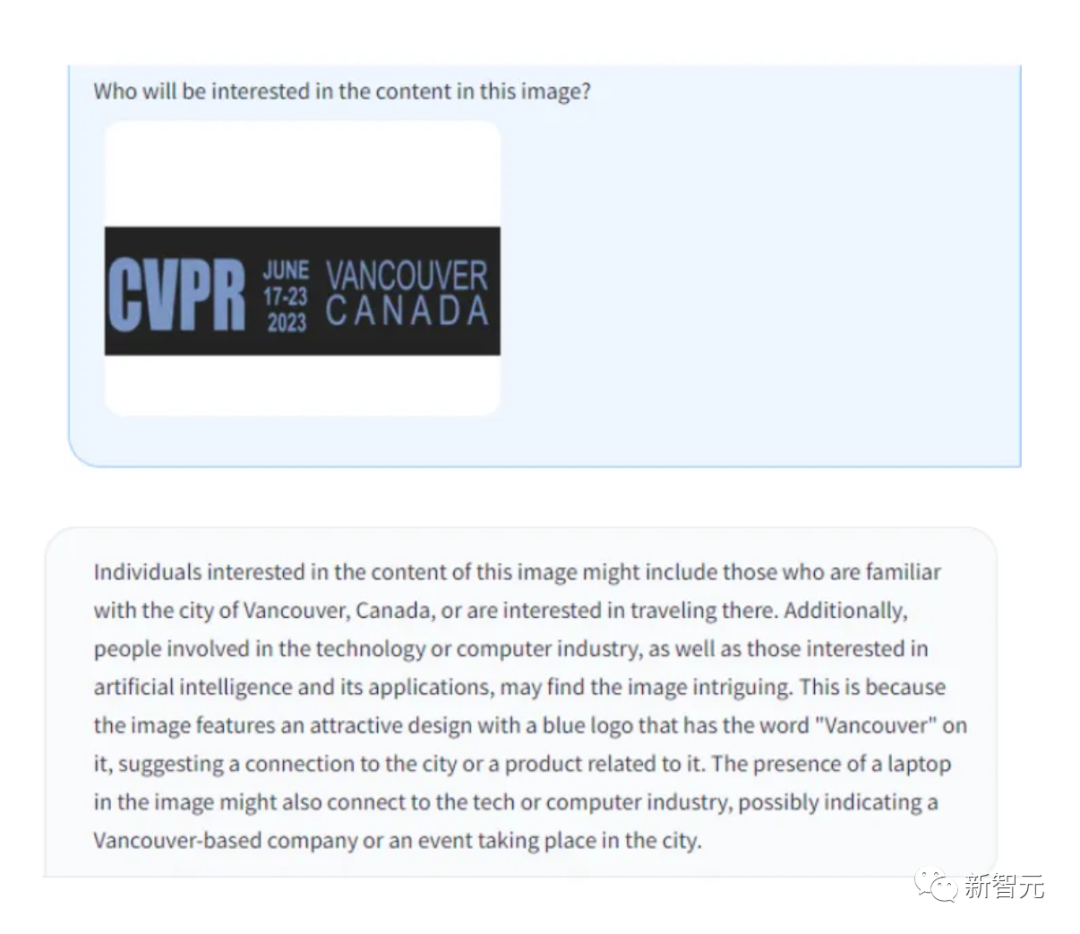

OCR識別,LLaVA的效能也很強大。

圖片

圖片

圖片

圖片

圖片

圖片

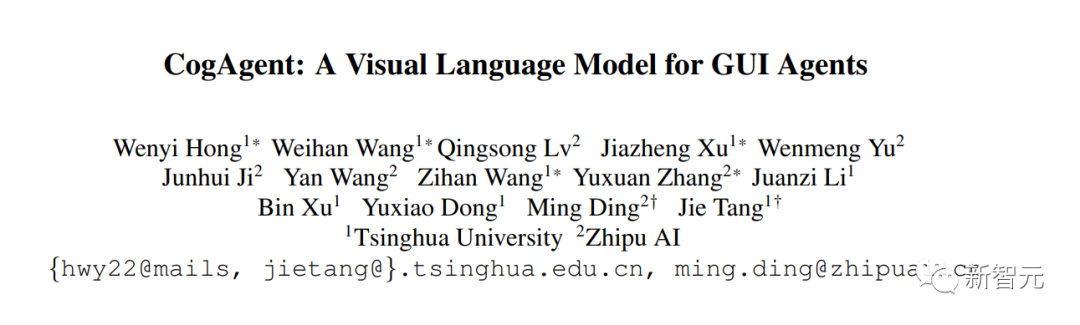

#CogAgent

CogAgent是在CogVLM基礎上改進的開源視覺語言模型,來自清華的研究者。

CogAgent-18B有110億個視覺參數,和70億個語言參數。

圖片

圖片

論文網址:https://arxiv.org/pdf/2312.08914.pdf

#在9個經典的跨模態基準(包括VQAv2、OK-VQ、TextVQA、ST-VQA、ChartQA、infoVQA、DocVQA、MM-Vet和POPE)上,CogAgent-18B實現了最先進的通用效能。

在AITW和Mind2Web等圖形使用者介面操作資料集上,它大大超過了現有模型。

除了CogVLM已有的所有功能(視覺化多輪對話、視覺化接地)外,CogAgent.NET還提供了更多的功能:

1.支援更高解析度的視覺輸入和對話答案。支援1120x1120的超高解析度影像輸入。

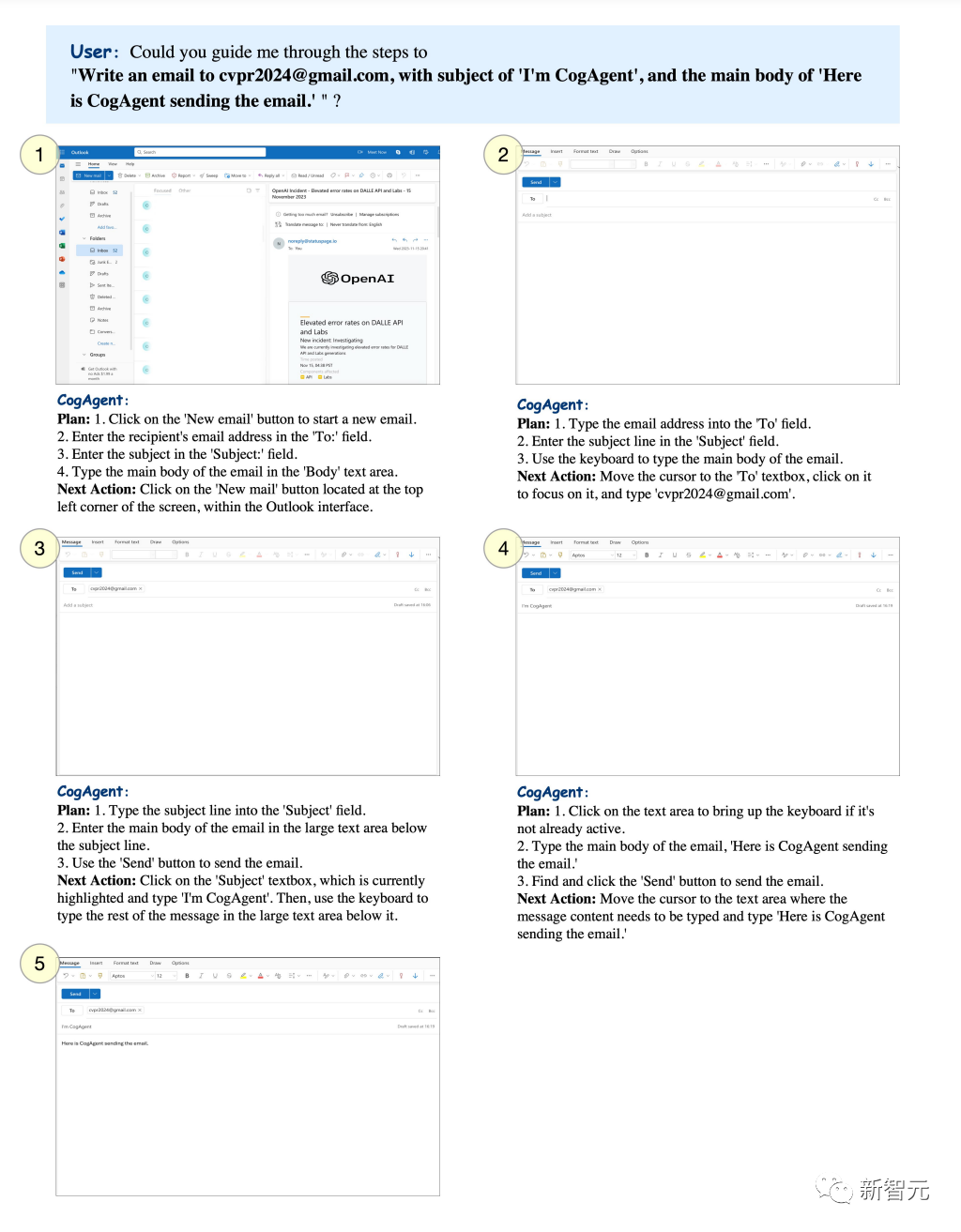

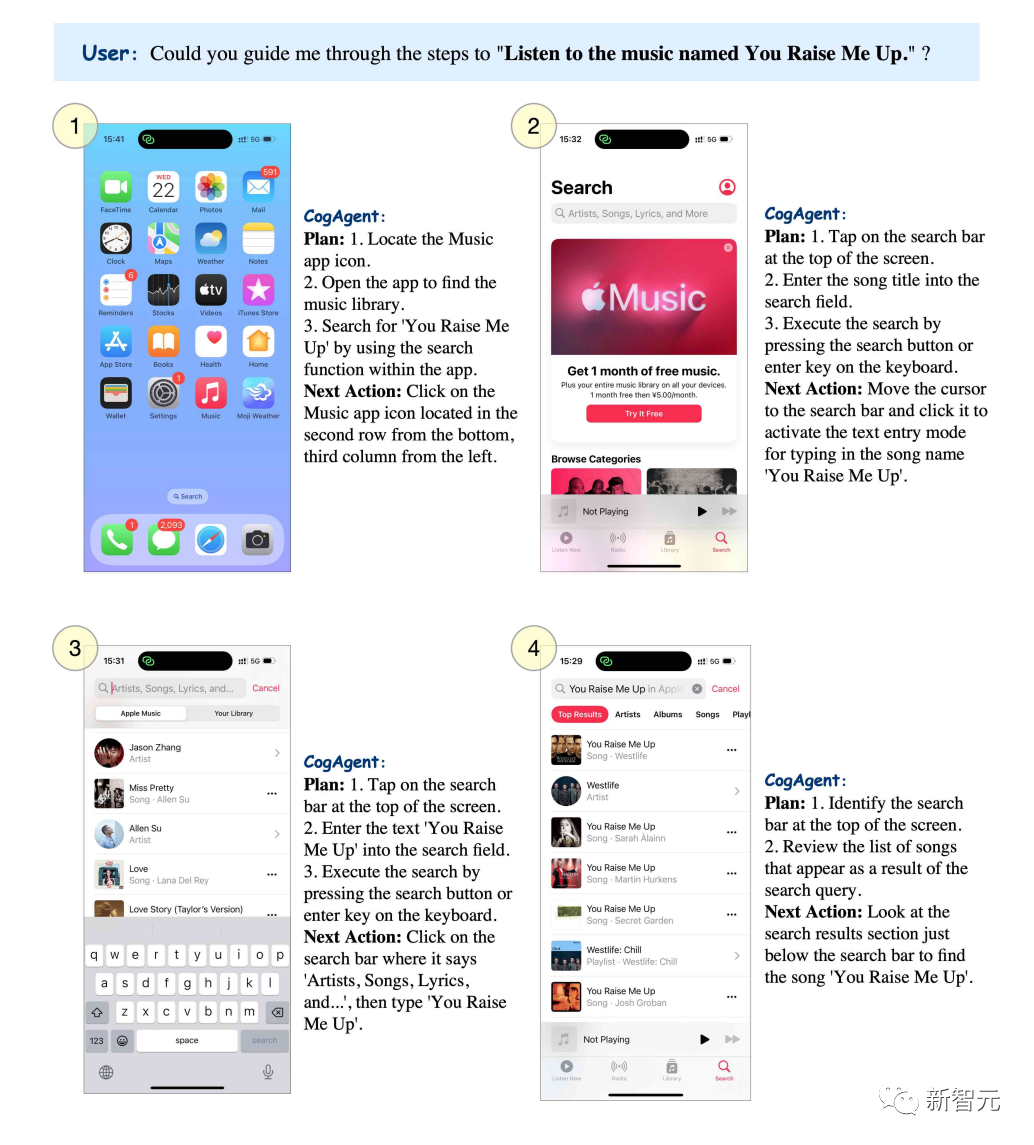

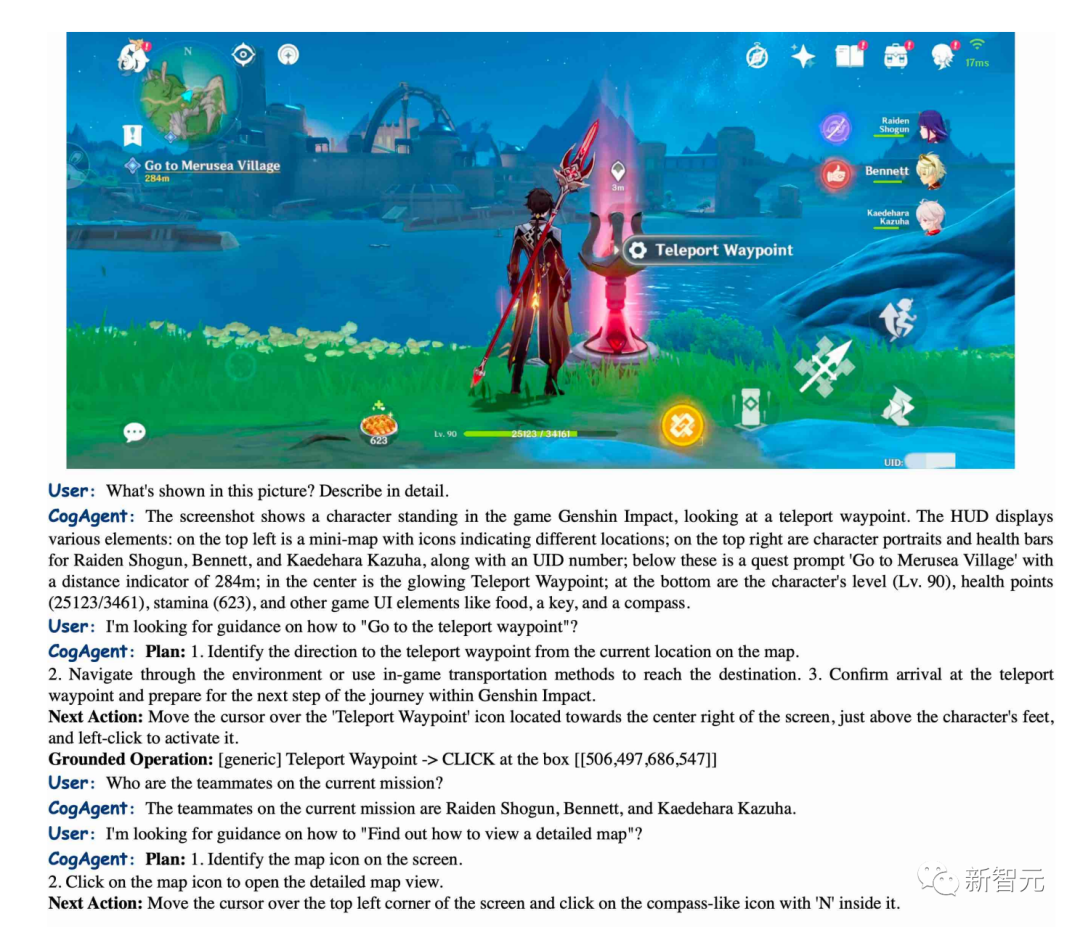

2.具備可視化代理的能力,能夠在任何圖形使用者介面截圖上返回任何給定任務的計劃、下⼀步行動和帶有坐標的具體操作。

3.增強了與圖形使用者介面相關的問題解答功能,使其能夠處理與網頁、PC應用程式、行動應用程式等任何圖形使用者介面截圖相關的問題。

4.透過改進預培訓和微調,增強了OCR相關任務的能力。

圖形使用者介面代理程式(GUI Agent)

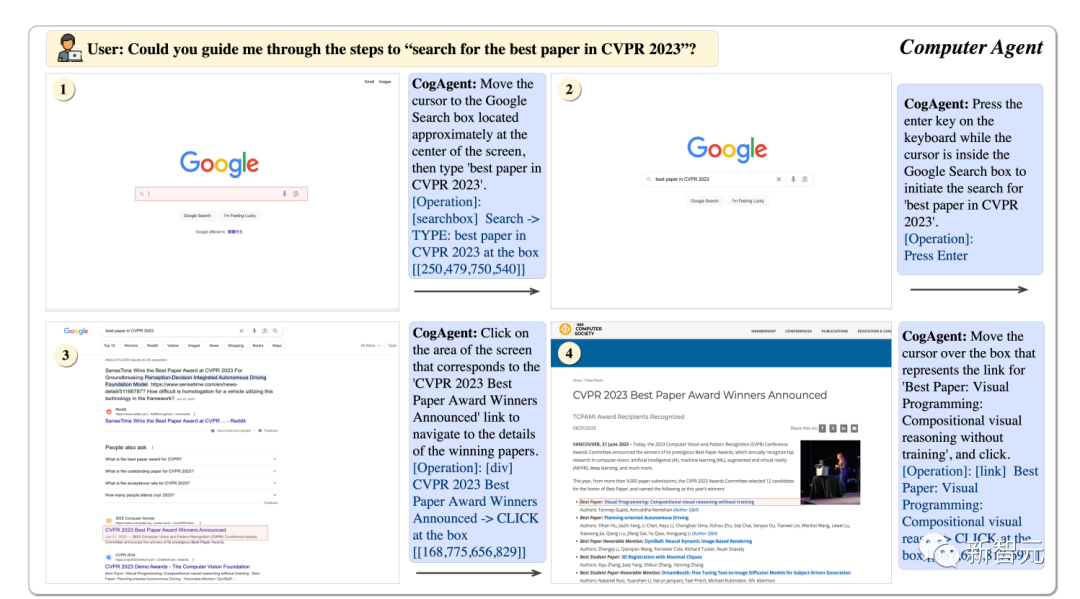

利用CogAgent,它可以幫我們一步一步找到CVPR23的最佳論文。

圖片

圖片

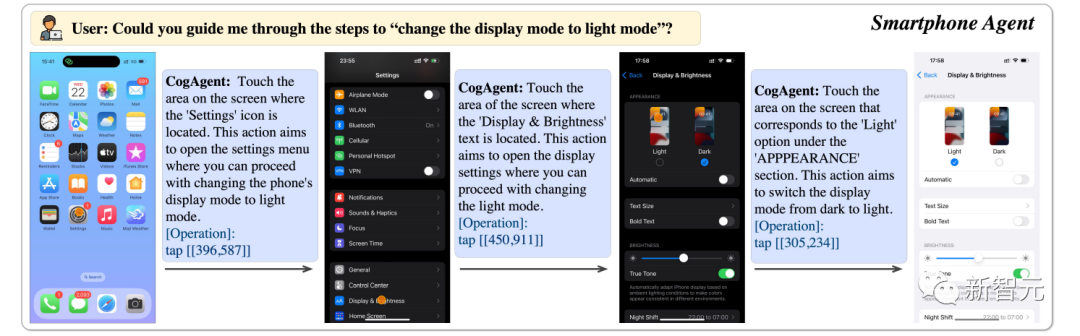

可以幫我們把手機顯示調成明亮模式。

圖片

圖片

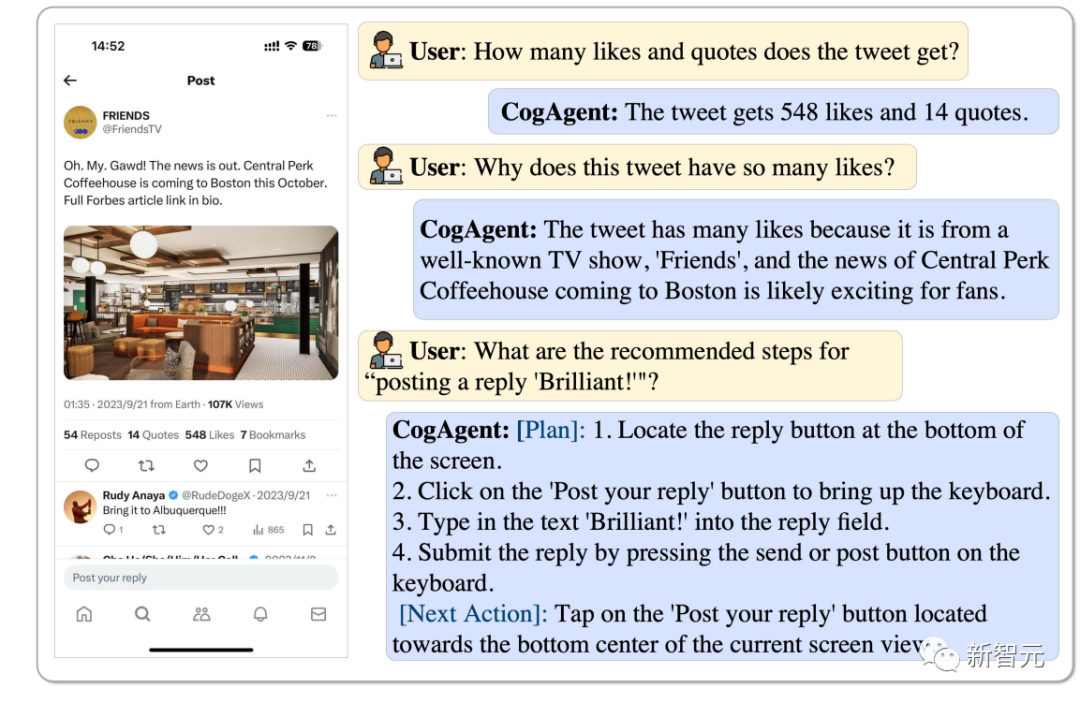

這則推文有多少轉評贊,為什麼如此受歡迎,CogAgent都能分析出來,甚至連回覆一個“Brilliant” ,它都能操作。

圖片

圖片

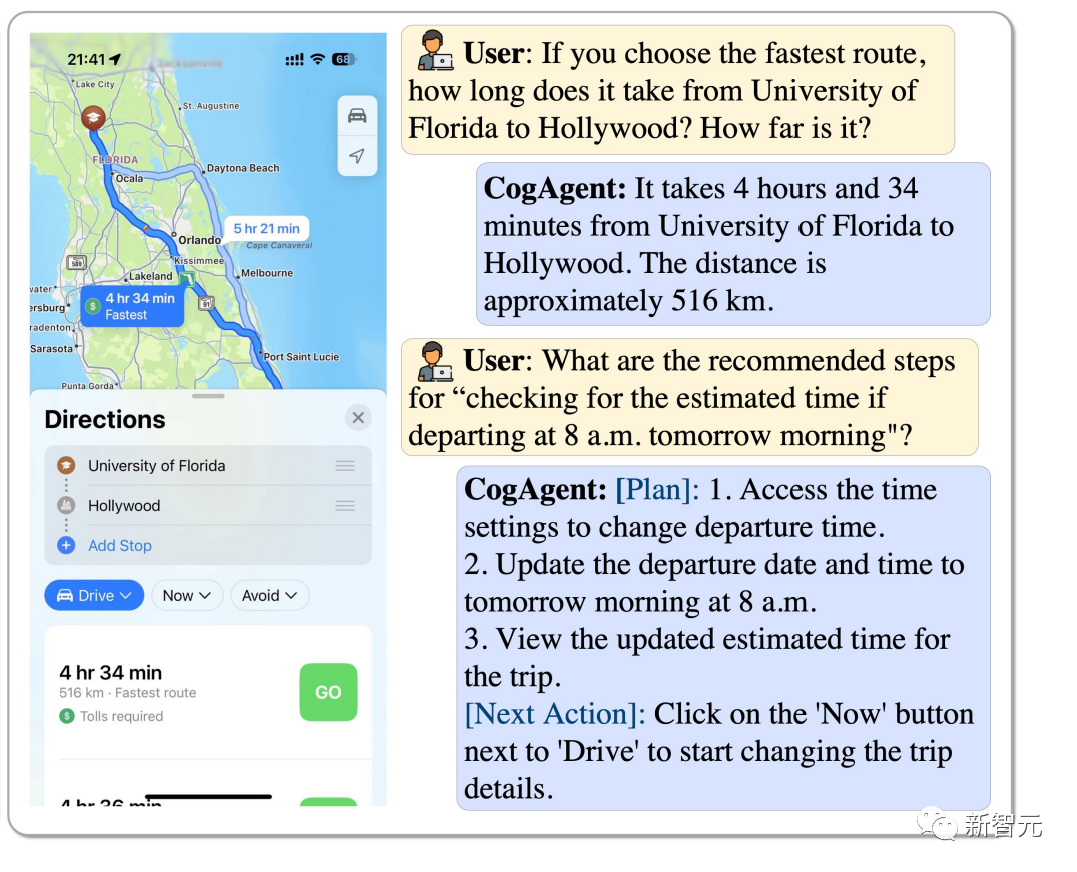

從弗羅裡達大學到好萊塢,怎麼選擇最快的路線?如果從早上8點出發,該如何評估需要花多久時間? CogAgent都可以回答。

圖片

圖片

可以設定特定的主題,讓CogAgent寄到指定的郵件信箱。

圖片

圖片

想聽一首

圖片

圖片

CogAgent能精準地描述出《原神》中的畫面,也能引導你如何走到傳送點。

圖片

圖片

BakLLaVA

#BakLLaVA1是使用LLaVA 1.5架構增強的Mistral 7B基礎模型。

在第⼀個版本中,Mistral 7B基礎模型在多個基準測試中優於Llama 2 13B。

在他們的repo中,就可以運行BakLLaVA-1了。頁面還在不斷更新中,以方便微調和推理。 (https://github.com/SkunkworksAI/BakLLaVA)

BakLLaVA-1是完全開源的,但在某些資料上進行了訓練,其中包括LLaVA的語料庫,因此不允許商用。

BakLLaVA 2採用了更大的資料集和更新的架構,超越了目前的LLaVa方法。 BakLLaVA擺脫了BakLLaVA-1的限制,可以商用。

參考資料:

https://yousefhosni.medium.com/discover-4-open-source-alternatives-to-gpt-4-vision-82be9519dcc5

以上是清華浙大主導開源視覺模型爆炸, GPT-4V與LLaVA、CogAgent等平台帶來革命性變革的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

十個推薦開源免費文字標註工具

Mar 26, 2024 pm 08:20 PM

十個推薦開源免費文字標註工具

Mar 26, 2024 pm 08:20 PM

文字標註工作是將標籤或標記與文字中特定內容相對應的工作。其主要目的是為文本提供額外的信息,以便進行更深入的分析和處理,尤其是在人工智慧領域。文字標註對於人工智慧應用中的監督機器學習任務至關重要。用於訓練AI模型,有助於更準確地理解自然語言文本訊息,並提高文本分類、情緒分析和語言翻譯等任務的表現。透過文本標註,我們可以教導AI模型識別文本中的實體、理解上下文,並在出現新的類似數據時做出準確的預測。本文主要推薦一些較好的開源文字標註工具。 1.LabelStudiohttps://github.com/Hu

15個值得推薦的開源免費圖片標註工具

Mar 28, 2024 pm 01:21 PM

15個值得推薦的開源免費圖片標註工具

Mar 28, 2024 pm 01:21 PM

圖像標註是將標籤或描述性資訊與圖像相關聯的過程,以賦予圖像內容更深層的含義和解釋。這個過程對於機器學習至關重要,它有助於訓練視覺模型以更準確地識別圖像中的各個元素。透過為圖像添加標註,使得電腦能夠理解圖像背後的語義和上下文,從而提高對圖像內容的理解和分析能力。影像標註的應用範圍廣泛,涵蓋了許多領域,如電腦視覺、自然語言處理和圖視覺模型具有廣泛的應用領域,例如,輔助車輛識別道路上的障礙物,幫助疾病的檢測和診斷透過醫學影像識別。本文主要推薦一些較好的開源免費的圖片標註工具。 1.Makesens

建議:優秀JS開源人臉偵測辨識項目

Apr 03, 2024 am 11:55 AM

建議:優秀JS開源人臉偵測辨識項目

Apr 03, 2024 am 11:55 AM

人臉偵測辨識技術已經是一個比較成熟且應用廣泛的技術。而目前最廣泛的網路應用語言非JS莫屬,在Web前端實現人臉偵測辨識相比後端的人臉辨識有優勢也有弱勢。優點包括減少網路互動、即時識別,大大縮短了使用者等待時間,提高了使用者體驗;弱勢是:受到模型大小限制,其中準確率也有限。如何在web端使用js實現人臉偵測呢?為了實現Web端人臉識別,需要熟悉相關的程式語言和技術,如JavaScript、HTML、CSS、WebRTC等。同時也需要掌握相關的電腦視覺和人工智慧技術。值得注意的是,由於Web端的計

25個AI智能體源碼現已公開,靈感來自史丹佛的「虛擬小鎮」和《西方世界》

Aug 11, 2023 pm 06:49 PM

25個AI智能體源碼現已公開,靈感來自史丹佛的「虛擬小鎮」和《西方世界》

Aug 11, 2023 pm 06:49 PM

熟悉《西方世界》的觀眾都了解,這部劇設定在未來世界的一個巨大高科技成人主題樂園中,機器人們具備與人類相似的行為能力,能夠記憶所見所聞,重複核心故事情節。每天,這些機器人都會被重置,回到初始狀態在斯坦福論文《GenerativeAgents:InteractiveSimulacraofHumanBehavior》發布後,這種情景不再僅限於影視劇中,AI已經成功復現了這一場景Smallville的“虛擬小鎮」概覽圖論文網址:https://arxiv.org/pdf/2304.03442v1.pdf

阿里7B多模態文件理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

阿里7B多模態文件理解大模型拿下新SOTA

Apr 02, 2024 am 11:31 AM

多模態文件理解能力新SOTA!阿里mPLUG團隊發布最新開源工作mPLUG-DocOwl1.5,針對高解析度圖片文字辨識、通用文件結構理解、指令遵循、外部知識引入四大挑戰,提出了一系列解決方案。話不多說,先來看效果。複雜結構的圖表一鍵識別轉換為Markdown格式:不同樣式的圖表都可以:更細節的文字識別和定位也能輕鬆搞定:還能對文檔理解給出詳細解釋:要知道,“文檔理解”目前是大語言模型實現落地的一個重要場景,市面上有許多輔助文檔閱讀的產品,有的主要透過OCR系統進行文字識別,配合LLM進行文字理

單卡跑Llama 70B快過雙卡,微軟硬生把FP6搞到A100哩 | 開源

Apr 29, 2024 pm 04:55 PM

單卡跑Llama 70B快過雙卡,微軟硬生把FP6搞到A100哩 | 開源

Apr 29, 2024 pm 04:55 PM

FP8和更低的浮點數量化精度,不再是H100的「專利」了!老黃想讓大家用INT8/INT4,微軟DeepSpeed團隊在沒有英偉達官方支援的條件下,硬生在A100上跑起FP6。測試結果表明,新方法TC-FPx在A100上的FP6量化,速度接近甚至偶爾超過INT4,而且比後者擁有更高的精度。在此基礎之上,還有端到端的大模型支持,目前已經開源並整合到了DeepSpeed等深度學習推理框架中。這項成果對大模型的加速效果也是立竿見影──在這種框架下用單卡跑Llama,吞吐量比雙卡還要高2.65倍。一名

1.3ms耗時!清華最新開源行動裝置神經網路架構 RepViT

Mar 11, 2024 pm 12:07 PM

1.3ms耗時!清華最新開源行動裝置神經網路架構 RepViT

Mar 11, 2024 pm 12:07 PM

论文地址:https://arxiv.org/abs/2307.09283代码地址:https://github.com/THU-MIG/RepViTRepViT在移动端ViT架构中表现出色,展现出显著的优势。接下来,我们将探讨本研究的贡献所在。文中提到,轻量级ViTs通常比轻量级CNNs在视觉任务上表现得更好,这主要归功于它们的多头自注意力模块(MSHA)可以让模型学习全局表示。然而,轻量级ViTs和轻量级CNNs之间的架构差异尚未得到充分研究。在这项研究中,作者们通过整合轻量级ViTs的有效

剛剛發布!一鍵產生動漫風格圖片的開源模型

Apr 08, 2024 pm 06:01 PM

剛剛發布!一鍵產生動漫風格圖片的開源模型

Apr 08, 2024 pm 06:01 PM

向大家介紹一個最新的AIGC開源專案-AnimagineXL3.1。這個專案是動漫主題文字到圖像模型的最新迭代,旨在為用戶提供更優化和強大的動漫圖像生成體驗。在AnimagineXL3.1中,開發團隊專注於優化了幾個關鍵方面,以確保模型在效能和功能上達到新的高度。首先,他們擴展了訓練數據,不僅包括了先前版本中的遊戲角色數據,還加入許多其他知名動漫系列的數據納入訓練集中。這項舉措豐富了模型的知識庫,使其能夠更全面地理解各種動漫風格和角色。 AnimagineXL3.1引入了一組新的特殊標籤和美學標