新技術Repaint123:有效率地產生優質的單視圖3D,只需2分鐘!

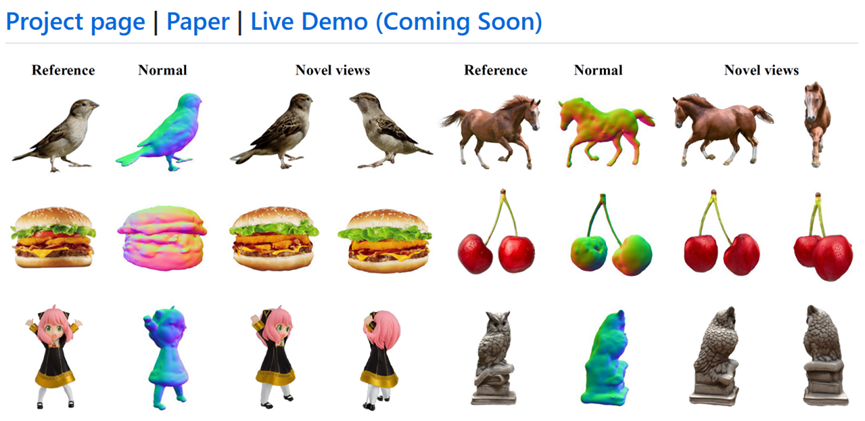

將一幅影像轉換為3D的方法通常採用Score Distillation Sampling(SDS)的方法,儘管結果令人印象深刻,但仍存在多個不足之處,包括多重視角不一致、過度飽和、過度平滑的紋理,以及生成速度緩慢等問題。

為了解決這些問題,北京大學、新加坡國立大學、武漢大學等機構的研究人員提出了Repaint123,以減輕多視角偏差、紋理退化,並加速生成過程。

論文網址:https://arxiv.org/pdf/2312.13271.pdf

GitHub :https://github.com/PKU-YuanGroup/repaint123

計畫網址:https://pku-yuangroup.github.io/repaint123/

#核心概念是將2D擴散模型的生成影像能力與紋理對齊能力結合,以產生高品質多視角影像。

作者進一步提出了可見性感知的自適應再繪強度,以提升生成影像品質。

產生的高品質、多視角一致的影像使得可以使用簡單的均方誤差(MSE)損失進行快速的3D內容產生。

作者經實驗證明,Repaint123能夠在2分鐘內產生高品質的3D內容,具有多視角一致性和精細紋理。

文章的主要貢獻點如下:

#1. Repaint123全面考慮了圖像到3D生成的可控重繪過程,能夠生成多元視角一致的高品質圖片序列。

2. Repaint123提出了一個簡單的單視圖3D產生的baseline,粗模階段採用Zero123作為3D prior與SDS損失快速優化Gaussian Splatting幾何(1分鐘),細模階段採用Stable Diffusion作為2D prior與MSE損失快速精緻Mesh紋理(1分鐘)。

3. 大量的實驗驗證了Repaint123方法的有效性,可以在短短2分鐘內從單一影像中產生匹配2D產生的品質的3D內容。

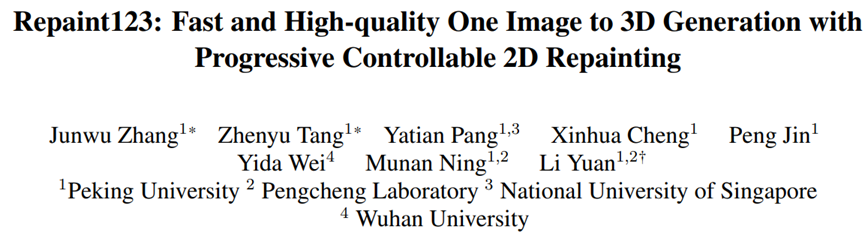

圖1:論文動機:快速、一致、高品質的單一視角3D生成

具體方法:

Repaint123主要改進集中於mesh細化階段,包含兩個部分:多視角一致的高品質影像序列生成,快速高品質的3D重建。

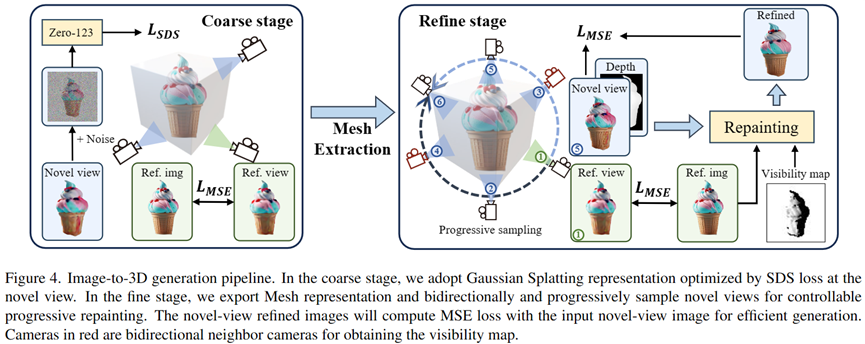

在粗模階段,作者採用3D Gaussian Splatting作為3D表徵,透過SDS損失優化的粗模幾何和紋理。

在細化階段,作者將粗模模型轉換為網格表示,並提出漸進的、可控制的紋理細化重繪方案。

首先,作者透過幾何控制和參考影像的指導逐步重新繪製相對於先前最佳化視圖的不可見區域,從而獲得新穎視圖的視圖一致性影像。

然後,作者採用影像提示進行無分類器指導,並設計自適應重繪策略,以進一步提高重疊區域的生成品質。

最後,透過產生視圖一致的高品質影像,作者利用簡單的MSE損失來快速產生3D內容。

多重視角一致的高品質影像序列產生:

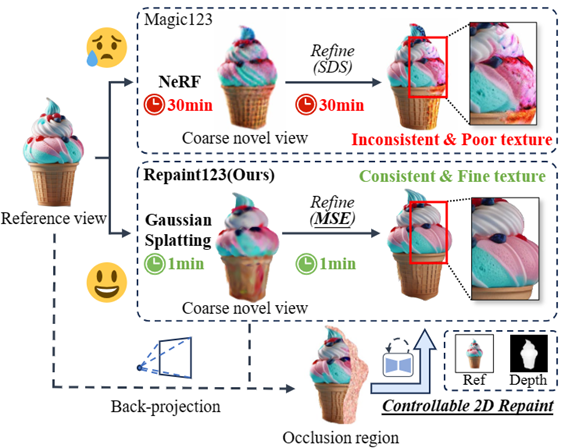

#如圖2所示,多視角一致的高品質影像序列生成分為以下四個部分:

圖2:多重視角一致的影像產生流程

#DDIM Inversion

為了保存粗模階段產生的3D一致的低頻紋理訊息,作者使用DDIM Inversion將影像反演到確定的latent, 為後續去噪產生忠實一致的圖片做基礎。

Controllable Denoising

#為了控制幾何一致性與長程紋理一致,在去噪階段作者使用ControlNet引入粗模渲染的深度圖作為幾何先驗, 注入參考圖的Attention特徵進行紋理遷移。

同時,為了執行Classifier-free guidance提升影像質量,論文使用CLIP將參考圖編碼為image prompt提示去噪網路。

Obtain Occlusion Mask

為了從渲染出來的圖片In和深度圖Dn的新穎視圖中獲得遮擋掩碼Mn,在給定Ir和Dr的重繪參考視圖Vr條件下,作者首先透過使用深度Dr縮放來自Vr的2D像素點至3D點雲,然後從新視角Vn渲染3D點雲Pr,得到深度圖Dn'。

作者認為兩個新穎視圖深度圖(Dn和Dn')之間具有不同深度值的區域是遮蔽遮罩中的遮蔽區域。

Progressively Repainting both Occlusions and Overlaps

為了確保影像序列重相鄰影像的重疊區域像素層級對齊,作者使用了漸進式局部重繪的策略,在保持重疊區域不變的情況下產生和諧一致的臨近區域,從參考視角依次類推到360°。

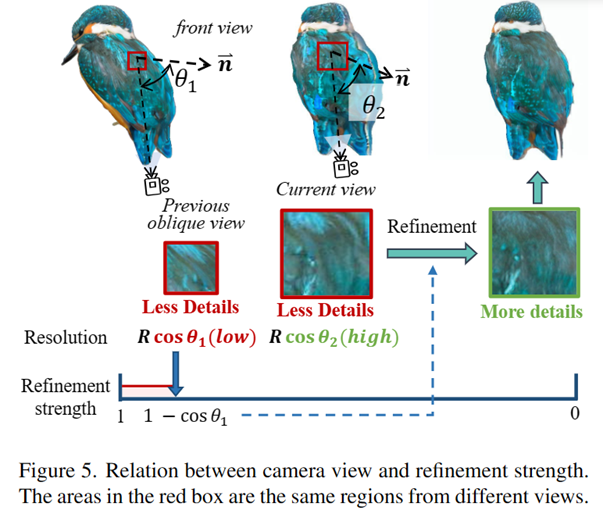

但是如圖3所示,作者發現重疊區域同樣需要進行細化,因為一個先前斜視的區域在正視時其可視分辨率變大,需要補充更多的高頻訊息。

為了選擇合適的細化強度使得在提升品質的同時保證忠實度,作者藉用投影定理與影像超分的思想,提出了一種簡單直接的能見度可感知的重繪策略來細化重疊區域,另細化強度等於1-cosθ*(其中θ*為先前所有相機視角與所視表面法向量夾角的最大值),從而自適應地重繪重疊區域。

圖3:相機視角與細化強度的關係

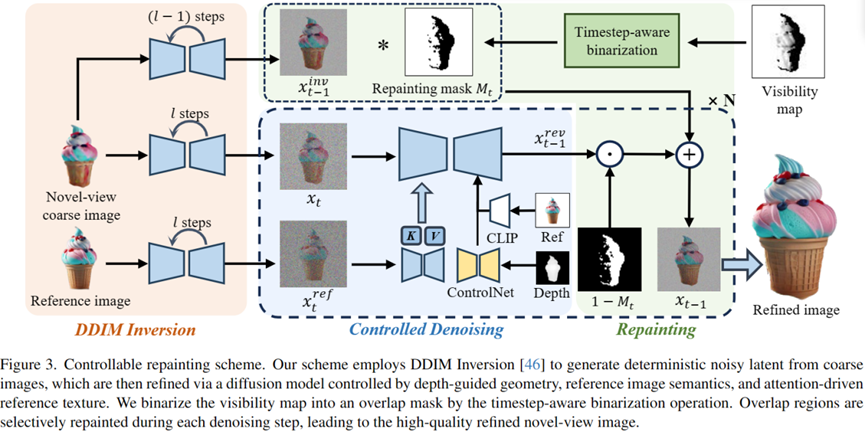

快速高品質的3D重建:

如圖4所示,作者採用了兩階段方法,先使用Gaussian Splatting表示來快速產生合理的幾何和粗糙的紋理,同時藉助上述生成的多視角一致的高品質影像序列, 作者得以使用簡單的MSE loss進行快速的3D紋理重建。

圖4:Repaint123兩階段單一視角3D生成框架

實驗結果

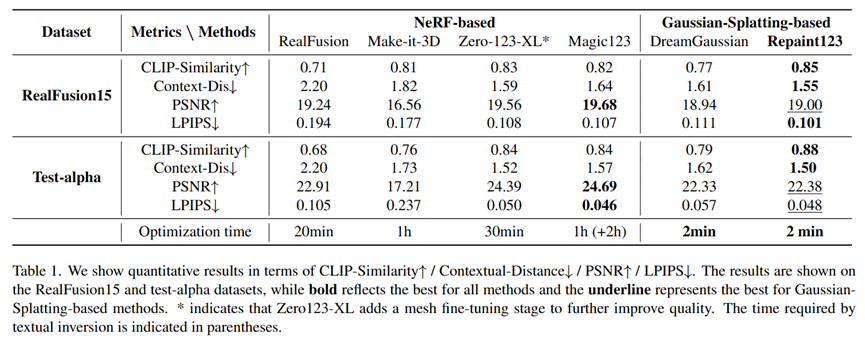

作者比較了多個單視圖生成任務方法,在RealFusion15和Test-alpha資料集上取得了一致性、品質、速度三方面最先進的效果。

單一視圖3D產生視覺化比較

單一視圖3D生成定量比較

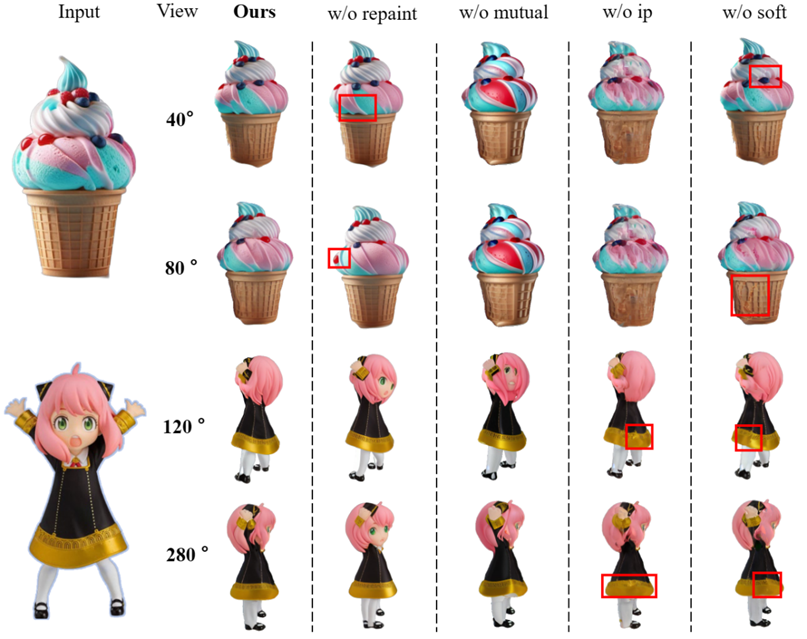

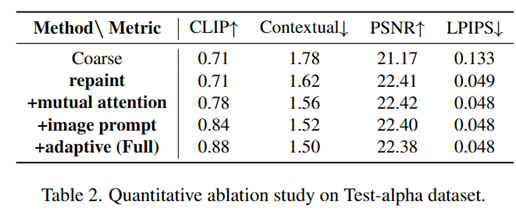

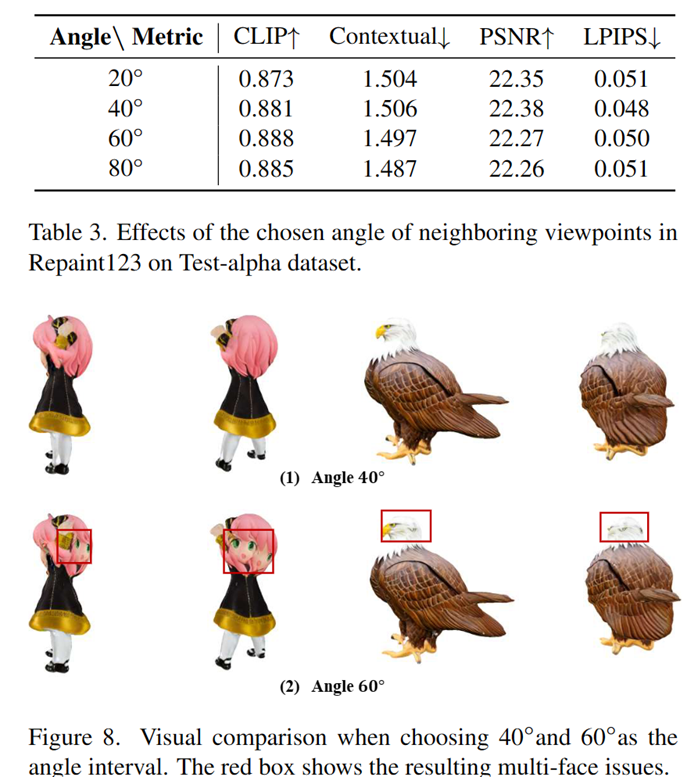

#同時,作者也對論文使用的每個模組的有效性以及視角轉動增量進行了消融實驗:

以上是新技術Repaint123:有效率地產生優質的單視圖3D,只需2分鐘!的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

開源!超越ZoeDepth! DepthFM:快速且精確的單目深度估計!

Apr 03, 2024 pm 12:04 PM

開源!超越ZoeDepth! DepthFM:快速且精確的單目深度估計!

Apr 03, 2024 pm 12:04 PM

0.這篇文章乾了啥?提出了DepthFM:一個多功能且快速的最先進的生成式單目深度估計模型。除了傳統的深度估計任務外,DepthFM還展示了在深度修復等下游任務中的最先進能力。 DepthFM效率高,可以在少數推理步驟內合成深度圖。以下一起來閱讀這項工作~1.論文資訊標題:DepthFM:FastMonocularDepthEstimationwithFlowMatching作者:MingGui,JohannesS.Fischer,UlrichPrestel,PingchuanMa,Dmytr

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想像一下,一個人工智慧模型,不僅擁有超越傳統運算的能力,還能以更低的成本實現更有效率的效能。這不是科幻,DeepSeek-V2[1],全球最強開源MoE模型來了。 DeepSeek-V2是一個強大的專家混合(MoE)語言模型,具有訓練經濟、推理高效的特點。它由236B個參數組成,其中21B個參數用於啟動每個標記。與DeepSeek67B相比,DeepSeek-V2效能更強,同時節省了42.5%的訓練成本,減少了93.3%的KV緩存,最大生成吞吐量提高到5.76倍。 DeepSeek是一家探索通用人工智

AI顛覆數學研究!菲爾茲獎得主、華裔數學家領銜11篇頂刊論文|陶哲軒轉贊

Apr 09, 2024 am 11:52 AM

AI顛覆數學研究!菲爾茲獎得主、華裔數學家領銜11篇頂刊論文|陶哲軒轉贊

Apr 09, 2024 am 11:52 AM

AI,的確正在改變數學。最近,一直十分關注這個議題的陶哲軒,轉發了最近一期的《美國數學學會通報》(BulletinoftheAmericanMathematicalSociety)。圍繞著「機器會改變數學嗎?」這個話題,許多數學家發表了自己的觀點,全程火花四射,內容硬核,精彩紛呈。作者陣容強大,包括菲爾茲獎得主AkshayVenkatesh、華裔數學家鄭樂雋、紐大電腦科學家ErnestDavis等多位業界知名學者。 AI的世界已經發生了天翻地覆的變化,要知道,其中許多文章是在一年前提交的,而在這一

你好,電動Atlas!波士頓動力機器人復活,180度詭異動作嚇到馬斯克

Apr 18, 2024 pm 07:58 PM

你好,電動Atlas!波士頓動力機器人復活,180度詭異動作嚇到馬斯克

Apr 18, 2024 pm 07:58 PM

波士頓動力Atlas,正式進入電動機器人時代!昨天,液壓Atlas剛「含淚」退出歷史舞台,今天波士頓動力就宣布:電動Atlas上崗。看來,在商用人形機器人領域,波士頓動力是下定決心要跟特斯拉硬剛一把了。新影片放出後,短短十幾小時內,就已經有一百多萬觀看。舊人離去,新角色登場,這是歷史的必然。毫無疑問,今年是人形機器人的爆發年。網友銳評:機器人的進步,讓今年看起來像人類的開幕式動作、自由度遠超人類,但這真不是恐怖片?影片一開始,Atlas平靜地躺在地上,看起來應該是仰面朝天。接下來,讓人驚掉下巴

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

替代MLP的KAN,被開源專案擴展到卷積了

Jun 01, 2024 pm 10:03 PM

本月初,來自MIT等機構的研究者提出了一種非常有潛力的MLP替代方法—KAN。 KAN在準確性和可解釋性方面表現優於MLP。而且它能以非常少的參數量勝過以更大參數量運行的MLP。例如,作者表示,他們用KAN以更小的網路和更高的自動化程度重現了DeepMind的結果。具體來說,DeepMind的MLP有大約300,000個參數,而KAN只有約200個參數。 KAN與MLP一樣具有強大的數學基礎,MLP基於通用逼近定理,而KAN基於Kolmogorov-Arnold表示定理。如下圖所示,KAN在邊上具

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人進廠打工,馬斯克:手的自由度今年將達到22個!

May 06, 2024 pm 04:13 PM

特斯拉機器人Optimus最新影片出爐,已經可以在工廠裡打工了。正常速度下,它分揀電池(特斯拉的4680電池)是這樣的:官方還放出了20倍速下的樣子——在小小的「工位」上,揀啊揀啊揀:這次放出的影片亮點之一在於Optimus在廠子裡完成這項工作,是完全自主的,全程沒有人為的干預。而且在Optimus的視角之下,它還可以把放歪了的電池重新撿起來放置,主打一個自動糾錯:對於Optimus的手,英偉達科學家JimFan給出了高度的評價:Optimus的手是全球五指機器人裡最靈巧的之一。它的手不僅有觸覺

FisheyeDetNet:首個以魚眼相機為基礎的目標偵測演算法

Apr 26, 2024 am 11:37 AM

FisheyeDetNet:首個以魚眼相機為基礎的目標偵測演算法

Apr 26, 2024 am 11:37 AM

目標偵測在自動駕駛系統當中是一個比較成熟的問題,其中行人偵測是最早得以部署演算法之一。在多數論文當中已經進行了非常全面的研究。然而,利用魚眼相機進行環視的距離感知相對來說研究較少。由於徑向畸變大,標準的邊界框表示在魚眼相機當中很難實施。為了緩解上述描述,我們探索了擴展邊界框、橢圓、通用多邊形設計為極座標/角度表示,並定義一個實例分割mIOU度量來分析這些表示。所提出的具有多邊形形狀的模型fisheyeDetNet優於其他模型,並同時在用於自動駕駛的Valeo魚眼相機資料集上實現了49.5%的mAP

快手版Sora「可靈」開放測試:生成超120s視頻,更懂物理,複雜運動也能精準建模

Jun 11, 2024 am 09:51 AM

快手版Sora「可靈」開放測試:生成超120s視頻,更懂物理,複雜運動也能精準建模

Jun 11, 2024 am 09:51 AM

什麼?瘋狂動物城被國產AI搬進現實了?與影片一同曝光的,是一款名為「可靈」全新國產影片生成大模型。 Sora利用了相似的技術路線,結合多項自研技術創新,生產的影片不僅運動幅度大且合理,還能模擬物理世界特性,具備強大的概念組合能力與想像。數據上看,可靈支持生成長達2分鐘的30fps的超長視頻,分辨率高達1080p,且支援多種寬高比。另外再劃個重點,可靈不是實驗室放出的Demo或影片結果演示,而是短影片領域頭部玩家快手推出的產品級應用。而且主打一個務實,不開空頭支票、發布即上線,可靈大模型已在快影