2023年電信AI公司頂會論文及競賽分享

近年來,中國電信在人工智慧技術方向持續努力。 2023年11月28日,中國電信數位智慧科技分公司正式更名為中電信人工智慧科技有限公司(以下簡稱「電信AI公司」)。 2023年,電信AI公司在21項國內外頂級AI競賽中連續獲獎,申請了100多項專利,並在CVPR、ACM MM、ICCV等頂級會議和期刊上發表了30多篇論文,展現了國資央企在人工智慧技術領域佈局的初步成果

作為中國電信開展人工智慧業務的專業公司,電信AI公司是一家科技型、能力型和平台型企業。公司致力於攻克人工智慧核心技術、研究尖端技術和推動產業空間拓展,旨在成為百億級的人工智慧服務商。在過去的兩年中,電信AI公司成功地自主研發了一系列創新應用成果,如星河AI演算法倉賦能平台、星雲AI四級算力平台和星辰通用基礎大模型等。現在,公司擁有800多名員工,平均年齡31歲,其中80%為研發人員,70%來自於國內外網路大廠和AI頭部企業。為了加速大模型時代的研發進展,公司擁有2,500多張A100等值算力的訓練卡以及300多位專職的資料標註人員。同時,公司也聯合上海人工智慧實驗室、西安交通大學、北京郵電大學和智源研究院等科學研究機構,面向中國電信的6000萬視聯網和數億用戶場景,共同打造國際一流的人工智慧技術和應用

接下來,我們將回顧並分享電信AI公司在2023年所取得的一些重要研究成果。本次分享將介紹AI研發中心CV演算法團隊在ICCV 2023賽事中獲得Temporal Action Localisation賽道冠軍的技術成果。 ICCV是國際電腦視覺領域的三大頂級會議之一,每兩年舉辦一次,業界評價極高。本文將分享該團隊在此次挑戰中所採用的演算法思路與方案

ICCV 2023感知測試挑戰-時間動作定位冠軍技術分享

比賽概況和團隊背景

DeepMind發起的ICCV 2023首屆感知測試挑戰旨在評估模型在視訊、音訊和文字模態中的能力。該競賽涵蓋了四個技能領域、四種推理類型和六個計算任務,以全面評估多模態感知模型的能力。其中,Temporal Action Localisation賽道的核心任務是對未剪輯的影片內容進行深入理解和準確的動作定位,該技術對自動駕駛系統、視訊監控分析等多種應用場景具有重要意義

本次比賽中,參賽團隊由電信AI公司交通演算法方向的成員組成,該團隊名為CTCV。電信AI公司在電腦視覺技術領域深入研究,並累積了豐富的經驗。其技術成果已在城市治理、交通治安等多個業務領域廣泛應用,並持續服務大量使用者

引言是一篇文章的開頭部分,旨在引起讀者的興趣並提供背景資訊。一個好的引言可以吸引讀者的注意力,概括文章的主題,並激發讀者繼續閱讀的慾望。寫引言時,要注意語言簡潔明了,內容準確有力。引言的目的是為了引導讀者進入文章的主題,因此需要引用相關的事實、數據或引人思考的問題。總之,引言是文章的門戶,可以決定讀者是否繼續閱讀下去

影片理解的一個挑戰性問題是在影片中定位和分類動作的任務,即時序動作定位(Temporal Action Localisation, TAL)

TAL技術近期取得了顯著進展。舉例來說,TadTR和ReAct採用了類似DETR的基於Transformer的解碼器來進行動作偵測,將動作實例建模為一組可學習的集合。而TallFormer則利用基於Transformer的編碼器來擷取視訊表徵

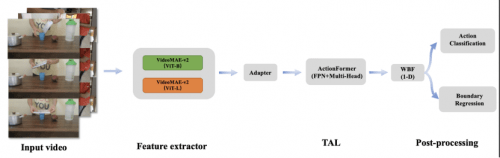

儘管以上方法在時序動作定位方面已經取得了良好的效果,但在視訊感知能力方面存在一些限制。要更好地定位動作實例,可靠的視訊特徵表達是關鍵。我們的團隊首先採用VideoMAE-v2框架,加入adapter linear層,訓練了具有兩種不同主幹網路的動作類別預測模型,並使用模型分類層前一層進行TAL任務的特徵提取。接下來,我們利用改進的ActionFormer框架訓練了TAL任務,並修改了WBF方法以適應TAL任務。最終,我們的方法在評測集上實現了0.50的mAP,排名第一,領先第二名的團隊3個百分點,比Google DeepMind提供的基準模型高出34個百分點

2 競賽解決方案

演算法概覽如下圖所示:

2.1 資料增強

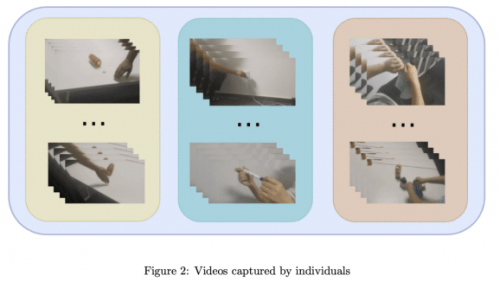

在Temporal Action Localisation賽道中,CTCV團隊使用的資料集是未經修剪的用於動作定位的視頻,具有高分辨率,並且包含多個動作實例的特點。透過分析資料集,發現訓練集相較於驗證集缺少了三個類別的標籤。為了確保模型驗證的充分性以及滿足競賽的要求,團隊收集了少量的視訊數據,並將其加入訓練資料集中,以豐富訓練樣本。同時為了簡化標註過程,每個影片預設只包含一個動作

請參考圖2中自主擷取的視訊範例

2.2 動作辨識與特徵提取

#近年來,出現了許多基於大規模資料訓練的基礎模型,這些模型透過零樣本識別、線性探測、提示微調、微調等方法,將基礎模型的強大泛化能力應用到多個下游任務中,有效推動了人工智慧領域的多個方面的進步

TAL賽道中的動作定位和辨識十分具有挑戰性。例如,"假裝將某物撕成碎片"和"將某物撕成碎片"這兩個動作非常相似,這無疑給特徵層面帶來了更大的挑戰。因此,直接使用現有的預訓練模型來提取特徵的效果並不理想

因此,我們團隊透過解析JSON標註文件,將TAL資料集轉換為動作辨識資料集。然後,我們以Vit-B和Vit-L為主幹網絡,在VideoMAE-v2網絡後增加adapter層和用於分類的linear層,訓練同資料域下的動作分類器。我們也將動作分類模型去除linear層,用於影片特徵的擷取。 VitB模型的特徵維度為768,而ViTL模型的特徵維度為1024。當我們同時將這兩種特徵進行concat時,我們產生了一個新的特徵,維度為1792,這個特徵將作為訓練時序動作定位模型的替代品。在訓練的初期,我們嘗試了音訊特徵,但實驗結果發現mAP指標有所下降。因此,在後續的實驗中,我們沒有考慮到音頻特徵

2.3 時序動作定位

Actionformer是一個以時間為序的動作定位設計的anchor-free模型。它融合了多尺度特徵和時間維度的局部自註意力。在本次競賽中,CTCV團隊選擇Actionformer作為動作定位的基準模型,用於預測動作發生的邊界(起止時間)和類別

CTCV團隊對動作邊界回歸和動作分類任務進行了統一處理。相對於基線訓練結構,首先將視訊特徵編碼到多尺度的Transformer中。然後在模型的迴歸和分類的head分支中引入了特徵金字塔層,以增強網路特徵表達能力,每個時間步驟的head分支會產生一個動作候選。同時,透過增加head數量到32,並引入fpn1D結構,進一步提升了模型的定位與辨識能力

1-D的2.4 WBF

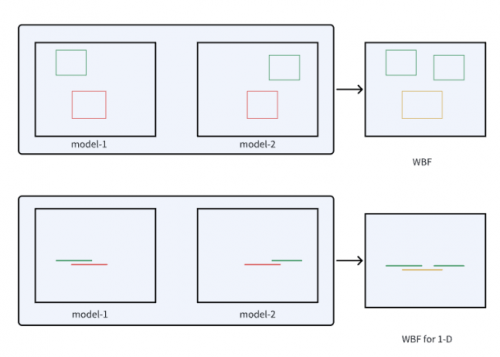

#加權盒子融合(Weighted Boxes Fusion,簡稱WBF)是一種創新的偵測框融合方法。此方法利用所有偵測框的置信度來建構最終的預測框,在影像目標偵測中表現出了不錯的效果。與NMS和soft-NMS方法不同,加權盒子融合不會捨棄任何預測結果,而是利用所有提出的邊界框的置信度分數來建構平均的盒子。這種方法大大提高了預測矩形的準確性

在WBF的啟發下,CTCV團隊將動作的一維邊界框類比為一維線段,並對WBF方法進行了修改,使其適用於TAL任務。實驗結果顯示此方法的有效性,如圖3所示

改進後的一維WBF示意圖如圖3所示

3 實驗結果

3.1 評估指標。 評估標準

評估指標是mAP,用於本次挑戰賽。 mAP是透過計算不同動作類別和IoU閾值的平均精確度來確定的。 CTCV團隊以0.1的增量評估IoU閾值,範圍從0.1到0.5

3.2 實驗細節重寫如下:

為了得到多樣化的模型,CTCV團隊對訓練資料集進行了80%的重複採樣,總共進行了5次。分別採用了Vit-B、Vit-L和concat的特徵進行模型訓練,成功得到了15個多樣化的模型。最終,這些模型的評估結果被輸入到WBF模組,並為每個模型結果分配了相同的融合權重

實驗結果如下圖所示:

表1中顯示了不同特徵的效能比較。第一行和第二行展示了使用ViT-B和ViT-L特徵的結果。第三行展示了ViT-B和ViT-L特徵級聯的結果

在實驗過程中,CTCV團隊發現級聯特徵的平均精確度(mAP)略低於ViT-L,但仍優於ViT-B。儘管如此,透過在驗證集上的各種方法表現,我們將不同特徵在評測集的預測結果藉助WBF進行融合,最終提交到系統的mAP為0.50

需要重新改寫的內容是:4 結論

CTCV團隊在本次競賽中採取了多項策略來提升效能。首先,他們透過資料收集來增強驗證集中缺失的類別的訓練資料。其次,他們利用VideoMAE-v2框架加入adapter層來訓練視訊特徵提取器,並透過改進的ActionFormer框架來訓練TAL任務。此外,他們還修改了WBF方法以有效地融合測試結果。最終,CTCV團隊在評測集上取得了0.50的mAP,名列第一。 電信AI公司一直秉持著「科技從業務中來,到業務中去」的發展理念。他們將競賽視為檢驗和提陞技術能力的重要平台,並透過參與競賽不斷優化和完善技術方案,為客戶提供更高品質的服務。同時,參與競賽也為團隊成員提供了寶貴的學習與成長機會

以上是2023年電信AI公司頂會論文及競賽分享的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

10個生成AI編碼擴展,在VS代碼中,您必須探索

Apr 13, 2025 am 01:14 AM

10個生成AI編碼擴展,在VS代碼中,您必須探索

Apr 13, 2025 am 01:14 AM

嘿,編碼忍者!您當天計劃哪些與編碼有關的任務?在您進一步研究此博客之前,我希望您考慮所有與編碼相關的困境,這是將其列出的。 完畢? - 讓&#8217

GPT-4O vs OpenAI O1:新的Openai模型值得炒作嗎?

Apr 13, 2025 am 10:18 AM

GPT-4O vs OpenAI O1:新的Openai模型值得炒作嗎?

Apr 13, 2025 am 10:18 AM

介紹 Openai已根據備受期待的“草莓”建築發布了其新模型。這種稱為O1的創新模型增強了推理能力,使其可以通過問題進行思考

如何在SQL中添加列? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

如何在SQL中添加列? - 分析Vidhya

Apr 17, 2025 am 11:43 AM

SQL的Alter表語句:動態地將列添加到數據庫 在數據管理中,SQL的適應性至關重要。 需要即時調整數據庫結構嗎? Alter表語句是您的解決方案。本指南的詳細信息添加了Colu

pixtral -12b:Mistral AI'第一個多模型模型 - 分析Vidhya

Apr 13, 2025 am 11:20 AM

pixtral -12b:Mistral AI'第一個多模型模型 - 分析Vidhya

Apr 13, 2025 am 11:20 AM

介紹 Mistral發布了其第一個多模式模型,即Pixtral-12b-2409。該模型建立在Mistral的120億參數Nemo 12B之上。是什麼設置了該模型?現在可以拍攝圖像和Tex

如何使用AGNO框架構建多模式AI代理?

Apr 23, 2025 am 11:30 AM

如何使用AGNO框架構建多模式AI代理?

Apr 23, 2025 am 11:30 AM

在從事代理AI時,開發人員經常發現自己在速度,靈活性和資源效率之間進行權衡。我一直在探索代理AI框架,並遇到了Agno(以前是Phi-

超越駱駝戲:大型語言模型的4個新基準

Apr 14, 2025 am 11:09 AM

超越駱駝戲:大型語言模型的4個新基準

Apr 14, 2025 am 11:09 AM

陷入困境的基準:駱駝案例研究 2025年4月上旬,梅塔(Meta)揭開了其Llama 4套件的模特,擁有令人印象深刻的性能指標,使他們對GPT-4O和Claude 3.5 Sonnet等競爭對手的良好定位。倫斯的中心

多動症遊戲,健康工具和AI聊天機器人如何改變全球健康

Apr 14, 2025 am 11:27 AM

多動症遊戲,健康工具和AI聊天機器人如何改變全球健康

Apr 14, 2025 am 11:27 AM

視頻遊戲可以緩解焦慮,建立焦點或支持多動症的孩子嗎? 隨著醫療保健在全球範圍內挑戰,尤其是在青年中的挑戰,創新者正在轉向一種不太可能的工具:視頻遊戲。現在是世界上最大的娛樂印度河之一

OpenAI以GPT-4.1的重點轉移,將編碼和成本效率優先考慮

Apr 16, 2025 am 11:37 AM

OpenAI以GPT-4.1的重點轉移,將編碼和成本效率優先考慮

Apr 16, 2025 am 11:37 AM

該版本包括三種不同的型號,GPT-4.1,GPT-4.1 MINI和GPT-4.1 NANO,標誌著向大語言模型景觀內的特定任務優化邁進。這些模型並未立即替換諸如