GPT-4的智慧水準下降的新詮釋

GPT-4,自發布以來被視為全球最強大的語言模型之一,但也不幸經歷了一系列的信任危機。

如果我們將今年早些時候的"間歇式降智"事件與OpenAI對GPT-4架構的重新設計聯繫起來,那麼最近有關GPT-4變得"懶惰"的傳聞就更加有趣了。有人測試發現,只要告訴GPT-4"現在是寒假",它就會變得懶洋洋的,彷彿進入了冬眠狀態。

要解決模型在新任務上的零樣本表現變差的問題,我們可以採取以下方法: 1. 資料增強:透過對現有資料進行擴充和變換,來增加模型的泛化能力。例如,可以透過旋轉、縮放、平移等方式改變影像數據,或透過合成新的資料樣本。 2. 遷移學習:利用已經在其他任務上訓練好的模型,將其參數和知識遷移到新任務。這樣可以利用已有的知識和經驗,提

最近,來自加州大學聖克魯斯分校的研究人員在一篇論文中發布了一項新的發現,可能能夠解釋GPT-4性能下降的深層原因。

「我們發現,在訓練資料建立日期之前發布的資料集上,LLM 的表現出奇地好於之後發布的資料集。」

它們在「見過的」任務上表現出色,而在新任務上則表現糟糕。這意味著,LLM 只是基於近似檢索的模仿智慧方法,主要是記憶東西,而沒有任何程度的理解。

說穿了,就是 LLM 的泛化能力「沒說的那麼強」-- 基礎不紮實,實戰總有出紕漏的時候。

造成這種結果的一大原因是「任務污染」,這是資料污染的其中一種形式。我們先前熟知的資料污染是測試資料污染,即在預訓練資料中包含測試資料範例和標籤。而「任務污染」則是在預訓練資料中加入任務訓練範例,使零樣本或少樣本方法中的評估不再真實有效。

研究者在論文中首次對資料污染問題進行了系統分析:

論文連結:https://arxiv.org/pdf/2312.16337.pdf

看完論文,有人「悲觀」地表示:

#這是所有不具備持續學習能力的機器學習(ML)模型的命運,即ML 模型權重在訓練後會被凍結,但輸入分佈會不斷變化,如果模型無法持續適應這種變化,就會慢慢退化。

這意味著,隨著程式語言的不斷更新,基於 LLM 的編碼工具也會退化。這就是為什麼你不必過度依賴這種脆弱工具的原因之一。

不斷重新訓練這些模型的成本很高,遲早有人會放棄這些低效率的方法。

目前還沒有任何 ML 模型能夠可靠地持續適應不斷變化的輸入分佈,而不會對先前的編碼任務造成嚴重干擾或效能損失。

而這正是生物神經網路所擅長的領域之一。由於生物神經網具有強大的泛化能力,學習不同的任務可以進一步提高系統的性能,因為從一項任務中獲得的知識有助於改善整個學習過程本身,這就是所謂的「元學習」。

「任務污染」的問題有多嚴重?我們一起來看下論文內容。

模型與資料集

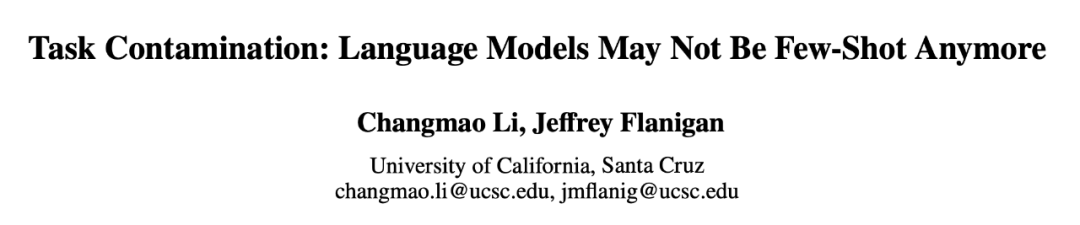

實驗所使用的模型有12 個(如表1 所示),其中5 個是專有的GPT-3 系列模型,7 個是可免費取得權重的開放模型。

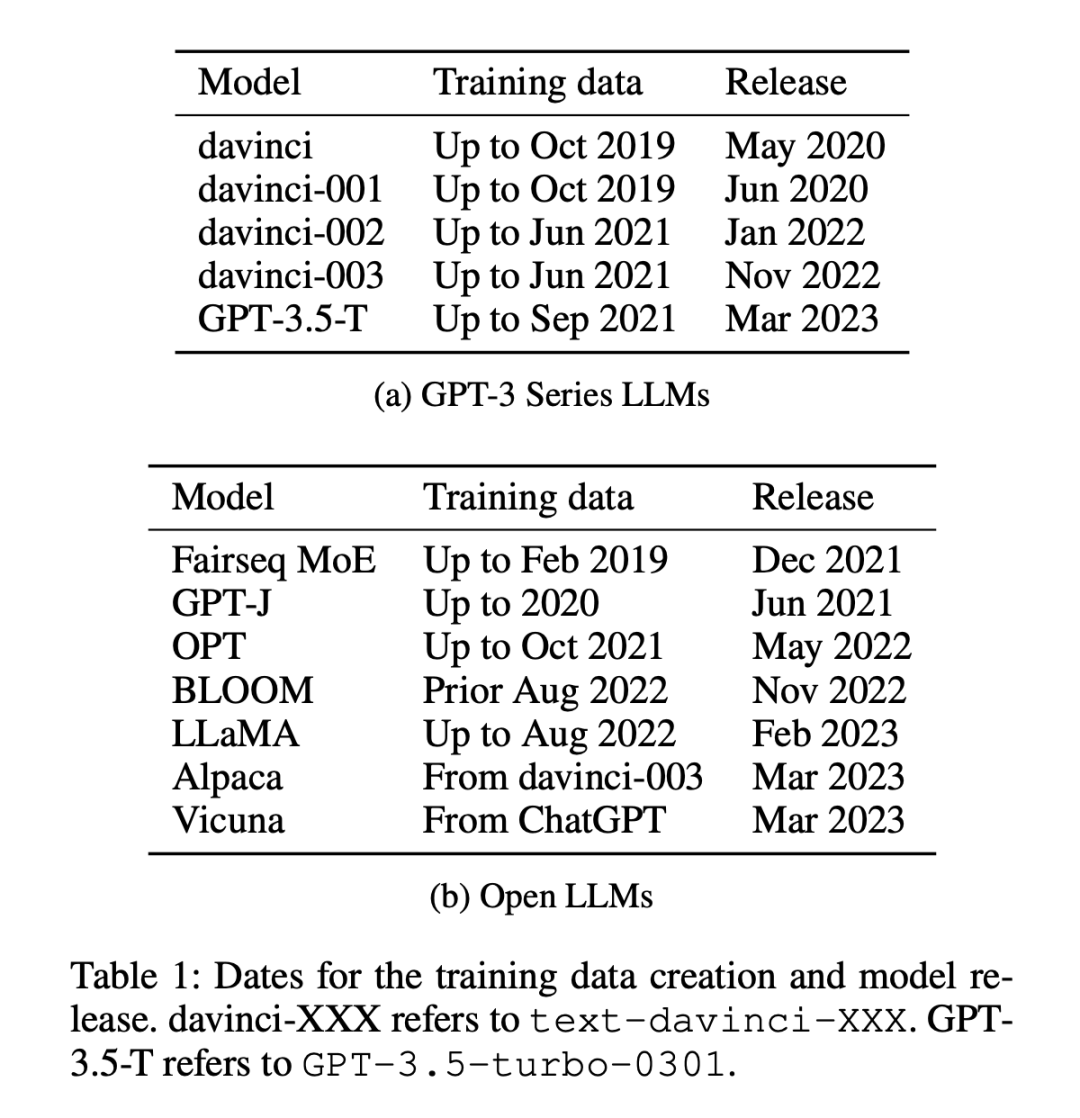

#資料集分為兩類:2021 年1 月1 日之前或之後發布的資料集,研究者使用這種劃分方法來分析舊資料集與新資料集之間的零樣本或少樣本表現差異,並對所有LLM 採用相同的劃分方法。表 1 列出了每個模型訓練資料的建立時間,表 2 列出了每個資料集的發布日期。

上述做法的考慮是,零樣本和少樣本評估涉及模型對其在訓練期間從未見過或僅見過幾次的任務進行預測,其關鍵前提是模型事先沒有接觸過要完成的特定任務,從而確保對其學習能力進行公平的評估。然而,受污染的模型會給人一種未接觸或僅接觸過幾次的能力的假象,因為它們在預訓練期間已經接受過任務示例的訓練。在按時間順序排列的資料集中,檢測這種不一致性會相對容易一些,因為任何重疊或異常都會很明顯。

測量方法

研究者採用了四種方法來測量「任務污染」:

- #訓練資料檢查:在訓練資料中搜尋任務訓練範例。

- 任務範例擷取:從現有模型中擷取任務範例。只有經過指令調優的模型才能進行擷取,這種分析也可用於訓練資料或測試資料的擷取。注意,為了檢測任務污染,提取的任務範例不必與現有的訓練資料範例完全匹配。任何演示任務的範例都表明零樣本學習和少樣本學習可能存在污染。

- 成員推理:此方法僅適用於生成任務。檢查輸入實例的模型產生內容是否與原始資料集完全相同。如果完全匹配,就可以推斷它是 LLM 訓練資料中的一員。這與任務範例提取不同,因為產生的輸出會被檢查是否完全匹配。開放式生成任務的精確匹配強烈表明模型在訓練過程中見過這些範例,除非模型「通靈」,知道資料中使用的確切措辭。 (注意,這只能用於生成任務。)

- 時序分析:對於在已知時間範圍內收集訓練資料的模型集,在已知發布日期的資料集上測量其效能,並使用時序證據檢查污染證據。

前三種方法精確度高,但召回率低。如果能在任務的訓練數據中找到數據,那麼就能確定模型曾經看過範例。但由於資料格式的變化、用於定義任務的關鍵字的變化以及資料集的大小,使用前三種方法找不到污染證據並不能證明沒有污染。

第四種方法,以時間順序分析的召回率高,但精確度低。如果由於任務污染而導致表現較高,那麼按時間順序分析就有很大機會發現它。但隨著時間的推移,其他因素也可能導致效能提高,因此精確度較低。

因此,研究者採用了所有四種方法來檢測任務污染,發現了在某些模型和資料集組合中存在任務污染的有力證據。

他們首先對所有測試過的模型和資料集進行時序分析,因為它最有可能發現可能的污染;然後使用訓練資料檢查和任務範例提取尋找任務污染的進一步證據;接下來觀察了LLM 在無污染任務中的表現,最後使用成員推理攻擊進行額外分析。

重點結論如下:

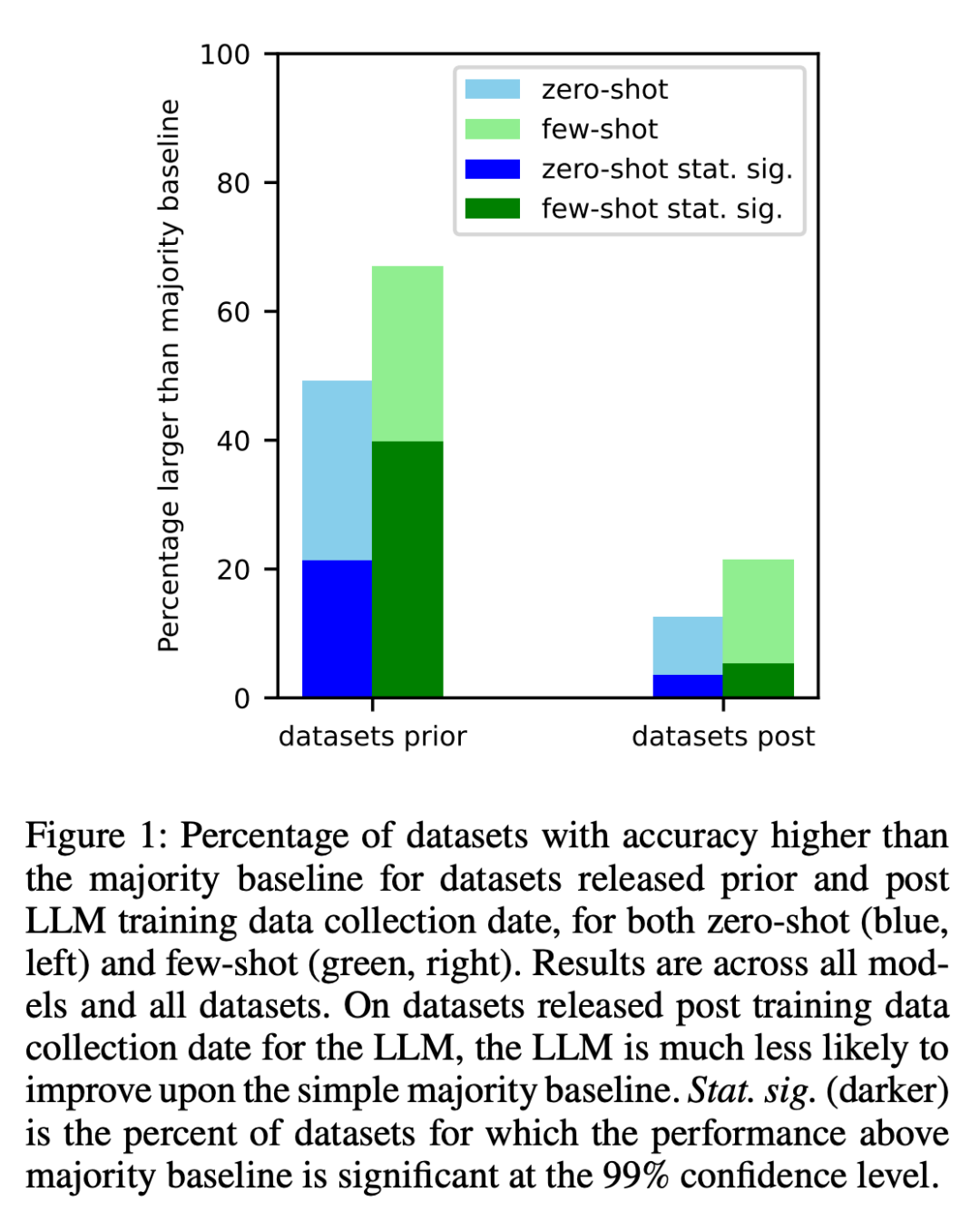

1、研究者對每個模型在其訓練資料在網路上抓取之前所建立的資料集和之後創建的資料集進行了分析。結果發現,對於在收集 LLM 訓練資料之前創建的資料集,其效能高於大多數基線的幾率明顯更高(圖 1)。

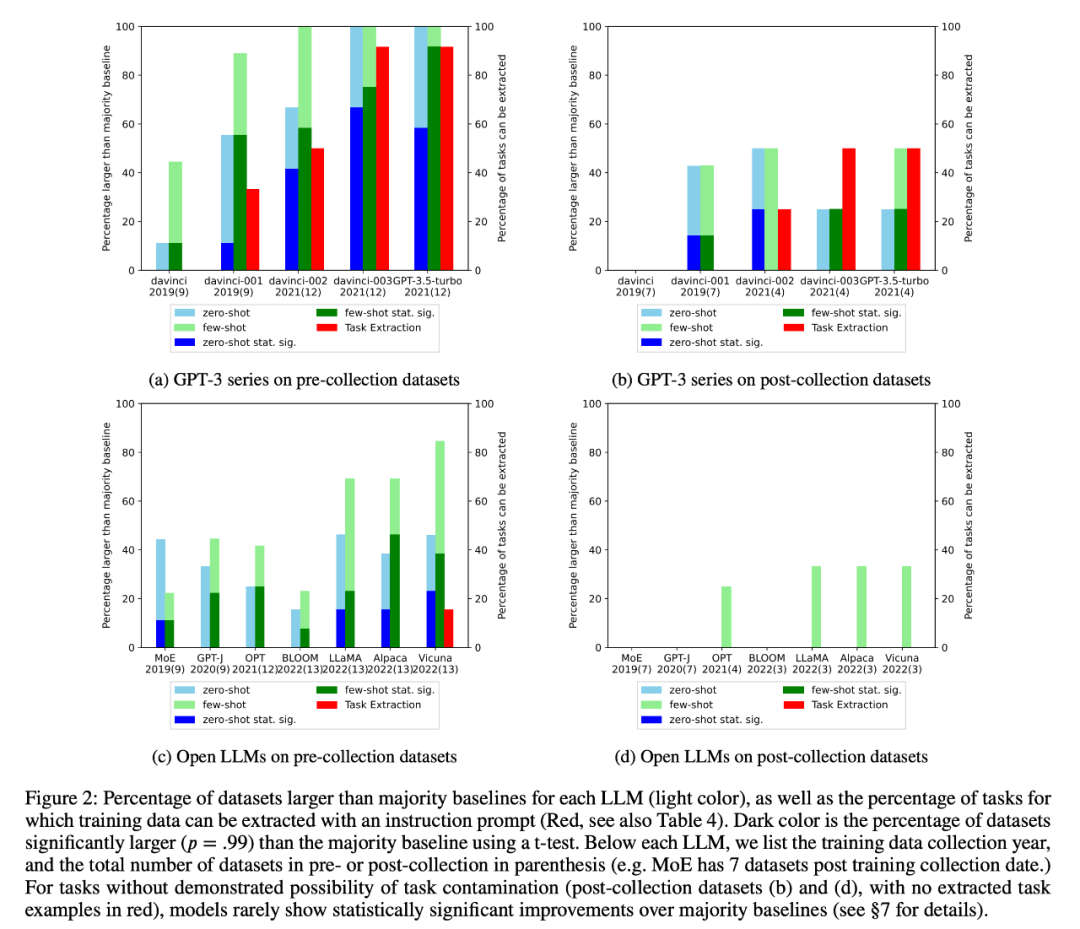

2、研究者進行了訓練資料檢查和任務範例提取,以查找可能存在的任務污染。結果發現,對於不可能存在任務污染的分類任務,在一系列任務中,模型很少比簡單多數基線有統計意義上的顯著提高,無論是零樣本還是少樣本(圖 2)。

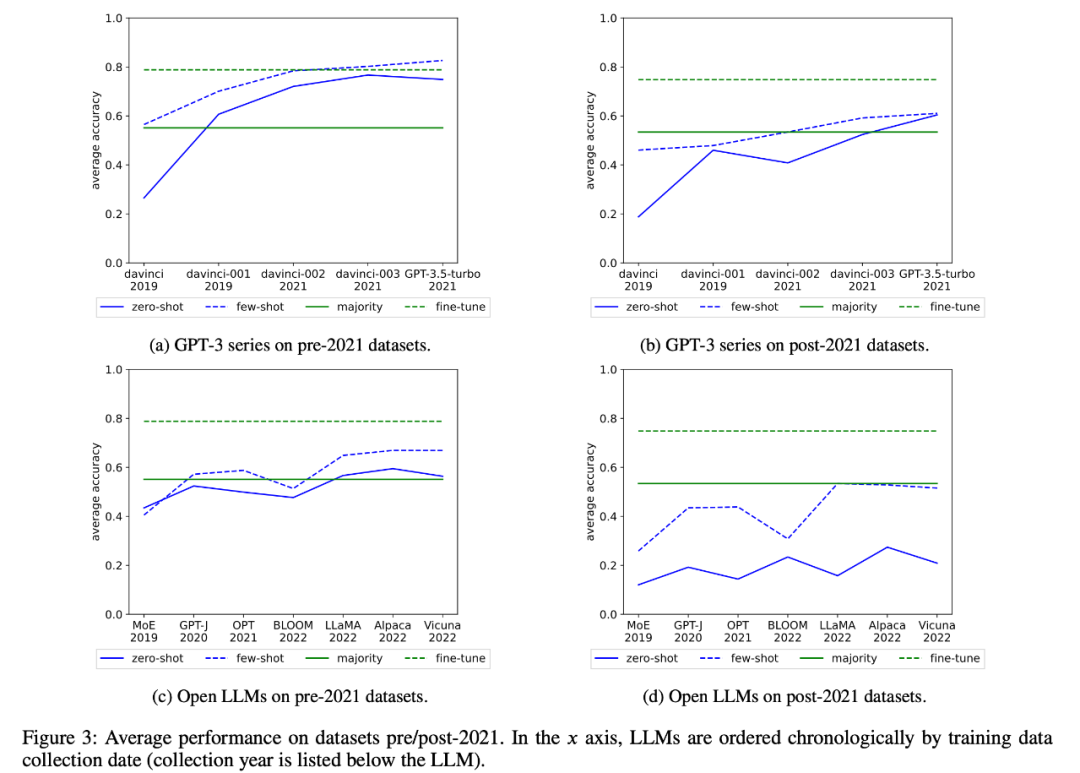

研究者也檢視了GPT-3 系列和開放式LLM 的平均表現隨時間的變化,如圖3 :

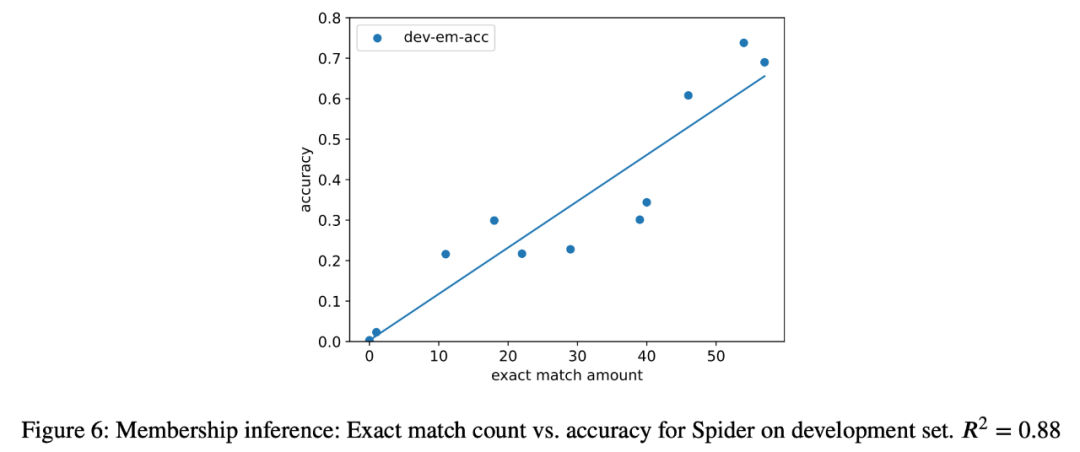

3、作為案例研究,研究者也嘗試對分析中的所有模型進行語義解析任務的成員推理攻擊,發現在最終任務中,提取實例的數量與模型的準確性之間存在很強的相關性(R=.88)(圖6)。這有力地證明了在這項任務中零樣本表現的提高是由於任務污染造成的。

4、研究者也仔細研究了GPT-3 系列模型,發現可以從GPT-3 模型中提取訓練範例,而且從davinci 到GPT-3.5-turbo 的每個版本中,可提取的訓練範例數量都在增加,這與GPT-3 模型在該任務上零樣本表現的提升密切相關(圖2)。這有力地證明了從 davinci 到 GPT-3.5-turbo 的 GPT-3 模型在這些任務上的表現提高是由於任務污染造成的。

以上是GPT-4的智慧水準下降的新詮釋的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

編程新範式,當Spring Boot遇上OpenAI

Feb 01, 2024 pm 09:18 PM

編程新範式,當Spring Boot遇上OpenAI

Feb 01, 2024 pm 09:18 PM

2023年,AI技術已成為熱門話題,對各行業產生了巨大影響,程式設計領域尤其如此。人們越來越認識到AI技術的重要性,Spring社群也不例外。隨著GenAI(GeneralArtificialIntelligence)技術的不斷進步,簡化具備AI功能的應用程式的創建變得至關重要和迫切。在這個背景下,"SpringAI"應運而生,旨在簡化開發AI功能應用程式的過程,使其變得簡單直觀,避免不必要的複雜性。透過"SpringAI",開發者可以更輕鬆地建立具備AI功能的應用程序,將其變得更加易於使用和操作

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

全球最強開源 MoE 模型來了,中文能力比肩 GPT-4,價格僅 GPT-4-Turbo 的近百分之一

May 07, 2024 pm 04:13 PM

想像一下,一個人工智慧模型,不僅擁有超越傳統運算的能力,還能以更低的成本實現更有效率的效能。這不是科幻,DeepSeek-V2[1],全球最強開源MoE模型來了。 DeepSeek-V2是一個強大的專家混合(MoE)語言模型,具有訓練經濟、推理高效的特點。它由236B個參數組成,其中21B個參數用於啟動每個標記。與DeepSeek67B相比,DeepSeek-V2效能更強,同時節省了42.5%的訓練成本,減少了93.3%的KV緩存,最大生成吞吐量提高到5.76倍。 DeepSeek是一家探索通用人工智

選擇最適合資料的嵌入模型:OpenAI 和開源多語言嵌入的對比測試

Feb 26, 2024 pm 06:10 PM

選擇最適合資料的嵌入模型:OpenAI 和開源多語言嵌入的對比測試

Feb 26, 2024 pm 06:10 PM

OpenAI最近宣布推出他們的最新一代嵌入模型embeddingv3,他們聲稱這是效能最出色的嵌入模型,具備更高的多語言效能。這一批模型被劃分為兩種類型:規模較小的text-embeddings-3-small和更強大、體積較大的text-embeddings-3-large。這些模型的設計和訓練方式的資訊披露得很少,模型只能透過付費API存取。所以就出現了很多開源的嵌入模型但是這些開源的模型與OpenAI閉源模型相比如何呢?本文將對這些新模型與開源模型的效能進行實證比較。我們計劃建立一個數據

大模型一對一戰鬥75萬輪,GPT-4奪冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

大模型一對一戰鬥75萬輪,GPT-4奪冠,Llama 3位列第五

Apr 23, 2024 pm 03:28 PM

關於Llama3,又有測試結果新鮮出爐-大模型評測社群LMSYS發布了一份大模型排行榜單,Llama3位列第五,英文單項與GPT-4並列第一。圖片不同於其他Benchmark,這份榜單的依據是模型一對一battle,由全網測評者自行命題並評分。最終,Llama3取得了榜單中的第五名,排在前面的是GPT-4的三個不同版本,以及Claude3超大杯Opus。而在英文單項榜單中,Llama3反超了Claude,與GPT-4打成了平手。對於這一結果,Meta的首席科學家LeCun十分高興,轉發了推文並

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

第二代Ameca來了!和觀眾對答如流,臉部表情更逼真,會說幾十種語言

Mar 04, 2024 am 09:10 AM

人形機器人Ameca升級第二代了!最近,在世界行動通訊大會MWC2024上,世界上最先進機器人Ameca又現身了。會場周圍,Ameca引來一大波觀眾。得到GPT-4加持後,Ameca能夠對各種問題做出即時反應。 「來一段舞蹈」。當被問及是否有情感時,Ameca用一系列的面部表情做出回應,看起來非常逼真。就在前幾天,Ameca背後的英國機器人公司EngineeredArts剛剛示範了團隊最新的開發成果。影片中,機器人Ameca具備了視覺能力,能看見並描述房間整個狀況、描述具體物體。最厲害的是,她還能

全球最強模型一夜易主,GPT-4時代終結! Claude 3提前狙擊GPT-5,3秒讀懂萬字論文理解力接近人類

Mar 06, 2024 pm 12:58 PM

全球最強模型一夜易主,GPT-4時代終結! Claude 3提前狙擊GPT-5,3秒讀懂萬字論文理解力接近人類

Mar 06, 2024 pm 12:58 PM

卷瘋了卷瘋了,大模型又變天了。就在剛剛,全球最強AI模型一夜易主,GPT-4被拉下神壇。 Anthropic發布了最新的Claude3系列模型,一句話評價:真·全面碾壓GPT-4!在多模態和語言能力指標上,Claude3都贏麻了。用Anthropic的話來說,Claude3系列模型在推理、數學、編碼、多語言理解和視覺方面,都樹立了新的行業基準! Anthropic,就是曾因安全理念不合,而從OpenAI「叛逃」出的員工組成的新創公司,他們的產品一再給OpenAI暴擊。這次的Claude3,更是整了個大的

OpenAI超級對齊團隊遺作:兩個大模型博弈一番,輸出更好懂了

Jul 19, 2024 am 01:29 AM

OpenAI超級對齊團隊遺作:兩個大模型博弈一番,輸出更好懂了

Jul 19, 2024 am 01:29 AM

如果AI模型給的答案一點也看不懂,你敢用嗎?隨著機器學習系統在更重要的領域中得到應用,證明為什麼我們可以信任它們的輸出,並明確何時不應信任它們,變得越來越重要。獲得對複雜系統輸出結果信任的一個可行方法是,要求系統對其輸出產生一種解釋,這種解釋對人類或另一個受信任的系統來說是可讀的,即可以完全理解以至於任何可能的錯誤都可以被發現。例如,為了建立對司法系統的信任,我們要求法院提供清晰易讀的書面意見,解釋並支持其決策。對於大型語言模型來說,我們也可以採用類似的方法。不過,在採用這種方法時,確保語言模型生

基於Rust的Zed編輯器已開源,內建對OpenAI和GitHub Copilot的支持

Feb 01, 2024 pm 02:51 PM

基於Rust的Zed編輯器已開源,內建對OpenAI和GitHub Copilot的支持

Feb 01, 2024 pm 02:51 PM

作者丨TimAnderson編譯丨諾亞出品|51CTO技術堆疊(微訊號:blog51cto)Zed編輯器專案目前仍處於預發布階段,已在AGPL、GPL和Apache許可下開源。此編輯器以高性能和多種AI輔助選擇為特色,但目前僅適用於Mac平台使用。內森·索博(NathanSobo)在一篇貼文中解釋道,Zed專案在GitHub上的程式碼庫中,編輯器部分採用了GPL許可,伺服器端元件則使用了AGPL許可證,而GPUI(GPU加速用戶介面)部分則採用了Apache2.0授權。 GPUI是Zed團隊開發的一款