小而強大的模型盛火:TinyLlama和LiteLlama成為熱門選擇

目前,研究者開始關注小巧且高性能的小模型,儘管大家都在研究參數規模達到百億甚至千億級的大模型。

小型模型在邊緣裝置上有廣泛應用,如智慧型手機、物聯網裝置和嵌入式系統。這些設備通常運算能力和儲存空間有限,無法有效運行大型語言模型。因此,研究小型模型變得特別重要。

接下來我們要介紹的這兩項研究,可能滿足你對小模型的需求。

TinyLlama-1.1B

#新加坡科技設計大學(SUTD)的研究者最近發布了TinyLlama,這是一個參數量為11億的語言模型,經過在大約3萬億個token上的預訓練。

- #論文網址:https://arxiv.org/pdf/2401.02385.pdf

- 專案位址:https://github.com/jzhang38/TinyLlama/blob/main/README_zh-CN.md

##TinyLlama是基於Llama 2架構和分詞器的,這使得它可以輕鬆地與許多使用Llama的開源專案整合。此外,TinyLlama只有11億個參數,體積小巧,非常適合需要限制計算和記憶體佔用的應用程式。

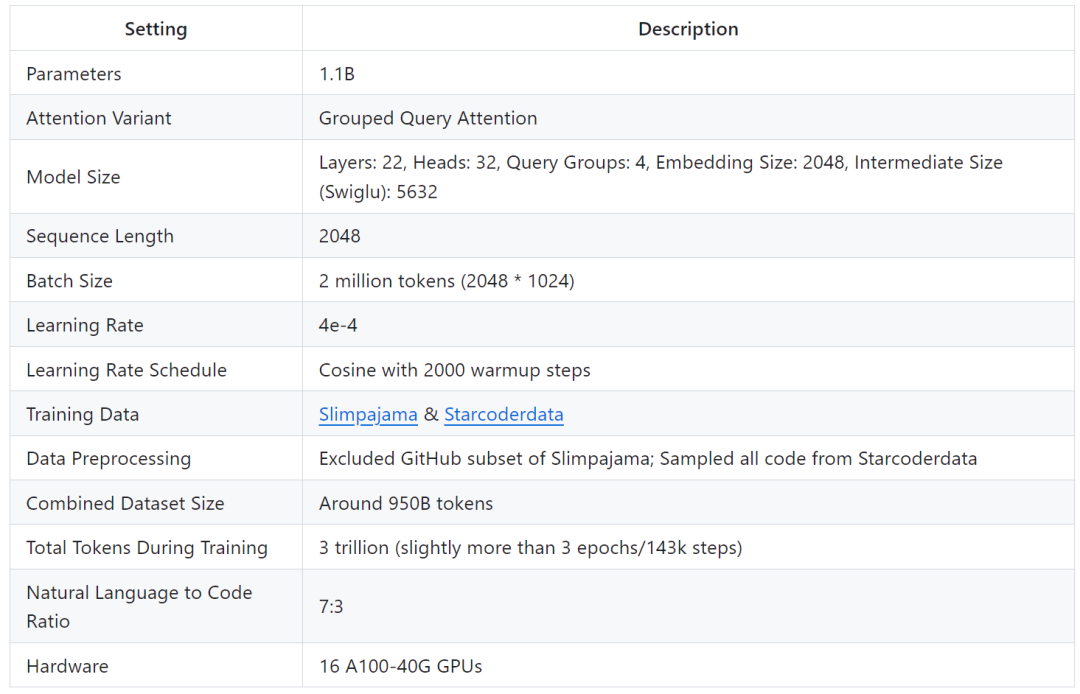

研究表示僅需 16 塊 A100-40G 的 GPU,便可在 90 天內完成 TinyLlama 的訓練。

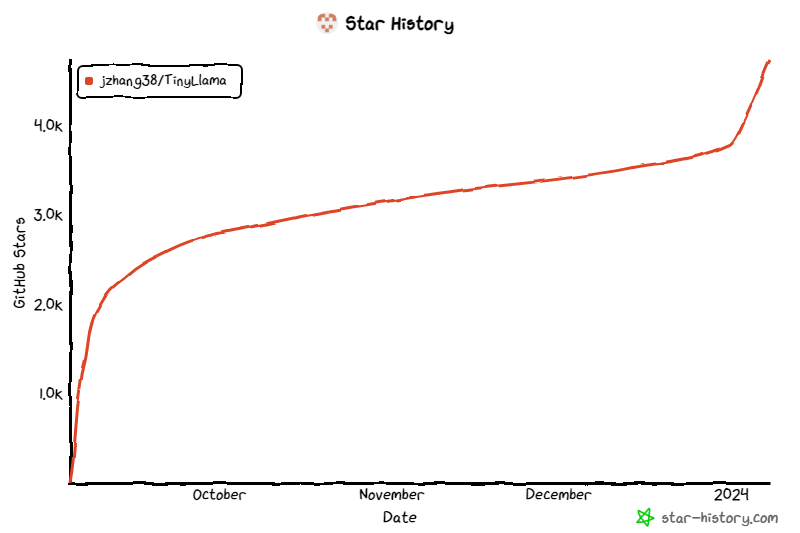

該專案從上線開始,持續受到關注,目前星標量達到 4.7K。

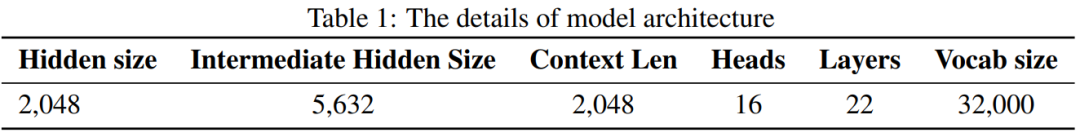

TinyLlama 模型架構詳細資訊如下所示:

# #訓練細節如下:

#研究者表示,這項研究旨在挖掘使用較大資料集訓練較小模型的潛力。他們重點探討在用遠大於擴展定律(scaling law)建議的 token 數量進行訓練時,較小模型的行為表現。

具體來說,研究使用大約 3 兆個 token 訓練具有 1.1B 個參數的 Transformer (僅解碼器)模型。據了解,這是第一次嘗試使用如此大量的資料來訓練具有 1B 參數的模型。

儘管規模相對較小,但 TinyLlama 在一系列下游任務中表現相當出色,它的效能顯著優於同等大小的現有開源語言模型。具體來說,TinyLlama 在各種下游任務中都超越了 OPT-1.3B 和 Pythia1.4B 。

此外,TinyLlama 也用到了各種最佳化方法,如 flash attention 2、FSDP( Fully Sharded Data Parallel )、 xFormers 等。

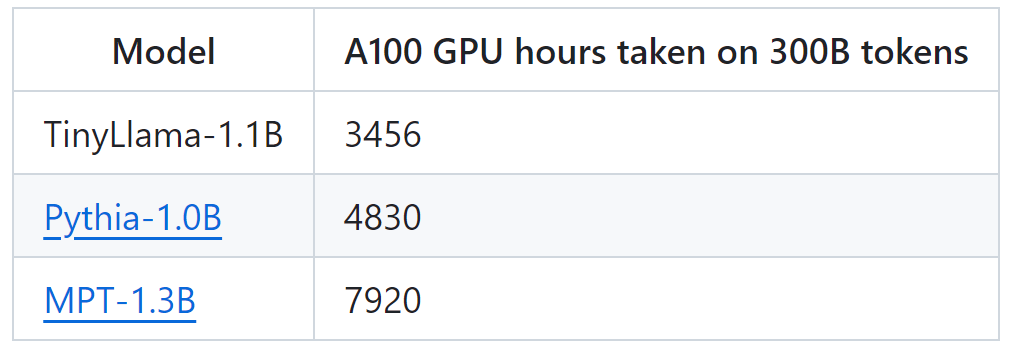

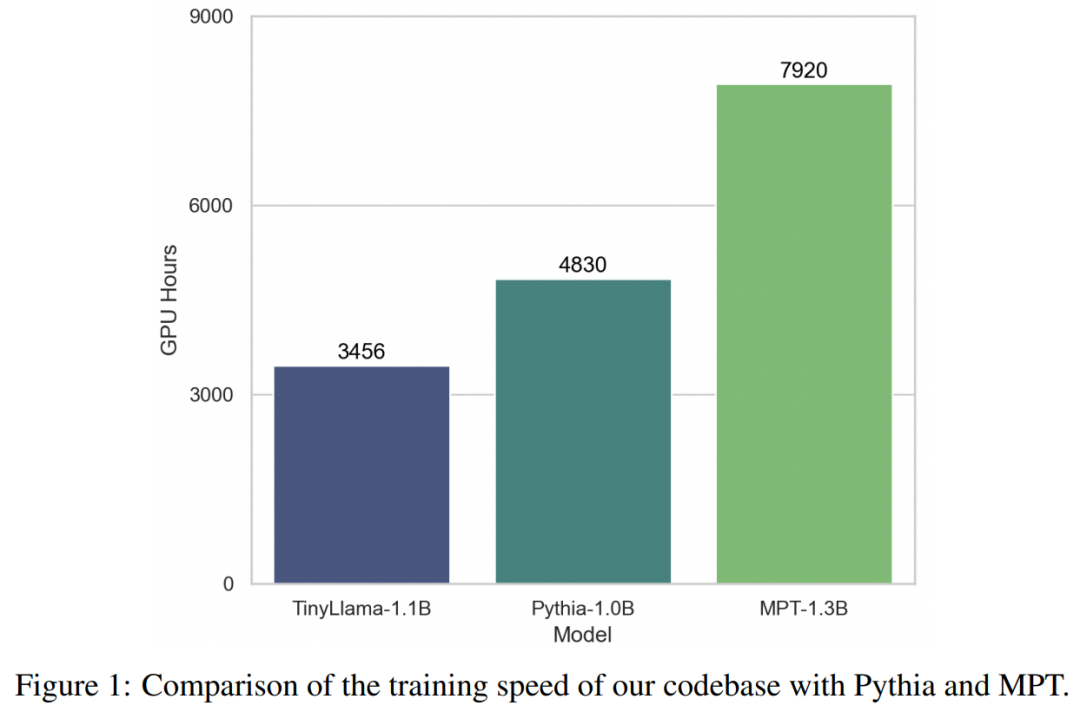

在這些技術的加持下,TinyLlama 訓練吞吐量達到了每 A100-40G GPU 每秒 24000 個 token。例如,TinyLlama-1.1B 模型對於 300B token 僅需要 3,456 A100 GPU 小時,而 Pythia 為 4,830 小時,MPT 為 7,920 小時。這顯示了該研究優化的有效性以及在大規模模型訓練中節省大量時間和資源的潛力。

TinyLlama 實現了24k tokens / 秒/ A100 的訓練速度,這個速度好比用戶可以在8 個A100 上用32 小時訓練一個具有11 億參數、220 億token 的chinchilla -optimial 的模型。同時,這些最佳化也大幅減少了顯存佔用,使用者可以把 11 億參數的模型塞入 40GB 的 GPU 裡面還能同時維持 16k tokens 的 per-gpu batch size。只要要把 batch size 改小一點, 你就可以在 RTX 3090/4090 上面訓練 TinyLlama。

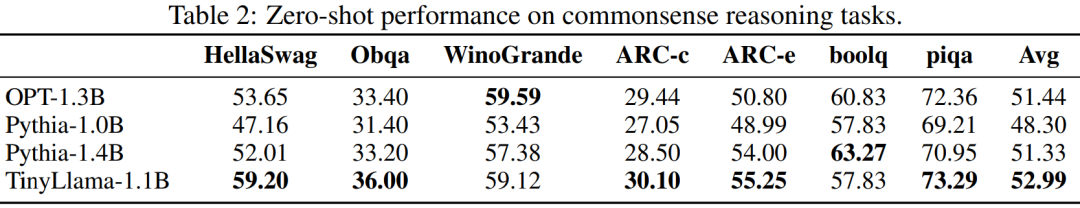

#在實驗中,研究主要關注具有純解碼器架構的語言模型,包含約10 億個參數。具體來說,該研究將 TinyLlama 與 OPT-1.3B、Pythia-1.0B 和 Pythia-1.4B 進行了比較。

TinyLlama 在常識推理任務上的表現如下所示,可以看出 TinyLlama 在許多任務上都優於基線,並獲得了最高的平均分數。

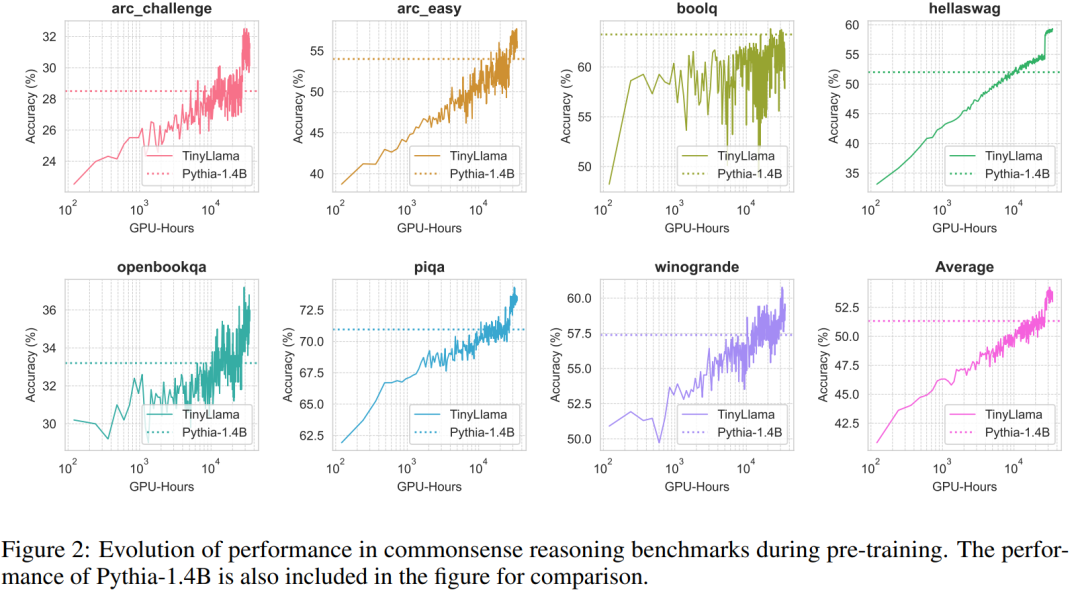

此外,研究者在預訓練期間追蹤了TinyLlama 在常識推理基準上的準確率,如圖2 所示,TinyLlama 的性能隨著計算資源的增加而提高,在大多數基準中超過了Pythia-1.4B 的準確率。

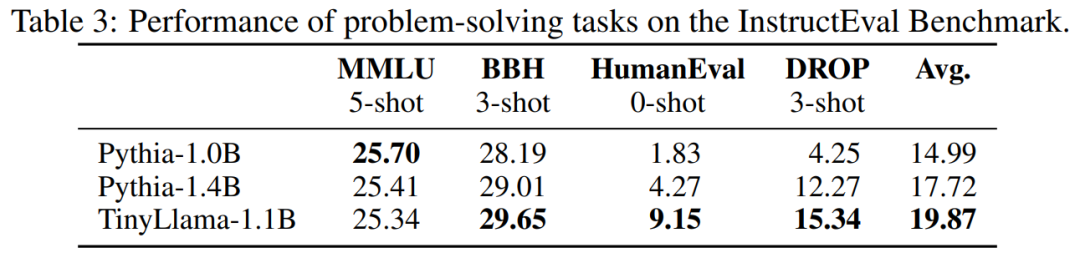

表 3 表明,與現有模型相比,TinyLlama 表現出了更好的問題解決能力。

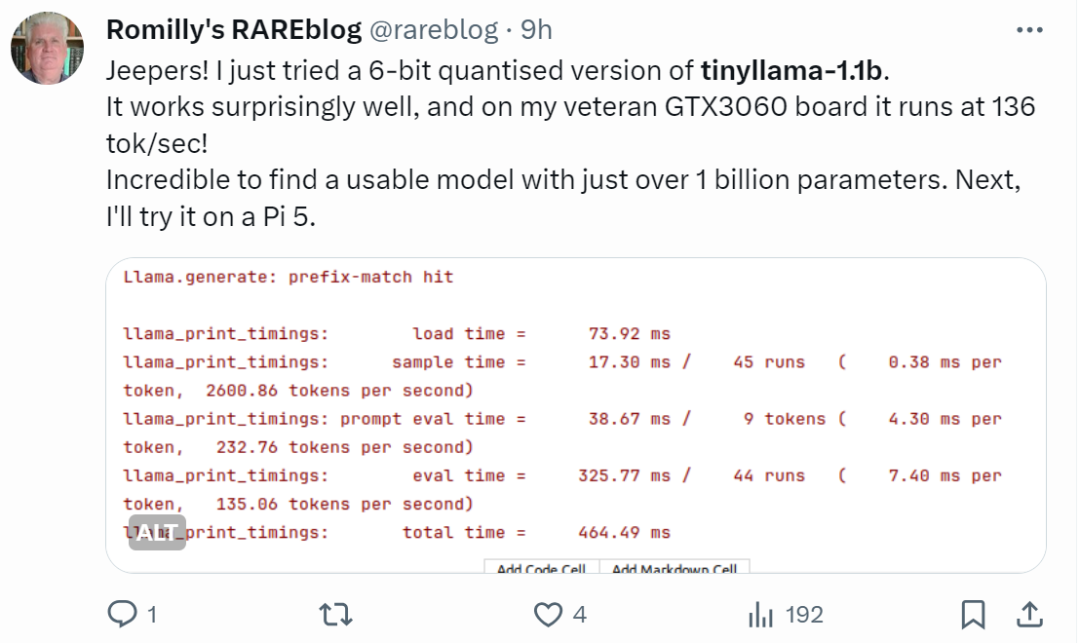

手快的網友已經開始整活了:運行效果出奇得好,在GTX3060 上運行,能以136 tok / 秒的速度運行。

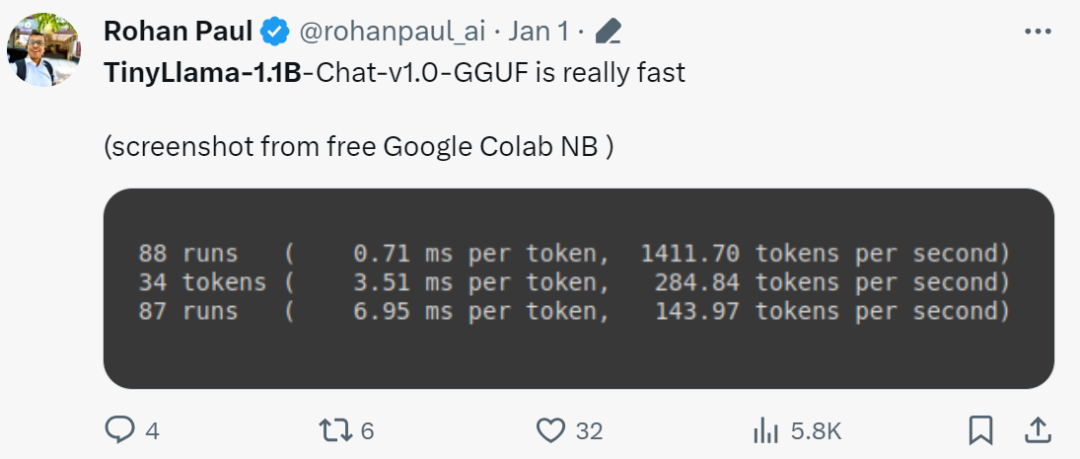

「確實是快!」

小模型LiteLlama

由於TinyLlama 的發布,SLM(小型語言模型)開始引起廣泛關注。德州工農大學的 Xiaotian Han 發布了 SLM-LiteLlama。它有 460M 參數,由 1T token 進行訓練。這是 Meta AI 的 LLaMa 2 的開源複刻版本,但模型規模顯著縮小。

專案位址:https://huggingface.co/ahxt/LiteLlama-460M-1T

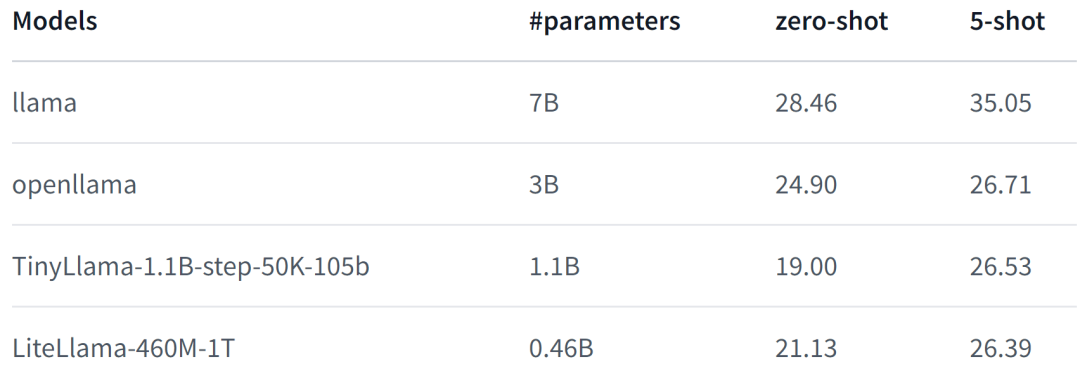

#LiteLlama-460M-1T 在RedPajama 資料集上進行訓練,並使用GPT2Tokenizer 對文字進行token 化。作者在 MMLU 任務上對此模型進行評估,結果如下圖所示,在參數量大幅減少的情況下,LiteLlama-460M-1T 仍能取得與其他模型相媲美或更好的成績。

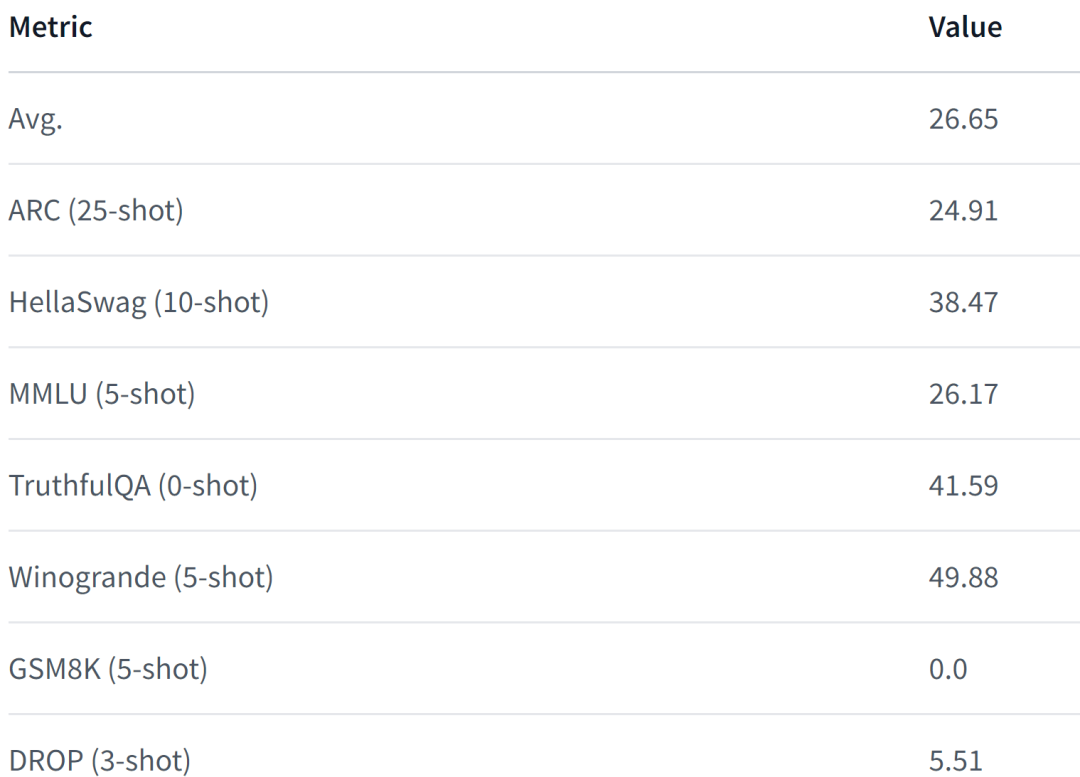

以下為該模型的效能表現,更詳細內容請參閱:

https://www.php.cn/link/05ec1d748d9e3bbc975a057f7cd02fb6

面對規模大幅縮小的LiteLlama,有網友好奇,它是否能夠在4GB 的記憶體上運作。如果你也想知道,不如親自試試看。

以上是小而強大的模型盛火:TinyLlama和LiteLlama成為熱門選擇的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

熱門話題

Debian郵件服務器防火牆配置技巧

Apr 13, 2025 am 11:42 AM

Debian郵件服務器防火牆配置技巧

Apr 13, 2025 am 11:42 AM

配置Debian郵件服務器的防火牆是確保服務器安全性的重要步驟。以下是幾種常用的防火牆配置方法,包括iptables和firewalld的使用。使用iptables配置防火牆安裝iptables(如果尚未安裝):sudoapt-getupdatesudoapt-getinstalliptables查看當前iptables規則:sudoiptables-L配置

debian readdir如何與其他工具集成

Apr 13, 2025 am 09:42 AM

debian readdir如何與其他工具集成

Apr 13, 2025 am 09:42 AM

Debian系統中的readdir函數是用於讀取目錄內容的系統調用,常用於C語言編程。本文將介紹如何將readdir與其他工具集成,以增強其功能。方法一:C語言程序與管道結合首先,編寫一個C程序調用readdir函數並輸出結果:#include#include#includeintmain(intargc,char*argv[]){DIR*dir;structdirent*entry;if(argc!=2){

debian readdir如何實現文件排序

Apr 13, 2025 am 09:06 AM

debian readdir如何實現文件排序

Apr 13, 2025 am 09:06 AM

在Debian系統中,readdir函數用於讀取目錄內容,但其返回的順序並非預先定義的。要對目錄中的文件進行排序,需要先讀取所有文件,再利用qsort函數進行排序。以下代碼演示瞭如何在Debian系統中使用readdir和qsort對目錄文件進行排序:#include#include#include#include//自定義比較函數,用於qsortintcompare(constvoid*a,constvoid*b){returnstrcmp(*(

Debian郵件服務器SSL證書安裝方法

Apr 13, 2025 am 11:39 AM

Debian郵件服務器SSL證書安裝方法

Apr 13, 2025 am 11:39 AM

在Debian郵件服務器上安裝SSL證書的步驟如下:1.安裝OpenSSL工具包首先,確保你的系統上已經安裝了OpenSSL工具包。如果沒有安裝,可以使用以下命令進行安裝:sudoapt-getupdatesudoapt-getinstallopenssl2.生成私鑰和證書請求接下來,使用OpenSSL生成一個2048位的RSA私鑰和一個證書請求(CSR):openss

Debian OpenSSL如何進行數字簽名驗證

Apr 13, 2025 am 11:09 AM

Debian OpenSSL如何進行數字簽名驗證

Apr 13, 2025 am 11:09 AM

在Debian系統上使用OpenSSL進行數字簽名驗證,可以按照以下步驟操作:準備工作安裝OpenSSL:確保你的Debian系統已經安裝了OpenSSL。如果沒有安裝,可以使用以下命令進行安裝:sudoaptupdatesudoaptinstallopenssl獲取公鑰:數字簽名驗證需要使用簽名者的公鑰。通常,公鑰會以文件的形式提供,例如public_key.pe

Debian OpenSSL如何防止中間人攻擊

Apr 13, 2025 am 10:30 AM

Debian OpenSSL如何防止中間人攻擊

Apr 13, 2025 am 10:30 AM

在Debian系統中,OpenSSL是一個重要的庫,用於加密、解密和證書管理。為了防止中間人攻擊(MITM),可以採取以下措施:使用HTTPS:確保所有網絡請求使用HTTPS協議,而不是HTTP。 HTTPS使用TLS(傳輸層安全協議)加密通信數據,確保數據在傳輸過程中不會被竊取或篡改。驗證服務器證書:在客戶端手動驗證服務器證書,確保其可信。可以通過URLSession的委託方法來手動驗證服務器

Debian Hadoop日誌管理怎麼做

Apr 13, 2025 am 10:45 AM

Debian Hadoop日誌管理怎麼做

Apr 13, 2025 am 10:45 AM

在Debian上管理Hadoop日誌,可以遵循以下步驟和最佳實踐:日誌聚合啟用日誌聚合:在yarn-site.xml文件中設置yarn.log-aggregation-enable為true,以啟用日誌聚合功能。配置日誌保留策略:設置yarn.log-aggregation.retain-seconds來定義日誌的保留時間,例如保留172800秒(2天)。指定日誌存儲路徑:通過yarn.n

centos關機命令行

Apr 14, 2025 pm 09:12 PM

centos關機命令行

Apr 14, 2025 pm 09:12 PM

CentOS 關機命令為 shutdown,語法為 shutdown [選項] 時間 [信息]。選項包括:-h 立即停止系統;-P 關機後關電源;-r 重新啟動;-t 等待時間。時間可指定為立即 (now)、分鐘數 ( minutes) 或特定時間 (hh:mm)。可添加信息在系統消息中顯示。