利用知識圖譜增強RAG模型的能力和減輕大模型虛假印象

在使用大型語言模型(LLM)時,幻覺是一個常見問題。儘管LLM可以產生流暢連貫的文本,但其產生的資訊往往不準確或不一致。為了防止LLM產生幻覺,可以利用外部的知識來源,例如資料庫或知識圖譜,來提供事實資訊。這樣一來,LLM可以依賴這些可靠的資料來源,從而產生更準確和可靠的文字內容。

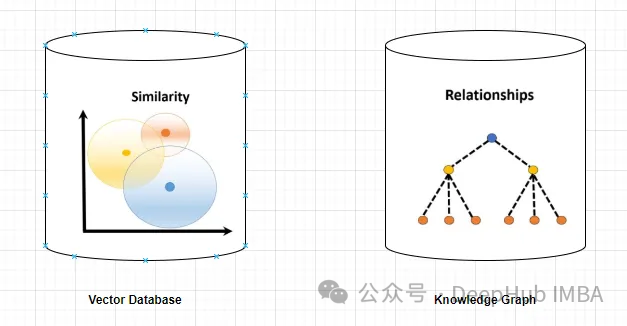

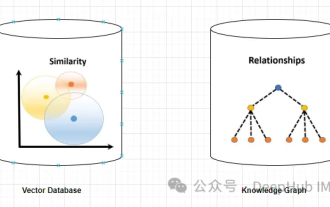

向量資料庫與知識圖譜

向量資料庫

向量資料庫是一組表示實體或概念的高維向量。它們可以用於度量不同實體或概念之間的相似性或相關性,透過它們的向量表示進行計算。

一個向量資料庫可以根據向量距離告訴你,「巴黎」和「法國」比「巴黎」和「德國」更相關。

查詢向量資料庫通常涉及搜尋相似的向量或基於特定標準的向量檢索。以下是一個查詢向量資料庫的簡單範例。

假設有一個高維向量資料庫,儲存了客戶設定檔。您想找到與給定參考客戶相似的客戶。

首先,為了將客戶定義為向量表示,我們可以提取相關特徵或屬性並將其轉換為向量形式。

可以使用適當的演算法(如k近鄰或餘弦相似度)在向量資料庫中進行相似度搜索,以識別最相似的鄰居。

檢索與確定的最近鄰向量對應的客戶配置文件,這些概要文件表示與參考客戶相似的客戶,根據定義的相似性度量。

向使用者展示檢索到的客戶個人資料或相關信息,如姓名、人口統計資料或購買歷史。

知識圖譜

知識圖譜是表示實體或概念及其關係(如事實、屬性或類別)的節點和邊的集合。基於它們的節點和邊緣屬性,可用於查詢或推斷關於不同實體或概念的事實資訊。

例如,一個知識圖可以根據邊緣標籤告訴你「巴黎」是「法國」的首都。

查詢圖資料庫涉及遍歷圖結構並根據特定標準檢索節點、關係或模式。

假設你有一個表示社群網路的圖資料庫,其中使用者是節點,他們的關係表示為連結節點的邊。如果為給定使用者找到朋友的朋友(共同聯繫),那麼我們應該進行如下操作:

1、在圖資料庫中標識表示參考用戶的節點。這可以透過查詢特定的使用者識別碼或其他相關標準來實現。

2、使用圖查詢語言,例如Cypher(在Neo4j中使用)或Gremlin,從參考使用者節點遍歷圖。指定要探索的模式或關係。

MATCH (:User {userId: ‘referenceUser’})-[:FRIEND]->()-[:FRIEND]->(fof:User) RETURN fof這個查詢從參考用戶開始,沿著FRIEND關係找到另一個節點(FRIEND),然後沿著另一個FRIEND關係找到朋友的朋友(fof)。

3、對圖資料庫執行查詢,根據查詢模式檢索結果節點(朋友的朋友),可以取得關於檢索節點的特定屬性或其他資訊。

圖資料庫可以提供更進階的查詢功能,包括過濾、聚合和複雜的模式匹配。具體的查詢語言和語法可能會有所不同,但一般的過程涉及遍歷圖結構以檢索符合所需標準的節點和關係。

知識圖譜解決「幻覺」問題的優勢

知識圖譜比向量資料庫提供更精確和具體的資訊。向量資料庫表示兩個實體或概念之間的相似性或相關性,而知識圖可以更好地理解它們之間的關係。例如知識圖譜可以告訴你「艾菲爾鐵塔」是「巴黎」的地標,而向量資料庫只能顯示這兩個概念的相似程度,但是具體他們之間如何相關的卻沒有說明。

知識圖支援比向量資料庫更多樣化、更複雜的查詢。向量資料庫主要可以回答基於向量距離、相似性或最近鄰的查詢,這些查詢僅限於直接的相似性測量。而知識圖可以處理基於邏輯運算子的查詢,例如「具有屬性Z的所有實體是什麼?」或「W和V的共同範疇是什麼?」這可以幫助LLM產生更多樣化和有趣的文本。

知識圖比向量資料庫更能進行推理和推論。向量資料庫只能提供儲存在資料庫中的直接資訊。而知識圖可以提供從實體或概念之間的關係派生的間接資訊。例如,一個知識圖譜可以根據「巴黎是法國的首都」和「法國位於歐洲」這兩個事實推論出「艾菲爾鐵塔位於歐洲」。這可以幫助LLM產生更具邏輯性和一致性的文字。

所以知識圖譜是一個比向量資料庫更好的解決方案。可以為LLM提供了更準確、相關、多樣、有趣、合乎邏輯和一致的訊息,使它們更可靠地產生準確和真實的文本。但這裡的關鍵是文檔文檔之間需要有清晰的關係,否則知識圖譜將無法捕捉到它。

但是,知识图谱的使用并没有向量数据库那么直接简单,不仅在内容的梳理(数据),应用部署,查询生成等方面都没有向量数据库那么方便,这也影响了它在实际应用中的使用频率。所以下面我们使用一个简单的例子来介绍如何使用知识图谱构建RAG。

代码实现

我们需要使用3个主要工具/组件:

1、LlamaIndex是一个编排框架,它简化了私有数据与公共数据的集成,它提供了数据摄取、索引和查询的工具,使其成为生成式人工智能需求的通用解决方案。

2、嵌入模型将文本转换为文本所提供的一条信息的数字表示形式。这种表示捕获了所嵌入内容的语义含义,使其对于许多行业应用程序都很健壮。这里使用“thenlper/gte-large”模型。

3、需要大型语言模型来根据所提供的问题和上下文生成响应。这里使用Zephyr 7B beta模型

下面我们开始进行代码编写,首先安装包

%%capture pip install llama_index pyvis Ipython langchain pypdf

启用日志Logging Level设置为“INFO”,我们可以输出有助于监视应用程序操作流的消息

import logging import sys # logging.basicConfig(stream=sys.stdout, level=logging.INFO) logging.getLogger().addHandler(logging.StreamHandler(stream=sys.stdout))

导入依赖项

from llama_index import (SimpleDirectoryReader,LLMPredictor,ServiceContext,KnowledgeGraphIndex) # from llama_index.graph_stores import SimpleGraphStore from llama_index.storage.storage_context import StorageContext from llama_index.llms import HuggingFaceInferenceAPI from langchain.embeddings import HuggingFaceInferenceAPIEmbeddings from llama_index.embeddings import LangchainEmbedding from pyvis.network import Network

我们使用Huggingface推理api端点载入LLM

HF_TOKEN = "api key DEEPHUB 123456" llm = HuggingFaceInferenceAPI(model_name="HuggingFaceH4/zephyr-7b-beta", token=HF_TOKEN )

首先载入嵌入模型:

embed_model = LangchainEmbedding(HuggingFaceInferenceAPIEmbeddings(api_key=HF_TOKEN,model_name="thenlper/gte-large") )

加载数据集

documents = SimpleDirectoryReader("/content/Documents").load_data() print(len(documents)) ####Output### 44构建知识图谱索引

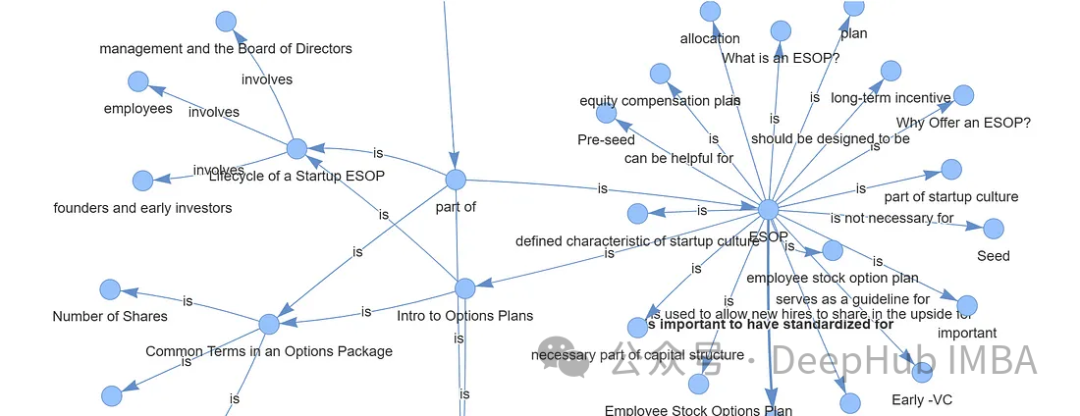

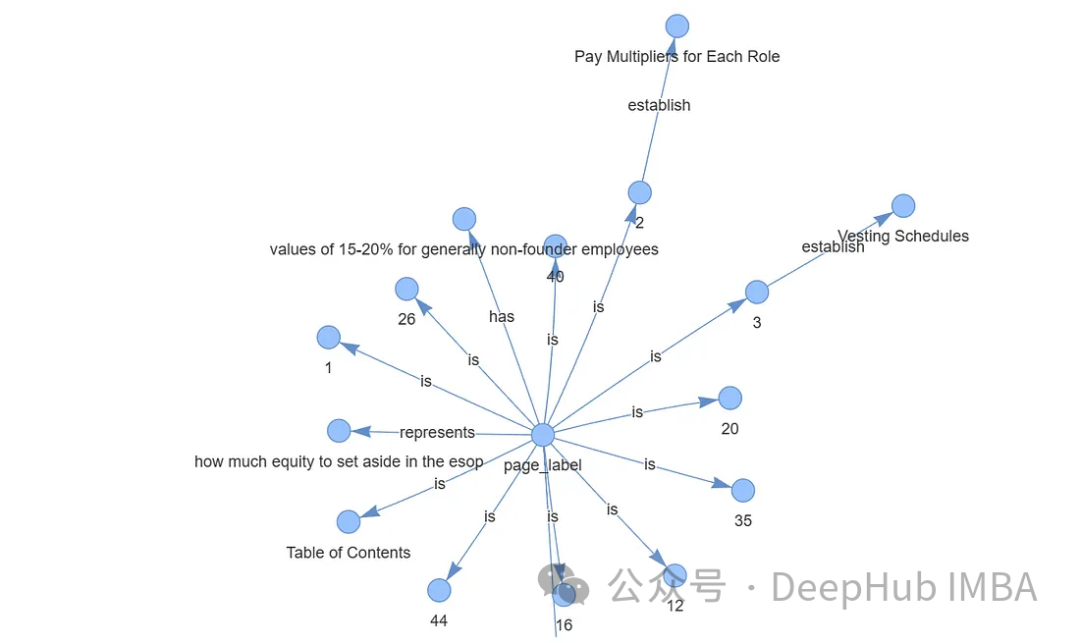

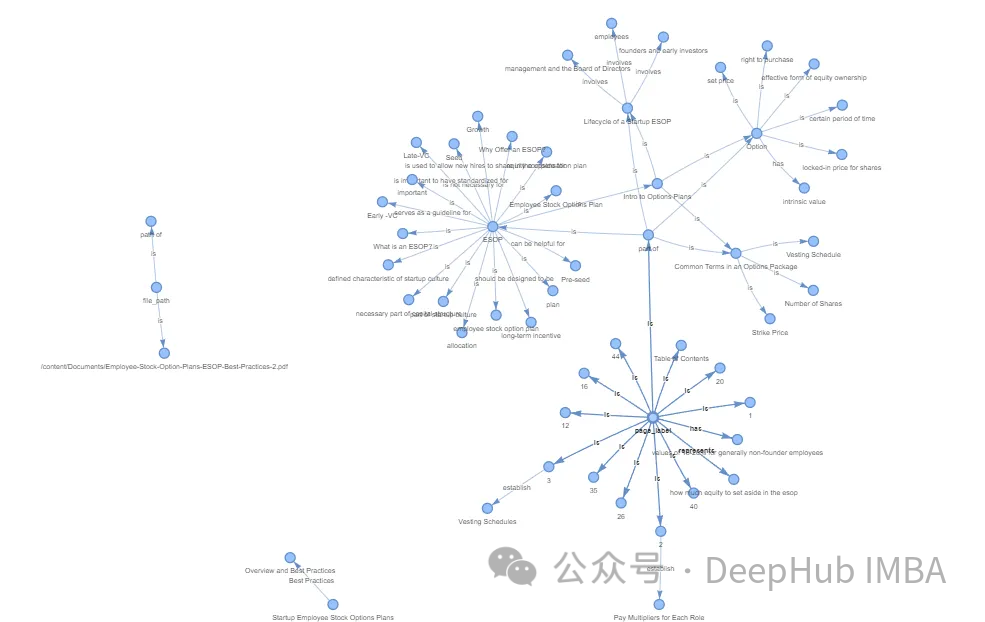

创建知识图谱通常涉及专业和复杂的任务。通过利用Llama Index (LLM)、KnowledgeGraphIndex和GraphStore,可以方便地任何数据源创建一个相对有效的知识图谱。

#setup the service context service_context = ServiceContext.from_defaults(chunk_size=256,llm=llm,embed_model=embed_model ) #setup the storage context graph_store = SimpleGraphStore() storage_context = StorageContext.from_defaults(graph_store=graph_store) #Construct the Knowlege Graph Undex index = KnowledgeGraphIndex.from_documents( documents=documents,max_triplets_per_chunk=3,service_context=service_context,storage_context=storage_context,include_embeddings=True)

Max_triplets_per_chunk:它控制每个数据块处理的关系三元组的数量

Include_embeddings:切换在索引中包含嵌入以进行高级分析。

通过构建查询引擎对知识图谱进行查询

query = "What is ESOP?" query_engine = index.as_query_engine(include_text=True,response_mode ="tree_summarize",embedding_mode="hybrid",similarity_top_k=5,) # message_template =f"""Please check if the following pieces of context has any mention of the keywords provided in the Question.If not then don't know the answer, just say that you don't know.Stop there.Please donot try to make up an answer. Question: {query} Helpful Answer: """ # response = query_engine.query(message_template) # print(response.response.split("")[-1].strip()) #####OUTPUT ##################### ESOP stands for Employee Stock Ownership Plan. It is a retirement plan that allows employees to receive company stock or stock options as part of their compensation. In simpler terms, it is a plan that allows employees to own a portion of the company they work for. This can be a motivating factor for employees as they have a direct stake in the company's success. ESOPs can also be a tax-efficient way for companies to provide retirement benefits to their employees.可以看到,输出的结果已经很好了,可以说与向量数据库的结果非常一致。

最后还可以可视化我们生成的图谱,使用Pyvis库进行可视化展示

from pyvis.network import Network from IPython.display import display g = index.get_networkx_graph() net = Network(notebook=True,cdn_resources="in_line",directed=True) net.from_nx(g) net.show("graph.html") net.save_graph("Knowledge_graph.html") # import IPython IPython.display.HTML(filename="/content/Knowledge_graph.html")

通过上面的代码我们可以直接通过LLM生成知识图谱,这样简化了我们非常多的人工操作。如果需要更精准更完整的知识图谱,还需要人工手动检查,这里就不细说了。

数据存储,通过持久化数据,可以将结果保存到硬盘中,供以后使用。

storage_context.persist()

存储的结果如下:

总结

向量数据库和知识图谱的区别在于它们存储和表示数据的方法。向量数据库擅长基于相似性的操作,依靠数值向量来测量实体之间的距离。知识图谱通过节点和边缘捕获复杂的关系和依赖关系,促进语义分析和高级推理。

对于语言模型(LLM)幻觉,知识图被证明优于向量数据库。知识图谱提供了更准确、多样、有趣、有逻辑性和一致性的信息,减少了LLM产生幻觉的可能性。这种优势源于它们能够提供实体之间关系的精确细节,而不仅仅是表明相似性,从而支持更复杂的查询和逻辑推理。

在以前知识图谱的应用难点在于图谱的构建,但是现在LLM的出现简化了这个过程,使得我们可以轻松的构建出可用的知识图谱,这使得他在应用方面又向前迈出了一大步。对于RAG,知识图谱是一个非常好的应用方向。

以上是利用知識圖譜增強RAG模型的能力和減輕大模型虛假印象的詳細內容。更多資訊請關注PHP中文網其他相關文章!

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

記事本++7.3.1

好用且免費的程式碼編輯器

SublimeText3漢化版

中文版,非常好用

禪工作室 13.0.1

強大的PHP整合開發環境

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

為什麼大型語言模型都在使用 SwiGLU 作為激活函數?

Apr 08, 2024 pm 09:31 PM

為什麼大型語言模型都在使用 SwiGLU 作為激活函數?

Apr 08, 2024 pm 09:31 PM

如果你一直在關注大型語言模型的架構,你可能會在最新的模型和研究論文中看到「SwiGLU」這個詞。 SwiGLU可以說是在大語言模型中最常使用的激活函數,我們這篇文章就來對它進行詳細的介紹。 SwiGLU其實是2020年Google提出的激活函數,它結合了SWISH和GLU兩者的特徵。 SwiGLU的中文全名為“雙向門控線性單元”,它將SWISH和GLU兩種激活函數進行了優化和結合,以提高模型的非線性表達能力。 SWISH是一種非常普遍的激活函數,它在大語言模型中得到廣泛應用,而GLU則在自然語言處理任務中表現出

使用Rag和Sem-Rag提供上下文增強AI編碼助手

Jun 10, 2024 am 11:08 AM

使用Rag和Sem-Rag提供上下文增強AI編碼助手

Jun 10, 2024 am 11:08 AM

透過將檢索增強生成和語意記憶納入AI編碼助手,提升開發人員的生產力、效率和準確性。譯自EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG,作者JanakiramMSV。雖然基本AI程式設計助理自然有幫助,但由於依賴對軟體語言和編寫軟體最常見模式的整體理解,因此常常無法提供最相關和正確的程式碼建議。這些編碼助手產生的代碼適合解決他們負責解決的問題,但通常不符合各個團隊的編碼標準、慣例和風格。這通常會導致需要修改或完善其建議,以便將程式碼接受到應

知識圖譜檢索增強的GraphRAG(基於Neo4j程式碼實作)

Jun 12, 2024 am 10:32 AM

知識圖譜檢索增強的GraphRAG(基於Neo4j程式碼實作)

Jun 12, 2024 am 10:32 AM

圖檢索增強生成(GraphRAG)正逐漸流行起來,成為傳統向量搜尋方法的強大補充。這種方法利用圖資料庫的結構化特性,將資料以節點和關係的形式組織起來,從而增強檢索資訊的深度和上下文關聯性。圖在表示和儲存多樣化且相互關聯的資訊方面具有天然優勢,能夠輕鬆捕捉不同資料類型間的複雜關係和屬性。而向量資料庫則處理這類結構化資訊時則顯得力不從心,它們更專注於處理高維度向量表示的非結構化資料。在RAG應用中,結合結構化的圖資料和非結構化的文字向量搜索,可以讓我們同時享受兩者的優勢,這也是本文將要探討的內容。構

微調真的能讓LLM學到新東西嗎:引入新知識可能讓模型產生更多的幻覺

Jun 11, 2024 pm 03:57 PM

微調真的能讓LLM學到新東西嗎:引入新知識可能讓模型產生更多的幻覺

Jun 11, 2024 pm 03:57 PM

大型語言模型(LLM)是在龐大的文字資料庫上訓練的,在那裡它們獲得了大量的實際知識。這些知識嵌入到它們的參數中,然後可以在需要時使用。這些模型的知識在訓練結束時被「具體化」。在預訓練結束時,模型實際上停止學習。對模型進行對齊或進行指令調優,讓模型學習如何充分利用這些知識,以及如何更自然地回應使用者的問題。但是有時模型知識是不夠的,儘管模型可以透過RAG存取外部內容,但透過微調使用模型適應新的領域被認為是有益的。這種微調是使用人工標註者或其他llm創建的輸入進行的,模型會遇到額外的實際知識並將其整合

可視化FAISS向量空間並調整RAG參數提高結果精度

Mar 01, 2024 pm 09:16 PM

可視化FAISS向量空間並調整RAG參數提高結果精度

Mar 01, 2024 pm 09:16 PM

隨著開源大型語言模型的效能不斷提高,編寫和分析程式碼、推薦、文字摘要和問答(QA)對的效能都有了很大的提高。但當涉及QA時,LLM通常會在未訓練資料的相關的問題上有所欠缺,許多內部文件都保存在公司內部,以確保合規性、商業機密或隱私。當查詢這些文件時,會使得LLM產生幻覺,產生不相關、捏造或不一致的內容。一種處理這項挑戰的可行技術是檢索增強生成(RAG)。它涉及透過引用訓練資料來源以外的權威知識庫來增強回應的過程,以提升生成的品質和準確性。 RAG系統包括一個檢索系統,用於從語料庫中檢索相關文檔片段

使用SPIN技術進行自我博弈微調訓練的LLM的最佳化

Jan 25, 2024 pm 12:21 PM

使用SPIN技術進行自我博弈微調訓練的LLM的最佳化

Jan 25, 2024 pm 12:21 PM

2024年是大型語言模型(LLM)快速發展的一年。在LLM的訓練中,對齊方法是一個重要的技術手段,其中包括監督微調(SFT)和依賴人類偏好的人類回饋強化學習(RLHF)。這些方法在LLM的發展中起到了至關重要的作用,但是對齊方法需要大量的人工註釋資料。面對這項挑戰,微調成為一個充滿活力的研究領域,研究人員積極致力於開發能夠有效利用人類資料的方法。因此,對齊方法的發展將推動LLM技術的進一步突破。加州大學最近進行了一項研究,介紹了一種名為SPIN(SelfPlayfInetuNing)的新技術。 S

建構多模態RAG系統的方法:使用CLIP和LLM

Jan 13, 2024 pm 10:24 PM

建構多模態RAG系統的方法:使用CLIP和LLM

Jan 13, 2024 pm 10:24 PM

我們將討論使用開源的大型語言多模態模型(LargeLanguageMulti-Modal)來建立檢索增強生成(RAG)系統的方法。我們的重點是在不依賴LangChain或LLlamaindex的情況下實現這一目標,以避免增加更多的框架依賴。什麼是RAG在人工智慧領域,檢索增強生成(retrieve-augmentedgeneration,RAG)技術的出現為大型語言模型(LargeLanguageModels)帶來了變革性的改進。 RAG的本質是透過允許模型從外部來源動態檢索即時訊息,從而增強人工智慧

利用知識圖譜增強RAG模型的能力和減輕大模型虛假印象

Jan 14, 2024 pm 06:30 PM

利用知識圖譜增強RAG模型的能力和減輕大模型虛假印象

Jan 14, 2024 pm 06:30 PM

在使用大型語言模型(LLM)時,幻覺是一個常見問題。儘管LLM可以產生流暢連貫的文本,但其產生的資訊往往不準確或不一致。為了防止LLM產生幻覺,可以利用外部的知識來源,例如資料庫或知識圖譜,來提供事實資訊。這樣一來,LLM可以依賴這些可靠的資料來源,從而產生更準確和可靠的文字內容。向量資料庫和知識圖譜向量資料庫向量資料庫是一組表示實體或概念的高維度向量。它們可以用於度量不同實體或概念之間的相似性或相關性,透過它們的向量表示進行計算。一個向量資料庫可以根據向量距離告訴你,「巴黎」和「法國」比「巴黎」和